GGUF革命:一种格式如何永远改变了本地AI

探索GGUF如何通过革命性的量化和优化技术,使强大的语言模型能够在消费级硬件上运行,从而彻底改变了本地AI部署。

2023年8月,一个简单的文件格式公告永远改变了本地AI的发展轨迹。GGUF(GPT-Generated Unified Format,GPT生成统一格式)不仅仅是替代了其前身GGML。它彻底民主化了对强大AI模型的访问,使任何拥有消费级笔记本电脑的人都能运行以前需要昂贵云基础设施的复杂语言模型。

这是一个关于一种格式如何引发革命,将AI能力直接交到全球数百万用户手中的故事。

问题:AI模型对普通人来说太大了

在GGUF出现之前,在本地运行先进的AI模型是一场噩梦。像LLaMA或GPT风格架构这样的大型语言模型需要数百GB的内存、昂贵的GPU,以及大多数开发者和爱好者无法企及的技术专业知识。

障碍是真实存在的:

- 一个70B参数的模型需要约140GB的显存

- 消费级GPU最多只有24GB

- 云推理每月花费数百美元

- 注重隐私的用户没有本地选择

- 发展中国家无法访问昂贵的云服务

GGML基础:这一旅程始于GGML(最初由Georgi Gerganov开发),它引入了可以显著减小模型大小的量化技术。然而,GGML存在局限性:

- 加载时间和推理性能慢

- 扩展性和灵活性有限

- 添加新功能时存在兼容性问题

- 主要为LLaMA架构设计

- 不支持特殊令牌(Token)

GGUF的出现:游戏规则改变者

2023年8月21日,Georgi Gerganov推出GGUF作为GGML的继任者,一切都改变了。GGUF不仅仅是一个渐进式改进。它是对AI模型如何存储、加载和执行的完全重新构想。

GGUF的革命性之处

1. 在不损失质量的情况下大幅减小尺寸 GGUF的量化技术可以将模型大小减少50-75%,同时保持95%以上的性能准确度。Q4_K_M变体在原始大小仅30%的情况下提供了96%的原始性能。

2. 通用硬件兼容性 与以前的格式不同,GGUF可以在以下硬件上高效运行:

- 标准CPU(Intel、AMD、Apple Silicon)

- 消费级GPU(NVIDIA、AMD)

- 边缘设备和移动硬件

- 混合CPU/GPU配置

3. 闪电般的加载速度 以前需要几分钟加载的模型现在几秒钟就能启动。mmap兼容性增强使加载时间比传统格式快3倍。

4. 自包含智能 一个GGUF文件包含运行模型所需的一切:

- 模型权重和架构

- 完整的元数据和配置

- 分词器信息

- 量化参数

- 特殊令牌定义

技术突破:GGUF的工作原理

高级量化层次结构

GGUF支持从Q2到Q8的复杂量化级别,每个级别都针对不同的用例进行了优化:

超压缩(Q2_K):

- 最小的文件大小(减少75%以上)

- 在8GB RAM系统上运行

- 适合移动部署

- 质量有轻微折衷

如需了解更多在有限硬件资源下工作的策略,请查看我们关于在预算硬件和低显存上运行ComfyUI的综合指南。

平衡性能(Q4_K_M):

- 推荐的起点

- 减少50-60%的大小

- 出色的质量保留

- 适合大多数应用

高质量(Q6_K、Q8_0):

- 最小的质量损失

- 减少30-40%的大小

- 适合专业应用

- 需要16GB以上的RAM

内存优化魔法

GGUF的二进制格式设计革新了内存使用:

- 减少50-70%的RAM需求

- 高效的权重存储和加载

- 先进的压缩算法

- 优化的内存映射

跨平台性能

Apple Silicon优化:

- 原生ARM NEON支持

- Metal框架集成

- M1/M2/M3芯片优化

- 统一内存架构优势

NVIDIA GPU加速:

- CUDA内核优化

- RTX 4090达到约150令牌/秒

- 高效的显存利用

- 混合精度支持

要了解更多关于GPU加速和CUDA优化的信息,请阅读我们详细的PyTorch CUDA GPU加速指南。

纯CPU卓越性能:

- AVX/AVX2/AVX512支持

- 多线程优化

- 缓存友好操作

- 无外部依赖

GGUF构建的生态系统

llama.cpp:参考实现

llama.cpp成为GGUF模型执行的黄金标准:

性能成就:

- 开创了消费级硬件优化

- 在不损失质量的情况下进行高级量化

- 跨平台兼容性

- 专注于内存带宽优化

技术创新:

- 用于NVIDIA GPU的自定义CUDA内核

- Apple Silicon优化

- 仅CPU推理能力

- 最少的外部依赖

Ollama:使GGUF易于访问

Ollama将GGUF从技术工具转变为对消费者友好的平台:

用户体验革命:

- 一键模型安装

- 自动GGUF转换

- 模型版本管理

- 简单的CLI界面

- 不需要Python知识

安装简便性:

- 设置时间不到5分钟

- 适用于Windows、Mac、Linux

- 自动依赖管理

- 集成模型库

Hugging Face集成

Hugging Face Hub拥抱GGUF,创建了一个庞大的生态系统:

模型可用性:

- 数千个GGUF模型

- 提供预量化版本

- 社区驱动的转换

- 专业模型发布

质量控制:

- 标准化命名约定

- 性能基准

- 社区验证

- 定期更新

现实世界的影响:数字不会说谎

硬件要求革命

| 规格 | GGUF之前 | GGUF之后 |

|---|---|---|

| 70B模型要求 | 140GB显存 | 40-50GB RAM(Q4_K_M) |

| 最低硬件成本 | 10,000美元以上的GPU设置 | 1,500美元的消费级笔记本电脑 |

| 月度云成本 | 200-500美元 | 0美元(本地运行) |

| 技术专业知识 | 高 | 最低 |

性能基准

量化效率:

| 量化级别 | 尺寸减少 | 质量保留 |

|---|---|---|

| Q2_K | 75% | 90% |

| Q4_K_M | 60% | 96% |

| Q6_K | 40% | 98% |

| Q8_0 | 25% | 99.5% |

加载速度改进:

- 模型加载速度快3倍

- 即时模型切换

- 内存映射文件访问

- 减少初始化开销

全球采用统计

开发者采用:

- 每月下载llama.cpp超过50万次

- Hugging Face上下载GGUF模型超过100万次

- 支持200多种模型架构

- 50多种编程语言绑定

硬件覆盖范围:

- 可在只有4GB RAM的设备上运行

- 与10年前的硬件兼容

- 可能的移动设备部署

- 边缘计算应用

民主化效应

打破障碍

地理访问: GGUF消除了对昂贵云服务的需求,使发展中国家和互联网基础设施有限的地区能够访问AI。

教育影响: 大学和学校现在可以在本地运行AI模型,实现无需云成本或隐私担忧的实践学习。如果你是AI新手,可以从我们的AI图像生成入门完整指南开始。

小企业赋能: 本地部署意味着企业可以使用AI,而无需与云提供商共享敏感数据或支付订阅费。

隐私和安全革命

完全的数据隐私:

- 模型完全离线运行

- 数据不会离开你的设备

- 适合敏感应用

- 符合GDPR和合规要求

气隙部署:

- 无需互联网连接即可工作

- 适合安全环境

- 政府和军事应用

- 工业和医疗保健用例

GGUF与竞争对手的比较

GGUF vs GPTQ vs AWQ

| 格式 | 优点 | 缺点 | 最佳用例 |

|---|---|---|---|

| GPTQ | 出色的GPU性能,高压缩率 | 仅限GPU,设置复杂,硬件支持有限 | 高端GPU系统 |

| AWQ | 良好的质量保留,GPU优化 | 硬件支持有限,较新格式 | 专业GPU部署 |

| GGUF | 通用硬件,易于设置,出色的生态系统 | 仅GPU性能略低于GPTQ | 其他所有情况(95%的用例) |

本地AI的明确赢家

GGUF主导本地AI部署,因为:

- 灵活性:在任何硬件配置上运行

- 生态系统:大量工具和模型支持

- 简单性:不需要技术专业知识

- 性能:针对现实世界硬件进行优化

- 面向未来:可扩展的设计支持新功能

高级GGUF技术和优化

量化策略选择

内容创作(Q5_K_M - Q6_K):

- 高质量文本生成

- 创意写作应用

- 专业文档

- 代码生成任务

聊天应用(Q4_K_M):

- 平衡的性能和质量

- 实时对话

- 通用问答系统

- 教育应用

资源受限环境(Q3_K_M - Q2_K):

- 移动部署

- 边缘计算

- 物联网应用

- 批处理任务

性能调优

内存优化:

- 为可用RAM使用适当的量化

- 启用内存映射以实现更快的访问

- 根据用例配置上下文长度

- 实施模型缓存策略

CPU优化:

- 线程数匹配CPU核心数

- 多插槽系统的NUMA感知

- 缓存优化技术

- 内存带宽最大化

GPU加速:

- 混合CPU/GPU推理

- 显存使用优化

- 批大小调优

- 管道并行化

GGUF的商业影响

成本降低分析

| 成本因素 | 传统云AI | GGUF本地部署 |

|---|---|---|

| API/使用成本 | 每1k令牌0.03-0.06美元 | 0美元(硬件后) |

| 月度运营成本 | 500-2000美元 | 仅电费(约5-20美元) |

| 初始投资 | 0美元 | 1500-3000美元(一次性) |

| 数据隐私 | 与提供商共享 | 完全控制 |

| 供应商锁定 | 显著 | 完全独立 |

ROI计算: 对于每月处理100万令牌的组织,GGUF部署在2-6个月内就能收回成本,同时提供更优越的隐私和控制。

启用的新商业模式

本地AI服务:

- 本地AI咨询

- 自定义模型部署

- 注重隐私的AI解决方案

- 离线AI应用

教育机会:

- AI培训研讨会

- 本地模型微调服务

- 自定义GGUF转换服务

- AI集成咨询

行业应用和案例研究

医疗保健:隐私优先的AI

用例:

- 医疗记录分析

- 诊断辅助

- 患者沟通

- 研究数据处理

GGUF优势:

- 完全符合HIPAA

- 数据不会离开设施

- 降低责任担忧

- 降低运营成本

金融服务:安全的AI处理

应用:

- 文档分析

- 风险评估

- 客户服务自动化

- 监管合规

优势:

- 零数据泄露风险

- 监管合规

- 实时处理

- 成本效益扩展

政府:主权AI

部署场景:

创作内容每月赚取$1,250+

加入我们的独家创作者联盟计划。根据病毒视频表现获得报酬。以完全的创作自由按您的风格创作内容。

- 机密文件处理

- 公民服务自动化

- 机构间沟通

- 政策分析

战略优势:

- 国家安全合规

- 数据主权

- 减少对外国的依赖

- 预算优化

GGUF和本地AI的未来

新兴发展

模型架构支持:

- 视觉-语言模型(LLaVA)

- 代码特定模型(CodeLlama)

- 多模态能力

- 专业领域模型

硬件集成:

- NPU(神经处理单元)支持

- 移动芯片优化

- 物联网设备部署

- 嵌入式系统集成

性能改进:

- 高级量化技术

- 更好的压缩算法

- 更快的加载机制

- 增强的内存效率

市场预测

增长预测:

- 本地AI市场:到2027年达150亿美元

- GGUF采用率:本地部署的80%

- 消费级硬件渗透:2亿台设备

- 企业采用:AI部署的70%

技术演进:

- 实时模型流式传输

- 动态量化

- 联邦学习集成

- 边缘AI编排

入门:你的GGUF之旅

初学者设置指南

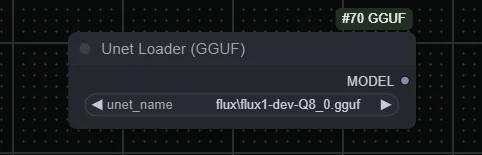

步骤1:选择你的平台

- Ollama:初学者最简单的选择

- llama.cpp:最大控制和自定义

- GGUF Loader:可视化界面选项

- 语言特定绑定:Python、JavaScript等

步骤2:硬件评估

| RAM容量 | 支持的模型大小 | 参数数量 |

|---|---|---|

| 8GB | 小型模型 | 7B参数 |

| 16GB | 中型模型 | 13B参数 |

| 32GB以上 | 大型模型 | 33B以上参数 |

步骤3:模型选择 从经过验证的模型开始:

- Llama 2/3:通用,文档完善

- Mistral:快速推理,质量好

- Code Llama:编程辅助

- Vicuna:聊天优化性能

高级配置

性能优化:

- 上下文长度调优

- 线程数优化

- 内存映射配置

- 量化选择

集成策略:

- API包装器开发

- 应用集成

- 自定义推理管道

- 监控和日志记录

常见问题故障排除

内存和性能问题

RAM不足:

- 使用较低的量化(Q3_K_M或Q2_K)

- 减少上下文长度

- 启用内存映射

- 关闭不必要的应用程序

性能慢:

- 检查线程数设置

- 验证硬件加速

- 更新到最新的GGUF版本

- 考虑混合CPU/GPU推理

模型加载错误:

- 验证GGUF文件完整性

- 检查模型兼容性

- 更新推理引擎

- 查看错误日志

平台特定解决方案

Windows优化:

- 使用Windows Terminal以获得更好的性能

- 配置Windows Defender排除项

- 启用硬件加速

- 使用WSL2进行基于Linux的工具

macOS配置:

- 启用Metal加速

- 配置内存压力

- 使用Homebrew管理依赖

- 针对Apple Silicon优化

Linux性能:

- 配置NUMA设置

- 启用适当的CPU功能

- 使用包管理器管理依赖

- 配置交换和内存

Apatero.com对GGUF模型的优势

虽然GGUF使本地AI变得可访问,但对于需要一致、高质量结果的专业人士来说,管理多个模型和配置可能会变得复杂。Apatero.com通过提供专业级平台来弥合这一差距,该平台利用GGUF的优势,同时消除技术复杂性。

为什么专业人士选择Apatero.com进行AI生成:

GGUF驱动的性能:

- 底层利用优化的GGUF模型

- 自动量化选择以获得最佳结果

- 专业级基础设施

- 一致、可靠的性能

无技术开销:

- 不需要模型管理

- 自动更新和优化

- 专业支持和可靠性

- 企业级安全性

适合使用本地AI的团队:

- 希望获得GGUF优势而无需复杂性的企业

- 需要一致AI输出的团队

- 需要专业支持的组织

- 扩展AI操作的公司

无缝集成:

- API访问GGUF驱动的模型

- 自定义模型部署选项

- 团队协作功能

- 专业工作流程工具

在Apatero.com体验具有企业可靠性的GGUF模型的强大功能。享受本地AI的所有优势,无需任何技术开销。

GGUF改变了一切

GGUF革命不仅仅代表了文件格式的改进。它是我们对AI可访问性和部署思考方式的根本转变。通过使强大的语言模型能够在消费级硬件上运行,GGUF以在两年前似乎不可能的方式实现了AI的民主化。

影响是不可否认的:

- 数百万用户现在可以在本地运行AI模型

- 隐私和安全已恢复到AI应用中

- 发展中国家已获得最先进AI的访问权限

- 小企业可以与科技巨头竞争

- 边缘创新已被释放

革命仍在继续: 随着GGUF的发展和新优化的出现,云和本地AI性能之间的差距继续缩小。未来属于本地AI,而GGUF正在引领这一潮流。

无论你是希望将AI集成到应用程序中的开发者、寻求私有AI解决方案的企业,还是想要探索最新模型的爱好者,GGUF都使这一切成为可能。革命就在这里,它是可访问的,并且正在你面前的设备上运行。

**准备加入GGUF革命了吗?**下载Ollama,安装你的第一个GGUF模型,今天就体验本地AI的未来。力量实实在在地掌握在你的手中。

准备好创建你的AI网红了吗?

加入115名学生,在我们完整的51节课程中掌握ComfyUI和AI网红营销。