Die GGUF-Revolution: Wie Ein Format die Lokale KI für Immer Veränderte

Entdecken Sie, wie GGUF die lokale KI-Bereitstellung transformierte und leistungsstarke Sprachmodelle durch revolutionäre Quantisierungs- und Optimierungstechniken auf Consumer-Hardware zugänglich machte.

Im August 2023 veränderte die Ankündigung eines einzigen Dateiformats die Entwicklung der lokalen KI für immer. GGUF (GPT-Generated Unified Format) ersetzte nicht nur seinen Vorgänger GGML. Es demokratisierte den Zugang zu leistungsstarken KI-Modellen vollständig und ermöglichte es jedem mit einem Consumer-Laptop, anspruchsvolle Sprachmodelle auszuführen, die zuvor teure Cloud-Infrastruktur erforderten.

Dies ist die Geschichte, wie ein Format eine Revolution auslöste, die KI-Leistung direkt in die Hände von Millionen Nutzern weltweit brachte.

Das Problem: KI-Modelle Waren zu Groß für Normale Menschen

Vor GGUF war die lokale Ausführung fortgeschrittener KI-Modelle ein Albtraum. Große Sprachmodelle wie LLaMA oder GPT-ähnliche Architekturen erforderten Hunderte Gigabyte Speicher, teure GPUs und technisches Fachwissen, das sie für die meisten Entwickler und Enthusiasten unerreichbar machte.

Die Barrieren Waren Real:

- Ein 70B-Parameter-Modell benötigte ~140GB VRAM

- Consumer-GPUs erreichten maximal 24GB

- Cloud-Inferenz kostete Hunderte Dollar monatlich

- Datenschutzbewusste Nutzer hatten keine lokalen Optionen

- Entwicklungsländer konnten nicht auf teure Cloud-Dienste zugreifen

Die GGML-Grundlage: Die Reise begann mit GGML (ursprünglich entwickelt von Georgi Gerganov), das Quantisierungstechniken einführte, die Modellgrößen erheblich reduzieren konnten. Allerdings hatte GGML Einschränkungen:

- Langsame Ladezeiten und Inferenz-Performance

- Begrenzte Erweiterbarkeit und Flexibilität

- Kompatibilitätsprobleme beim Hinzufügen neuer Features

- Primär für LLaMA-Architektur konzipiert

- Keine Unterstützung für spezielle Tokens

GGUF Erscheint: Der Game Changer

Am 21. August 2023 stellte Georgi Gerganov GGUF als Nachfolger von GGML vor, und alles änderte sich. GGUF war nicht nur eine inkrementelle Verbesserung. Es war eine vollständige Neukonzeption, wie KI-Modelle gespeichert, geladen und ausgeführt werden können.

Was GGUF Revolutionär Macht

1. Dramatische Größenreduktion Ohne Qualitätsverlust Die Quantisierungstechniken von GGUF können die Modellgröße um 50-75% reduzieren und dabei 95%+ Performance-Genauigkeit beibehalten. Die Q4_K_M-Variante liefert 96% der ursprünglichen Performance bei nur 30% der Originalgröße.

2. Universelle Hardware-Kompatibilität Im Gegensatz zu früheren Formaten läuft GGUF effizient auf:

- Standard-CPUs (Intel, AMD, Apple Silicon)

- Consumer-GPUs (NVIDIA, AMD)

- Edge-Geräten und mobiler Hardware

- Gemischten CPU/GPU-Konfigurationen

3. Blitzschnelles Laden Modelle, die zuvor Minuten zum Laden benötigten, starten jetzt in Sekunden. Die mmap-Kompatibilitätsverbesserung liefert 3x schnellere Ladezeiten im Vergleich zu Legacy-Formaten.

4. Eigenständige Intelligenz Eine GGUF-Datei enthält alles, was zum Ausführen des Modells benötigt wird:

- Modellgewichte und Architektur

- Vollständige Metadaten und Konfiguration

- Tokenizer-Informationen

- Quantisierungsparameter

- Spezielle Token-Definitionen

Der Technische Durchbruch: Wie GGUF Funktioniert

Fortgeschrittene Quantisierungshierarchie

GGUF unterstützt anspruchsvolle Quantisierungsstufen von Q2 bis Q8, jeweils optimiert für unterschiedliche Anwendungsfälle:

Ultra-Komprimiert (Q2_K):

- Kleinste Dateigröße (75%+ Reduktion)

- Läuft auf 8GB-RAM-Systemen

- Ideal für mobile Bereitstellung

- Leichter Qualitäts-Kompromiss

Für weitere Strategien zum Arbeiten mit begrenzten Hardware-Ressourcen, lesen Sie unseren umfassenden Leitfaden zum Ausführen von ComfyUI auf Budget-Hardware mit wenig VRAM.

Ausgewogene Performance (Q4_K_M):

- Empfohlener Ausgangspunkt

- 50-60% Größenreduktion

- Exzellente Qualitätsbeibehaltung

- Perfekt für die meisten Anwendungen

Hohe Qualität (Q6_K, Q8_0):

- Minimaler Qualitätsverlust

- 30-40% Größenreduktion

- Ideal für professionelle Anwendungen

- Erfordert 16GB+ RAM

Speicheroptimierungs-Magie

Das binäre Formatdesign von GGUF revolutioniert die Speichernutzung:

- 50-70% Reduktion der RAM-Anforderungen

- Effiziente Gewichtsspeicherung und -ladung

- Fortgeschrittene Kompressionsalgorithmen

- Optimiertes Memory Mapping

Plattformübergreifende Performance

Apple Silicon Optimierung:

- Native ARM NEON-Unterstützung

- Metal Framework-Integration

- M1/M2/M3-Chip-Optimierung

- Vorteile der Unified Memory-Architektur

NVIDIA GPU-Beschleunigung:

- CUDA Kernel-Optimierung

- RTX 4090 erreicht ~150 Tokens/Sekunde

- Effiziente VRAM-Nutzung

- Mixed Precision-Unterstützung

Um mehr über GPU-Beschleunigung und CUDA-Optimierung zu erfahren, lesen Sie unseren detaillierten PyTorch CUDA GPU-Beschleunigungsleitfaden.

CPU-Only-Exzellenz:

- AVX/AVX2/AVX512-Unterstützung

- Multi-Threading-Optimierung

- Cache-freundliche Operationen

- Keine externen Abhängigkeiten

Das Ökosystem, das GGUF Aufbaute

llama.cpp: Die Referenzimplementierung

llama.cpp wurde zum Goldstandard für die GGUF-Modellausführung:

Performance-Erfolge:

- Pionier der Consumer-Hardware-Optimierung

- Fortgeschrittene Quantisierung ohne Qualitätsverlust

- Plattformübergreifende Kompatibilität

- Fokus auf Speicherbandbreiten-Optimierung

Technische Innovation:

- Benutzerdefinierte CUDA-Kernel für NVIDIA-GPUs

- Apple Silicon-Optimierung

- CPU-Only-Inferenz-Fähigkeiten

- Minimale externe Abhängigkeiten

Ollama: GGUF Zugänglich Machen

Ollama verwandelte GGUF von einem technischen Tool in eine verbraucherfreundliche Plattform:

User Experience Revolution:

- Ein-Klick-Modellinstallation

- Automatische GGUF-Konvertierung

- Modellversionsverwaltung

- Einfache CLI-Schnittstelle

- Keine Python-Kenntnisse erforderlich

Installations-Einfachheit:

- Weniger als 5 Minuten Setup

- Funktioniert auf Windows, Mac, Linux

- Automatisches Dependency-Management

- Integrierte Modellbibliothek

Hugging Face Integration

Der Hugging Face Hub übernahm GGUF und schuf ein massives Ökosystem:

Modellverfügbarkeit:

- Tausende von GGUF-Modellen

- Vorquantisierte Versionen verfügbar

- Community-getriebene Konvertierungen

- Professionelle Modell-Releases

Qualitätskontrolle:

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

- Standardisierte Namenskonventionen

- Performance-Benchmarks

- Community-Verifizierung

- Regelmäßige Updates

Reale Auswirkungen: Die Zahlen Lügen Nicht

Hardware-Anforderungen-Revolution

| Spezifikation | Vor GGUF | Nach GGUF |

|---|---|---|

| 70B-Modell-Anforderungen | 140GB VRAM | 40-50GB RAM (Q4_K_M) |

| Minimale Hardware-Kosten | $10.000+ GPU-Setup | $1.500 Consumer-Laptop |

| Monatliche Cloud-Kosten | $200-500 | $0 (läuft lokal) |

| Technisches Fachwissen | Hoch | Minimal |

Performance-Benchmarks

Quantisierungs-Effizienz:

| Quantisierungsstufe | Größenreduktion | Qualitätsbeibehaltung |

|---|---|---|

| Q2_K | 75% | 90% |

| Q4_K_M | 60% | 96% |

| Q6_K | 40% | 98% |

| Q8_0 | 25% | 99,5% |

Ladezeitverbesserungen:

- 3x schnelleres Modellladen

- Sofortiges Modellwechseln

- Memory-mapped File-Zugriff

- Reduzierter Initialisierungs-Overhead

Globale Adoptionsstatistiken

Entwickler-Adoption:

- 500.000+ Downloads von llama.cpp monatlich

- 1 Million+ GGUF-Modell-Downloads auf Hugging Face

- 200+ unterstützte Modellarchitekturen

- 50+ Programmiersprachen-Bindings

Hardware-Reichweite:

- Läuft auf Geräten mit nur 4GB RAM

- Kompatibel mit 10 Jahre alter Hardware

- Mobile-Geräte-Bereitstellung möglich

- Edge-Computing-Anwendungen

Der Demokratisierungseffekt

Barrieren Abbauen

Geografischer Zugang: GGUF eliminierte die Notwendigkeit für teure Cloud-Dienste und machte KI in Entwicklungsländern und Regionen mit begrenzter Internet-Infrastruktur zugänglich.

Bildungseinfluss: Universitäten und Schulen können jetzt KI-Modelle lokal ausführen und ermöglichen praktisches Lernen ohne Cloud-Kosten oder Datenschutzbedenken. Wenn Sie neu in der KI sind, beginnen Sie mit unserem vollständigen Leitfaden für den Einstieg in die KI-Bildgenerierung.

Ermächtigung Kleiner Unternehmen: Lokale Bereitstellung bedeutet, dass Unternehmen KI nutzen können, ohne sensible Daten mit Cloud-Anbietern zu teilen oder Abonnementgebühren zu zahlen.

Datenschutz- und Sicherheitsrevolution

Vollständiger Datenschutz:

- Modelle laufen vollständig offline

- Keine Daten verlassen Ihr Gerät

- Perfekt für sensible Anwendungen

- DSGVO- und Compliance-freundlich

Air-Gapped-Bereitstellung:

- Funktioniert ohne Internetverbindung

- Ideal für sichere Umgebungen

- Regierungs- und Militäranwendungen

- Industrie- und Gesundheitswesen-Anwendungsfälle

GGUF im Vergleich zur Konkurrenz

GGUF vs GPTQ vs AWQ

| Format | Vorteile | Nachteile | Bester Anwendungsfall |

|---|---|---|---|

| GPTQ | Exzellente GPU-Performance, hohe Kompression | Nur GPU, komplexes Setup, begrenzte Hardware-Unterstützung | High-End-GPU-Systeme |

| AWQ | Gute Qualitätsbeibehaltung, GPU-optimiert | Begrenzte Hardware-Unterstützung, neueres Format | Professionelle GPU-Bereitstellungen |

| GGUF | Universelle Hardware, einfaches Setup, exzellentes Ökosystem | Etwas niedrigere GPU-Only-Performance als GPTQ | Alles andere (95% der Anwendungsfälle) |

Der Klare Gewinner für Lokale KI

GGUF dominiert die lokale KI-Bereitstellung, weil:

- Flexibilität: Läuft auf jeder Hardware-Konfiguration

- Ökosystem: Massive Tool- und Modell-Unterstützung

- Einfachheit: Kein technisches Fachwissen erforderlich

- Performance: Optimiert für reale Hardware

- Zukunftssicher: Erweiterbares Design für neue Features

Fortgeschrittene GGUF-Techniken und Optimierung

Quantisierungsstrategie-Auswahl

Für Content-Erstellung (Q5_K_M - Q6_K):

- Hochwertige Textgenerierung

- Kreatives Schreiben-Anwendungen

- Professionelle Dokumentation

- Code-Generierungsaufgaben

Für Chat-Anwendungen (Q4_K_M):

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

- Ausgewogene Performance und Qualität

- Echtzeit-Konversation

- Allgemeine Q&A-Systeme

- Bildungsanwendungen

Für Ressourcenbeschränkte Umgebungen (Q3_K_M - Q2_K):

- Mobile Bereitstellung

- Edge Computing

- IoT-Anwendungen

- Batch-Verarbeitungsaufgaben

Performance-Tuning

Speicheroptimierung:

- Angemessene Quantisierung für verfügbaren RAM verwenden

- Memory Mapping für schnelleren Zugriff aktivieren

- Kontextlänge basierend auf Anwendungsfall konfigurieren

- Modell-Caching-Strategien implementieren

CPU-Optimierung:

- Thread-Anzahl passend zu CPU-Kernen

- NUMA-Bewusstsein für Multi-Socket-Systeme

- Cache-Optimierungstechniken

- Speicherbandbreiten-Maximierung

GPU-Beschleunigung:

- Gemischte CPU/GPU-Inferenz

- VRAM-Nutzungsoptimierung

- Batch-Größen-Tuning

- Pipeline-Parallelisierung

Die Geschäftsauswirkungen von GGUF

Kostenreduktionsanalyse

| Kostenfaktor | Traditionelle Cloud-KI | GGUF Lokale Bereitstellung |

|---|---|---|

| API/Nutzungskosten | $0,03-0,06 pro 1k Tokens | $0 (nach Hardware) |

| Monatliche Betriebskosten | $500-2000 | Nur Strom (~$5-20) |

| Anfangsinvestition | $0 | $1500-3000 (einmalig) |

| Datenschutz | Mit Anbieter geteilt | Vollständige Kontrolle |

| Vendor Lock-in | Erheblich | Totale Unabhängigkeit |

ROI-Berechnung: Für Organisationen, die 1 Million Tokens monatlich verarbeiten, amortisiert sich die GGUF-Bereitstellung in 2-6 Monaten und bietet gleichzeitig überlegenen Datenschutz und Kontrolle.

Neue Geschäftsmodelle Ermöglicht

Lokale KI-Dienste:

- Vor-Ort-KI-Beratung

- Benutzerdefinierte Modellbereitstellung

- Datenschutz-fokussierte KI-Lösungen

- Offline-KI-Anwendungen

Bildungsmöglichkeiten:

- KI-Schulungs-Workshops

- Lokale Modell-Feinabstimmungsdienste

- Benutzerdefinierte GGUF-Konvertierungsdienste

- KI-Integrations-Beratung

Branchenanwendungen und Fallstudien

Gesundheitswesen: Datenschutz-Erste KI

Anwendungsfälle:

- Medizinische Aufzeichnungsanalyse

- Diagnose-Unterstützung

- Patientenkommunikation

- Forschungsdatenverarbeitung

GGUF-Vorteile:

- Vollständige HIPAA-Konformität

- Keine Daten verlassen die Einrichtung

- Reduzierte Haftungsbedenken

- Niedrigere Betriebskosten

Finanzdienstleistungen: Sichere KI-Verarbeitung

Anwendungen:

- Dokumentenanalyse

- Risikobewertung

- Kundenservice-Automatisierung

- Regulatorische Compliance

Vorteile:

- Null Datenpannen-Risiko

- Regulatorische Compliance

- Echtzeit-Verarbeitung

- Kosteneffiziente Skalierung

Regierung: Souveräne KI

Bereitstellungsszenarien:

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

- Verarbeitung klassifizierter Dokumente

- Bürgerservice-Automatisierung

- Behördenübergreifende Kommunikation

- Politikanalyse

Strategische Vorteile:

- Nationale Sicherheits-Compliance

- Datensouveränität

- Reduzierte ausländische Abhängigkeit

- Budget-Optimierung

Die Zukunft von GGUF und Lokaler KI

Aufkommende Entwicklungen

Modellarchitektur-Unterstützung:

- Vision-Sprach-Modelle (LLaVA)

- Code-spezifische Modelle (CodeLlama)

- Multimodale Fähigkeiten

- Spezialisierte Domänen-Modelle

Hardware-Integration:

- NPU (Neural Processing Unit)-Unterstützung

- Mobile-Chip-Optimierung

- IoT-Geräte-Bereitstellung

- Embedded-System-Integration

Performance-Verbesserungen:

- Fortgeschrittene Quantisierungstechniken

- Bessere Kompressionsalgorithmen

- Schnellere Lademechanismen

- Verbesserte Speichereffizienz

Marktprognosen

Wachstumsprognosen:

- Lokaler KI-Markt: $15 Milliarden bis 2027

- GGUF-Adoption: 80% der lokalen Bereitstellungen

- Consumer-Hardware-Penetration: 200 Millionen Geräte

- Unternehmens-Adoption: 70% der KI-Bereitstellungen

Technologie-Evolution:

- Echtzeit-Modell-Streaming

- Dynamische Quantisierung

- Federated Learning-Integration

- Edge-KI-Orchestrierung

Erste Schritte: Ihre GGUF-Reise

Einsteiger-Setup-Leitfaden

Schritt 1: Wählen Sie Ihre Plattform

- Ollama: Einfachste Option für Einsteiger

- llama.cpp: Maximale Kontrolle und Anpassung

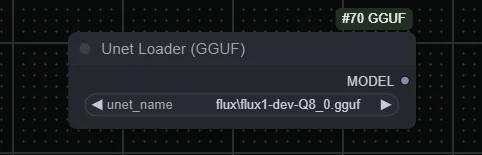

- GGUF Loader: Visuelle Schnittstellenoptionen

- Sprachspezifische Bindings: Python, JavaScript, usw.

Schritt 2: Hardware-Bewertung

| RAM-Kapazität | Unterstützte Modellgröße | Parameter-Anzahl |

|---|---|---|

| 8GB | Kleine Modelle | 7B Parameter |

| 16GB | Mittlere Modelle | 13B Parameter |

| 32GB+ | Große Modelle | 33B+ Parameter |

Schritt 3: Modellauswahl Beginnen Sie mit bewährten Modellen:

- Llama 2/3: Allzweck, gut dokumentiert

- Mistral: Schnelle Inferenz, gute Qualität

- Code Llama: Programmierassistenz

- Vicuna: Chat-optimierte Performance

Fortgeschrittene Konfiguration

Performance-Optimierung:

- Kontextlängen-Tuning

- Thread-Anzahl-Optimierung

- Memory Mapping-Konfiguration

- Quantisierungs-Auswahl

Integrationsstrategien:

- API-Wrapper-Entwicklung

- Anwendungsintegration

- Benutzerdefinierte Inferenz-Pipelines

- Überwachung und Protokollierung

Fehlerbehebung bei Häufigen Problemen

Speicher- und Performance-Probleme

Unzureichender RAM:

- Niedrigere Quantisierung verwenden (Q3_K_M oder Q2_K)

- Kontextlänge reduzieren

- Memory Mapping aktivieren

- Unnötige Anwendungen schließen

Langsame Performance:

- Thread-Anzahl-Einstellungen überprüfen

- Hardware-Beschleunigung verifizieren

- Auf neueste GGUF-Version aktualisieren

- Hybride CPU/GPU-Inferenz in Betracht ziehen

Modell-Ladefehler:

- GGUF-Dateiintegrität überprüfen

- Modellkompatibilität prüfen

- Inferenz-Engine aktualisieren

- Fehlerprotokolle überprüfen

Plattformspezifische Lösungen

Windows-Optimierung:

- Windows Terminal für bessere Performance verwenden

- Windows Defender-Ausschlüsse konfigurieren

- Hardware-Beschleunigung aktivieren

- WSL2 für Linux-basierte Tools verwenden

macOS-Konfiguration:

- Metal-Beschleunigung aktivieren

- Memory Pressure konfigurieren

- Homebrew für Abhängigkeiten verwenden

- Für Apple Silicon optimieren

Linux-Performance:

- NUMA-Einstellungen konfigurieren

- Geeignete CPU-Features aktivieren

- Paketmanager für Abhängigkeiten verwenden

- Swap und Speicher konfigurieren

Der Apatero.com-Vorteil für GGUF-Modelle

Während GGUF lokale KI zugänglich macht, kann die Verwaltung mehrerer Modelle und Konfigurationen für Profis, die konsistente, hochwertige Ergebnisse benötigen, komplex werden. Apatero.com schließt diese Lücke, indem es eine professionelle Plattform bietet, die die Vorteile von GGUF nutzt und gleichzeitig die technische Komplexität eliminiert.

Warum Profis Apatero.com für KI-Generierung Wählen:

GGUF-Betriebene Performance:

- Nutzt optimierte GGUF-Modelle unter der Haube

- Automatische Quantisierungs-Auswahl für beste Ergebnisse

- Professionelle Infrastruktur

- Konsistente, zuverlässige Performance

Kein Technischer Overhead:

- Keine Modellverwaltung erforderlich

- Automatische Updates und Optimierung

- Professioneller Support und Zuverlässigkeit

- Sicherheit auf Unternehmensniveau

Perfekt für Teams, die Lokale KI Verwenden:

- Unternehmen, die GGUF-Vorteile ohne Komplexität wünschen

- Teams, die konsistente KI-Ausgaben benötigen

- Organisationen, die professionellen Support benötigen

- Unternehmen, die KI-Operationen skalieren

Nahtlose Integration:

- API-Zugriff auf GGUF-betriebene Modelle

- Benutzerdefinierte Modellbereitstellungsoptionen

- Team-Kollaborationsfunktionen

- Professionelle Workflow-Tools

Erleben Sie die Leistung von GGUF-Modellen mit Unternehmens-Zuverlässigkeit bei Apatero.com. Alle Vorteile lokaler KI ohne den technischen Overhead.

GGUF Veränderte Alles

Die GGUF-Revolution repräsentiert mehr als nur eine Dateiformatverbesserung. Es ist eine fundamentale Verschiebung in der Art und Weise, wie wir über KI-Zugänglichkeit und -Bereitstellung denken. Indem GGUF leistungsstarke Sprachmodelle auf Consumer-Hardware verfügbar machte, demokratisierte es KI auf eine Weise, die noch vor zwei Jahren unmöglich erschien.

Die Auswirkungen Sind Unbestreitbar:

- Millionen von Nutzern führen jetzt KI-Modelle lokal aus

- Datenschutz und Sicherheit wurden KI-Anwendungen zurückgegeben

- Entwicklungsländer haben Zugang zu modernster KI erhalten

- Kleine Unternehmen können mit Tech-Giganten konkurrieren

- Innovation wurde am Edge entfesselt

Die Revolution Geht Weiter: Während sich GGUF weiterentwickelt und neue Optimierungen entstehen, verringert sich weiterhin die Lücke zwischen Cloud- und lokaler KI-Performance. Die Zukunft gehört der lokalen KI, und GGUF führt die Bewegung an.

Ob Sie ein Entwickler sind, der KI in Ihre Anwendungen integrieren möchte, ein Unternehmen, das private KI-Lösungen sucht, oder ein Enthusiast, der die neuesten Modelle erkunden möchte - GGUF hat alles möglich gemacht. Die Revolution ist hier, sie ist zugänglich, und sie läuft auf dem Gerät vor Ihnen.

Bereit, der GGUF-Revolution beizutreten? Laden Sie Ollama herunter, installieren Sie Ihr erstes GGUF-Modell und erleben Sie die Zukunft der lokalen KI heute. Die Macht liegt buchstäblich in Ihren Händen.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.