GGUF革命:1つのフォーマットがローカルAIを永久に変えた方法

GGUFがローカルAI展開をどのように変革し、革新的な量子化と最適化技術により、コンシューマーハードウェアで強力な言語モデルにアクセスできるようにしたかをご紹介します。

2023年8月、1つのファイルフォーマットの発表が、ローカルAIの軌道を永久に変えました。GGUF(GPT-Generated Unified Format)は、その前身であるGGMLを単に置き換えただけではありません。強力なAIモデルへのアクセスを完全に民主化し、高価なクラウドインフラストラクチャを必要としていた高度な言語モデルを、コンシューマー向けラップトップで誰でも実行できるようにしたのです。

これは、1つのフォーマットが世界中の何百万ものユーザーの手に直接AIパワーをもたらした革命の物語です。

問題:AIモデルは一般の人々にとって大きすぎた

GGUF以前は、高度なAIモデルをローカルで実行することは悪夢でした。LLaMAやGPTスタイルのアーキテクチャのような大規模言語モデルは、数百ギガバイトのメモリ、高価なGPU、そしてほとんどの開発者や愛好家の手の届かない技術的専門知識を必要としました。

障壁は現実的でした:

- 70Bパラメータモデルには約140GBのVRAMが必要でした

- コンシューマーGPUは最大24GBまでしか対応していませんでした

- クラウド推論には月額数百ドルのコストがかかりました

- プライバシーを重視するユーザーにはローカルオプションがありませんでした

- 発展途上国では高価なクラウドサービスにアクセスできませんでした

GGMLの基盤:この旅はGGML(Georgi Gerganovによって開発)から始まりました。GGMLは、モデルサイズを大幅に削減できる量子化技術を導入しました。しかし、GGMLには制限がありました:

- 読み込み時間と推論パフォーマンスが遅い

- 拡張性と柔軟性が限られている

- 新機能追加時の互換性の問題

- 主にLLaMAアーキテクチャ向けに設計されている

- 特殊トークンのサポートがない

GGUFの登場:ゲームチェンジャー

2023年8月21日、Georgi GerganovがGGMLの後継としてGGUFを発表し、すべてが変わりました。GGUFは単なる段階的な改善ではありませんでした。AIモデルの保存、読み込み、実行方法の完全な再構想でした。

GGUFが革命的である理由

1. 品質を損なわない劇的なサイズ削減 GGUFの量子化技術は、95%以上のパフォーマンス精度を維持しながら、モデルサイズを50-75%削減できます。Q4_K_Mバリアントは、元のサイズのわずか30%で元のパフォーマンスの96%を提供します。

2. 普遍的なハードウェア互換性 以前のフォーマットとは異なり、GGUFは以下で効率的に動作します:

- 標準CPU(Intel、AMD、Apple Silicon)

- コンシューマーGPU(NVIDIA、AMD)

- エッジデバイスとモバイルハードウェア

- CPU/GPU混合構成

3. 超高速読み込み 以前は読み込みに数分かかっていたモデルが、今では数秒で起動します。mmap互換性の強化により、レガシーフォーマットと比較して3倍高速な読み込み時間を実現しています。

4. 自己完結型インテリジェンス GGUFファイルには、モデルを実行するために必要なすべてが含まれています:

- モデルの重みとアーキテクチャ

- 完全なメタデータと設定

- トークナイザー情報

- 量子化パラメータ

- 特殊トークン定義

技術的ブレークスルー:GGUFの仕組み

高度な量子化階層

GGUFは、Q2からQ8までの高度な量子化レベルをサポートしており、それぞれが異なるユースケースに最適化されています:

超圧縮(Q2_K):

- 最小のファイルサイズ(75%以上の削減)

- 8GB RAMシステムで動作

- モバイル展開に最適

- わずかな品質のトレードオフ

限られたハードウェアリソースでの作業戦略については、低VRAMでも問題なし:予算ハードウェアでComfyUIを実行するの包括的なガイドをご覧ください。

バランスの取れたパフォーマンス(Q4_K_M):

- 推奨される開始点

- 50-60%のサイズ削減

- 優れた品質保持

- ほとんどのアプリケーションに最適

高品質(Q6_K、Q8_0):

- 最小限の品質損失

- 30-40%のサイズ削減

- プロフェッショナルアプリケーションに最適

- 16GB以上のRAMが必要

メモリ最適化の魔法

GGUFのバイナリフォーマット設計は、メモリ使用を革命化します:

- RAMの必要量が50-70%削減

- 効率的な重みの保存と読み込み

- 高度な圧縮アルゴリズム

- 最適化されたメモリマッピング

クロスプラットフォームパフォーマンス

Apple Siliconの最適化:

- ネイティブARM NEONサポート

- Metalフレームワーク統合

- M1/M2/M3チップの最適化

- ユニファイドメモリアーキテクチャの利点

NVIDIA GPUアクセラレーション:

- CUDAカーネルの最適化

- RTX 4090で約150トークン/秒を達成

- 効率的なVRAM利用

- 混合精度サポート

GPUアクセラレーションとCUDA最適化について詳しくは、PyTorch CUDA GPU加速ガイドをご覧ください。

CPU専用の優秀性:

- AVX/AVX2/AVX512サポート

- マルチスレッド最適化

- キャッシュに優しい操作

- 外部依存関係なし

GGUFが構築したエコシステム

llama.cpp:リファレンス実装

llama.cppは、GGUFモデル実行のゴールドスタンダードとなりました:

パフォーマンスの成果:

- コンシューマーハードウェア最適化の先駆者

- 品質を損なわない高度な量子化

- クロスプラットフォーム互換性

- メモリ帯域幅最適化に焦点

技術革新:

- NVIDIA GPU用のカスタムCUDAカーネル

- Apple Siliconの最適化

- CPU専用の推論機能

- 最小限の外部依存関係

Ollama:GGUFをアクセシブルに

Ollamaは、GGUFを技術的なツールからコンシューマーフレンドリーなプラットフォームに変えました:

ユーザーエクスペリエンス革命:

- ワンクリックモデルインストール

- 自動GGUF変換

- モデルバージョン管理

- シンプルなCLIインターフェース

- Pythonの知識不要

インストールのシンプルさ:

- 5分未満のセットアップ

- Windows、Mac、Linuxで動作

- 自動依存関係管理

- 統合モデルライブラリ

Hugging Faceの統合

Hugging Face HubはGGUFを受け入れ、巨大なエコシステムを作り上げました:

モデルの利用可能性:

- 数千のGGUFモデル

- 事前量子化バージョンが利用可能

- コミュニティ主導の変換

- プロフェッショナルモデルのリリース

品質管理:

無料のComfyUIワークフロー

この記事のテクニックに関する無料のオープンソースComfyUIワークフローを見つけてください。 オープンソースは強力です。

- 標準化された命名規則

- パフォーマンスベンチマーク

- コミュニティによる検証

- 定期的な更新

実世界への影響:数字は嘘をつかない

ハードウェア要件の革命

| 仕様 | GGUF以前 | GGUF以後 |

|---|---|---|

| 70Bモデルの要件 | 140GB VRAM | 40-50GB RAM(Q4_K_M) |

| 最小ハードウェアコスト | $10,000以上のGPUセットアップ | $1,500のコンシューマーラップトップ |

| 月額クラウドコスト | $200-500 | $0(ローカルで実行) |

| 技術的専門知識 | 高い | 最小限 |

パフォーマンスベンチマーク

量子化効率:

| 量子化レベル | サイズ削減 | 品質保持 |

|---|---|---|

| Q2_K | 75% | 90% |

| Q4_K_M | 60% | 96% |

| Q6_K | 40% | 98% |

| Q8_0 | 25% | 99.5% |

読み込み速度の改善:

- 3倍高速なモデル読み込み

- 即座のモデル切り替え

- メモリマップファイルアクセス

- 初期化オーバーヘッドの削減

グローバル採用統計

開発者の採用:

- llama.cppの月間50万以上のダウンロード

- Hugging Faceでの100万以上のGGUFモデルダウンロード

- 200以上のサポートされているモデルアーキテクチャ

- 50以上のプログラミング言語バインディング

ハードウェアリーチ:

- わずか4GB RAMのデバイスで動作

- 10年前のハードウェアと互換性あり

- モバイルデバイスへの展開が可能

- エッジコンピューティングアプリケーション

民主化の効果

障壁を打ち破る

地理的アクセス: GGUFは、高価なクラウドサービスの必要性を排除し、発展途上国やインターネットインフラが限られた地域でAIをアクセス可能にしました。

教育的影響: 大学や学校は、クラウドコストやプライバシーの懸念なしに、AIモデルをローカルで実行できるようになり、実践的な学習が可能になりました。AIが初めての方は、2025年版AI画像生成を始めるための完全ガイドから始めてください。

中小企業のエンパワーメント: ローカル展開により、企業はクラウドプロバイダーと機密データを共有したり、サブスクリプション料金を支払ったりすることなく、AIを使用できます。

プライバシーとセキュリティの革命

完全なデータプライバシー:

- モデルは完全にオフラインで実行されます

- データはデバイスから外に出ません

- 機密アプリケーションに最適

- GDPRおよびコンプライアンスに適合

エアギャップ展開:

- インターネット接続なしで動作

- セキュアな環境に最適

- 政府および軍事アプリケーション

- 産業および医療のユースケース

GGUFと競合他社の比較

GGUF vs GPTQ vs AWQ

| フォーマット | 長所 | 短所 | 最適なユースケース |

|---|---|---|---|

| GPTQ | 優れたGPUパフォーマンス、高い圧縮率 | GPU専用、複雑なセットアップ、限られたハードウェアサポート | ハイエンドGPUシステム |

| AWQ | 良好な品質保持、GPU最適化 | 限られたハードウェアサポート、新しいフォーマット | プロフェッショナルGPU展開 |

| GGUF | 普遍的なハードウェア、簡単なセットアップ、優れたエコシステム | GPTQよりもわずかに低いGPU専用パフォーマンス | その他すべて(95%のユースケース) |

ローカルAIの明確な勝者

GGUFがローカルAI展開を支配する理由:

- 柔軟性:あらゆるハードウェア構成で動作

- エコシステム:膨大なツールとモデルのサポート

- シンプルさ:技術的専門知識不要

- パフォーマンス:実世界のハードウェアに最適化

- 将来性:新機能のための拡張可能な設計

高度なGGUF技術と最適化

量子化戦略の選択

コンテンツ作成用(Q5_K_M - Q6_K):

- 高品質なテキスト生成

- クリエイティブライティングアプリケーション

- プロフェッショナルなドキュメント作成

- コード生成タスク

チャットアプリケーション用(Q4_K_M):

複雑さをスキップしたいですか? Apatero は、技術的なセットアップなしでプロフェッショナルなAI結果を即座に提供します。

- バランスの取れたパフォーマンスと品質

- リアルタイム会話

- 一般的なQ&Aシステム

- 教育アプリケーション

リソース制約環境用(Q3_K_M - Q2_K):

- モバイル展開

- エッジコンピューティング

- IoTアプリケーション

- バッチ処理タスク

パフォーマンスチューニング

メモリ最適化:

- 利用可能なRAMに適した量子化を使用

- より高速なアクセスのためにメモリマッピングを有効化

- ユースケースに基づいてコンテキスト長を設定

- モデルキャッシング戦略を実装

CPU最適化:

- CPUコアに合わせたスレッド数

- マルチソケットシステムのNUMA認識

- キャッシュ最適化技術

- メモリ帯域幅の最大化

GPUアクセラレーション:

- 混合CPU/GPU推論

- VRAM使用の最適化

- バッチサイズのチューニング

- パイプライン並列化

GGUFのビジネスインパクト

コスト削減分析

| コスト要因 | 従来のクラウドAI | GGUFローカル展開 |

|---|---|---|

| API/使用コスト | 1000トークンあたり$0.03-0.06 | $0(ハードウェア後) |

| 月額運用コスト | $500-2000 | 電気代のみ(約$5-20) |

| 初期投資 | $0 | $1500-3000(一回限り) |

| データプライバシー | プロバイダーと共有 | 完全な管理 |

| ベンダーロックイン | 重大 | 完全な独立 |

ROI計算: 月間100万トークンを処理する組織の場合、GGUF展開は2-6か月で投資回収でき、優れたプライバシーとコントロールを提供します。

可能になった新しいビジネスモデル

ローカルAIサービス:

- オンプレミスAIコンサルティング

- カスタムモデル展開

- プライバシー重視のAIソリューション

- オフラインAIアプリケーション

教育機会:

- AIトレーニングワークショップ

- ローカルモデルファインチューニングサービス

- カスタムGGUF変換サービス

- AI統合コンサルティング

業界アプリケーションとケーススタディ

医療:プライバシー第一のAI

ユースケース:

- 医療記録分析

- 診断支援

- 患者コミュニケーション

- 研究データ処理

GGUFの利点:

- 完全なHIPAAコンプライアンス

- データが施設外に出ない

- 責任リスクの軽減

- 運用コストの削減

金融サービス:セキュアなAI処理

アプリケーション:

- 文書分析

- リスク評価

- カスタマーサービスの自動化

- 規制コンプライアンス

利点:

- データ侵害リスクゼロ

- 規制コンプライアンス

- リアルタイム処理

- コスト効果的なスケーリング

政府:主権AI

展開シナリオ:

コンテンツ制作で月$1,250以上稼ぐ

独占クリエイターアフィリエイトプログラムに参加。バイラル動画のパフォーマンスに応じて報酬。自分のスタイルで完全な創造的自由を持ってコンテンツを作成。

- 機密文書処理

- 市民サービスの自動化

- 省庁間コミュニケーション

- 政策分析

戦略的利点:

- 国家安全保障コンプライアンス

- データ主権

- 外国依存の削減

- 予算最適化

GGUFとローカルAIの未来

新たな展開

モデルアーキテクチャサポート:

- ビジョン言語モデル(LLaVA)

- コード特化モデル(CodeLlama)

- マルチモーダル機能

- 特化ドメインモデル

ハードウェア統合:

- NPU(Neural Processing Unit)サポート

- モバイルチップ最適化

- IoTデバイス展開

- 組み込みシステム統合

パフォーマンス改善:

- 高度な量子化技術

- より優れた圧縮アルゴリズム

- より高速な読み込みメカニズム

- 強化されたメモリ効率

市場予測

成長予測:

- ローカルAI市場:2027年までに150億ドル

- GGUF採用:ローカル展開の80%

- コンシューマーハードウェア浸透:2億デバイス

- エンタープライズ採用:AI展開の70%

技術進化:

- リアルタイムモデルストリーミング

- 動的量子化

- フェデレーテッドラーニング統合

- エッジAIオーケストレーション

始めよう:あなたのGGUFジャーニー

初心者向けセットアップガイド

ステップ1:プラットフォームを選ぶ

- Ollama:初心者にとって最もシンプルなオプション

- llama.cpp:最大限の制御とカスタマイズ

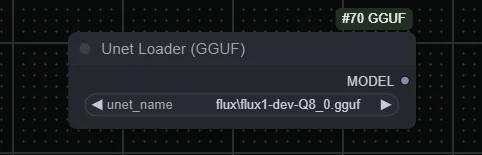

- GGUF Loader:ビジュアルインターフェースオプション

- 言語固有のバインディング:Python、JavaScriptなど

ステップ2:ハードウェア評価

| RAM容量 | サポートされるモデルサイズ | パラメータ数 |

|---|---|---|

| 8GB | 小型モデル | 7Bパラメータ |

| 16GB | 中型モデル | 13Bパラメータ |

| 32GB以上 | 大型モデル | 33B以上のパラメータ |

ステップ3:モデル選択 実績のあるモデルから始めましょう:

- Llama 2/3:汎用、よくドキュメント化されている

- Mistral:高速推論、良好な品質

- Code Llama:プログラミング支援

- Vicuna:チャット最適化パフォーマンス

高度な設定

パフォーマンス最適化:

- コンテキスト長のチューニング

- スレッド数の最適化

- メモリマッピングの設定

- 量子化の選択

統合戦略:

- APIラッパー開発

- アプリケーション統合

- カスタム推論パイプライン

- モニタリングとロギング

一般的な問題のトラブルシューティング

メモリとパフォーマンスの問題

RAM不足:

- より低い量子化を使用(Q3_K_MまたはQ2_K)

- コンテキスト長を削減

- メモリマッピングを有効化

- 不要なアプリケーションを閉じる

パフォーマンスの低下:

- スレッド数の設定を確認

- ハードウェアアクセラレーションを検証

- 最新のGGUFバージョンに更新

- ハイブリッドCPU/GPU推論を検討

モデル読み込みエラー:

- GGUFファイルの整合性を検証

- モデルの互換性を確認

- 推論エンジンを更新

- エラーログを確認

プラットフォーム固有のソリューション

Windows最適化:

- より良いパフォーマンスのためにWindows Terminalを使用

- Windows Defenderの除外を設定

- ハードウェアアクセラレーションを有効化

- LinuxベースのツールにはWSL2を使用

macOS設定:

- Metalアクセラレーションを有効化

- メモリプレッシャーを設定

- 依存関係にはHomebrewを使用

- Apple Silicon向けに最適化

Linuxパフォーマンス:

- NUMA設定を構成

- 適切なCPU機能を有効化

- 依存関係にはパッケージマネージャーを使用

- スワップとメモリを設定

GGUFモデルにおけるApatero.comの利点

GGUFはローカルAIをアクセス可能にしますが、プロフェッショナルが一貫した高品質の結果を必要とする場合、複数のモデルと設定を管理することは複雑になる可能性があります。Apatero.comは、GGUFの利点を活用しながら技術的な複雑さを排除するプロフェッショナルグレードのプラットフォームを提供することで、このギャップを埋めます。

プロフェッショナルがAI生成にApatero.comを選ぶ理由:

GGUF駆動のパフォーマンス:

- 内部で最適化されたGGUFモデルを利用

- 最良の結果のための自動量子化選択

- プロフェッショナルグレードのインフラストラクチャ

- 一貫性のある信頼できるパフォーマンス

技術的オーバーヘッドなし:

- モデル管理不要

- 自動更新と最適化

- プロフェッショナルなサポートと信頼性

- エンタープライズグレードのセキュリティ

ローカルAIを使用するチームに最適:

- 複雑さなしにGGUFの利点を求める企業

- 一貫したAI出力を必要とするチーム

- プロフェッショナルなサポートを必要とする組織

- AI運用をスケーリングする企業

シームレスな統合:

- GGUF駆動モデルへのAPIアクセス

- カスタムモデル展開オプション

- チームコラボレーション機能

- プロフェッショナルなワークフローツール

Apatero.comでエンタープライズの信頼性を備えたGGUFモデルのパワーを体験してください。技術的なオーバーヘッドなしに、ローカルAIのすべての利点を享受できます。

GGUFがすべてを変えた

GGUF革命は、単なるファイルフォーマットの改善以上のものを表しています。それは、AIのアクセシビリティと展開についての考え方における根本的なシフトです。強力な言語モデルをコンシューマーハードウェアで利用可能にすることで、GGUFは、わずか2年前には不可能に思えた方法でAIを民主化しました。

その影響は否定できません:

- 何百万ものユーザーが現在、AIモデルをローカルで実行しています

- プライバシーとセキュリティがAIアプリケーションに復活しました

- 発展途上国が最先端のAIにアクセスできるようになりました

- 中小企業がテクノロジー大手と競争できるようになりました

- エッジでのイノベーションが解放されました

革命は続いています: GGUFが進化し、新しい最適化が登場するにつれて、クラウドとローカルAIのパフォーマンスの間のギャップは縮小し続けています。未来はローカルAIに属しており、GGUFがその先頭に立っています。

あなたがアプリケーションにAIを統合しようとしている開発者であれ、プライベートなAIソリューションを求めているビジネスであれ、最新のモデルを探求したい愛好家であれ、GGUFはすべてを可能にしました。革命はここにあり、アクセス可能であり、あなたの目の前のデバイスで動作しています。

GGUF革命に参加する準備はできましたか? Ollamaをダウンロードし、最初のGGUFモデルをインストールして、今日からローカルAIの未来を体験してください。パワーは文字通りあなたの手の中にあります。

AIインフルエンサーを作成する準備はできましたか?

115人の学生とともに、51レッスンの完全なコースでComfyUIとAIインフルエンサーマーケティングをマスター。