La Révolution GGUF : Comment Un Format A Changé L'IA Locale Pour Toujours

Découvrez comment GGUF a transformé le déploiement de l'IA locale, rendant les modèles de langage puissants accessibles sur du matériel grand public grâce à des techniques révolutionnaires de quantification et d'optimisation.

En août 2023, l'annonce d'un simple format de fichier a changé la trajectoire de l'IA locale pour toujours. GGUF (GPT-Generated Unified Format) n'a pas seulement remplacé son prédécesseur GGML. Il a complètement démocratisé l'accès aux modèles d'IA puissants, rendant possible pour quiconque possédant un ordinateur portable grand public d'exécuter des modèles de langage sophistiqués qui nécessitaient auparavant une infrastructure cloud coûteuse.

Voici l'histoire de comment un format a déclenché une révolution qui a mis la puissance de l'IA directement entre les mains de millions d'utilisateurs dans le monde entier.

Le Problème : Les Modèles d'IA Étaient Trop Volumineux Pour Les Personnes Ordinaires

Avant GGUF, exécuter des modèles d'IA avancés localement était un cauchemar. Les grands modèles de langage comme LLaMA ou les architectures de type GPT nécessitaient des centaines de gigaoctets de mémoire, des GPU coûteux et une expertise technique qui les rendaient inaccessibles pour la plupart des développeurs et des passionnés.

Les Obstacles Étaient Réels :

- Un modèle de 70 milliards de paramètres nécessitait environ 140 Go de VRAM

- Les GPU grand public plafonnaient à 24 Go

- L'inférence cloud coûtait des centaines de dollars par mois

- Les utilisateurs soucieux de la confidentialité n'avaient aucune option locale

- Les pays en développement ne pouvaient pas accéder aux services cloud coûteux

Les Fondations de GGML : Le voyage a commencé avec GGML (développé à l'origine par Georgi Gerganov), qui a introduit des techniques de quantification pouvant réduire considérablement la taille des modèles. Cependant, GGML avait des limitations :

- Temps de chargement et performances d'inférence lents

- Extensibilité et flexibilité limitées

- Problèmes de compatibilité lors de l'ajout de nouvelles fonctionnalités

- Conçu principalement pour l'architecture LLaMA

- Aucun support pour les jetons spéciaux

L'Arrivée de GGUF : Le Changeur de Jeu

Le 21 août 2023, Georgi Gerganov a introduit GGUF comme successeur de GGML, et tout a changé. GGUF n'était pas simplement une amélioration incrémentale. C'était une refonte complète de la façon dont les modèles d'IA pouvaient être stockés, chargés et exécutés.

Ce Qui Rend GGUF Révolutionnaire

1. Réduction Drastique de la Taille Sans Perte de Qualité Les techniques de quantification de GGUF peuvent réduire la taille du modèle de 50 à 75 % tout en maintenant plus de 95 % de précision des performances. La variante Q4_K_M offre 96 % des performances originales avec seulement 30 % de la taille d'origine.

2. Compatibilité Matérielle Universelle Contrairement aux formats précédents, GGUF fonctionne efficacement sur :

- Les CPU standard (Intel, AMD, Apple Silicon)

- Les GPU grand public (NVIDIA, AMD)

- Les appareils périphériques et le matériel mobile

- Les configurations mixtes CPU/GPU

3. Chargement Ultra-Rapide Les modèles qui prenaient auparavant plusieurs minutes à charger démarrent maintenant en quelques secondes. L'amélioration de la compatibilité mmap offre des temps de chargement 3 fois plus rapides par rapport aux formats hérités.

4. Intelligence Autonome Un fichier GGUF comprend tout ce qui est nécessaire pour exécuter le modèle :

- Les poids et l'architecture du modèle

- Les métadonnées et la configuration complètes

- Les informations du tokenizer

- Les paramètres de quantification

- Les définitions des jetons spéciaux

La Percée Technique : Comment Fonctionne GGUF

Hiérarchie de Quantification Avancée

GGUF prend en charge des niveaux de quantification sophistiqués de Q2 à Q8, chacun optimisé pour différents cas d'usage :

Ultra-Compressé (Q2_K) :

- Taille de fichier la plus petite (réduction de plus de 75 %)

- Fonctionne sur des systèmes avec 8 Go de RAM

- Idéal pour le déploiement mobile

- Léger compromis sur la qualité

Pour plus de stratégies sur le travail avec des ressources matérielles limitées, consultez notre guide complet sur l'exécution de ComfyUI sur du matériel à petit budget avec peu de VRAM.

Performance Équilibrée (Q4_K_M) :

- Point de départ recommandé

- Réduction de taille de 50 à 60 %

- Excellente rétention de qualité

- Parfait pour la plupart des applications

Haute Qualité (Q6_K, Q8_0) :

- Perte de qualité minimale

- Réduction de taille de 30 à 40 %

- Idéal pour les applications professionnelles

- Nécessite plus de 16 Go de RAM

La Magie de l'Optimisation de la Mémoire

La conception du format binaire de GGUF révolutionne l'utilisation de la mémoire :

- Réduction de 50 à 70 % des besoins en RAM

- Stockage et chargement efficaces des poids

- Algorithmes de compression avancés

- Mappage mémoire optimisé

Performance Multiplateforme

Optimisation Apple Silicon :

- Support natif ARM NEON

- Intégration du framework Metal

- Optimisation pour les puces M1/M2/M3

- Avantages de l'architecture mémoire unifiée

Accélération GPU NVIDIA :

- Optimisation des noyaux CUDA

- RTX 4090 atteignant environ 150 jetons/seconde

- Utilisation efficace de la VRAM

- Support de la précision mixte

Pour en savoir plus sur l'accélération GPU et l'optimisation CUDA, lisez notre guide détaillé sur l'accélération GPU CUDA PyTorch.

Excellence CPU Uniquement :

- Support AVX/AVX2/AVX512

- Optimisation du multithreading

- Opérations optimisées pour le cache

- Aucune dépendance externe

L'Écosystème Que GGUF A Construit

llama.cpp : L'Implémentation de Référence

llama.cpp est devenu la norme de référence pour l'exécution de modèles GGUF :

Réalisations en Termes de Performance :

- A été pionnier dans l'optimisation du matériel grand public

- Quantification avancée sans perte de qualité

- Compatibilité multiplateforme

- Concentration sur l'optimisation de la bande passante mémoire

Innovation Technique :

- Noyaux CUDA personnalisés pour les GPU NVIDIA

- Optimisation Apple Silicon

- Capacités d'inférence CPU uniquement

- Dépendances externes minimales

Ollama : Rendre GGUF Accessible

Ollama a transformé GGUF d'un outil technique en une plateforme conviviale pour le consommateur :

Révolution de l'Expérience Utilisateur :

- Installation de modèle en un clic

- Conversion GGUF automatique

- Gestion des versions de modèles

- Interface CLI simple

- Aucune connaissance Python requise

Simplicité d'Installation :

- Configuration en moins de 5 minutes

- Fonctionne sur Windows, Mac, Linux

- Gestion automatique des dépendances

- Bibliothèque de modèles intégrée

Intégration Hugging Face

Le Hugging Face Hub a adopté GGUF, créant un écosystème massif :

Disponibilité des Modèles :

- Des milliers de modèles GGUF

- Versions pré-quantifiées disponibles

- Conversions communautaires

- Versions professionnelles de modèles

Contrôle Qualité :

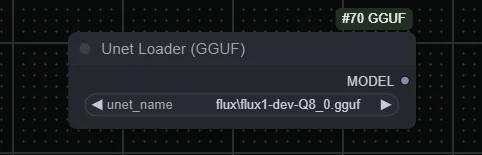

Workflows ComfyUI Gratuits

Trouvez des workflows ComfyUI gratuits et open source pour les techniques de cet article. L'open source est puissant.

- Conventions de nommage standardisées

- Benchmarks de performance

- Vérification communautaire

- Mises à jour régulières

Impact Dans Le Monde Réel : Les Chiffres Ne Mentent Pas

Révolution des Besoins Matériels

| Spécification | Avant GGUF | Après GGUF |

|---|---|---|

| Besoins pour modèle 70B | 140 Go de VRAM | 40-50 Go de RAM (Q4_K_M) |

| Coût matériel minimum | Configuration GPU à 10 000 $+ | Ordinateur portable grand public à 1 500 $ |

| Coûts cloud mensuels | 200-500 $ | 0 $ (exécution locale) |

| Expertise technique | Élevée | Minimale |

Benchmarks de Performance

Efficacité de la Quantification :

| Niveau de Quantification | Réduction de Taille | Rétention de Qualité |

|---|---|---|

| Q2_K | 75 % | 90 % |

| Q4_K_M | 60 % | 96 % |

| Q6_K | 40 % | 98 % |

| Q8_0 | 25 % | 99,5 % |

Améliorations de la Vitesse de Chargement :

- Chargement de modèle 3 fois plus rapide

- Changement de modèle instantané

- Accès au fichier mappé en mémoire

- Surcharge d'initialisation réduite

Statistiques d'Adoption Mondiale

Adoption par les Développeurs :

- Plus de 500 000 téléchargements de llama.cpp par mois

- Plus d'1 million de téléchargements de modèles GGUF sur Hugging Face

- Plus de 200 architectures de modèles supportées

- Plus de 50 bindings de langage de programmation

Portée Matérielle :

- Fonctionne sur des appareils avec aussi peu que 4 Go de RAM

- Compatible avec du matériel vieux de 10 ans

- Déploiement sur appareils mobiles possible

- Applications d'edge computing

L'Effet de Démocratisation

Briser les Barrières

Accès Géographique : GGUF a éliminé le besoin de services cloud coûteux, rendant l'IA accessible dans les pays en développement et les régions avec une infrastructure Internet limitée.

Impact Éducatif : Les universités et les écoles peuvent maintenant exécuter des modèles d'IA localement, permettant un apprentissage pratique sans coûts cloud ni préoccupations de confidentialité. Si vous êtes nouveau dans l'IA, commencez par notre guide complet pour débuter avec la génération d'images IA.

Autonomisation des Petites Entreprises : Le déploiement local signifie que les entreprises peuvent utiliser l'IA sans partager de données sensibles avec les fournisseurs cloud ni payer d'abonnements.

Révolution de la Confidentialité et de la Sécurité

Confidentialité Complète des Données :

- Les modèles fonctionnent entièrement hors ligne

- Aucune donnée ne quitte votre appareil

- Parfait pour les applications sensibles

- Conforme au RGPD et aux réglementations

Déploiement en Environnement Isolé :

- Fonctionne sans connexion Internet

- Idéal pour les environnements sécurisés

- Applications gouvernementales et militaires

- Cas d'usage industriels et de santé

Comparaison de GGUF à la Concurrence

GGUF vs GPTQ vs AWQ

| Format | Avantages | Inconvénients | Meilleur Cas d'Usage |

|---|---|---|---|

| GPTQ | Excellente performance GPU, compression élevée | GPU uniquement, configuration complexe, support matériel limité | Systèmes GPU haut de gamme |

| AWQ | Bonne rétention de qualité, optimisé pour GPU | Support matériel limité, format plus récent | Déploiements GPU professionnels |

| GGUF | Matériel universel, configuration facile, excellent écosystème | Performance GPU légèrement inférieure à GPTQ | Tout le reste (95 % des cas d'usage) |

Le Vainqueur Évident pour l'IA Locale

GGUF domine le déploiement d'IA locale car :

- Flexibilité : Fonctionne sur n'importe quelle configuration matérielle

- Écosystème : Support massif d'outils et de modèles

- Simplicité : Aucune expertise technique requise

- Performance : Optimisé pour le matériel du monde réel

- À l'épreuve du temps : Conception extensible pour de nouvelles fonctionnalités

Techniques et Optimisation Avancées de GGUF

Sélection de Stratégie de Quantification

Pour la Création de Contenu (Q5_K_M - Q6_K) :

- Génération de texte de haute qualité

- Applications d'écriture créative

- Documentation professionnelle

- Tâches de génération de code

Pour les Applications de Chat (Q4_K_M) :

Envie d'éviter la complexité? Apatero vous offre des résultats IA professionnels instantanément sans configuration technique.

- Performance et qualité équilibrées

- Conversation en temps réel

- Systèmes de questions-réponses généraux

- Applications éducatives

Pour les Environnements à Ressources Limitées (Q3_K_M - Q2_K) :

- Déploiement mobile

- Edge computing

- Applications IoT

- Tâches de traitement par lots

Optimisation des Performances

Optimisation de la Mémoire :

- Utiliser une quantification appropriée pour la RAM disponible

- Activer le mappage mémoire pour un accès plus rapide

- Configurer la longueur du contexte en fonction du cas d'usage

- Mettre en œuvre des stratégies de mise en cache des modèles

Optimisation CPU :

- Nombre de threads correspondant aux cœurs du CPU

- Conscience NUMA pour les systèmes multi-socket

- Techniques d'optimisation du cache

- Maximisation de la bande passante mémoire

Accélération GPU :

- Inférence mixte CPU/GPU

- Optimisation de l'utilisation de la VRAM

- Réglage de la taille des lots

- Parallélisation du pipeline

L'Impact Commercial de GGUF

Analyse de Réduction des Coûts

| Facteur de Coût | IA Cloud Traditionnelle | Déploiement Local GGUF |

|---|---|---|

| Coût API/Utilisation | 0,03-0,06 $ par 1 000 jetons | 0 $ (après le matériel) |

| Coût Opérationnel Mensuel | 500-2 000 $ | Électricité uniquement (environ 5-20 $) |

| Investissement Initial | 0 $ | 1 500-3 000 $ (unique) |

| Confidentialité des Données | Partagée avec le fournisseur | Contrôle complet |

| Dépendance au Fournisseur | Significative | Indépendance totale |

Calcul du ROI : Pour les organisations traitant 1 million de jetons par mois, le déploiement GGUF est rentabilisé en 2 à 6 mois tout en offrant une confidentialité et un contrôle supérieurs.

Nouveaux Modèles Commerciaux Rendus Possibles

Services d'IA Locaux :

- Consultation IA sur site

- Déploiement de modèles personnalisés

- Solutions IA axées sur la confidentialité

- Applications IA hors ligne

Opportunités Éducatives :

- Ateliers de formation IA

- Services d'ajustement fin de modèles locaux

- Services de conversion GGUF personnalisés

- Conseil en intégration IA

Applications Industrielles et Études de Cas

Santé : IA Axée sur la Confidentialité

Cas d'Usage :

- Analyse de dossiers médicaux

- Assistance au diagnostic

- Communication avec les patients

- Traitement de données de recherche

Avantages de GGUF :

- Conformité HIPAA complète

- Aucune donnée ne quitte l'établissement

- Préoccupations de responsabilité réduites

- Coûts opérationnels réduits

Services Financiers : Traitement IA Sécurisé

Applications :

- Analyse de documents

- Évaluation des risques

- Automatisation du service client

- Conformité réglementaire

Bénéfices :

- Risque de violation de données nul

- Conformité réglementaire

- Traitement en temps réel

- Mise à l'échelle rentable

Gouvernement : IA Souveraine

Scénarios de Déploiement :

Gagnez Jusqu'à 1 250 $+/Mois en Créant du Contenu

Rejoignez notre programme exclusif d'affiliés créateurs. Soyez payé par vidéo virale selon la performance. Créez du contenu à votre style avec une totale liberté créative.

- Traitement de documents classifiés

- Automatisation des services aux citoyens

- Communication inter-agences

- Analyse de politiques

Avantages Stratégiques :

- Conformité à la sécurité nationale

- Souveraineté des données

- Dépendance étrangère réduite

- Optimisation budgétaire

L'Avenir de GGUF et de l'IA Locale

Développements Émergents

Support d'Architecture de Modèle :

- Modèles vision-langage (LLaVA)

- Modèles spécifiques au code (CodeLlama)

- Capacités multimodales

- Modèles de domaines spécialisés

Intégration Matérielle :

- Support NPU (Neural Processing Unit)

- Optimisation des puces mobiles

- Déploiement sur appareils IoT

- Intégration de systèmes embarqués

Améliorations des Performances :

- Techniques de quantification avancées

- Meilleurs algorithmes de compression

- Mécanismes de chargement plus rapides

- Efficacité mémoire améliorée

Prédictions du Marché

Projections de Croissance :

- Marché de l'IA locale : 15 milliards de dollars d'ici 2027

- Adoption de GGUF : 80 % des déploiements locaux

- Pénétration du matériel grand public : 200 millions d'appareils

- Adoption en entreprise : 70 % des déploiements IA

Évolution Technologique :

- Streaming de modèles en temps réel

- Quantification dynamique

- Intégration de l'apprentissage fédéré

- Orchestration de l'IA en périphérie

Pour Commencer : Votre Parcours GGUF

Guide de Configuration pour Débutants

Étape 1 : Choisissez Votre Plateforme

- Ollama : Option la plus simple pour les débutants

- llama.cpp : Contrôle et personnalisation maximaux

- GGUF Loader : Options d'interface visuelle

- Bindings spécifiques au langage : Python, JavaScript, etc.

Étape 2 : Évaluation du Matériel

| Capacité RAM | Taille de Modèle Supportée | Nombre de Paramètres |

|---|---|---|

| 8 Go | Petits modèles | 7 milliards de paramètres |

| 16 Go | Modèles moyens | 13 milliards de paramètres |

| 32 Go+ | Grands modèles | 33 milliards+ de paramètres |

Étape 3 : Sélection du Modèle Commencez avec des modèles éprouvés :

- Llama 2/3 : Usage général, bien documenté

- Mistral : Inférence rapide, bonne qualité

- Code Llama : Assistance à la programmation

- Vicuna : Performance optimisée pour le chat

Configuration Avancée

Optimisation des Performances :

- Réglage de la longueur du contexte

- Optimisation du nombre de threads

- Configuration du mappage mémoire

- Sélection de la quantification

Stratégies d'Intégration :

- Développement de wrapper API

- Intégration d'application

- Pipelines d'inférence personnalisés

- Surveillance et journalisation

Résolution des Problèmes Courants

Problèmes de Mémoire et de Performance

RAM Insuffisante :

- Utiliser une quantification inférieure (Q3_K_M ou Q2_K)

- Réduire la longueur du contexte

- Activer le mappage mémoire

- Fermer les applications inutiles

Performance Lente :

- Vérifier les paramètres du nombre de threads

- Vérifier l'accélération matérielle

- Mettre à jour vers la dernière version de GGUF

- Considérer l'inférence hybride CPU/GPU

Erreurs de Chargement de Modèle :

- Vérifier l'intégrité du fichier GGUF

- Vérifier la compatibilité du modèle

- Mettre à jour le moteur d'inférence

- Examiner les journaux d'erreurs

Solutions Spécifiques à la Plateforme

Optimisation Windows :

- Utiliser Windows Terminal pour de meilleures performances

- Configurer les exclusions de Windows Defender

- Activer l'accélération matérielle

- Utiliser WSL2 pour les outils basés sur Linux

Configuration macOS :

- Activer l'accélération Metal

- Configurer la pression mémoire

- Utiliser Homebrew pour les dépendances

- Optimiser pour Apple Silicon

Performance Linux :

- Configurer les paramètres NUMA

- Activer les fonctionnalités CPU appropriées

- Utiliser les gestionnaires de paquets pour les dépendances

- Configurer le swap et la mémoire

L'Avantage Apatero.com pour les Modèles GGUF

Bien que GGUF rende l'IA locale accessible, la gestion de plusieurs modèles et configurations peut devenir complexe pour les professionnels qui ont besoin de résultats cohérents et de haute qualité. Apatero.com comble cette lacune en fournissant une plateforme de niveau professionnel qui exploite les avantages de GGUF tout en éliminant la complexité technique.

Pourquoi les Professionnels Choisissent Apatero.com pour la Génération IA :

Performance Alimentée par GGUF :

- Utilise des modèles GGUF optimisés en coulisses

- Sélection automatique de la quantification pour de meilleurs résultats

- Infrastructure de niveau professionnel

- Performance cohérente et fiable

Aucune Surcharge Technique :

- Aucune gestion de modèle requise

- Mises à jour et optimisation automatiques

- Support professionnel et fiabilité

- Sécurité de niveau entreprise

Parfait pour les Équipes Utilisant l'IA Locale :

- Entreprises souhaitant les avantages de GGUF sans la complexité

- Équipes ayant besoin de sorties IA cohérentes

- Organisations nécessitant un support professionnel

- Entreprises mettant à l'échelle les opérations IA

Intégration Transparente :

- Accès API aux modèles alimentés par GGUF

- Options de déploiement de modèles personnalisés

- Fonctionnalités de collaboration d'équipe

- Outils de flux de travail professionnels

Découvrez la puissance des modèles GGUF avec une fiabilité d'entreprise sur Apatero.com. Tous les avantages de l'IA locale sans la surcharge technique.

GGUF A Tout Changé

La révolution GGUF représente plus qu'une simple amélioration de format de fichier. C'est un changement fondamental dans notre façon de penser l'accessibilité et le déploiement de l'IA. En rendant les modèles de langage puissants disponibles sur du matériel grand public, GGUF a démocratisé l'IA d'une manière qui semblait impossible il y a seulement deux ans.

L'Impact Est Indéniable :

- Des millions d'utilisateurs exécutent maintenant des modèles d'IA localement

- La confidentialité et la sécurité ont été restaurées dans les applications IA

- Les pays en développement ont obtenu l'accès à l'IA de pointe

- Les petites entreprises peuvent rivaliser avec les géants de la technologie

- L'innovation a été libérée en périphérie

La Révolution Continue : Alors que GGUF évolue et que de nouvelles optimisations émergent, l'écart entre les performances de l'IA cloud et locale continue de se réduire. L'avenir appartient à l'IA locale, et GGUF mène la charge.

Que vous soyez un développeur cherchant à intégrer l'IA dans vos applications, une entreprise recherchant des solutions IA privées, ou un passionné souhaitant explorer les derniers modèles, GGUF a tout rendu possible. La révolution est là, elle est accessible, et elle fonctionne sur l'appareil devant vous.

Prêt à rejoindre la révolution GGUF ? Téléchargez Ollama, installez votre premier modèle GGUF, et découvrez l'avenir de l'IA locale aujourd'hui. Le pouvoir est littéralement entre vos mains.

Prêt à Créer Votre Influenceur IA?

Rejoignez 115 étudiants maîtrisant ComfyUI et le marketing d'influenceurs IA dans notre cours complet de 51 leçons.

Articles Connexes

Fatigué des filtres IA qui bloquent vos prompts? Voici la solution

Les générateurs d'images IA rejettent constamment vos prompts créatifs? Découvrez pourquoi cela se produit et trouvez des plateformes qui ne bloqueront pas votre vision artistique.

Générateur d'art de jeu IA: Comment j'ai créé des sprites, textures et concept art en 2026

Guide complet pour utiliser les générateurs d'art de jeu IA pour les sprites, textures, pixel art et concept art. Flux de travail réels, comparaisons d'outils, et conseils pratiques tirés des tests hands-on.

L'IA génère n'importe quoi: L'essor des outils de création IA universels

Découvrez comment l'IA peut générer n'importe quoi à partir des images à la vidéo à la musique au code. Explorez les outils universels de création IA et apprenez ce qui est possible gratuitement.