GGUF 혁명: 하나의 포맷이 로컬 AI를 영원히 바꾼 방법

GGUF가 혁신적인 양자화와 최적화 기술을 통해 소비자 하드웨어에서 강력한 언어 모델을 접근 가능하게 만들어 로컬 AI 배포를 어떻게 변화시켰는지 알아보세요.

2023년 8월, 단 하나의 파일 포맷 발표가 로컬 AI의 궤적을 영원히 바꾸었습니다. GGUF(GPT-Generated Unified Format)는 단순히 전임자인 GGML을 대체한 것이 아니었습니다. 이전에는 고가의 클라우드 인프라가 필요했던 정교한 언어 모델(Language Model)을 일반 노트북으로도 실행할 수 있게 만들어 강력한 AI 모델에 대한 접근을 완전히 민주화했습니다.

이것은 하나의 포맷이 전 세계 수백만 사용자의 손에 AI 파워를 직접 넣어준 혁명을 촉발시킨 이야기입니다.

문제: AI 모델은 일반인에게 너무 컸습니다

GGUF 이전에는 고급 AI 모델(Model)을 로컬에서 실행하는 것이 악몽과 같았습니다. LLaMA나 GPT 스타일 아키텍처와 같은 대규모 언어 모델은 수백 기가바이트의 메모리, 고가의 GPU가 필요했으며, 대부분의 개발자와 애호가들이 접근할 수 없는 기술적 전문성을 요구했습니다.

장벽은 현실이었습니다:

- 70B 파라미터 모델은 약 140GB의 VRAM이 필요했습니다

- 소비자용 GPU는 최대 24GB였습니다

- 클라우드 추론 비용은 월 수백 달러였습니다

- 프라이버시를 중시하는 사용자는 로컬 옵션이 없었습니다

- 개발도상국은 고가의 클라우드 서비스에 접근할 수 없었습니다

GGML 기반: 이 여정은 GGML(Georgi Gerganov가 원래 개발)로 시작되었으며, 모델 크기를 크게 줄일 수 있는 양자화(Quantization) 기술을 도입했습니다. 그러나 GGML에는 한계가 있었습니다:

- 느린 로딩 시간과 추론 성능

- 제한된 확장성과 유연성

- 새로운 기능을 추가할 때 호환성 문제

- 주로 LLaMA 아키텍처를 위해 설계됨

- 특수 토큰(Token) 지원 없음

GGUF 등장: 게임 체인저

2023년 8월 21일, Georgi Gerganov는 GGML의 후속작으로 GGUF를 소개했고, 모든 것이 바뀌었습니다. GGUF는 단순한 점진적 개선이 아니었습니다. AI 모델이 저장되고, 로드되고, 실행되는 방식에 대한 완전한 재구상이었습니다.

GGUF를 혁명적으로 만드는 것

1. 품질 손실 없는 극적인 크기 감소 GGUF의 양자화 기술은 95% 이상의 성능 정확도를 유지하면서 모델 크기를 50-75% 줄일 수 있습니다. Q4_K_M 변형은 원래 크기의 30%에서 원래 성능의 96%를 제공합니다.

2. 범용 하드웨어 호환성 이전 포맷과 달리 GGUF는 다음에서 효율적으로 실행됩니다:

- 표준 CPU(Intel, AMD, Apple Silicon)

- 소비자용 GPU(NVIDIA, AMD)

- 엣지 디바이스 및 모바일 하드웨어

- 혼합 CPU/GPU 구성

3. 초고속 로딩 이전에 로드하는 데 몇 분이 걸렸던 모델이 이제 몇 초 만에 시작됩니다. mmap 호환성 향상은 레거시 포맷에 비해 3배 빠른 로딩 시간을 제공합니다.

4. 자체 포함 인텔리전스 GGUF 파일에는 모델을 실행하는 데 필요한 모든 것이 포함되어 있습니다:

- 모델 가중치 및 아키텍처

- 완전한 메타데이터 및 구성

- 토크나이저 정보

- 양자화 파라미터

- 특수 토큰 정의

기술적 돌파구: GGUF의 작동 방식

고급 양자화 계층 구조

GGUF는 Q2에서 Q8까지 정교한 양자화 수준을 지원하며, 각각 다른 사용 사례에 최적화되어 있습니다:

초압축(Q2_K):

- 가장 작은 파일 크기(75% 이상 감소)

- 8GB RAM 시스템에서 실행

- 모바일 배포에 이상적

- 약간의 품질 절충

제한된 하드웨어 리소스로 작업하는 더 많은 전략을 보려면 예산 하드웨어에서 낮은 VRAM으로 ComfyUI 실행하기에 대한 포괄적인 가이드를 확인하세요.

균형 성능(Q4_K_M):

- 권장 시작점

- 50-60% 크기 감소

- 우수한 품질 유지

- 대부분의 애플리케이션에 완벽함

고품질(Q6_K, Q8_0):

- 최소한의 품질 손실

- 30-40% 크기 감소

- 전문 애플리케이션에 이상적

- 16GB 이상의 RAM 필요

메모리 최적화 마법

GGUF의 바이너리 포맷 설계는 메모리 사용을 혁신합니다:

- RAM 요구 사항 50-70% 감소

- 효율적인 가중치 저장 및 로딩

- 고급 압축 알고리즘

- 최적화된 메모리 매핑

크로스 플랫폼 성능

Apple Silicon 최적화:

- 네이티브 ARM NEON 지원

- Metal 프레임워크 통합

- M1/M2/M3 칩 최적화

- 통합 메모리 아키텍처 이점

NVIDIA GPU 가속:

- CUDA 커널 최적화

- RTX 4090은 초당 약 150개 토큰 달성

- 효율적인 VRAM 활용

- 혼합 정밀도 지원

GPU 가속 및 CUDA 최적화에 대해 자세히 알아보려면 PyTorch CUDA GPU 가속 가이드를 읽어보세요.

CPU 전용 우수성:

- AVX/AVX2/AVX512 지원

- 멀티스레딩 최적화

- 캐시 친화적 작업

- 외부 종속성 없음

GGUF가 구축한 생태계

llama.cpp: 참조 구현

llama.cpp는 GGUF 모델 실행의 표준이 되었습니다:

성능 성과:

- 소비자 하드웨어 최적화 선구자

- 품질 손실 없는 고급 양자화

- 크로스 플랫폼 호환성

- 메모리 대역폭 최적화 초점

기술 혁신:

- NVIDIA GPU용 사용자 정의 CUDA 커널

- Apple Silicon 최적화

- CPU 전용 추론 기능

- 최소한의 외부 종속성

Ollama: GGUF를 접근 가능하게 만들기

Ollama는 GGUF를 기술 도구에서 소비자 친화적 플랫폼으로 변환했습니다:

사용자 경험 혁명:

- 원클릭 모델 설치

- 자동 GGUF 변환

- 모델 버전 관리

- 간단한 CLI 인터페이스

- Python 지식 불필요

설치 단순성:

- 5분 미만 설정

- Windows, Mac, Linux에서 작동

- 자동 종속성 관리

- 통합 모델 라이브러리

Hugging Face 통합

Hugging Face Hub은 GGUF를 수용하여 대규모 생태계를 만들었습니다:

모델 가용성:

- 수천 개의 GGUF 모델

- 사전 양자화 버전 사용 가능

- 커뮤니티 주도 변환

- 전문 모델 릴리스

품질 관리:

무료 ComfyUI 워크플로우

이 글의 기술에 대한 무료 오픈소스 ComfyUI 워크플로우를 찾아보세요. 오픈소스는 강력합니다.

- 표준화된 명명 규칙

- 성능 벤치마크

- 커뮤니티 검증

- 정기 업데이트

실제 영향: 숫자는 거짓말을 하지 않습니다

하드웨어 요구사항 혁명

| 사양 | GGUF 이전 | GGUF 이후 |

|---|---|---|

| 70B 모델 요구사항 | 140GB VRAM | 40-50GB RAM (Q4_K_M) |

| 최소 하드웨어 비용 | $10,000+ GPU 설정 | $1,500 소비자 노트북 |

| 월 클라우드 비용 | $200-500 | $0 (로컬에서 실행) |

| 기술적 전문성 | 높음 | 최소 |

성능 벤치마크

양자화 효율성:

| 양자화 수준 | 크기 감소 | 품질 유지 |

|---|---|---|

| Q2_K | 75% | 90% |

| Q4_K_M | 60% | 96% |

| Q6_K | 40% | 98% |

| Q8_0 | 25% | 99.5% |

로딩 속도 개선:

- 3배 빠른 모델 로딩

- 즉시 모델 전환

- 메모리 매핑된 파일 액세스

- 초기화 오버헤드 감소

글로벌 채택 통계

개발자 채택:

- 월 50만 이상의 llama.cpp 다운로드

- Hugging Face에서 100만 이상의 GGUF 모델 다운로드

- 200개 이상의 지원되는 모델 아키텍처

- 50개 이상의 프로그래밍 언어 바인딩

하드웨어 도달 범위:

- 4GB RAM만으로도 실행 가능

- 10년 된 하드웨어와 호환

- 모바일 디바이스 배포 가능

- 엣지 컴퓨팅 애플리케이션

민주화 효과

장벽 허물기

지리적 접근성: GGUF는 고가의 클라우드 서비스 필요성을 제거하여 개발도상국 및 인터넷 인프라가 제한된 지역에서 AI를 접근 가능하게 만들었습니다.

교육적 영향: 대학과 학교는 이제 클라우드 비용이나 프라이버시 우려 없이 실습 학습을 가능하게 하는 AI 모델을 로컬에서 실행할 수 있습니다. AI를 처음 접하신다면 2025년 AI 이미지 생성 시작하기 완벽 가이드로 시작하세요.

중소기업 역량 강화: 로컬 배포는 기업이 민감한 데이터를 클라우드 제공업체와 공유하거나 구독료를 지불하지 않고 AI를 사용할 수 있음을 의미합니다.

프라이버시 및 보안 혁명

완전한 데이터 프라이버시:

- 모델이 완전히 오프라인으로 실행됩니다

- 데이터가 장치를 떠나지 않습니다

- 민감한 애플리케이션에 완벽합니다

- GDPR 및 규정 준수 친화적

에어갭 배포:

- 인터넷 연결 없이 작동합니다

- 보안 환경에 이상적입니다

- 정부 및 군사 애플리케이션

- 산업 및 의료 사용 사례

GGUF와 경쟁 포맷 비교

GGUF vs GPTQ vs AWQ

| 포맷 | 장점 | 단점 | 최적 사용 사례 |

|---|---|---|---|

| GPTQ | 우수한 GPU 성능, 높은 압축 | GPU 전용, 복잡한 설정, 제한된 하드웨어 지원 | 고급 GPU 시스템 |

| AWQ | 좋은 품질 유지, GPU 최적화 | 제한된 하드웨어 지원, 새로운 포맷 | 전문 GPU 배포 |

| GGUF | 범용 하드웨어, 쉬운 설정, 우수한 생태계 | GPTQ보다 GPU 전용 성능이 약간 낮음 | 그 외 모든 것(95%의 사용 사례) |

로컬 AI의 명백한 승자

GGUF가 로컬 AI 배포를 지배하는 이유:

- 유연성: 모든 하드웨어 구성에서 실행됩니다

- 생태계: 대규모 도구 및 모델 지원

- 단순성: 기술적 전문성 불필요

- 성능: 실제 하드웨어에 최적화됨

- 미래 지향적: 새로운 기능을 위한 확장 가능한 설계

고급 GGUF 기술 및 최적화

양자화 전략 선택

콘텐츠 제작용(Q5_K_M - Q6_K):

- 고품질 텍스트 생성(Generation)

- 창작 작문 애플리케이션

- 전문 문서 작성

- 코드 생성 작업

채팅 애플리케이션용(Q4_K_M):

복잡함을 건너뛰고 싶으신가요? Apatero 는 기술적 설정 없이 즉시 전문 AI 결과를 제공합니다.

- 균형 잡힌 성능과 품질

- 실시간 대화

- 일반 Q&A 시스템

- 교육 애플리케이션

리소스 제약 환경용(Q3_K_M - Q2_K):

- 모바일 배포

- 엣지 컴퓨팅

- IoT 애플리케이션

- 배치 처리 작업

성능 튜닝

메모리 최적화:

- 사용 가능한 RAM에 적합한 양자화 사용

- 더 빠른 액세스를 위해 메모리 매핑 활성화

- 사용 사례에 따라 컨텍스트 길이 구성

- 모델 캐싱 전략 구현

CPU 최적화:

- CPU 코어와 일치하는 스레드 수

- 다중 소켓 시스템을 위한 NUMA 인식

- 캐시 최적화 기술

- 메모리 대역폭 극대화

GPU 가속:

- 혼합 CPU/GPU 추론

- VRAM 사용 최적화

- 배치 크기 튜닝

- 파이프라인 병렬화

GGUF의 비즈니스 영향

비용 절감 분석

| 비용 요소 | 전통적 클라우드 AI | GGUF 로컬 배포 |

|---|---|---|

| API/사용 비용 | 1천 토큰당 $0.03-0.06 | $0 (하드웨어 이후) |

| 월 운영 비용 | $500-2000 | 전기료만 (약 $5-20) |

| 초기 투자 | $0 | $1500-3000 (일회성) |

| 데이터 프라이버시 | 제공업체와 공유 | 완전한 제어 |

| 벤더 종속 | 상당함 | 완전한 독립성 |

ROI 계산: 월 100만 토큰을 처리하는 조직의 경우, GGUF 배포는 우수한 프라이버시 및 제어를 제공하면서 2-6개월 내에 자체 비용을 회수합니다.

새로운 비즈니스 모델 활성화

로컬 AI 서비스:

- 온프레미스 AI 컨설팅

- 맞춤형 모델 배포

- 프라이버시 중심 AI 솔루션

- 오프라인 AI 애플리케이션

교육 기회:

- AI 교육 워크숍

- 로컬 모델 미세 조정 서비스

- 맞춤형 GGUF 변환 서비스

- AI 통합 컨설팅

산업 응용 프로그램 및 사례 연구

의료: 프라이버시 우선 AI

사용 사례:

- 의료 기록 분석

- 진단 지원

- 환자 의사소통

- 연구 데이터 처리

GGUF 장점:

- 완전한 HIPAA 규정 준수

- 데이터가 시설을 떠나지 않음

- 책임 우려 감소

- 낮은 운영 비용

금융 서비스: 보안 AI 처리

애플리케이션:

- 문서 분석

- 위험 평가

- 고객 서비스 자동화

- 규제 준수

이점:

- 데이터 유출 위험 제로

- 규제 준수

- 실시간 처리

- 비용 효율적 확장

정부: 주권 AI

배포 시나리오:

콘텐츠 제작으로 월 $1,250+ 벌기

독점 크리에이터 제휴 프로그램에 참여하세요. 바이럴 동영상 성과에 따라 수익을 받으세요. 완전한 창작 자유로 자신만의 스타일로 콘텐츠를 만드세요.

- 기밀 문서 처리

- 시민 서비스 자동화

- 기관 간 의사소통

- 정책 분석

전략적 이점:

- 국가 안보 준수

- 데이터 주권

- 해외 의존도 감소

- 예산 최적화

GGUF와 로컬 AI의 미래

새로운 발전

모델 아키텍처 지원:

- 비전-언어 모델(LLaVA)

- 코드 전용 모델(CodeLlama)

- 멀티모달 기능

- 전문 도메인 모델

하드웨어 통합:

- NPU(신경 처리 장치) 지원

- 모바일 칩 최적화

- IoT 디바이스 배포

- 임베디드 시스템 통합

성능 개선:

- 고급 양자화 기술

- 더 나은 압축 알고리즘

- 더 빠른 로딩 메커니즘

- 향상된 메모리 효율성

시장 예측

성장 전망:

- 로컬 AI 시장: 2027년까지 150억 달러

- GGUF 채택: 로컬 배포의 80%

- 소비자 하드웨어 보급: 2억 대 디바이스

- 기업 채택: AI 배포의 70%

기술 진화:

- 실시간 모델 스트리밍

- 동적 양자화

- 연합 학습 통합

- 엣지 AI 오케스트레이션

시작하기: GGUF 여정

초보자 설정 가이드

1단계: 플랫폼 선택

- Ollama: 초보자를 위한 가장 간단한 옵션

- llama.cpp: 최대 제어 및 사용자 정의

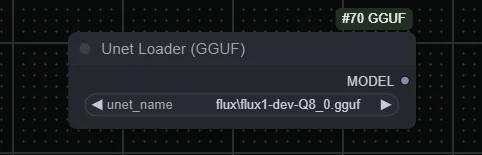

- GGUF Loader: 시각적 인터페이스 옵션

- 언어별 바인딩: Python, JavaScript 등

2단계: 하드웨어 평가

| RAM 용량 | 지원되는 모델 크기 | 파라미터 수 |

|---|---|---|

| 8GB | 소형 모델 | 7B 파라미터 |

| 16GB | 중형 모델 | 13B 파라미터 |

| 32GB+ | 대형 모델 | 33B+ 파라미터 |

3단계: 모델 선택 검증된 모델로 시작하세요:

- Llama 2/3: 범용, 잘 문서화됨

- Mistral: 빠른 추론, 좋은 품질

- Code Llama: 프로그래밍 지원

- Vicuna: 채팅 최적화 성능

고급 구성

성능 최적화:

- 컨텍스트 길이 튜닝

- 스레드 수 최적화

- 메모리 매핑 구성

- 양자화 선택

통합 전략:

- API 래퍼 개발

- 애플리케이션 통합

- 맞춤형 추론 파이프라인

- 모니터링 및 로깅

일반적인 문제 해결

메모리 및 성능 문제

불충분한 RAM:

- 더 낮은 양자화 사용(Q3_K_M 또는 Q2_K)

- 컨텍스트 길이 축소

- 메모리 매핑 활성화

- 불필요한 애플리케이션 종료

느린 성능:

- 스레드 수 설정 확인

- 하드웨어 가속 확인

- 최신 GGUF 버전으로 업데이트

- 하이브리드 CPU/GPU 추론 고려

모델 로딩 오류:

- GGUF 파일 무결성 확인

- 모델 호환성 확인

- 추론 엔진 업데이트

- 오류 로그 검토

플랫폼별 솔루션

Windows 최적화:

- 더 나은 성능을 위해 Windows 터미널 사용

- Windows Defender 제외 구성

- 하드웨어 가속 활성화

- Linux 기반 도구를 위해 WSL2 사용

macOS 구성:

- Metal 가속 활성화

- 메모리 압력 구성

- 종속성을 위해 Homebrew 사용

- Apple Silicon 최적화

Linux 성능:

- NUMA 설정 구성

- 적절한 CPU 기능 활성화

- 종속성을 위해 패키지 관리자 사용

- 스왑 및 메모리 구성

GGUF 모델을 위한 Apatero.com 이점

GGUF가 로컬 AI를 접근 가능하게 만들지만, 일관된 고품질 결과가 필요한 전문가에게는 여러 모델과 구성을 관리하는 것이 복잡해질 수 있습니다. Apatero.com은 기술적 복잡성을 제거하면서 GGUF의 이점을 활용하는 전문가급 플랫폼을 제공하여 이 격차를 해소합니다.

전문가가 AI 생성을 위해 Apatero.com을 선택하는 이유:

GGUF 기반 성능:

- 내부적으로 최적화된 GGUF 모델 활용

- 최상의 결과를 위한 자동 양자화 선택

- 전문가급 인프라

- 일관되고 신뢰할 수 있는 성능

기술적 오버헤드 없음:

- 모델 관리 불필요

- 자동 업데이트 및 최적화

- 전문적인 지원 및 신뢰성

- 엔터프라이즈급 보안

로컬 AI를 사용하는 팀에 완벽함:

- 복잡성 없이 GGUF 이점을 원하는 기업

- 일관된 AI 출력이 필요한 팀

- 전문 지원이 필요한 조직

- AI 운영을 확장하는 회사

원활한 통합:

- GGUF 기반 모델에 대한 API 액세스

- 맞춤형 모델 배포 옵션

- 팀 협업 기능

- 전문 워크플로우(Workflow) 도구

Apatero.com에서 엔터프라이즈 신뢰성과 함께 GGUF 모델의 힘을 경험하세요. 기술적 오버헤드 없이 로컬 AI의 모든 이점을 누리세요.

GGUF는 모든 것을 바꿨습니다

GGUF 혁명은 단순한 파일 포맷 개선 이상을 나타냅니다. 이것은 AI 접근성과 배포에 대해 생각하는 방식의 근본적인 변화입니다. 소비자 하드웨어에서 강력한 언어 모델을 사용 가능하게 만듦으로써 GGUF는 불과 2년 전만 해도 불가능해 보였던 방식으로 AI를 민주화했습니다.

영향은 부인할 수 없습니다:

- 수백만 사용자가 이제 로컬에서 AI 모델을 실행합니다

- 프라이버시와 보안이 AI 애플리케이션에 복원되었습니다

- 개발도상국이 최첨단 AI에 액세스할 수 있게 되었습니다

- 중소기업이 거대 기술 기업과 경쟁할 수 있습니다

- 엣지에서 혁신이 촉발되었습니다

혁명은 계속됩니다: GGUF가 진화하고 새로운 최적화가 등장함에 따라 클라우드와 로컬 AI 성능 간의 격차는 계속 줄어들고 있습니다. 미래는 로컬 AI에 속하며, GGUF가 이를 주도하고 있습니다.

애플리케이션에 AI를 통합하려는 개발자든, 개인 AI 솔루션을 찾는 비즈니스든, 최신 모델을 탐색하려는 애호가든, GGUF는 이 모든 것을 가능하게 만들었습니다. 혁명은 여기에 있으며, 접근 가능하고, 바로 당신 앞의 장치에서 실행되고 있습니다.

GGUF 혁명에 참여할 준비가 되셨습니까? Ollama를 다운로드하고, 첫 번째 GGUF 모델을 설치하고, 오늘 로컬 AI의 미래를 경험하세요. 힘은 말 그대로 당신의 손 안에 있습니다.

AI 인플루언서를 만들 준비가 되셨나요?

완전한 51레슨 과정에서 ComfyUI와 AI 인플루언서 마케팅을 마스터하는 115명의 학생들과 함께하세요.