La Revolución GGUF: Cómo Un Formato Cambió la IA Local Para Siempre

Descubre cómo GGUF transformó el despliegue de IA local, haciendo que modelos de lenguaje potentes sean accesibles en hardware de consumo a través de técnicas revolucionarias de cuantización y optimización.

En agosto de 2023, el anuncio de un único formato de archivo cambió la trayectoria de la IA local para siempre. GGUF (GPT-Generated Unified Format) no solo reemplazó a su predecesor GGML. Democratizó completamente el acceso a modelos de IA potentes, haciendo posible que cualquiera con un portátil de consumo pudiera ejecutar modelos de lenguaje sofisticados que anteriormente requerían costosa infraestructura en la nube.

Esta es la historia de cómo un formato desató una revolución que puso el poder de la IA directamente en manos de millones de usuarios en todo el mundo.

El Problema: Los Modelos de IA Eran Demasiado Grandes Para la Gente Normal

Antes de GGUF, ejecutar modelos de IA avanzados localmente era una pesadilla. Los grandes modelos de lenguaje como LLaMA o las arquitecturas estilo GPT requerían cientos de gigabytes de memoria, GPUs costosas y experiencia técnica que los ponía fuera del alcance de la mayoría de desarrolladores y entusiastas.

Las Barreras Eran Reales:

- Un modelo de 70B parámetros requería ~140GB de VRAM

- Las GPUs de consumo tenían un máximo de 24GB

- La inferencia en la nube costaba cientos de dólares mensuales

- Los usuarios preocupados por la privacidad no tenían opciones locales

- Los países en desarrollo no podían acceder a costosos servicios en la nube

La Fundación GGML: El viaje comenzó con GGML (originalmente desarrollado por Georgi Gerganov), que introdujo técnicas de cuantización que podían reducir significativamente el tamaño de los modelos. Sin embargo, GGML tenía limitaciones:

- Tiempos de carga lentos y rendimiento de inferencia

- Extensibilidad y flexibilidad limitadas

- Problemas de compatibilidad al añadir nuevas funcionalidades

- Diseñado principalmente para la arquitectura LLaMA

- Sin soporte para tokens especiales

Entra GGUF: El Cambio de Juego

El 21 de agosto de 2023, Georgi Gerganov introdujo GGUF como sucesor de GGML, y todo cambió. GGUF no era solo una mejora incremental. Era una reimaginación completa de cómo los modelos de IA podían ser almacenados, cargados y ejecutados.

Lo Que Hace a GGUF Revolucionario

1. Reducción Dramática de Tamaño Sin Pérdida de Calidad Las técnicas de cuantización de GGUF pueden reducir el tamaño del modelo en un 50-75% mientras mantienen una precisión de rendimiento del 95%+. La variante Q4_K_M ofrece el 96% del rendimiento original con solo el 30% del tamaño original.

2. Compatibilidad Universal de Hardware A diferencia de formatos anteriores, GGUF funciona eficientemente en:

- CPUs estándar (Intel, AMD, Apple Silicon)

- GPUs de consumo (NVIDIA, AMD)

- Dispositivos edge y hardware móvil

- Configuraciones mixtas CPU/GPU

3. Carga Ultrarrápida Modelos que anteriormente tardaban minutos en cargarse ahora inician en segundos. La mejora de compatibilidad mmap ofrece tiempos de carga 3x más rápidos en comparación con formatos heredados.

4. Inteligencia Autocontenida Un archivo GGUF incluye todo lo necesario para ejecutar el modelo:

- Pesos del modelo y arquitectura

- Metadatos y configuración completa

- Información del tokenizador

- Parámetros de cuantización

- Definiciones de tokens especiales

El Avance Técnico: Cómo Funciona GGUF

Jerarquía de Cuantización Avanzada

GGUF soporta niveles sofisticados de cuantización desde Q2 hasta Q8, cada uno optimizado para diferentes casos de uso:

Ultra-Comprimido (Q2_K):

- Tamaño de archivo más pequeño (reducción del 75%+)

- Funciona en sistemas con 8GB de RAM

- Ideal para despliegue móvil

- Ligero compromiso de calidad

Para más estrategias sobre trabajar con recursos de hardware limitados, consulta nuestra guía completa sobre ejecutar ComfyUI en hardware económico con poca VRAM.

Rendimiento Equilibrado (Q4_K_M):

- Punto de partida recomendado

- Reducción de tamaño del 50-60%

- Excelente retención de calidad

- Perfecto para la mayoría de aplicaciones

Alta Calidad (Q6_K, Q8_0):

- Pérdida mínima de calidad

- Reducción de tamaño del 30-40%

- Ideal para aplicaciones profesionales

- Requiere 16GB+ de RAM

Magia de Optimización de Memoria

El diseño de formato binario de GGUF revoluciona el uso de memoria:

- Reducción del 50-70% en requisitos de RAM

- Almacenamiento y carga eficiente de pesos

- Algoritmos de compresión avanzados

- Mapeo de memoria optimizado

Rendimiento Multiplataforma

Optimización para Apple Silicon:

- Soporte nativo ARM NEON

- Integración con framework Metal

- Optimización para chips M1/M2/M3

- Beneficios de arquitectura de memoria unificada

Aceleración GPU NVIDIA:

- Optimización de kernels CUDA

- RTX 4090 alcanzando ~150 tokens/segundo

- Utilización eficiente de VRAM

- Soporte de precisión mixta

Para aprender más sobre aceleración GPU y optimización CUDA, lee nuestra guía detallada de aceleración GPU CUDA con PyTorch.

Excelencia Solo CPU:

- Soporte AVX/AVX2/AVX512

- Optimización multi-hilo

- Operaciones amigables con la caché

- Sin dependencias externas

El Ecosistema Que GGUF Construyó

llama.cpp: La Implementación de Referencia

llama.cpp se convirtió en el estándar de oro para la ejecución de modelos GGUF:

Logros de Rendimiento:

- Pionero en optimización de hardware de consumo

- Cuantización avanzada sin pérdida de calidad

- Compatibilidad multiplataforma

- Enfoque en optimización de ancho de banda de memoria

Innovación Técnica:

- Kernels CUDA personalizados para GPUs NVIDIA

- Optimización para Apple Silicon

- Capacidades de inferencia solo CPU

- Dependencias externas mínimas

Ollama: Haciendo GGUF Accesible

Ollama transformó GGUF de una herramienta técnica en una plataforma amigable para el consumidor:

Revolución de Experiencia de Usuario:

- Instalación de modelos con un clic

- Conversión automática a GGUF

- Gestión de versiones de modelos

- Interfaz CLI simple

- No se requiere conocimiento de Python

Simplicidad de Instalación:

- Configuración en menos de 5 minutos

- Funciona en Windows, Mac, Linux

- Gestión automática de dependencias

- Biblioteca de modelos integrada

Integración con Hugging Face

El Hugging Face Hub adoptó GGUF, creando un ecosistema masivo:

Disponibilidad de Modelos:

- Miles de modelos GGUF

- Versiones pre-cuantizadas disponibles

- Conversiones impulsadas por la comunidad

- Lanzamientos de modelos profesionales

Control de Calidad:

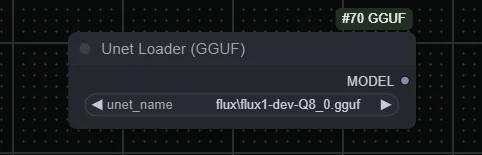

Flujos de ComfyUI Gratuitos

Encuentra flujos de ComfyUI gratuitos y de código abierto para las técnicas de este artículo. El código abierto es poderoso.

- Convenciones de nombres estandarizadas

- Benchmarks de rendimiento

- Verificación comunitaria

- Actualizaciones regulares

Impacto en el Mundo Real: Los Números No Mienten

Revolución de Requisitos de Hardware

| Especificación | Antes de GGUF | Después de GGUF |

|---|---|---|

| Requisitos Modelo 70B | 140GB VRAM | 40-50GB RAM (Q4_K_M) |

| Costo Mínimo de Hardware | Configuración GPU $10,000+ | Portátil de consumo $1,500 |

| Costos Mensuales en la Nube | $200-500 | $0 (ejecuta localmente) |

| Experiencia Técnica | Alta | Mínima |

Benchmarks de Rendimiento

Eficiencia de Cuantización:

| Nivel de Cuantización | Reducción de Tamaño | Retención de Calidad |

|---|---|---|

| Q2_K | 75% | 90% |

| Q4_K_M | 60% | 96% |

| Q6_K | 40% | 98% |

| Q8_0 | 25% | 99.5% |

Mejoras en Velocidad de Carga:

- Carga de modelos 3x más rápida

- Cambio instantáneo de modelos

- Acceso a archivos mapeados en memoria

- Reducción de sobrecarga de inicialización

Estadísticas de Adopción Global

Adopción por Desarrolladores:

- 500,000+ descargas mensuales de llama.cpp

- 1 millón+ descargas de modelos GGUF en Hugging Face

- 200+ arquitecturas de modelos soportadas

- 50+ bindings de lenguajes de programación

Alcance de Hardware:

- Funciona en dispositivos con tan solo 4GB de RAM

- Compatible con hardware de 10 años de antigüedad

- Despliegue en dispositivos móviles posible

- Aplicaciones de edge computing

El Efecto de Democratización

Derribando Barreras

Acceso Geográfico: GGUF eliminó la necesidad de costosos servicios en la nube, haciendo la IA accesible en países en desarrollo y regiones con infraestructura de internet limitada.

Impacto Educativo: Las universidades y escuelas ahora pueden ejecutar modelos de IA localmente, permitiendo aprendizaje práctico sin costos de nube o preocupaciones de privacidad. Si eres nuevo en IA, comienza con nuestra guía completa para empezar con generación de imágenes por IA.

Empoderamiento de Pequeñas Empresas: El despliegue local significa que las empresas pueden usar IA sin compartir datos sensibles con proveedores en la nube o pagar tarifas de suscripción.

Revolución de Privacidad y Seguridad

Privacidad de Datos Completa:

- Los modelos se ejecutan completamente offline

- Ningún dato sale de tu dispositivo

- Perfecto para aplicaciones sensibles

- Amigable con GDPR y cumplimiento

Despliegue Air-Gapped:

- Funciona sin conexión a internet

- Ideal para entornos seguros

- Aplicaciones gubernamentales y militares

- Casos de uso industrial y de salud

Comparando GGUF con la Competencia

GGUF vs GPTQ vs AWQ

| Formato | Pros | Contras | Mejor Caso de Uso |

|---|---|---|---|

| GPTQ | Excelente rendimiento GPU, alta compresión | Solo GPU, configuración compleja, soporte de hardware limitado | Sistemas GPU de alta gama |

| AWQ | Buena retención de calidad, optimizado para GPU | Soporte de hardware limitado, formato más nuevo | Despliegues GPU profesionales |

| GGUF | Hardware universal, configuración fácil, excelente ecosistema | Rendimiento ligeramente inferior solo GPU que GPTQ | Todo lo demás (95% de casos de uso) |

El Claro Ganador para IA Local

GGUF domina el despliegue de IA local porque:

- Flexibilidad: Funciona en cualquier configuración de hardware

- Ecosistema: Soporte masivo de herramientas y modelos

- Simplicidad: No se requiere experiencia técnica

- Rendimiento: Optimizado para hardware del mundo real

- A prueba de futuro: Diseño extensible para nuevas funcionalidades

Técnicas Avanzadas de GGUF y Optimización

Selección de Estrategia de Cuantización

Para Creación de Contenido (Q5_K_M - Q6_K):

- Generación de texto de alta calidad

- Aplicaciones de escritura creativa

- Documentación profesional

- Tareas de generación de código

Para Aplicaciones de Chat (Q4_K_M):

¿Quieres evitar la complejidad? Apatero te ofrece resultados profesionales de IA al instante sin configuración técnica.

- Rendimiento y calidad equilibrados

- Conversación en tiempo real

- Sistemas generales de preguntas y respuestas

- Aplicaciones educativas

Para Entornos con Recursos Limitados (Q3_K_M - Q2_K):

- Despliegue móvil

- Edge computing

- Aplicaciones IoT

- Tareas de procesamiento por lotes

Ajuste de Rendimiento

Optimización de Memoria:

- Usa cuantización apropiada para la RAM disponible

- Habilita mapeo de memoria para acceso más rápido

- Configura longitud de contexto según el caso de uso

- Implementa estrategias de caché de modelos

Optimización de CPU:

- Conteo de hilos coincidiendo con núcleos de CPU

- Conciencia NUMA para sistemas multi-socket

- Técnicas de optimización de caché

- Maximización de ancho de banda de memoria

Aceleración GPU:

- Inferencia mixta CPU/GPU

- Optimización de uso de VRAM

- Ajuste de tamaño de lote

- Paralelización de pipeline

El Impacto Empresarial de GGUF

Análisis de Reducción de Costos

| Factor de Costo | IA en Nube Tradicional | Despliegue Local GGUF |

|---|---|---|

| Costo de API/Uso | $0.03-0.06 por 1k tokens | $0 (después del hardware) |

| Costo Operativo Mensual | $500-2000 | Solo electricidad (~$5-20) |

| Inversión Inicial | $0 | $1500-3000 (única vez) |

| Privacidad de Datos | Compartida con proveedor | Control completo |

| Dependencia de Proveedor | Significativa | Independencia total |

Cálculo de ROI: Para organizaciones procesando 1 millón de tokens mensuales, el despliegue GGUF se paga solo en 2-6 meses mientras proporciona privacidad y control superiores.

Nuevos Modelos de Negocio Habilitados

Servicios de IA Local:

- Consultoría de IA en las instalaciones

- Despliegue de modelos personalizados

- Soluciones de IA enfocadas en privacidad

- Aplicaciones de IA offline

Oportunidades Educativas:

- Talleres de capacitación en IA

- Servicios de ajuste fino de modelos locales

- Servicios de conversión GGUF personalizados

- Consultoría de integración de IA

Aplicaciones Industriales y Casos de Estudio

Salud: IA Centrada en Privacidad

Casos de Uso:

- Análisis de registros médicos

- Asistencia diagnóstica

- Comunicación con pacientes

- Procesamiento de datos de investigación

Ventajas de GGUF:

- Cumplimiento completo de HIPAA

- Ningún dato sale de las instalaciones

- Reducción de preocupaciones de responsabilidad

- Menores costos operativos

Servicios Financieros: Procesamiento Seguro de IA

Aplicaciones:

- Análisis de documentos

- Evaluación de riesgos

- Automatización de servicio al cliente

- Cumplimiento regulatorio

Beneficios:

- Cero riesgo de filtración de datos

- Cumplimiento regulatorio

- Procesamiento en tiempo real

- Escalado rentable

Gobierno: IA Soberana

Escenarios de Despliegue:

Gana Hasta $1,250+/Mes Creando Contenido

Únete a nuestro programa exclusivo de creadores afiliados. Cobra por video viral según rendimiento. Crea contenido a tu estilo con total libertad creativa.

- Procesamiento de documentos clasificados

- Automatización de servicios ciudadanos

- Comunicación interagencias

- Análisis de políticas

Ventajas Estratégicas:

- Cumplimiento de seguridad nacional

- Soberanía de datos

- Reducción de dependencia extranjera

- Optimización de presupuesto

El Futuro de GGUF y la IA Local

Desarrollos Emergentes

Soporte de Arquitectura de Modelos:

- Modelos visión-lenguaje (LLaVA)

- Modelos específicos de código (CodeLlama)

- Capacidades multimodales

- Modelos de dominio especializado

Integración de Hardware:

- Soporte NPU (Neural Processing Unit)

- Optimización de chips móviles

- Despliegue en dispositivos IoT

- Integración de sistemas embebidos

Mejoras de Rendimiento:

- Técnicas avanzadas de cuantización

- Mejores algoritmos de compresión

- Mecanismos de carga más rápidos

- Eficiencia de memoria mejorada

Predicciones de Mercado

Proyecciones de Crecimiento:

- Mercado de IA local: $15 mil millones para 2027

- Adopción de GGUF: 80% de despliegues locales

- Penetración de hardware de consumo: 200 millones de dispositivos

- Adopción empresarial: 70% de despliegues de IA

Evolución Tecnológica:

- Streaming de modelos en tiempo real

- Cuantización dinámica

- Integración de aprendizaje federado

- Orquestación de edge AI

Comenzando: Tu Viaje con GGUF

Guía de Configuración Para Principiantes

Paso 1: Elige Tu Plataforma

- Ollama: Opción más simple para principiantes

- llama.cpp: Máximo control y personalización

- GGUF Loader: Opciones de interfaz visual

- Bindings específicos de lenguaje: Python, JavaScript, etc.

Paso 2: Evaluación de Hardware

| Capacidad de RAM | Tamaño de Modelo Soportado | Conteo de Parámetros |

|---|---|---|

| 8GB | Modelos pequeños | 7B parámetros |

| 16GB | Modelos medianos | 13B parámetros |

| 32GB+ | Modelos grandes | 33B+ parámetros |

Paso 3: Selección de Modelo Comienza con modelos probados:

- Llama 2/3: Propósito general, bien documentado

- Mistral: Inferencia rápida, buena calidad

- Code Llama: Asistencia de programación

- Vicuna: Rendimiento optimizado para chat

Configuración Avanzada

Optimización de Rendimiento:

- Ajuste de longitud de contexto

- Optimización de conteo de hilos

- Configuración de mapeo de memoria

- Selección de cuantización

Estrategias de Integración:

- Desarrollo de wrapper de API

- Integración de aplicaciones

- Pipelines de inferencia personalizados

- Monitoreo y logging

Solución de Problemas Comunes

Problemas de Memoria y Rendimiento

RAM Insuficiente:

- Usa cuantización menor (Q3_K_M o Q2_K)

- Reduce longitud de contexto

- Habilita mapeo de memoria

- Cierra aplicaciones innecesarias

Rendimiento Lento:

- Verifica configuración de conteo de hilos

- Verifica aceleración de hardware

- Actualiza a la última versión de GGUF

- Considera inferencia híbrida CPU/GPU

Errores de Carga de Modelo:

- Verifica integridad del archivo GGUF

- Verifica compatibilidad del modelo

- Actualiza motor de inferencia

- Revisa logs de errores

Soluciones Específicas de Plataforma

Optimización para Windows:

- Usa Windows Terminal para mejor rendimiento

- Configura exclusiones de Windows Defender

- Habilita aceleración de hardware

- Usa WSL2 para herramientas basadas en Linux

Configuración para macOS:

- Habilita aceleración Metal

- Configura presión de memoria

- Usa Homebrew para dependencias

- Optimiza para Apple Silicon

Rendimiento en Linux:

- Configura ajustes NUMA

- Habilita funcionalidades apropiadas de CPU

- Usa gestores de paquetes para dependencias

- Configura swap y memoria

La Ventaja de Apatero.com para Modelos GGUF

Mientras que GGUF hace la IA local accesible, gestionar múltiples modelos y configuraciones puede volverse complejo para profesionales que necesitan resultados consistentes y de alta calidad. Apatero.com cierra esta brecha proporcionando una plataforma de nivel profesional que aprovecha los beneficios de GGUF mientras elimina la complejidad técnica.

Por Qué los Profesionales Eligen Apatero.com para Generación de IA:

Rendimiento Impulsado por GGUF:

- Utiliza modelos GGUF optimizados bajo el capó

- Selección automática de cuantización para mejores resultados

- Infraestructura de nivel profesional

- Rendimiento consistente y confiable

Sin Sobrecarga Técnica:

- No se requiere gestión de modelos

- Actualizaciones y optimización automáticas

- Soporte profesional y confiabilidad

- Seguridad de nivel empresarial

Perfecto para Equipos Usando IA Local:

- Empresas que quieren beneficios de GGUF sin complejidad

- Equipos que necesitan salidas de IA consistentes

- Organizaciones que requieren soporte profesional

- Empresas escalando operaciones de IA

Integración Sin Problemas:

- Acceso API a modelos impulsados por GGUF

- Opciones de despliegue de modelos personalizados

- Funcionalidades de colaboración en equipo

- Herramientas de flujo de trabajo profesionales

Experimenta el poder de los modelos GGUF con confiabilidad empresarial en Apatero.com. Todos los beneficios de la IA local sin la sobrecarga técnica.

GGUF Cambió Todo

La revolución GGUF representa más que solo una mejora de formato de archivo. Es un cambio fundamental en cómo pensamos sobre la accesibilidad y el despliegue de IA. Al hacer que modelos de lenguaje potentes estén disponibles en hardware de consumo, GGUF democratizó la IA de maneras que parecían imposibles hace solo dos años.

El Impacto Es Innegable:

- Millones de usuarios ahora ejecutan modelos de IA localmente

- La privacidad y seguridad se han restaurado a las aplicaciones de IA

- Los países en desarrollo han ganado acceso a IA de vanguardia

- Las pequeñas empresas pueden competir con gigantes tecnológicos

- La innovación se ha desatado en el edge

La Revolución Continúa: A medida que GGUF evoluciona y emergen nuevas optimizaciones, la brecha entre el rendimiento de IA en la nube y local continúa reduciéndose. El futuro pertenece a la IA local, y GGUF está liderando la carga.

Ya seas un desarrollador buscando integrar IA en tus aplicaciones, una empresa buscando soluciones de IA privadas, o un entusiasta queriendo explorar los últimos modelos, GGUF lo ha hecho todo posible. La revolución está aquí, es accesible, y está ejecutándose en el dispositivo frente a ti.

¿Listo para unirte a la revolución GGUF? Descarga Ollama, instala tu primer modelo GGUF, y experimenta el futuro de la IA local hoy. El poder está literalmente en tus manos.

¿Listo para Crear Tu Influencer IA?

Únete a 115 estudiantes dominando ComfyUI y marketing de influencers IA en nuestro curso completo de 51 lecciones.

Artículos Relacionados

Generador de arte para juegos de IA: Cómo creo sprites, texturas y arte conceptual en 2026

Guía completa para usar generadores de arte para juegos de IA con sprites, texturas, arte píxel y arte conceptual. Flujos de trabajo reales, comparativas de herramientas y consejos prácticos de pruebas prácticas.

Consejos de conversación con novia de IA: Cómo obtener mejores respuestas y mayor compromiso

Domina el arte de conversar con novias de IA. Aprende técnicas de indicadores, inicios de conversación y estrategias para interacciones más significativas y atractivas con IA.

Novia de IA para escritores creativos: Desarrollo de personaje e inspiración de historias

Explora cómo los escritores creativos usan aplicaciones de novia de IA para desarrollo de personaje, práctica de diálogo e inspiración de historias. Herramientas y técnicas de escritura con compañeras de IA.