낮은 VRAM? 문제없음: 예산 하드웨어에서 ComfyUI 실행

제한된 GPU 메모리로 ComfyUI를 실행하기 위한 실용적인 가이드. 최적화 트릭, CPU 폴백 옵션, 클라우드 대안, 모든 예산에 대한 하드웨어 업그레이드 권장 사항을 배웁니다.

다른 사람들이 쉽게 멋진 AI 아트를 생성하는 것처럼 보이는 동안 "CUDA out of memory" 오류를 응시하고 계신가요? 이 좌절감을 겪는 것은 당신만이 아니며, 해결책은 비싼 RTX 4090으로 업그레이드하는 것보다 간단할 수 있습니다. 이 오류에 대한 완전한 문제 해결 가이드는 ComfyUI 초보자가 흔히 하는 10가지 실수를 확인하세요.

이 시나리오를 상상해보세요. ComfyUI를 다운로드하여 첫 번째 걸작을 만들기를 기대했지만 반복적으로 충돌하는 것을 보게 됩니다. 한편, Apatero.com과 같은 플랫폼은 하드웨어 요구 사항 없이 전문적인 결과를 제공하지만, 현재 설정을 작동시키기로 결심했습니다.

VRAM 요구 사항에 대한 현실 확인

ComfyUI의 메모리 사용량은 모델 크기와 이미지 해상도에 따라 극적으로 다릅니다. 이러한 요구 사항을 이해하면 현실적인 기대치를 설정하고 올바른 최적화 전략을 선택하는 데 도움이 됩니다.

- Stable Diffusion 1.5: 3.5GB 기본 + 2GB 워크플로우 오버헤드 = 5.5GB 최소

- SDXL 모델: 6.9GB 기본 + 3GB 오버헤드 = 10GB 최소

- ControlNet 추가: 전처리기에 따라 +2-4GB

- 다중 LoRA: LoRA 모델당 +500MB-1GB

좋은 소식은? 이 숫자들은 최악의 시나리오를 나타냅니다. 스마트한 최적화로 요구 사항을 40-60% 줄일 수 있어 단 4GB VRAM만으로도 ComfyUI를 실행 가능하게 만듭니다.

VRAM vs 시스템 RAM vs CPU 성능

대부분의 튜토리얼은 GPU 메모리에만 집중하지만, ComfyUI는 올바르게 구성되면 지능적으로 처리를 오프로드할 수 있습니다. 다양한 구성 요소가 성능에 미치는 영향은 다음과 같습니다.

| 구성 요소 | 역할 | 속도에 미치는 영향 | 메모리 사용량 |

|---|---|---|---|

| VRAM | 활성 모델 저장 | 시스템 RAM보다 10배 빠름 | 가장 빠른 액세스 |

| 시스템 RAM | 모델 스왑 버퍼 | 저장소보다 3배 빠름 | 중간 액세스 |

| CPU | 폴백 처리 | GPU보다 50-100배 느림 | 시스템 RAM 사용 |

| 저장소 | 모델 저장 | 로드 중에만 | 영구 저장 |

낮은 VRAM 시스템을 위한 필수 시작 매개변수

시작 매개변수는 모델 로드를 시작하기 전에 메모리를 관리하는 방법을 ComfyUI에 알려줍니다. 이러한 플래그는 작동과 충돌 사이의 차이를 만들 수 있습니다.

4GB VRAM 카드용 (GTX 1650, RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram: 활성 부분만 VRAM에 유지하고 나머지를 시스템 RAM으로 스왑

- --preview-method auto: 샘플링 중 효율적인 미리보기 생성 사용

6GB VRAM 카드용 (GTX 1060, RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

--force-fp16 플래그는 최소한의 품질 손실로 모델 메모리 사용량을 절반으로 줄입니다. 이 VRAM 범위에 완벽합니다.

8GB VRAM 카드용 (RTX 3070, RTX 4060)

python main.py --preview-method auto --force-fp16

8GB 카드는 대부분의 워크플로우를 처리할 수 있지만 복잡한 다중 모델 설정을 위해 FP16 정밀도의 이점을 받습니다.

고급 시작 매개변수

공격적인 메모리 관리: python main.py --lowvram --cpu-vae --preview-method none

파이프라인 일부의 CPU 폴백: python main.py --lowvram --cpu-vae --normalvram

최대 호환성 모드: python main.py --cpu --preview-method none

각 추가 매개변수는 속도를 호환성과 교환한다는 점에 유의하세요.

제한된 VRAM을 위한 모델 선택 전략

모든 AI 모델이 메모리 효율성에서 동등하게 만들어진 것은 아닙니다. 전략적 모델 선택은 경험을 극적으로 개선할 수 있습니다.

SD 1.5 모델 (메모리 챔피언)

Stable Diffusion 1.5 모델은 3.5GB VRAM만 필요하고 우수한 결과를 생성합니다. 낮은 VRAM 시스템을 위한 최고 선택은 다음 옵션을 포함합니다.

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper): 3.97GB 모델 크기로 다용도의 사실적인 결과

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1): 3.97GB의 초상화 전문가

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality): 3.97GB의 균형 잡힌 스타일

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix): 3.76GB의 애니메이션 중심

가지치기된 SDXL 모델 (최상의 타협)

전체 SDXL 모델은 6.9GB이지만, 가지치기된 버전은 대부분의 품질 이점을 유지하면서 이를 4.7GB로 줄입니다.

- SDXL Base (가지치기됨): 4.7GB로 완전한 1024x1024 기능

- Juggernaut XL (가지치기됨): 4.7GB로 판타지 아트 전문

- RealStock SDXL (가지치기됨): 4.7GB로 사진 촬영에 최적화

메모리 효율적인 LoRA 전략

LoRA 모델은 최소한의 메모리 오버헤드로 스타일 및 개념 제어를 추가합니다. 각 LoRA는 500MB-1GB만 추가하므로 낮은 VRAM 사용자 정의에 완벽합니다.

기본 모델 (3.5GB) + LoRA (0.5GB) = 4GB 총 vs 대형 사용자 정의 모델 (7GB) = 7GB 총

이미지 해상도 최적화

해상도는 생성 중 VRAM 사용에 가장 큰 영향을 미칩니다. 전략적 해상도 선택을 통해 메모리 제한을 초과하지 않고 큰 이미지를 만들 수 있습니다.

512x512 스위트 스팟

SD 1.5 모델의 경우 512x512는 품질과 메모리 사용의 최적 균형을 나타냅니다.

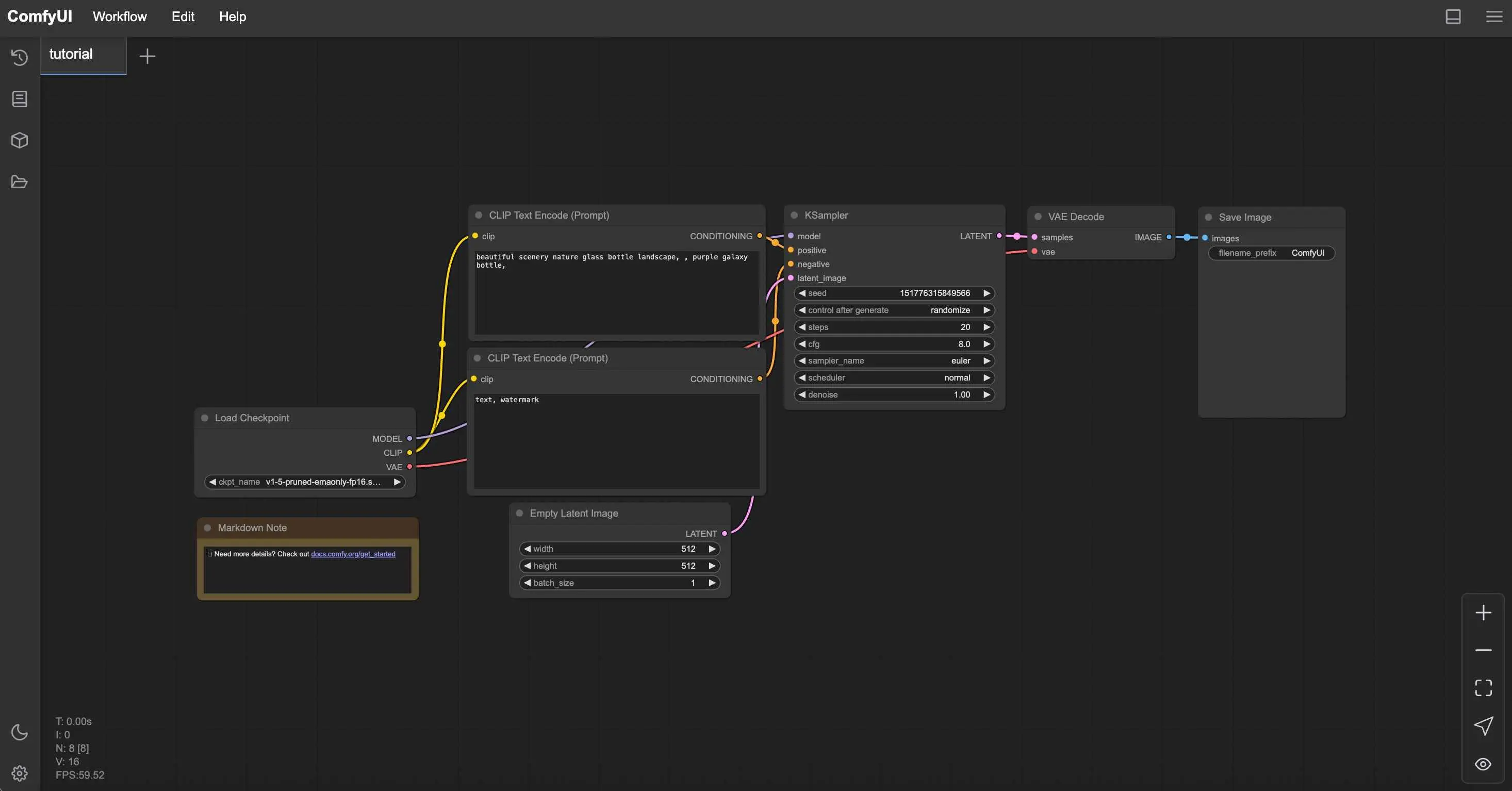

무료 ComfyUI 워크플로우

이 글의 기술에 대한 무료 오픈소스 ComfyUI 워크플로우를 찾아보세요. 오픈소스는 강력합니다.

| 해상도 | VRAM 사용량 | 생성 시간 | 품질 |

|---|---|---|---|

| 512x512 | 1.2GB | 15초 | 우수 |

| 768x768 | 2.8GB | 35초 | 더 나은 디테일 |

| 1024x1024 | 5.1GB | 65초 | SD 1.5 어려움 |

생성 + 업스케일링 전략

큰 이미지를 직접 생성하는 대신 512x512로 만든 다음 AI 도구로 업스케일합니다. 이 접근 방식은 더 적은 VRAM을 사용하고 종종 우수한 결과를 생성합니다. 업스케일링 방법에 대한 자세한 내용은 AI 이미지 업스케일링 비교를 읽어보세요.

2단계 생성 워크플로우

- 1단계: 제한된 VRAM으로 512x512에서 생성

- 2단계: 2x-4x 업스케일링을 위해 Real-ESRGAN 또는 ESRGAN 사용

- 3단계: 디테일 세밀화를 위한 선택적 img2img 패스

메모리 사용량은 전체 프로세스에서 4GB 미만으로 유지됩니다.

CPU 모드 설정 및 최적화

VRAM 제한이 극복할 수 없게 되면 CPU 모드는 실행 가능한 대안을 제공합니다. 느리지만 최신 CPU는 합리적인 시간 프레임에서 이미지를 생성할 수 있습니다.

CPU 모드 성능 현실 확인

CPU 생성은 훨씬 오래 걸리지만 16GB 이상의 RAM이 있는 모든 시스템에서 안정적으로 작동합니다.

| 하드웨어 | 512x512 시간 | 768x768 시간 | 최상의 사용 사례 |

|---|---|---|---|

| Intel i7-12700K | 8-12분 | 18-25분 | 인내심 있는 생성 |

| AMD Ryzen 7 5800X | 10-15분 | 22-30분 | 야간 배치 |

| M1 Pro Mac | 5-8분 | 12-18분 | 놀랍도록 좋음 |

| 이전 CPU (i5-8400) | 20-35분 | 45-60분 | 최후의 수단 |

CPU 성능 최적화

최대 CPU 최적화: python main.py --cpu --preview-method none --disable-xformers

- 다른 모든 애플리케이션 닫기: 시스템 리소스 확보

- 더 작은 모델 사용: SD 1.5 모델이 SDXL보다 잘 작동

- 단계 줄이기: 허용 가능한 품질을 위해 30-50 대신 15-20단계

- 밤새 배치 생성: 아침을 위해 여러 이미지 대기열에 추가

Apple Silicon 장점

M1 및 M2 Mac은 통합 메모리 아키텍처 및 최적화된 PyTorch 빌드로 인해 CPU 모드에서 놀랍도록 잘 작동합니다.

Apple Silicon용 최적화: python main.py --force-fp16 --preview-method auto

통합 메모리를 통해 M1/M2 시스템은 기존 VRAM 제한 없이 AI 생성을 위해 16GB 이상을 사용할 수 있습니다.

클라우드 및 원격 솔루션

때로는 낮은 VRAM 제한에 대한 최상의 솔루션은 클라우드 컴퓨팅을 통해 완전히 피하는 것입니다. 여러 옵션이 하드웨어 투자 없이 강력한 GPU 액세스를 제공합니다.

무료 클라우드 옵션

- [Google Colab](https://colab.research.google.com) (무료 티어): 15GB VRAM Tesla T4, 12시간 세션 제한

- [Kaggle Kernels](https://www.kaggle.com/code): 16GB VRAM P100, 30시간/주 제한

- [GitHub Codespaces](https://github.com/features/codespaces): 2코어 CPU만, 없는 것보다 나음

유료 클라우드 서비스

일관된 액세스를 위해 유료 서비스는 무료 티어보다 더 나은 성능과 신뢰성을 제공합니다.

복잡함을 건너뛰고 싶으신가요? Apatero 는 기술적 설정 없이 즉시 전문 AI 결과를 제공합니다.

| 서비스 | GPU 옵션 | 시간당 비용 | 최적 용도 |

|---|---|---|---|

| RunPod | RTX 4090, A100 | $0.50-2.00/시 | 파워 유저 |

| Vast.ai | 다양한 GPU | $0.20-1.50/시 | 예산 중심 |

| Lambda Labs | A100, H100 | $1.10-4.90/시 | 전문 작업 |

| Paperspace | RTX 5000, A6000 | $0.76-2.30/시 | 일관된 액세스 |

자세한 RunPod 설정 지침은 ComfyUI Docker 설정 가이드를 참조하세요.

Google Colab 설정 가이드

Colab에서 무료 ComfyUI (단계별)

- Google Colab 열기

- GPU 런타임으로 새 노트북 만들기 (런타임 → 런타임 유형 변경 → GPU)

- 이 코드 블록으로 ComfyUI 설치

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- 생성된 공개 URL을 통해 ComfyUI에 액세스

- Colab 인터페이스를 통해 모델 업로드 또는 직접 다운로드

하드웨어 업그레이드 전략

최적화가 한계에 도달하면 전략적 하드웨어 업그레이드가 최상의 장기 솔루션을 제공합니다. 스마트한 쇼핑은 대규모 투자 없이 성능을 극적으로 향상시킬 수 있습니다.

예산별 GPU 업그레이드 로드맵

$200 미만 중고 시장:

- GTX 1080 Ti (11GB) - SD 워크플로우에 우수한 가치

- RTX 2070 Super (8GB) - 기능과 VRAM의 좋은 균형

- RTX 3060 (12GB) - 관대한 VRAM을 가진 최신 아키텍처

$300-500 범위:

- RTX 3060 Ti (8GB) - 빠르지만 SDXL에는 VRAM 제한

- RTX 4060 Ti 16GB - AI 워크로드에 완벽

- RTX 3070 (8GB) - SD 1.5의 고성능

$500 이상 투자:

- RTX 4070 Super (12GB) - AI의 현재 스위트 스팟

- RTX 4070 Ti (12GB) - 더 높은 성능 티어

- 중고 RTX 3080 Ti (12GB) - 사용 가능한 경우 큰 가치

VRAM vs 성능 균형

더 많은 VRAM이 항상 더 나은 성능을 의미하지는 않습니다. 업그레이드를 선택할 때 일반적인 워크플로우 요구 사항을 고려하세요.

| 사용 사례 | 최소 VRAM | 권장 GPU | 이유 |

|---|---|---|---|

| SD 1.5만 | 6GB | RTX 3060 12GB | 우수한 가치 |

| SDXL 워크플로우 | 10GB | RTX 4070 Super | 미래 지향적 |

| 다중 LoRA | 12GB+ | RTX 4070 Ti | 복잡성 여유 |

| 전문 사용 | 16GB+ | RTX 4080 | 타협 없음 |

시스템 RAM 고려 사항

GPU 업그레이드는 모델 스와핑 및 워크플로우 복잡성을 위한 적절한 시스템 RAM과 함께 가장 잘 작동합니다.

- 16GB 시스템 RAM: 편안한 AI 워크플로우의 최소

- 32GB 시스템 RAM: 복잡한 다중 모델 설정에 권장

- 64GB 시스템 RAM: 대규모 모델을 위한 전문가 티어

워크플로우 최적화 기술

하드웨어 제한을 넘어 워크플로우 설계는 메모리 사용에 극적으로 영향을 미칩니다. 스마트한 워크플로우 구성으로 VRAM 요구 사항을 30-50% 줄일 수 있습니다.

메모리 효율적인 노드 배치

노드 순서는 생성 중 메모리 사용에 영향을 미칩니다. 전략적 배치는 피크 사용량을 줄입니다.

콘텐츠 제작으로 월 $1,250+ 벌기

독점 크리에이터 제휴 프로그램에 참여하세요. 바이럴 동영상 성과에 따라 수익을 받으세요. 완전한 창작 자유로 자신만의 스타일로 콘텐츠를 만드세요.

- 모델을 한 번 로드: 여러 체크포인트 로딩 노드 방지

- CLIP 인코더 재사용: 하나의 인코더를 여러 노드에 연결

- VAE 작업 최소화: 필요할 때만 디코드

- 효율적인 샘플러 사용: Euler 및 DPM++은 다른 것보다 적은 메모리 사용

배치 처리 전략

낮은 VRAM 시스템에서 여러 이미지를 효율적으로 생성하려면 다른 접근 방식이 필요합니다.

10개의 이미지를 동시에 생성하는 대신 (충돌), 배치당 2-3개의 이미지를 생성하고 메모리 오류 없이 일관된 생성을 위해 배치를 반복합니다.

ComfyUI Manager 최적화

ComfyUI Manager는 메모리 최적화 노드에 대한 원클릭 설치를 제공합니다.

낮은 VRAM을 위한 필수 Manager 설치

메모리 관리 노드:

- FreeU - 생성 중 메모리 사용량 감소

- Model Management - 자동 모델 언로드

- Efficient Attention - 메모리 최적화된 어텐션 메커니즘

설치 단계:

- Git clone을 통해 ComfyUI Manager 설치

- ComfyUI를 재시작하여 Manager 버튼 활성화

- 메모리 최적화 노드 검색 및 설치

- 새 노드 활성화를 위해 다시 재시작

모니터링 및 문제 해결

시스템 동작을 이해하면 성능을 최적화하고 충돌이 발생하기 전에 방지할 수 있습니다.

메모리 모니터링 도구

시스템 제한을 이해하고 그에 따라 최적화하기 위해 실시간으로 VRAM 사용량을 추적합니다.

Windows 사용자:

- 작업 관리자 → 성능 → GPU로 기본 모니터링

- 자세한 VRAM 추적을 위한 GPU-Z

- 지속적인 모니터링을 위한 MSI Afterburner

Linux 사용자: 실시간 VRAM 모니터링: nvidia-smi -l 1 또는 watch -n 1 nvidia-smi

Mac 사용자: 활동 모니터 → GPU 탭 또는 터미널 모니터링: sudo powermetrics -n 1 -i 1000 | grep -i gpu

일반적인 오류 해결

"CUDA out of memory"

- ComfyUI를 재시작하여 VRAM 지우기

- 이미지 해상도를 25% 줄이기

- 시작 매개변수에 --lowvram 추가

"Model loading failed"

- 사용 가능한 시스템 RAM 확인 (모델이 먼저 RAM에 로드됨)

- 더 작은 모델 변형 시도

- 다른 애플리케이션 닫기

"Generation extremely slow"

- GPU가 사용되고 있는지 확인 (nvidia-smi 확인)

- GPU 드라이버 업데이트

- 열 스로틀링 확인

성능 벤치마킹

최적화 효과를 측정하기 위해 기준 성능 메트릭을 확립합니다.

| 테스트 | 귀하의 하드웨어 | 목표 시간 | 최적화 성공 |

|---|---|---|---|

| 512x512 SD 1.5, 20단계 | _______ | < 30초 | 예/아니오 |

| 768x768 SD 1.5, 20단계 | _______ | < 60초 | 예/아니오 |

| 1024x1024 SDXL, 30단계 | _______ | < 120초 | 예/아니오 |

대안을 선택할 때

때로는 최상의 최적화는 ComfyUI가 현재 하드웨어 상황에 적합한 도구가 아님을 인식하는 것입니다.

낮은 VRAM 사용자를 위한 Apatero.com 장점

- 제로 하드웨어 요구 사항: 휴대폰을 포함한 모든 장치에서 작동

- 메모리 제한 없음: VRAM 걱정 없이 모든 해상도 생성

- 프리미엄 모델 액세스: 최신 SDXL 및 사용자 정의 모델 포함

- 즉각적인 결과: CPU 생성을 위해 20분 이상 기다릴 필요 없음

- 전문 기능: 기술적 복잡성 없는 고급 제어

- 비용 효율적: GPU 전기 비용보다 저렴한 경우가 많음

하이브리드 접근 전략

가장 스마트한 접근 방식은 특정 요구 사항에 따라 여러 솔루션을 결합하는 것입니다.

ComfyUI 사용 용도:

- AI 생성 원리 학습

- 사용자 정의 워크플로우 개발

- 오프라인 생성 요구 사항

- 적절한 하드웨어가 있을 때

Apatero.com 사용 용도:

- 전문 클라이언트 작업

- 고해상도 이미지

- 시간에 민감한 프로젝트

- 최신 모델 실험

예산 AI 생성의 결론

낮은 VRAM이 AI 아트 여정을 끝낼 필요는 없습니다. 적절한 최적화, 전략적 하드웨어 선택, 스마트한 워크플로우 설계를 통해 4GB 카드도 인상적인 결과를 생성할 수 있습니다.

최적화 행동 계획

- VRAM 수준에 적합한 시작 매개변수 적용

- 최대 호환성을 위해 SD 1.5 모델 선택

- AI 업스케일링으로 512x512 생성 사용

- 가끔 하이엔드 생성을 위해 클라우드 솔루션 고려

- 실제 사용 패턴에 따라 하드웨어 업그레이드 계획

- 기술적 번거로움 없이 결과가 필요할 때 [Apatero.com](https://apatero.com) 시도

하드웨어 제한이 종종 창의성을 불러일으킨다는 것을 기억하세요. 가장 혁신적인 AI 아트 중 일부는 제약에도 불구하고가 아니라 제약 내에서 작업하는 법을 배운 아티스트로부터 나옵니다.

현재 설정을 최적화하거나, 하드웨어를 업그레이드하거나, Apatero.com과 같은 클라우드 솔루션을 활용하거나 간에, 핵심은 문제 해결이 아닌 창작에 집중할 수 있는 접근 방식을 찾는 것입니다.

하드웨어에 관계없이 놀라운 AI 아트를 생성할 준비가 되셨나요? Apatero.com은 모든 기술적 장벽을 제거하고 즉시 창작을 시작하게 합니다. 최고의 AI 아트 도구는 방해가 되지 않고 창작하게 해주는 도구이기 때문입니다.

AI 인플루언서를 만들 준비가 되셨나요?

완전한 51레슨 과정에서 ComfyUI와 AI 인플루언서 마케팅을 마스터하는 115명의 학생들과 함께하세요.

관련 기사

2025년 ComfyUI 초보자가 가장 많이 하는 10가지 실수와 해결 방법

초보자를 좌절시키는 ComfyUI의 10가지 주요 함정을 피하세요. VRAM 오류, 모델 로딩 등에 대한 완벽한 문제 해결 가이드...

프로 사용자들이 알려주지 않는 25가지 ComfyUI 팁과 트릭 (2025년)

전문가들이 활용하는 25가지 고급 ComfyUI 팁, 워크플로우 최적화 기법, 프로 레벨 트릭을 알아보세요. CFG 튜닝, 배치 처리, 품질 개선에 대한 완전한 가이드입니다.

Anisora v3.2로 360도 애니메 회전: ComfyUI 완전한 캐릭터 회전 가이드 2025

ComfyUI에서 Anisora v3.2로 360도 애니메이션 캐릭터 회전을 마스터하세요. 카메라 궤도 워크플로우, 멀티뷰 일관성 및 전문적인 턴어라운드 애니메이션 기술을 배웁니다.