¿VRAM Baja? Sin Problema: Ejecutando ComfyUI en Hardware de Presupuesto

Guía práctica para ejecutar ComfyUI con memoria GPU limitada. Aprende trucos de optimización, opciones de respaldo de CPU, alternativas en la nube y recomendaciones de actualización de hardware para cada presupuesto.

¿Mirando fijamente errores de "CUDA out of memory" mientras todos los demás parecen generar arte IA impresionante sin esfuerzo? No estás solo en esta frustración, y la solución podría ser más simple que actualizar a esa costosa RTX 4090. Para una guía completa de solución de problemas de este error, consulta nuestros 10 errores comunes de principiantes en ComfyUI.

Imagina este escenario. Has descargado ComfyUI, emocionado por crear tu primera obra maestra, solo para verlo fallar repetidamente. Mientras tanto, plataformas como Apatero.com entregan resultados profesionales sin ningún requisito de hardware, pero estás determinado a hacer que tu configuración actual funcione.

La Verificación de Realidad Sobre Requisitos de VRAM

El uso de memoria de ComfyUI varía dramáticamente según el tamaño del modelo y la resolución de imagen. Entender estos requisitos te ayuda a establecer expectativas realistas y elegir la estrategia de optimización correcta.

- Stable Diffusion 1.5: 3.5GB base + 2GB para sobrecarga de flujo de trabajo = 5.5GB mínimo

- Modelos SDXL: 6.9GB base + 3GB sobrecarga = 10GB mínimo

- Adición de ControlNet: +2-4GB dependiendo del preprocesador

- Múltiples LoRAs: +500MB-1GB por modelo LoRA

¿La buena noticia? Estos números representan escenarios del peor caso. La optimización inteligente puede reducir los requisitos en un 40-60%, haciendo que ComfyUI sea viable en tarjetas con solo 4GB de VRAM.

VRAM vs RAM del Sistema vs Rendimiento de CPU

La mayoría de los tutoriales se enfocan únicamente en la memoria GPU, pero ComfyUI puede descargar inteligentemente el procesamiento cuando se configura correctamente. Aquí está cómo los diferentes componentes impactan el rendimiento.

| Componente | Rol | Impacto en Velocidad | Uso de Memoria |

|---|---|---|---|

| VRAM | Almacenamiento activo de modelo | 10x más rápido que RAM del sistema | Acceso más rápido |

| RAM del Sistema | Buffer de intercambio de modelos | 3x más rápido que almacenamiento | Acceso medio |

| CPU | Procesamiento de respaldo | 50-100x más lento que GPU | Usa RAM del sistema |

| Almacenamiento | Almacenamiento de modelos | Solo durante carga | Almacenamiento permanente |

Parámetros de Inicio Esenciales para Sistemas de VRAM Baja

Los parámetros de inicio le dicen a ComfyUI cómo gestionar la memoria antes de que comience a cargar modelos. Estos flags pueden significar la diferencia entre funcionar y fallar.

Para Tarjetas de 4GB VRAM (GTX 1650, RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram: Mantiene solo partes activas en VRAM, intercambia el resto a RAM del sistema

- --preview-method auto: Usa generación de vista previa eficiente durante el muestreo

Para Tarjetas de 6GB VRAM (GTX 1060, RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

El flag --force-fp16 reduce a la mitad el uso de memoria del modelo con pérdida mínima de calidad, perfecto para este rango de VRAM.

Para Tarjetas de 8GB VRAM (RTX 3070, RTX 4060)

python main.py --preview-method auto --force-fp16

Las tarjetas de 8GB pueden manejar la mayoría de los flujos de trabajo pero se benefician de la precisión FP16 para configuraciones complejas de múltiples modelos.

Parámetros de Inicio Avanzados

Gestión agresiva de memoria: python main.py --lowvram --cpu-vae --preview-method none

Respaldo de CPU para partes del pipeline: python main.py --lowvram --cpu-vae --normalvram

Modo de máxima compatibilidad: python main.py --cpu --preview-method none

Ten en cuenta que cada parámetro adicional intercambia velocidad por compatibilidad.

Estrategia de Selección de Modelos para VRAM Limitada

No todos los modelos de IA son iguales cuando se trata de eficiencia de memoria. La selección estratégica de modelos puede mejorar dramáticamente tu experiencia.

Modelos SD 1.5 (Campeones de Memoria)

Los modelos de Stable Diffusion 1.5 requieren solo 3.5GB de VRAM y generan excelentes resultados. Las mejores opciones para sistemas de VRAM baja incluyen las siguientes opciones.

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper): Resultados versátiles y fotorrealistas con tamaño de modelo de 3.97GB

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1): Especialista en retratos de 3.97GB

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality): Estilo equilibrado de 3.97GB

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix): Enfocado en anime de 3.76GB

Modelos SDXL Podados (Mejor Compromiso)

Los modelos SDXL completos pesan 6.9GB, pero las versiones podadas reducen esto a 4.7GB mientras mantienen la mayoría de los beneficios de calidad.

- SDXL Base (Podado): 4.7GB con capacidad completa de 1024x1024

- Juggernaut XL (Podado): 4.7GB especializado en arte fantástico

- RealStock SDXL (Podado): 4.7GB optimizado para fotografía

Estrategia de LoRA Eficiente en Memoria

Los modelos LoRA añaden control de estilo y concepto con sobrecarga mínima de memoria. Cada LoRA añade solo 500MB-1GB, haciéndolos perfectos para personalización de VRAM baja.

Modelo Base (3.5GB) + LoRA (0.5GB) = 4GB total vs Modelo Personalizado Grande (7GB) = 7GB total

Optimización de Resolución de Imagen

La resolución tiene el mayor impacto en el uso de VRAM durante la generación. Las elecciones estratégicas de resolución te permiten crear imágenes grandes sin exceder los límites de memoria.

El Punto Óptimo de 512x512

Para modelos SD 1.5, 512x512 representa el equilibrio óptimo de calidad y uso de memoria.

Flujos de ComfyUI Gratuitos

Encuentra flujos de ComfyUI gratuitos y de código abierto para las técnicas de este artículo. El código abierto es poderoso.

| Resolución | Uso de VRAM | Tiempo de Generación | Calidad |

|---|---|---|---|

| 512x512 | 1.2GB | 15 segundos | Excelente |

| 768x768 | 2.8GB | 35 segundos | Mejores detalles |

| 1024x1024 | 5.1GB | 65 segundos | SD 1.5 tiene dificultades |

Estrategia de Generación Más Escalado

En lugar de generar imágenes grandes directamente, crea a 512x512 y luego escala usando herramientas de IA. Este enfoque usa menos VRAM y a menudo produce resultados superiores. Para más sobre métodos de escalado, lee nuestra comparación de escalado de imágenes IA.

Flujo de Trabajo de Generación en Dos Etapas

- Etapa 1: Genera a 512x512 con tu VRAM limitada

- Etapa 2: Usa Real-ESRGAN o ESRGAN para escalado 2x-4x

- Etapa 3: Paso img2img opcional para refinamiento de detalles

El uso de memoria se mantiene por debajo de 4GB durante todo el proceso.

Configuración y Optimización del Modo CPU

Cuando las limitaciones de VRAM se vuelven insuperables, el modo CPU ofrece una alternativa viable. Aunque más lento, las CPUs modernas pueden generar imágenes en plazos razonables.

Verificación de Realidad del Rendimiento del Modo CPU

La generación con CPU tarda significativamente más pero funciona de manera confiable en cualquier sistema con 16GB+ de RAM.

| Hardware | Tiempo 512x512 | Tiempo 768x768 | Mejor Caso de Uso |

|---|---|---|---|

| Intel i7-12700K | 8-12 minutos | 18-25 minutos | Creación paciente |

| AMD Ryzen 7 5800X | 10-15 minutos | 22-30 minutos | Lotes nocturnos |

| M1 Pro Mac | 5-8 minutos | 12-18 minutos | Sorprendentemente bueno |

| CPUs Antiguas (i5-8400) | 20-35 minutos | 45-60 minutos | Último recurso |

Optimizando el Rendimiento de CPU

Optimización máxima de CPU: python main.py --cpu --preview-method none --disable-xformers

- Cierra todas las demás aplicaciones: Libera recursos del sistema

- Usa modelos más pequeños: Los modelos SD 1.5 funcionan mejor que SDXL

- Reduce pasos: 15-20 pasos en lugar de 30-50 para calidad aceptable

- Genera lotes por la noche: Pon en cola múltiples imágenes para la mañana

Ventaja de Apple Silicon

Los Macs M1 y M2 funcionan sorprendentemente bien en modo CPU debido a la arquitectura de memoria unificada y construcciones optimizadas de PyTorch.

Optimizado para Apple Silicon: python main.py --force-fp16 --preview-method auto

La memoria unificada permite que los sistemas M1/M2 usen 16GB+ para generación de IA sin limitaciones tradicionales de VRAM.

Soluciones en la Nube y Remotas

A veces la mejor solución para las limitaciones de VRAM baja es evitarlas por completo a través de computación en la nube. Varias opciones proporcionan acceso a GPU potentes sin inversión en hardware.

Opciones de Nube Gratuitas

- [Google Colab](https://colab.research.google.com) (Nivel Gratuito): Tesla T4 de 15GB VRAM, límite de sesión de 12 horas

- [Kaggle Kernels](https://www.kaggle.com/code): P100 de 16GB VRAM, límite de 30 horas/semana

- [GitHub Codespaces](https://github.com/features/codespaces): CPU de 2 núcleos solamente, mejor que nada

Servicios de Nube Pagados

Para acceso consistente, los servicios pagados ofrecen mejor rendimiento y confiabilidad que los niveles gratuitos.

¿Quieres evitar la complejidad? Apatero te ofrece resultados profesionales de IA al instante sin configuración técnica.

| Servicio | Opciones de GPU | Costo por Hora | Mejor Para |

|---|---|---|---|

| RunPod | RTX 4090, A100 | $0.50-2.00/hr | Usuarios avanzados |

| Vast.ai | Varias GPUs | $0.20-1.50/hr | Conscientes del presupuesto |

| Lambda Labs | A100, H100 | $1.10-4.90/hr | Trabajo profesional |

| Paperspace | RTX 5000, A6000 | $0.76-2.30/hr | Acceso consistente |

Para instrucciones detalladas de configuración de RunPod, consulta nuestra guía de configuración de Docker de ComfyUI.

Guía de Configuración para Google Colab

ComfyUI Gratuito en Colab (Paso a Paso)

- Abre Google Colab

- Crea un nuevo notebook con runtime GPU (Runtime → Cambiar tipo de runtime → GPU)

- Instala ComfyUI con este bloque de código

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- Accede a ComfyUI a través de la URL pública generada

- Sube modelos a través de la interfaz de Colab o descarga directamente

Estrategias de Actualización de Hardware

Cuando la optimización alcanza sus límites, las actualizaciones estratégicas de hardware proporcionan la mejor solución a largo plazo. Las compras inteligentes pueden mejorar dramáticamente el rendimiento sin inversión masiva.

Hoja de Ruta de Actualización de GPU por Presupuesto

Menos de $200 Mercado Usado:

- GTX 1080 Ti (11GB) - Excelente valor para flujos de trabajo SD

- RTX 2070 Super (8GB) - Buen equilibrio de características y VRAM

- RTX 3060 (12GB) - Arquitectura moderna con VRAM generosa

Rango $300-500:

- RTX 3060 Ti (8GB) - Rápida pero limitada en VRAM para SDXL

- RTX 4060 Ti 16GB - Perfecta para cargas de trabajo de IA

- RTX 3070 (8GB) - Alto rendimiento para SD 1.5

Inversión $500+:

- RTX 4070 Super (12GB) - Punto óptimo actual para IA

- RTX 4070 Ti (12GB) - Nivel de rendimiento superior

- RTX 3080 Ti Usada (12GB) - Gran valor si está disponible

Balance VRAM vs Rendimiento

Más VRAM no siempre significa mejor rendimiento. Considera las necesidades típicas de tu flujo de trabajo al elegir actualizaciones.

| Caso de Uso | VRAM Mínima | GPU Recomendada | Por Qué |

|---|---|---|---|

| Solo SD 1.5 | 6GB | RTX 3060 12GB | Excelente valor |

| Flujos de Trabajo SDXL | 10GB | RTX 4070 Super | A prueba de futuro |

| Múltiples LoRAs | 12GB+ | RTX 4070 Ti | Margen para complejidad |

| Uso Profesional | 16GB+ | RTX 4080 | Sin compromisos |

Consideraciones de RAM del Sistema

Las actualizaciones de GPU funcionan mejor con RAM del sistema adecuada para intercambio de modelos y complejidad de flujos de trabajo.

- 16GB RAM del Sistema: Mínimo para flujos de trabajo de IA cómodos

- 32GB RAM del Sistema: Recomendado para configuraciones complejas de múltiples modelos

- 64GB RAM del Sistema: Nivel profesional para modelos masivos

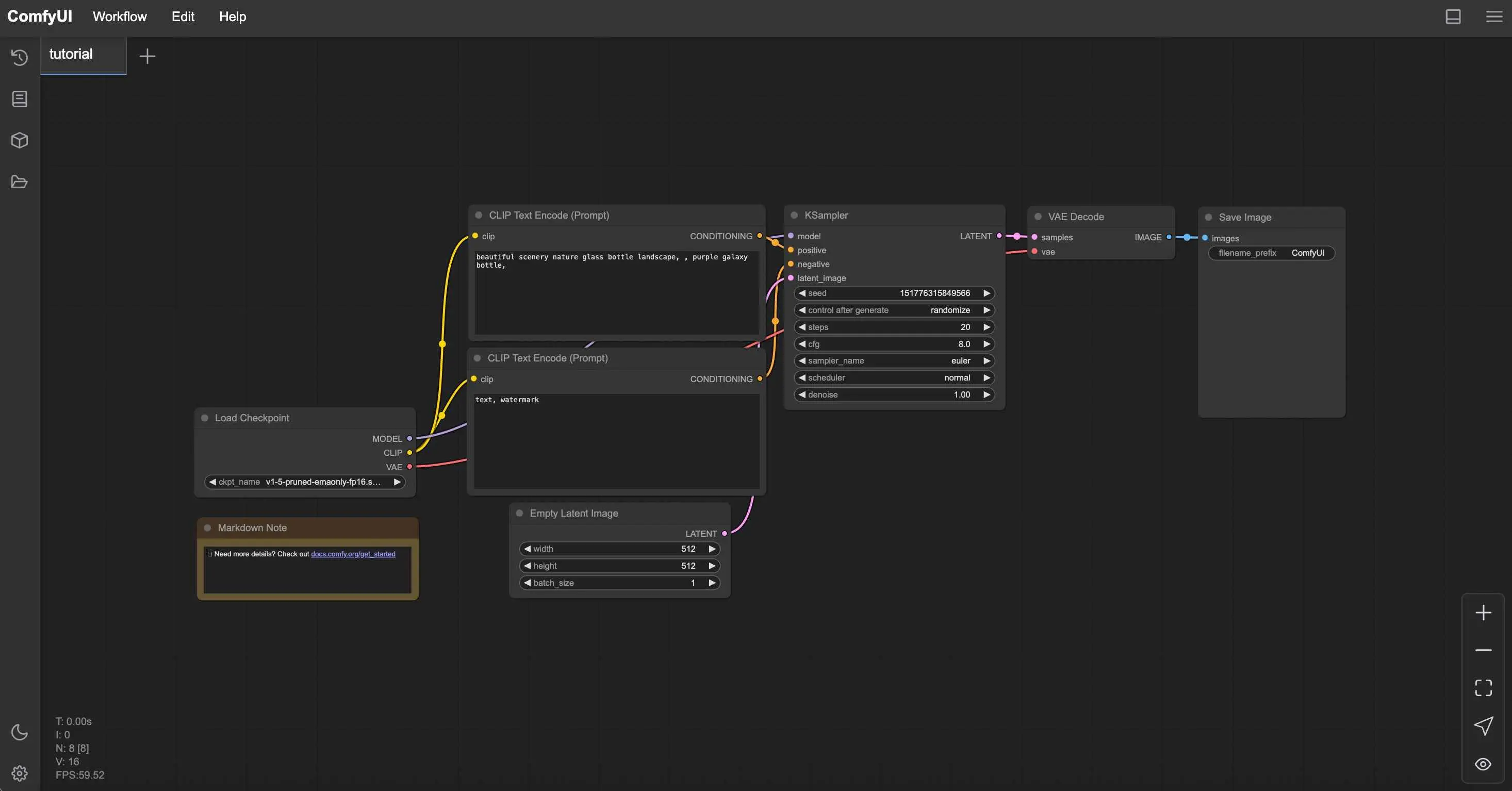

Técnicas de Optimización de Flujo de Trabajo

Más allá de las limitaciones de hardware, el diseño del flujo de trabajo impacta dramáticamente el uso de memoria. La construcción inteligente del flujo de trabajo puede reducir los requisitos de VRAM en un 30-50%.

Colocación de Nodos Eficiente en Memoria

El orden de los nodos afecta el uso de memoria durante la generación. La colocación estratégica reduce el uso pico.

Gana Hasta $1,250+/Mes Creando Contenido

Únete a nuestro programa exclusivo de creadores afiliados. Cobra por video viral según rendimiento. Crea contenido a tu estilo con total libertad creativa.

- Carga modelos una vez: Evita múltiples nodos de carga de checkpoint

- Reutiliza codificadores CLIP: Conecta un codificador a múltiples nodos

- Minimiza operaciones VAE: Decodifica solo cuando sea necesario

- Usa samplers eficientes: Euler y DPM++ usan menos memoria que otros

Estrategias de Procesamiento por Lotes

Generar múltiples imágenes eficientemente requiere diferentes enfoques en sistemas de VRAM baja.

En lugar de generar 10 imágenes simultáneamente (lo que falla), intenta generar 2-3 imágenes por lote y repite lotes para generación consistente sin errores de memoria.

Optimización de ComfyUI Manager

ComfyUI Manager proporciona instalación con un clic para nodos de optimización de memoria.

Instalaciones Esenciales de Manager para VRAM Baja

Nodos de Gestión de Memoria:

- FreeU - Reduce el uso de memoria durante la generación

- Model Management - Descarga automática de modelos

- Efficient Attention - Mecanismos de atención optimizados en memoria

Pasos de Instalación:

- Instala ComfyUI Manager vía Git clone

- Reinicia ComfyUI para activar el botón Manager

- Busca e instala nodos de optimización de memoria

- Reinicia nuevamente para activar nuevos nodos

Monitoreo y Solución de Problemas

Entender el comportamiento de tu sistema ayuda a optimizar el rendimiento y prevenir fallos antes de que ocurran.

Herramientas de Monitoreo de Memoria

Rastrea el uso de VRAM en tiempo real para entender los límites de tu sistema y optimizar en consecuencia.

Usuarios de Windows:

- Administrador de Tareas → Rendimiento → GPU para monitoreo básico

- GPU-Z para seguimiento detallado de VRAM

- MSI Afterburner para monitoreo continuo

Usuarios de Linux: Monitoreo de VRAM en tiempo real: nvidia-smi -l 1 o watch -n 1 nvidia-smi

Usuarios de Mac: Monitor de Actividad → pestaña GPU o monitoreo de terminal: sudo powermetrics -n 1 -i 1000 | grep -i gpu

Soluciones de Errores Comunes

"CUDA out of memory"

- Reinicia ComfyUI para limpiar VRAM

- Reduce la resolución de imagen en un 25%

- Añade --lowvram a los parámetros de inicio

"Model loading failed"

- Verifica RAM del sistema disponible (los modelos se cargan primero a RAM)

- Prueba variantes de modelos más pequeños

- Cierra otras aplicaciones

"Generation extremely slow"

- Verifica que se esté usando la GPU (verifica nvidia-smi)

- Actualiza controladores de GPU

- Verifica limitación térmica

Benchmarking de Rendimiento

Establece métricas de rendimiento de referencia para medir la efectividad de la optimización.

| Prueba | Tu Hardware | Tiempo Objetivo | Éxito de Optimización |

|---|---|---|---|

| 512x512 SD 1.5, 20 pasos | _______ | < 30 segundos | Sí/No |

| 768x768 SD 1.5, 20 pasos | _______ | < 60 segundos | Sí/No |

| 1024x1024 SDXL, 30 pasos | _______ | < 120 segundos | Sí/No |

Cuándo Elegir Alternativas

A veces la mejor optimización es reconocer cuándo ComfyUI no es la herramienta adecuada para tu situación actual de hardware.

Ventajas de Apatero.com para Usuarios de VRAM Baja

- Cero Requisitos de Hardware: Funciona en cualquier dispositivo incluyendo teléfonos

- Sin Limitaciones de Memoria: Genera cualquier resolución sin preocupaciones de VRAM

- Acceso a Modelos Premium: Últimos modelos SDXL y personalizados incluidos

- Resultados Instantáneos: Sin esperar más de 20 minutos para generación con CPU

- Características Profesionales: Controles avanzados sin complejidad técnica

- Rentable: A menudo más barato que los costos de electricidad de GPU

Estrategia de Enfoque Híbrido

El enfoque más inteligente a menudo combina múltiples soluciones basadas en tus necesidades específicas.

Usa ComfyUI Para:

- Aprender principios de generación de IA

- Desarrollo de flujos de trabajo personalizados

- Necesidades de generación offline

- Cuando tienes hardware adecuado

Usa Apatero.com Para:

- Trabajo profesional para clientes

- Imágenes de alta resolución

- Proyectos sensibles al tiempo

- Experimentar con los últimos modelos

La Conclusión sobre Generación de IA con Presupuesto

La VRAM baja no tiene que terminar tu viaje de arte IA. Con optimización adecuada, elecciones estratégicas de hardware y diseño inteligente de flujos de trabajo, incluso las tarjetas de 4GB pueden producir resultados impresionantes.

Tu Plan de Acción de Optimización

- Aplica parámetros de inicio apropiados para tu nivel de VRAM

- Elige modelos SD 1.5 para máxima compatibilidad

- Usa generación 512x512 con escalado de IA

- Considera soluciones en la nube para generación ocasional de gama alta

- Planifica actualizaciones de hardware basadas en tus patrones de uso reales

- Prueba [Apatero.com](https://apatero.com) cuando necesites resultados sin complicaciones técnicas

Recuerda que las limitaciones de hardware a menudo despiertan la creatividad. Parte del arte IA más innovador viene de artistas que aprendieron a trabajar dentro de restricciones en lugar de a pesar de ellas.

Ya sea que elijas optimizar tu configuración actual, actualizar tu hardware, o aprovechar soluciones en la nube como Apatero.com, la clave es encontrar el enfoque que te permita enfocarte en crear en lugar de solucionar problemas.

¿Listo para comenzar a generar arte IA increíble independientemente de tu hardware? Apatero.com elimina todas las barreras técnicas y te pone a crear inmediatamente. Porque la mejor herramienta de arte IA es la que se aparta de tu camino y te deja crear.

¿Listo para Crear Tu Influencer IA?

Únete a 115 estudiantes dominando ComfyUI y marketing de influencers IA en nuestro curso completo de 51 lecciones.

Artículos Relacionados

Los 10 Errores Más Comunes de Principiantes en ComfyUI y Cómo Solucionarlos en 2025

Evita las 10 principales trampas de ComfyUI que frustran a los nuevos usuarios. Guía completa de solución de problemas con soluciones para errores de VRAM, carga de modelos...

25 Tips y Trucos de ComfyUI Que los Usuarios Pro No Quieren Que Conozcas en 2025

Descubre 25 tips avanzados de ComfyUI, técnicas de optimización de flujos de trabajo y trucos de nivel profesional que los usuarios expertos aprovechan. Guía completa sobre ajuste de CFG, procesamiento por lotes y mejoras de calidad.

Rotación 360 de Anime con Anisora v3.2: Guía Completa de Rotación de Personajes ComfyUI 2025

Domina la rotación de personajes de anime de 360 grados con Anisora v3.2 en ComfyUI. Aprende flujos de trabajo de órbita de cámara, consistencia multi-vista y técnicas profesionales de animación turnaround.