VRAM低?没问题:在预算硬件上运行ComfyUI

在有限GPU内存下运行ComfyUI的实用指南。学习优化技巧、CPU回退选项、云替代方案和适合各种预算的硬件升级建议。

盯着"CUDA out of memory"错误,而其他人似乎毫不费力地生成令人惊叹的AI艺术?你不是唯一有这种挫败感的人,解决方案可能比升级到昂贵的RTX 4090更简单。有关此错误的完整故障排除指南,请查看我们的ComfyUI初学者常犯的10个错误。

想象这个场景。你下载了ComfyUI,兴奋地要创作你的第一个杰作,却看着它反复崩溃。与此同时,像Apatero.com这样的平台在没有任何硬件要求的情况下提供专业结果,但你决心让当前的设置工作。

VRAM要求的现实检查

ComfyUI的内存使用根据模型大小和图像分辨率而大不相同。理解这些要求可帮助你设定现实期望并选择正确的优化策略。

- Stable Diffusion 1.5: 3.5GB基础 + 2GB工作流开销 = 5.5GB最小

- SDXL模型: 6.9GB基础 + 3GB开销 = 10GB最小

- ControlNet添加: 根据预处理器+2-4GB

- 多个LoRA: 每个LoRA模型+500MB-1GB

好消息?这些数字代表最坏情况。智能优化可以减少40-60%的要求,使ComfyUI在仅4GB VRAM的显卡上可行。

VRAM vs 系统RAM vs CPU性能

大多数教程只关注GPU内存,但ComfyUI可以在正确配置时智能地卸载处理。不同组件如何影响性能如下。

| 组件 | 角色 | 对速度的影响 | 内存使用 |

|---|---|---|---|

| VRAM | 活动模型存储 | 比系统RAM快10倍 | 最快访问 |

| 系统RAM | 模型交换缓冲 | 比存储快3倍 | 中等访问 |

| CPU | 回退处理 | 比GPU慢50-100倍 | 使用系统RAM |

| 存储 | 模型存储 | 仅在加载期间 | 永久存储 |

低VRAM系统的必备启动参数

启动参数告诉ComfyUI在开始加载模型之前如何管理内存。这些标志可能意味着工作和崩溃之间的差异。

4GB VRAM显卡(GTX 1650、RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram: 仅在VRAM中保留活动部分,将其余部分交换到系统RAM

- --preview-method auto: 在采样期间使用高效的预览生成

6GB VRAM显卡(GTX 1060、RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

--force-fp16标志以最小的质量损失将模型内存使用减半,非常适合这个VRAM范围。

8GB VRAM显卡(RTX 3070、RTX 4060)

python main.py --preview-method auto --force-fp16

8GB显卡可以处理大多数工作流,但对于复杂的多模型设置,FP16精度有益。

高级启动参数

激进的内存管理: python main.py --lowvram --cpu-vae --preview-method none

管道部分的CPU回退: python main.py --lowvram --cpu-vae --normalvram

最大兼容性模式: python main.py --cpu --preview-method none

注意每个额外参数都将速度换取兼容性。

有限VRAM的模型选择策略

并非所有AI模型在内存效率方面都是平等创建的。战略性模型选择可以显著改善你的体验。

SD 1.5模型(内存冠军)

Stable Diffusion 1.5模型只需要3.5GB VRAM并生成出色的结果。低VRAM系统的首选包括以下选项。

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper): 3.97GB模型大小的多功能照片级真实结果

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1): 3.97GB的肖像专家

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality): 3.97GB的平衡风格

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix): 3.76GB的动漫重点

修剪的SDXL模型(最佳折衷)

完整SDXL模型重6.9GB,但修剪版本将其减少到4.7GB,同时保持大部分质量优势。

- SDXL Base(修剪): 4.7GB具有完整1024x1024能力

- Juggernaut XL(修剪): 4.7GB专门用于奇幻艺术

- RealStock SDXL(修剪): 4.7GB为摄影优化

内存高效的LoRA策略

LoRA模型以最小的内存开销添加风格和概念控制。每个LoRA仅添加500MB-1GB,使其非常适合低VRAM自定义。

基础模型(3.5GB)+ LoRA(0.5GB)= 4GB总计 vs 大型自定义模型(7GB)= 7GB总计

图像分辨率优化

分辨率对生成期间的VRAM使用影响最大。战略性分辨率选择让你可以在不超过内存限制的情况下创建大图像。

512x512甜点

对于SD 1.5模型,512x512代表质量和内存使用的最佳平衡。

| 分辨率 | VRAM使用 | 生成时间 | 质量 |

|---|---|---|---|

| 512x512 | 1.2GB | 15秒 | 优秀 |

| 768x768 | 2.8GB | 35秒 | 更好细节 |

| 1024x1024 | 5.1GB | 65秒 | SD 1.5困难 |

生成+放大策略

不直接生成大图像,而是在512x512创建然后使用AI工具放大。这种方法使用更少的VRAM,通常产生更优的结果。有关放大方法的更多信息,请阅读我们的AI图像放大比较。

两阶段生成工作流

- 阶段1: 使用有限的VRAM在512x512生成

- 阶段2: 使用Real-ESRGAN或ESRGAN进行2x-4x放大

- 阶段3: 可选的img2img通道用于细节精炼

整个过程的内存使用保持在4GB以下。

CPU模式设置和优化

当VRAM限制变得不可逾越时,CPU模式提供了可行的替代方案。虽然较慢,但现代CPU可以在合理的时间范围内生成图像。

CPU模式性能现实检查

CPU生成需要的时间要长得多,但在任何具有16GB以上RAM的系统上都能可靠工作。

| 硬件 | 512x512时间 | 768x768时间 | 最佳用例 |

|---|---|---|---|

| Intel i7-12700K | 8-12分钟 | 18-25分钟 | 耐心创作 |

| AMD Ryzen 7 5800X | 10-15分钟 | 22-30分钟 | 夜间批处理 |

| M1 Pro Mac | 5-8分钟 | 12-18分钟 | 惊人地好 |

| 旧CPU(i5-8400) | 20-35分钟 | 45-60分钟 | 最后手段 |

优化CPU性能

最大CPU优化: python main.py --cpu --preview-method none --disable-xformers

- 关闭所有其他应用程序: 释放系统资源

- 使用较小模型: SD 1.5模型比SDXL工作得更好

- 减少步骤: 15-20步而不是30-50步以获得可接受的质量

- 夜间生成批次: 为早上排队多个图像

Apple Silicon优势

M1和M2 Mac由于统一内存架构和优化的PyTorch构建,在CPU模式下表现出奇地好。

针对Apple Silicon优化: python main.py --force-fp16 --preview-method auto

统一内存允许M1/M2系统在没有传统VRAM限制的情况下使用16GB以上进行AI生成。

云和远程解决方案

有时低VRAM限制的最佳解决方案是通过云计算完全避免它们。几个选项提供强大的GPU访问,无需硬件投资。

免费云选项

- [Google Colab](https://colab.research.google.com)(免费层): 15GB VRAM Tesla T4,12小时会话限制

- [Kaggle Kernels](https://www.kaggle.com/code): 16GB VRAM P100,30小时/周限制

- [GitHub Codespaces](https://github.com/features/codespaces): 仅2核CPU,总比没有好

付费云服务

对于一致访问,付费服务提供比免费层更好的性能和可靠性。

| 服务 | GPU选项 | 小时成本 | 最适合 |

|---|---|---|---|

| RunPod | RTX 4090, A100 | $0.50-2.00/小时 | 高级用户 |

| Vast.ai | 各种GPU | $0.20-1.50/小时 | 预算意识 |

| Lambda Labs | A100, H100 | $1.10-4.90/小时 | 专业工作 |

| Paperspace | RTX 5000, A6000 | $0.76-2.30/小时 | 一致访问 |

有关详细的RunPod设置说明,请参阅我们的ComfyUI Docker设置指南。

Google Colab设置指南

Colab上的免费ComfyUI(逐步)

- 打开Google Colab

- 使用GPU运行时创建新笔记本(运行时→更改运行时类型→GPU)

- 使用此代码块安装ComfyUI

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- 通过生成的公共URL访问ComfyUI

- 通过Colab界面上传模型或直接下载

硬件升级策略

当优化达到极限时,战略性硬件升级提供最佳长期解决方案。智能购物可以在没有大量投资的情况下显著提高性能。

按预算划分的GPU升级路线图

$200以下二手市场:

- GTX 1080 Ti(11GB) - SD工作流的极佳价值

- RTX 2070 Super(8GB) - 功能和VRAM的良好平衡

- RTX 3060(12GB) - 具有慷慨VRAM的现代架构

$300-500范围:

- RTX 3060 Ti(8GB) - 快速但SDXL的VRAM有限

- RTX 4060 Ti 16GB - 完美适合AI工作负载

- RTX 3070(8GB) - SD 1.5的高性能

$500以上投资:

- RTX 4070 Super(12GB) - AI的当前甜点

- RTX 4070 Ti(12GB) - 更高性能层

- 二手RTX 3080 Ti(12GB) - 如果有的话很有价值

VRAM vs 性能平衡

更多VRAM并不总是意味着更好的性能。选择升级时考虑典型的工作流需求。

| 用例 | 最小VRAM | 推荐GPU | 原因 |

|---|---|---|---|

| 仅SD 1.5 | 6GB | RTX 3060 12GB | 极佳价值 |

| SDXL工作流 | 10GB | RTX 4070 Super | 面向未来 |

| 多个LoRA | 12GB+ | RTX 4070 Ti | 复杂性余地 |

| 专业使用 | 16GB+ | RTX 4080 | 无妥协 |

系统RAM考虑

GPU升级在具有足够系统RAM的情况下效果最佳,用于模型交换和工作流复杂性。

- 16GB系统RAM: 舒适AI工作流的最小值

- 32GB系统RAM: 推荐用于复杂的多模型设置

- 64GB系统RAM: 用于大规模模型的专业层

工作流优化技术

除了硬件限制,工作流设计显著影响内存使用。智能工作流构建可以减少30-50%的VRAM要求。

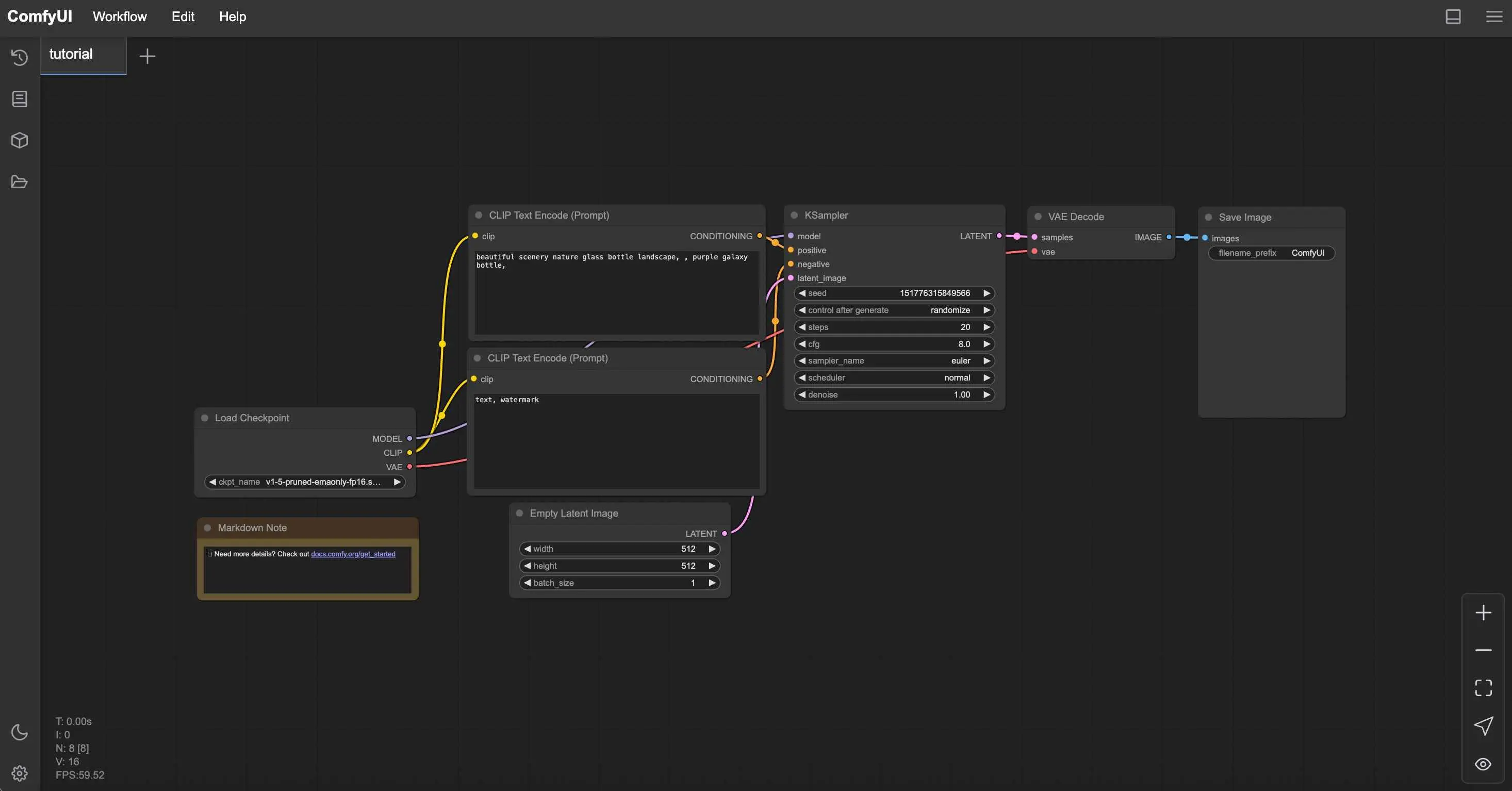

内存高效的节点放置

节点顺序影响生成期间的内存使用。战略性放置减少峰值使用。

创作内容每月赚取$1,250+

加入我们的独家创作者联盟计划。根据病毒视频表现获得报酬。以完全的创作自由按您的风格创作内容。

- 加载模型一次: 避免多个检查点加载节点

- 重用CLIP编码器: 将一个编码器连接到多个节点

- 最小化VAE操作: 仅在必要时解码

- 使用高效采样器: Euler和DPM++使用的内存少于其他

批处理策略

在低VRAM系统上高效生成多个图像需要不同的方法。

不是同时生成10个图像(会崩溃),而是尝试每批生成2-3个图像,并重复批次以实现一致生成而无内存错误。

ComfyUI Manager优化

ComfyUI Manager提供内存优化节点的一键安装。

低VRAM的必备Manager安装

内存管理节点:

- FreeU - 减少生成期间的内存使用

- Model Management - 自动模型卸载

- Efficient Attention - 内存优化的注意力机制

安装步骤:

- 通过Git clone安装ComfyUI Manager

- 重启ComfyUI以激活Manager按钮

- 搜索并安装内存优化节点

- 再次重启以激活新节点

监控和故障排除

了解系统行为有助于优化性能并在崩溃发生之前预防。

内存监控工具

实时跟踪VRAM使用以了解系统限制并相应优化。

Windows用户:

- 任务管理器→性能→GPU进行基本监控

- GPU-Z进行详细VRAM跟踪

- MSI Afterburner进行连续监控

Linux用户: 实时VRAM监控: nvidia-smi -l 1 或 watch -n 1 nvidia-smi

Mac用户: 活动监视器→GPU选项卡或终端监控: sudo powermetrics -n 1 -i 1000 | grep -i gpu

常见错误解决方案

"CUDA out of memory"

- 重启ComfyUI以清除VRAM

- 将图像分辨率降低25%

- 在启动参数中添加--lowvram

"Model loading failed"

- 检查可用系统RAM(模型首先加载到RAM)

- 尝试较小的模型变体

- 关闭其他应用程序

"Generation extremely slow"

- 验证GPU正在被使用(检查nvidia-smi)

- 更新GPU驱动程序

- 检查热节流

性能基准测试

建立基线性能指标以衡量优化效果。

| 测试 | 你的硬件 | 目标时间 | 优化成功 |

|---|---|---|---|

| 512x512 SD 1.5, 20步 | _______ | < 30秒 | 是/否 |

| 768x768 SD 1.5, 20步 | _______ | < 60秒 | 是/否 |

| 1024x1024 SDXL, 30步 | _______ | < 120秒 | 是/否 |

何时选择替代方案

有时最好的优化是认识到ComfyUI不是当前硬件情况的正确工具。

低VRAM用户的Apatero.com优势

- 零硬件要求: 在包括手机在内的任何设备上工作

- 无内存限制: 生成任何分辨率无需担心VRAM

- 高级模型访问: 包括最新的SDXL和自定义模型

- 即时结果: 无需等待20分钟以上的CPU生成

- 专业功能: 高级控制无技术复杂性

- 成本效益: 通常比GPU电费更便宜

混合方法策略

最聪明的方法通常是根据特定需求组合多个解决方案。

使用ComfyUI用于:

- 学习AI生成原理

- 自定义工作流开发

- 离线生成需求

- 当你有足够的硬件时

使用Apatero.com用于:

- 专业客户工作

- 高分辨率图像

- 时间敏感项目

- 实验最新模型

预算AI生成的底线

低VRAM不必结束你的AI艺术之旅。通过适当的优化、战略性硬件选择和智能工作流设计,即使4GB显卡也能产生令人印象深刻的结果。

你的优化行动计划

- 为你的VRAM级别应用适当的启动参数

- 选择SD 1.5模型以获得最大兼容性

- 使用512x512生成与AI放大

- 考虑偶尔高端生成的云解决方案

- 根据实际使用模式计划硬件升级

- 当需要无技术麻烦的结果时尝试[Apatero.com](https://apatero.com)

记住硬件限制通常会激发创造力。一些最具创新性的AI艺术来自学会在限制内工作而不是尽管有限制的艺术家。

无论你选择优化当前设置、升级硬件还是利用像Apatero.com这样的云解决方案,关键是找到让你专注于创作而不是故障排除的方法。

准备好无论硬件如何都生成惊人的AI艺术了吗?Apatero.com消除所有技术障碍,让你立即开始创作。因为最好的AI艺术工具是不妨碍你创作的工具。

准备好创建你的AI网红了吗?

加入115名学生,在我们完整的51节课程中掌握ComfyUI和AI网红营销。

相关文章

2025年ComfyUI新手最常犯的10个错误及解决方法

避免困扰新用户的ComfyUI十大常见陷阱。完整的故障排除指南,包含VRAM错误、模型加载问题的解决方案...

2025年专业用户不愿分享的25个ComfyUI技巧和诀窍

探索25个高级ComfyUI技巧、工作流优化技术和专业级诀窍。涵盖CFG调优、批处理以及质量改进的完整指南。

使用 Anisora v3.2 实现360度动漫旋转:ComfyUI 完整角色旋转指南2025

掌握使用 ComfyUI 中的 Anisora v3.2 进行360度动漫角色旋转。学习相机轨道工作流程、多视图一致性和专业转身动画技术。