VRAMが少ない?問題なし:予算内のハードウェアでComfyUIを実行

限られたGPUメモリでComfyUIを実行するための実用的なガイド。最適化のトリック、CPUフォールバックオプション、クラウド代替案、あらゆる予算に対応したハードウェアアップグレードの推奨事項を学びます。

他の人が簡単に見事なAIアートを生成しているように見える中、「CUDA out of memory」エラーを見つめていますか?このフラストレーションを抱えているのはあなただけではありません。そして解決策は、高価なRTX 4090にアップグレードするよりも簡単かもしれません。このエラーの完全なトラブルシューティングガイドについては、ComfyUI初心者がよくする10の間違いをご覧ください。

このシナリオを想像してください。ComfyUIをダウンロードして、最初の傑作を作成することに興奮していたのに、繰り返しクラッシュするのを見ることになりました。一方、Apatero.comのようなプラットフォームは、ハードウェア要件なしでプロフェッショナルな結果を提供していますが、あなたは現在のセットアップを機能させることに決意しています。

VRAM要件に関する現実チェック

ComfyUIのメモリ使用量は、モデルサイズと画像解像度によって劇的に変化します。これらの要件を理解することで、現実的な期待を設定し、適切な最適化戦略を選択できます。

- Stable Diffusion 1.5: 3.5GBベース + 2GBワークフローオーバーヘッド = 5.5GB最小

- SDXLモデル: 6.9GBベース + 3GBオーバーヘッド = 10GB最小

- ControlNet追加: プリプロセッサに応じて+2-4GB

- 複数のLoRA: LoRAモデルあたり+500MB-1GB

良いニュースは?これらの数字は最悪のシナリオを表しています。スマートな最適化により、要件を40-60%削減でき、わずか4GB VRAMのカードでComfyUIを実行可能にします。

VRAM vs システムRAM vs CPU性能

ほとんどのチュートリアルはGPUメモリのみに焦点を当てていますが、ComfyUIは正しく構成されていれば、処理をインテリジェントにオフロードできます。さまざまなコンポーネントがパフォーマンスにどのように影響するかを以下に示します。

| コンポーネント | 役割 | 速度への影響 | メモリ使用量 |

|---|---|---|---|

| VRAM | アクティブなモデルストレージ | システムRAMの10倍高速 | 最速アクセス |

| システムRAM | モデルスワップバッファ | ストレージの3倍高速 | 中程度のアクセス |

| CPU | フォールバック処理 | GPUの50-100倍遅い | システムRAMを使用 |

| ストレージ | モデルストレージ | ロード中のみ | 永続ストレージ |

低VRAMシステム用の必須起動パラメータ

起動パラメータは、モデルのロードを開始する前にメモリを管理する方法をComfyUIに指示します。これらのフラグは、機能するかクラッシュするかの違いを生む可能性があります。

4GB VRAMカード用(GTX 1650、RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram: アクティブな部分のみをVRAMに保持し、残りをシステムRAMにスワップ

- --preview-method auto: サンプリング中に効率的なプレビュー生成を使用

6GB VRAMカード用(GTX 1060、RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

--force-fp16フラグは、最小限の品質損失でモデルメモリ使用量を半分にカットします。このVRAM範囲に最適です。

8GB VRAMカード用(RTX 3070、RTX 4060)

python main.py --preview-method auto --force-fp16

8GBカードはほとんどのワークフローを処理できますが、複雑なマルチモデルセットアップにはFP16精度の恩恵を受けます。

高度な起動パラメータ

積極的なメモリ管理: python main.py --lowvram --cpu-vae --preview-method none

パイプラインの一部のCPUフォールバック: python main.py --lowvram --cpu-vae --normalvram

最大互換性モード: python main.py --cpu --preview-method none

各追加パラメータは速度を互換性と交換することに注意してください。

限られたVRAM用のモデル選択戦略

すべてのAIモデルがメモリ効率に関して同等に作られているわけではありません。戦略的なモデル選択により、体験を劇的に改善できます。

SD 1.5モデル(メモリチャンピオン)

Stable Diffusion 1.5モデルは3.5GB VRAMのみを必要とし、優れた結果を生成します。低VRAMシステム向けのトップピックには以下のオプションが含まれます。

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper): 3.97GBモデルサイズで多用途のフォトリアリスティックな結果

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1): 3.97GBのポートレート専門家

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality): 3.97GBのバランスの取れたスタイル

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix): 3.76GBのアニメ重視

剪定されたSDXLモデル(最良の妥協)

フルSDXLモデルは6.9GBの重さですが、剪定されたバージョンはほとんどの品質の利点を維持しながら、これを4.7GBに削減します。

- SDXL Base(剪定済み): 4.7GBで完全な1024x1024機能

- Juggernaut XL(剪定済み): 4.7GBでファンタジーアートに特化

- RealStock SDXL(剪定済み): 4.7GBで写真撮影に最適化

メモリ効率的なLoRA戦略

LoRAモデルは、最小限のメモリオーバーヘッドでスタイルとコンセプトコントロールを追加します。各LoRAは500MB-1GBのみを追加するため、低VRAMカスタマイズに最適です。

ベースモデル(3.5GB)+ LoRA(0.5GB)= 4GB合計 vs 大規模カスタムモデル(7GB)= 7GB合計

画像解像度の最適化

解像度は生成中のVRAM使用量に最大の影響を与えます。戦略的な解像度の選択により、メモリ制限を超えることなく大きな画像を作成できます。

512x512スイートスポット

SD 1.5モデルの場合、512x512は品質とメモリ使用量の最適なバランスを表します。

無料のComfyUIワークフロー

この記事のテクニックに関する無料のオープンソースComfyUIワークフローを見つけてください。 オープンソースは強力です。

| 解像度 | VRAM使用量 | 生成時間 | 品質 |

|---|---|---|---|

| 512x512 | 1.2GB | 15秒 | 優秀 |

| 768x768 | 2.8GB | 35秒 | より良い詳細 |

| 1024x1024 | 5.1GB | 65秒 | SD 1.5は苦戦 |

生成+アップスケーリング戦略

大きな画像を直接生成する代わりに、512x512で作成してからAIツールでアップスケールします。このアプローチはより少ないVRAMを使用し、しばしば優れた結果を生み出します。アップスケーリング方法の詳細については、AI画像アップスケーリング比較をお読みください。

2段階生成ワークフロー

- ステージ1: 限られたVRAMで512x512で生成

- ステージ2: 2x-4xアップスケーリングにReal-ESRGANまたはESRGANを使用

- ステージ3: 詳細の洗練のためのオプションのimg2imgパス

メモリ使用量はプロセス全体を通じて4GB未満のままです。

CPUモードのセットアップと最適化

VRAM制限が克服不可能になった場合、CPUモードは実行可能な代替手段を提供します。遅くはありますが、最新のCPUは妥当な時間枠で画像を生成できます。

CPUモードパフォーマンスの現実チェック

CPU生成は大幅に長くかかりますが、16GB以上のRAMを搭載した任意のシステムで確実に機能します。

| ハードウェア | 512x512時間 | 768x768時間 | 最良のユースケース |

|---|---|---|---|

| Intel i7-12700K | 8-12分 | 18-25分 | 忍耐強い作成 |

| AMD Ryzen 7 5800X | 10-15分 | 22-30分 | 夜間バッチ |

| M1 Pro Mac | 5-8分 | 12-18分 | 驚くほど良好 |

| 古いCPU(i5-8400) | 20-35分 | 45-60分 | 最後の手段 |

CPU性能の最適化

最大CPU最適化: python main.py --cpu --preview-method none --disable-xformers

- 他のすべてのアプリケーションを閉じる: システムリソースを解放

- より小さなモデルを使用: SD 1.5モデルはSDXLよりも優れた機能

- ステップを減らす: 許容可能な品質のために30-50の代わりに15-20ステップ

- 夜間にバッチ生成: 朝のために複数の画像をキューに入れる

Apple Siliconの利点

M1とM2 Macは、統一メモリアーキテクチャと最適化されたPyTorchビルドにより、CPUモードで驚くほど良好に機能します。

Apple Silicon用に最適化: python main.py --force-fp16 --preview-method auto

統一メモリにより、M1/M2システムは従来のVRAM制限なしにAI生成に16GB以上を使用できます。

クラウドとリモートソリューション

低VRAM制限に対する最良のソリューションは、クラウドコンピューティングを通じてそれらを完全に回避することです。いくつかのオプションがハードウェア投資なしで強力なGPUアクセスを提供します。

無料のクラウドオプション

- [Google Colab](https://colab.research.google.com)(無料ティア): 15GB VRAM Tesla T4、12時間セッション制限

- [Kaggle Kernels](https://www.kaggle.com/code): 16GB VRAM P100、30時間/週制限

- [GitHub Codespaces](https://github.com/features/codespaces): 2コアCPUのみ、何もないよりまし

有料クラウドサービス

一貫したアクセスのために、有料サービスは無料ティアよりも優れたパフォーマンスと信頼性を提供します。

複雑さをスキップしたいですか? Apatero は、技術的なセットアップなしでプロフェッショナルなAI結果を即座に提供します。

| サービス | GPUオプション | 時間コスト | 最適な用途 |

|---|---|---|---|

| RunPod | RTX 4090、A100 | $0.50-2.00/時 | パワーユーザー |

| Vast.ai | 様々なGPU | $0.20-1.50/時 | 予算重視 |

| Lambda Labs | A100、H100 | $1.10-4.90/時 | プロフェッショナルな仕事 |

| Paperspace | RTX 5000、A6000 | $0.76-2.30/時 | 一貫したアクセス |

詳細なRunPodセットアップ手順については、ComfyUI Dockerセットアップガイドをご覧ください。

Google Colabのセットアップガイド

Colabでの無料ComfyUI(ステップバイステップ)

- Google Colabを開く

- GPUランタイムで新しいノートブックを作成(ランタイム→ランタイムタイプを変更→GPU)

- このコードブロックでComfyUIをインストール

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- 生成された公開URLを介してComfyUIにアクセス

- Colabインターフェースを介してモデルをアップロードするか、直接ダウンロード

ハードウェアアップグレード戦略

最適化が限界に達したとき、戦略的なハードウェアアップグレードは最良の長期ソリューションを提供します。スマートなショッピングは、大規模な投資なしでパフォーマンスを劇的に改善できます。

予算別GPUアップグレードロードマップ

$200未満の中古市場:

- GTX 1080 Ti(11GB) - SDワークフローに優れた価値

- RTX 2070 Super(8GB) - 機能とVRAMの良好なバランス

- RTX 3060(12GB) - 寛大なVRAMを備えた最新アーキテクチャ

$300-500範囲:

- RTX 3060 Ti(8GB) - 高速だがSDXLにはVRAM制限

- RTX 4060 Ti 16GB - AIワークロードに最適

- RTX 3070(8GB) - SD 1.5の高性能

$500以上の投資:

- RTX 4070 Super(12GB) - AIの現在のスイートスポット

- RTX 4070 Ti(12GB) - より高いパフォーマンスティア

- 中古RTX 3080 Ti(12GB) - 利用可能な場合は大きな価値

VRAM vs パフォーマンスバランス

より多くのVRAMが常により良いパフォーマンスを意味するわけではありません。アップグレードを選択する際は、典型的なワークフローのニーズを考慮してください。

| ユースケース | 最小VRAM | 推奨GPU | 理由 |

|---|---|---|---|

| SD 1.5のみ | 6GB | RTX 3060 12GB | 優れた価値 |

| SDXLワークフロー | 10GB | RTX 4070 Super | 将来性 |

| 複数のLoRA | 12GB以上 | RTX 4070 Ti | 複雑さの余裕 |

| プロフェッショナル使用 | 16GB以上 | RTX 4080 | 妥協なし |

システムRAMの考慮事項

GPUアップグレードは、モデルスワッピングとワークフローの複雑さのための適切なシステムRAMで最良に機能します。

- 16GBシステムRAM: 快適なAIワークフローの最小

- 32GBシステムRAM: 複雑なマルチモデルセットアップに推奨

- 64GBシステムRAM: 大規模モデル用のプロフェッショナルティア

ワークフロー最適化技術

ハードウェアの制限を超えて、ワークフロー設計はメモリ使用量に劇的に影響します。スマートなワークフロー構築により、VRAM要件を30-50%削減できます。

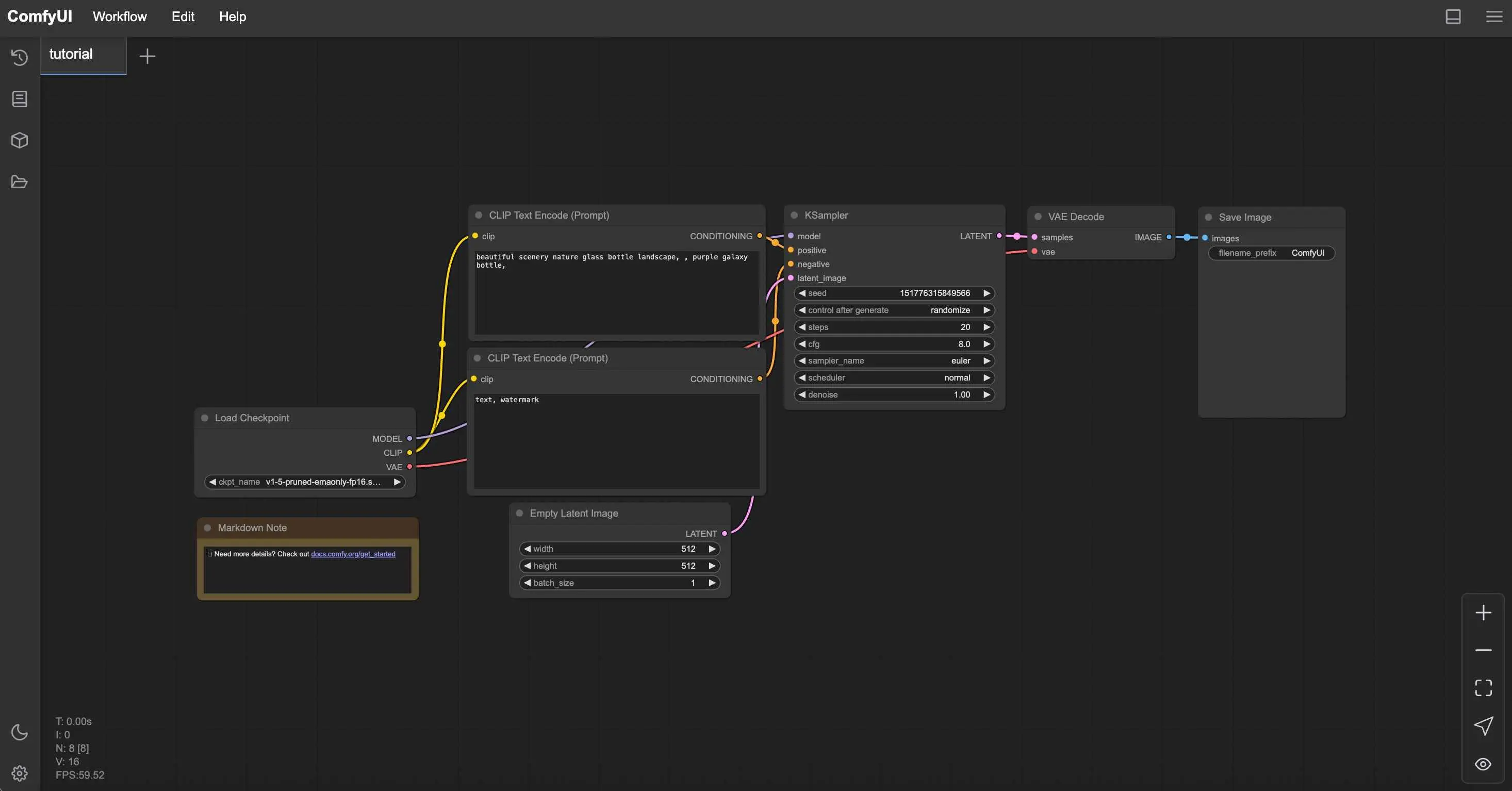

メモリ効率的なノード配置

ノードの順序は生成中のメモリ使用量に影響します。戦略的配置によりピーク使用量が削減されます。

コンテンツ制作で月$1,250以上稼ぐ

独占クリエイターアフィリエイトプログラムに参加。バイラル動画のパフォーマンスに応じて報酬。自分のスタイルで完全な創造的自由を持ってコンテンツを作成。

- モデルを一度ロード: 複数のチェックポイントロードノードを避ける

- CLIPエンコーダーを再利用: 1つのエンコーダーを複数のノードに接続

- VAE操作を最小化: 必要な場合にのみデコード

- 効率的なサンプラーを使用: EulerとDPM++は他よりも少ないメモリを使用

バッチ処理戦略

低VRAMシステムで複数の画像を効率的に生成するには、異なるアプローチが必要です。

10枚の画像を同時に生成する代わりに(クラッシュする)、バッチあたり2-3枚の画像を生成し、メモリエラーなしで一貫した生成のためにバッチを繰り返します。

ComfyUI Manager最適化

ComfyUI Managerは、メモリ最適化ノードのワンクリックインストールを提供します。

低VRAM用の必須Manager インストール

メモリ管理ノード:

- FreeU - 生成中のメモリ使用量を削減

- Model Management - 自動モデルアンロード

- Efficient Attention - メモリ最適化された注意メカニズム

インストール手順:

- Git cloneを介してComfyUI Managerをインストール

- ComfyUIを再起動してManagerボタンを有効化

- メモリ最適化ノードを検索してインストール

- 新しいノードを有効化するために再度再起動

監視とトラブルシューティング

システムの動作を理解することで、パフォーマンスを最適化し、クラッシュが発生する前に防ぐことができます。

メモリ監視ツール

システムの制限を理解し、それに応じて最適化するために、VRAMの使用状況をリアルタイムで追跡します。

Windowsユーザー:

- タスクマネージャー→パフォーマンス→GPUで基本監視

- 詳細なVRAM追跡のためのGPU-Z

- 継続的監視のためのMSI Afterburner

Linuxユーザー: リアルタイムVRAM監視: nvidia-smi -l 1 または watch -n 1 nvidia-smi

Macユーザー: アクティビティモニター→GPUタブまたはターミナル監視: sudo powermetrics -n 1 -i 1000 | grep -i gpu

一般的なエラーの解決策

"CUDA out of memory"

- ComfyUIを再起動してVRAMをクリア

- 画像解像度を25%削減

- 起動パラメータに--lowvramを追加

"Model loading failed"

- 利用可能なシステムRAMを確認(モデルは最初にRAMにロード)

- より小さなモデルバリアントを試す

- 他のアプリケーションを閉じる

"Generation extremely slow"

- GPUが使用されているか確認(nvidia-smiを確認)

- GPUドライバーを更新

- サーマルスロットリングを確認

パフォーマンスベンチマーク

最適化の効果を測定するために、ベースラインパフォーマンスメトリクスを確立します。

| テスト | あなたのハードウェア | 目標時間 | 最適化成功 |

|---|---|---|---|

| 512x512 SD 1.5、20ステップ | _______ | < 30秒 | はい/いいえ |

| 768x768 SD 1.5、20ステップ | _______ | < 60秒 | はい/いいえ |

| 1024x1024 SDXL、30ステップ | _______ | < 120秒 | はい/いいえ |

代替案を選択する時期

時には最良の最適化は、ComfyUIが現在のハードウェア状況に適したツールではないことを認識することです。

低VRAMユーザー向けのApatero.comの利点

- ゼロハードウェア要件: 電話を含むあらゆるデバイスで動作

- メモリ制限なし: VRAMの心配なしに任意の解像度を生成

- プレミアムモデルアクセス: 最新のSDXLとカスタムモデルが含まれる

- 即座の結果: CPU生成で20分以上待つ必要なし

- プロフェッショナル機能: 技術的複雑さなしの高度なコントロール

- コスト効果的: GPU電気代よりも安いことが多い

ハイブリッドアプローチ戦略

最もスマートなアプローチは、特定のニーズに基づいて複数のソリューションを組み合わせることです。

ComfyUIを使用する場合:

- AI生成原則の学習

- カスタムワークフロー開発

- オフライン生成のニーズ

- 適切なハードウェアがある場合

Apatero.comを使用する場合:

- プロフェッショナルなクライアントワーク

- 高解像度画像

- 時間に敏感なプロジェクト

- 最新モデルの実験

予算AI生成の結論

低VRAMはあなたのAIアートの旅を終わらせる必要はありません。適切な最適化、戦略的なハードウェアの選択、スマートなワークフロー設計により、4GBカードでも印象的な結果を生み出すことができます。

あなたの最適化アクションプラン

- VRAMレベルに適した起動パラメータを適用

- 最大互換性のためにSD 1.5モデルを選択

- AIアップスケーリングで512x512生成を使用

- 時折のハイエンド生成にクラウドソリューションを検討

- 実際の使用パターンに基づいてハードウェアアップグレードを計画

- 技術的な煩わしさなしに結果が必要な場合は[Apatero.com](https://apatero.com)を試す

ハードウェアの制限はしばしば創造性を刺激することを忘れないでください。最も革新的なAIアートの一部は、制約にもかかわらずではなく、制約の中で働くことを学んだアーティストから生まれます。

現在のセットアップを最適化するか、ハードウェアをアップグレードするか、Apatero.comのようなクラウドソリューションを活用するかにかかわらず、鍵はトラブルシューティングではなく作成に集中できるアプローチを見つけることです。

ハードウェアに関係なく素晴らしいAIアートを生成する準備はできましたか?Apatero.comはすべての技術的障壁を排除し、すぐに作成を始められます。最高のAIアートツールは、邪魔にならずに創作させてくれるツールだからです。

AIインフルエンサーを作成する準備はできましたか?

115人の学生とともに、51レッスンの完全なコースでComfyUIとAIインフルエンサーマーケティングをマスター。

関連記事

ComfyUI初心者が陥る最も一般的な10の間違いと2025年版の修正方法

新規ユーザーを悩ませるComfyUI初心者の落とし穴トップ10を回避しましょう。VRAMエラー、モデル読み込みなどの完全なトラブルシューティングガイド...

2025年版:プロユーザーが教えたがらないComfyUIの25のテクニックとコツ

エキスパートユーザーが活用している25の高度なComfyUIテクニック、ワークフロー最適化手法、プロレベルのコツを解説します。CFGチューニング、バッチ処理、品質改善の完全ガイド。

Anisora v3.2で360度アニメ回転:ComfyUI完全キャラクター回転ガイド2025

ComfyUIでAnisora v3.2を使用して360度アニメキャラクター回転をマスターしましょう。カメラ軌道ワークフロー、マルチビュー一貫性、プロフェッショナルなターンアラウンドアニメーション技術を学びます。