VRAM Faible ? Pas de Problème : Exécuter ComfyUI sur du Matériel Économique

Guide pratique pour exécuter ComfyUI avec une mémoire GPU limitée. Apprenez les astuces d'optimisation, les options de secours CPU, les alternatives cloud et les recommandations de mise à niveau matérielle pour chaque budget.

Vous fixez des erreurs "CUDA out of memory" pendant que tout le monde semble générer de l'art IA époustouflant sans effort ? Vous n'êtes pas seul dans cette frustration, et la solution pourrait être plus simple que de passer à cette coûteuse RTX 4090. Pour un guide complet de dépannage de cette erreur, consultez nos 10 erreurs courantes de débutants ComfyUI.

Imaginez ce scénario. Vous avez téléchargé ComfyUI, enthousiaste à l'idée de créer votre premier chef-d'œuvre, seulement pour le voir planter à répétition. Pendant ce temps, des plateformes comme Apatero.com livrent des résultats professionnels sans aucune exigence matérielle, mais vous êtes déterminé à faire fonctionner votre configuration actuelle.

La Vérification de Réalité sur les Exigences VRAM

L'utilisation de mémoire de ComfyUI varie considérablement en fonction de la taille du modèle et de la résolution d'image. Comprendre ces exigences vous aide à définir des attentes réalistes et à choisir la bonne stratégie d'optimisation.

- Stable Diffusion 1.5 : 3.5GB base + 2GB pour surcharge workflow = 5.5GB minimum

- Modèles SDXL : 6.9GB base + 3GB surcharge = 10GB minimum

- Ajout ControlNet : +2-4GB selon le préprocesseur

- Multiples LoRAs : +500MB-1GB par modèle LoRA

La bonne nouvelle ? Ces chiffres représentent les pires scénarios. L'optimisation intelligente peut réduire les exigences de 40-60%, rendant ComfyUI viable sur des cartes avec seulement 4GB de VRAM.

VRAM vs RAM Système vs Performance CPU

La plupart des tutoriels se concentrent uniquement sur la mémoire GPU, mais ComfyUI peut intelligemment décharger le traitement lorsqu'il est correctement configuré. Voici comment les différents composants impactent la performance.

| Composant | Rôle | Impact sur Vitesse | Utilisation Mémoire |

|---|---|---|---|

| VRAM | Stockage actif du modèle | 10x plus rapide que RAM système | Accès le plus rapide |

| RAM Système | Tampon d'échange de modèles | 3x plus rapide que stockage | Accès moyen |

| CPU | Traitement de secours | 50-100x plus lent que GPU | Utilise RAM système |

| Stockage | Stockage des modèles | Seulement pendant chargement | Stockage permanent |

Paramètres de Lancement Essentiels pour Systèmes VRAM Faible

Les paramètres de lancement indiquent à ComfyUI comment gérer la mémoire avant qu'il ne commence à charger les modèles. Ces flags peuvent faire la différence entre fonctionner et planter.

Pour Cartes 4GB VRAM (GTX 1650, RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram : Garde seulement les parties actives en VRAM, échange le reste vers RAM système

- --preview-method auto : Utilise génération d'aperçu efficace pendant échantillonnage

Pour Cartes 6GB VRAM (GTX 1060, RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

Le flag --force-fp16 réduit de moitié l'utilisation mémoire du modèle avec perte de qualité minimale, parfait pour cette plage VRAM.

Pour Cartes 8GB VRAM (RTX 3070, RTX 4060)

python main.py --preview-method auto --force-fp16

Les cartes 8GB peuvent gérer la plupart des workflows mais bénéficient de la précision FP16 pour les configurations multi-modèles complexes.

Paramètres de Lancement Avancés

Gestion agressive de mémoire : python main.py --lowvram --cpu-vae --preview-method none

Secours CPU pour parties du pipeline : python main.py --lowvram --cpu-vae --normalvram

Mode compatibilité maximum : python main.py --cpu --preview-method none

Notez que chaque paramètre supplémentaire échange vitesse contre compatibilité.

Stratégie de Sélection de Modèles pour VRAM Limitée

Tous les modèles IA ne sont pas égaux en matière d'efficacité mémoire. La sélection stratégique de modèles peut améliorer considérablement votre expérience.

Modèles SD 1.5 (Champions Mémoire)

Les modèles Stable Diffusion 1.5 nécessitent seulement 3.5GB de VRAM et génèrent d'excellents résultats. Les meilleurs choix pour systèmes VRAM faible incluent les options suivantes.

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper) : Résultats polyvalents et photoréalistes avec taille modèle 3.97GB

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1) : Spécialiste portraits à 3.97GB

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality) : Style équilibré à 3.97GB

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix) : Focalisé anime à 3.76GB

Modèles SDXL Élagués (Meilleur Compromis)

Les modèles SDXL complets pèsent 6.9GB, mais les versions élaguées réduisent cela à 4.7GB tout en maintenant la plupart des avantages qualité.

- SDXL Base (Élagué) : 4.7GB avec capacité complète 1024x1024

- Juggernaut XL (Élagué) : 4.7GB spécialisé pour art fantastique

- RealStock SDXL (Élagué) : 4.7GB optimisé pour photographie

Stratégie LoRA Efficace en Mémoire

Les modèles LoRA ajoutent contrôle de style et concept avec surcharge mémoire minimale. Chaque LoRA ajoute seulement 500MB-1GB, les rendant parfaits pour personnalisation VRAM faible.

Modèle Base (3.5GB) + LoRA (0.5GB) = 4GB total vs Grand Modèle Personnalisé (7GB) = 7GB total

Optimisation de Résolution d'Image

La résolution a le plus grand impact sur l'utilisation VRAM pendant la génération. Les choix stratégiques de résolution vous permettent de créer de grandes images sans dépasser les limites mémoire.

Le Point Optimal 512x512

Pour les modèles SD 1.5, 512x512 représente l'équilibre optimal de qualité et utilisation mémoire.

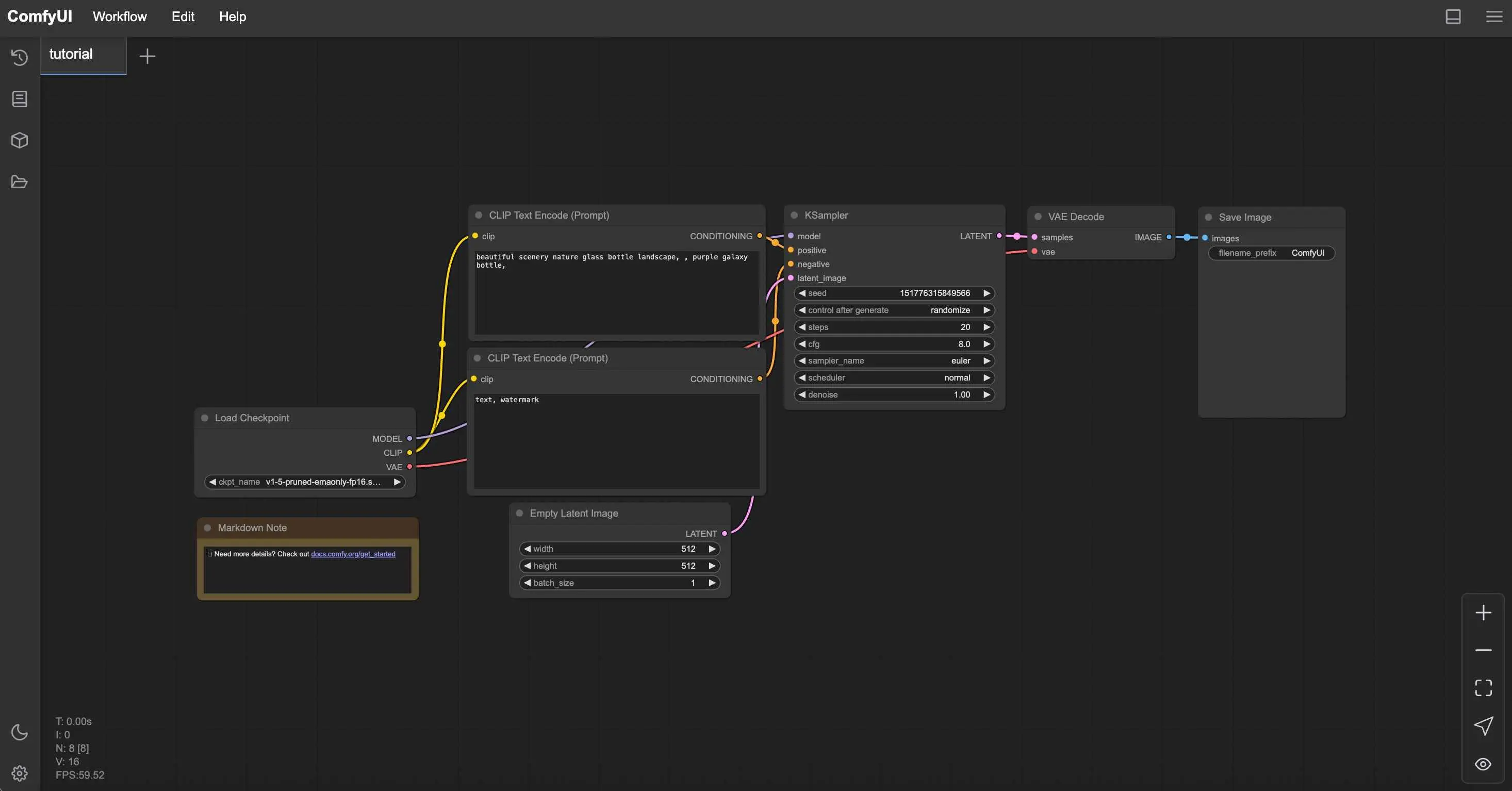

Workflows ComfyUI Gratuits

Trouvez des workflows ComfyUI gratuits et open source pour les techniques de cet article. L'open source est puissant.

| Résolution | Utilisation VRAM | Temps Génération | Qualité |

|---|---|---|---|

| 512x512 | 1.2GB | 15 secondes | Excellent |

| 768x768 | 2.8GB | 35 secondes | Meilleurs détails |

| 1024x1024 | 5.1GB | 65 secondes | SD 1.5 a du mal |

Stratégie Génération Plus Upscaling

Au lieu de générer directement de grandes images, créez à 512x512 puis upscalez avec outils IA. Cette approche utilise moins de VRAM et produit souvent des résultats supérieurs. Pour plus sur les méthodes d'upscaling, lisez notre comparaison d'upscaling d'images IA.

Workflow de Génération en Deux Étapes

- Étape 1 : Générez à 512x512 avec votre VRAM limitée

- Étape 2 : Utilisez Real-ESRGAN ou ESRGAN pour upscaling 2x-4x

- Étape 3 : Passe img2img optionnelle pour raffinement détails

L'utilisation mémoire reste sous 4GB tout au long du processus.

Configuration et Optimisation Mode CPU

Quand les limitations VRAM deviennent insurmontables, le mode CPU offre une alternative viable. Bien que plus lent, les CPUs modernes peuvent générer des images dans des délais raisonnables.

Vérification Réalité Performance Mode CPU

La génération CPU prend significativement plus de temps mais fonctionne de manière fiable sur n'importe quel système avec 16GB+ RAM.

| Matériel | Temps 512x512 | Temps 768x768 | Meilleur Cas d'Usage |

|---|---|---|---|

| Intel i7-12700K | 8-12 minutes | 18-25 minutes | Création patiente |

| AMD Ryzen 7 5800X | 10-15 minutes | 22-30 minutes | Lots nocturnes |

| M1 Pro Mac | 5-8 minutes | 12-18 minutes | Étonnamment bon |

| CPUs Anciens (i5-8400) | 20-35 minutes | 45-60 minutes | Dernier recours |

Optimisation Performance CPU

Optimisation CPU maximale : python main.py --cpu --preview-method none --disable-xformers

- Fermez toutes les autres applications : Libérez ressources système

- Utilisez modèles plus petits : Les modèles SD 1.5 fonctionnent mieux que SDXL

- Réduisez étapes : 15-20 étapes au lieu de 30-50 pour qualité acceptable

- Générez lots durant la nuit : Mettez en file plusieurs images pour le matin

Avantage Apple Silicon

Les Macs M1 et M2 fonctionnent étonnamment bien en mode CPU grâce à l'architecture mémoire unifiée et aux builds PyTorch optimisés.

Optimisé pour Apple Silicon : python main.py --force-fp16 --preview-method auto

La mémoire unifiée permet aux systèmes M1/M2 d'utiliser 16GB+ pour génération IA sans limitations VRAM traditionnelles.

Solutions Cloud et Distantes

Parfois la meilleure solution pour limitations VRAM faible est de les éviter entièrement via cloud computing. Plusieurs options fournissent accès GPU puissant sans investissement matériel.

Options Cloud Gratuites

- [Google Colab](https://colab.research.google.com) (Niveau Gratuit) : Tesla T4 15GB VRAM, limite session 12 heures

- [Kaggle Kernels](https://www.kaggle.com/code) : P100 16GB VRAM, limite 30 heures/semaine

- [GitHub Codespaces](https://github.com/features/codespaces) : CPU 2-cœurs seulement, mieux que rien

Services Cloud Payants

Pour accès cohérent, les services payants offrent meilleure performance et fiabilité que niveaux gratuits.

Envie d'éviter la complexité? Apatero vous offre des résultats IA professionnels instantanément sans configuration technique.

| Service | Options GPU | Coût Horaire | Meilleur Pour |

|---|---|---|---|

| RunPod | RTX 4090, A100 | $0.50-2.00/hr | Utilisateurs avancés |

| Vast.ai | Diverses GPUs | $0.20-1.50/hr | Conscients budget |

| Lambda Labs | A100, H100 | $1.10-4.90/hr | Travail professionnel |

| Paperspace | RTX 5000, A6000 | $0.76-2.30/hr | Accès cohérent |

Pour instructions détaillées configuration RunPod, consultez notre guide configuration Docker ComfyUI.

Guide Configuration pour Google Colab

ComfyUI Gratuit sur Colab (Étape par Étape)

- Ouvrez Google Colab

- Créez nouveau notebook avec runtime GPU (Runtime → Changer type runtime → GPU)

- Installez ComfyUI avec ce bloc code

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- Accédez ComfyUI via URL publique générée

- Téléchargez modèles via interface Colab ou téléchargez directement

Stratégies Mise à Niveau Matériel

Quand l'optimisation atteint ses limites, les mises à niveau matérielles stratégiques fournissent la meilleure solution long terme. Les achats intelligents peuvent améliorer considérablement performance sans investissement massif.

Feuille Route Mise à Niveau GPU par Budget

Moins de $200 Marché Occasion :

- GTX 1080 Ti (11GB) - Excellente valeur pour workflows SD

- RTX 2070 Super (8GB) - Bon équilibre fonctionnalités et VRAM

- RTX 3060 (12GB) - Architecture moderne avec VRAM généreuse

Gamme $300-500 :

- RTX 3060 Ti (8GB) - Rapide mais VRAM limitée pour SDXL

- RTX 4060 Ti 16GB - Parfaite pour charges travail IA

- RTX 3070 (8GB) - Haute performance pour SD 1.5

Investissement $500+ :

- RTX 4070 Super (12GB) - Point optimal actuel pour IA

- RTX 4070 Ti (12GB) - Niveau performance supérieur

- RTX 3080 Ti Occasion (12GB) - Grande valeur si disponible

Équilibre VRAM vs Performance

Plus de VRAM ne signifie pas toujours meilleure performance. Considérez besoins typiques workflow lors choix mises à niveau.

| Cas d'Usage | VRAM Minimum | GPU Recommandée | Pourquoi |

|---|---|---|---|

| SD 1.5 Seulement | 6GB | RTX 3060 12GB | Excellente valeur |

| Workflows SDXL | 10GB | RTX 4070 Super | Pérenne |

| Multiples LoRAs | 12GB+ | RTX 4070 Ti | Marge pour complexité |

| Usage Professionnel | 16GB+ | RTX 4080 | Aucun compromis |

Considérations RAM Système

Les mises à niveau GPU fonctionnent mieux avec RAM système adéquate pour échange modèles et complexité workflow.

- 16GB RAM Système : Minimum pour workflows IA confortables

- 32GB RAM Système : Recommandé pour configurations multi-modèles complexes

- 64GB RAM Système : Niveau professionnel pour modèles massifs

Techniques Optimisation Workflow

Au-delà limitations matérielles, conception workflow impacte considérablement utilisation mémoire. Construction intelligente workflow peut réduire exigences VRAM de 30-50%.

Placement Nœuds Efficace Mémoire

L'ordre nœuds affecte utilisation mémoire durant génération. Placement stratégique réduit usage pic.

Gagnez Jusqu'à 1 250 $+/Mois en Créant du Contenu

Rejoignez notre programme exclusif d'affiliés créateurs. Soyez payé par vidéo virale selon la performance. Créez du contenu à votre style avec une totale liberté créative.

- Chargez modèles une fois : Évitez multiples nœuds chargement checkpoint

- Réutilisez encodeurs CLIP : Connectez un encodeur à multiples nœuds

- Minimisez opérations VAE : Décodez seulement quand nécessaire

- Utilisez samplers efficaces : Euler et DPM++ utilisent moins mémoire que autres

Stratégies Traitement par Lots

Générer multiples images efficacement nécessite approches différentes sur systèmes VRAM faible.

Au lieu de générer 10 images simultanément (qui plante), essayez générer 2-3 images par lot et répétez lots pour génération cohérente sans erreurs mémoire.

Optimisation ComfyUI Manager

ComfyUI Manager fournit installation un-clic pour nœuds optimisation mémoire.

Installations Essentielles Manager pour VRAM Faible

Nœuds Gestion Mémoire :

- FreeU - Réduit utilisation mémoire pendant génération

- Model Management - Déchargement automatique modèles

- Efficient Attention - Mécanismes attention optimisés mémoire

Étapes Installation :

- Installez ComfyUI Manager via Git clone

- Redémarrez ComfyUI pour activer bouton Manager

- Recherchez et installez nœuds optimisation mémoire

- Redémarrez à nouveau pour activer nouveaux nœuds

Surveillance et Dépannage

Comprendre comportement système aide optimiser performance et prévenir plantages avant qu'ils arrivent.

Outils Surveillance Mémoire

Suivez utilisation VRAM en temps réel pour comprendre limites système et optimiser en conséquence.

Utilisateurs Windows :

- Gestionnaire Tâches → Performance → GPU pour surveillance basique

- GPU-Z pour suivi VRAM détaillé

- MSI Afterburner pour surveillance continue

Utilisateurs Linux : Surveillance VRAM temps réel : nvidia-smi -l 1 ou watch -n 1 nvidia-smi

Utilisateurs Mac : Moniteur Activité → onglet GPU ou surveillance terminal : sudo powermetrics -n 1 -i 1000 | grep -i gpu

Solutions Erreurs Courantes

"CUDA out of memory"

- Redémarrez ComfyUI pour vider VRAM

- Réduisez résolution image de 25%

- Ajoutez --lowvram aux paramètres lancement

"Model loading failed"

- Vérifiez RAM système disponible (modèles chargent en RAM d'abord)

- Essayez variantes modèles plus petites

- Fermez autres applications

"Generation extremely slow"

- Vérifiez GPU est utilisée (vérifiez nvidia-smi)

- Mettez à jour pilotes GPU

- Vérifiez limitation thermique

Benchmarking Performance

Établissez métriques performance référence pour mesurer efficacité optimisation.

| Test | Votre Matériel | Temps Cible | Succès Optimisation |

|---|---|---|---|

| 512x512 SD 1.5, 20 étapes | _______ | < 30 secondes | Oui/Non |

| 768x768 SD 1.5, 20 étapes | _______ | < 60 secondes | Oui/Non |

| 1024x1024 SDXL, 30 étapes | _______ | < 120 secondes | Oui/Non |

Quand Choisir Alternatives

Parfois meilleure optimisation est reconnaître quand ComfyUI n'est pas bon outil pour situation matérielle actuelle.

Avantages Apatero.com pour Utilisateurs VRAM Faible

- Zéro Exigences Matérielles : Fonctionne sur n'importe quel appareil y compris téléphones

- Pas de Limitations Mémoire : Générez n'importe quelle résolution sans soucis VRAM

- Accès Modèles Premium : Derniers modèles SDXL et personnalisés inclus

- Résultats Instantanés : Pas d'attente 20+ minutes pour génération CPU

- Fonctionnalités Professionnelles : Contrôles avancés sans complexité technique

- Rentable : Souvent moins cher que coûts électricité GPU

Stratégie Approche Hybride

L'approche la plus intelligente combine souvent multiples solutions basées sur besoins spécifiques.

Utilisez ComfyUI Pour :

- Apprendre principes génération IA

- Développement workflows personnalisés

- Besoins génération hors ligne

- Quand vous avez matériel adéquat

Utilisez Apatero.com Pour :

- Travail professionnel clients

- Images haute résolution

- Projets sensibles temps

- Expérimenter derniers modèles

La Conclusion sur Génération IA Budget

VRAM faible ne doit pas mettre fin à votre voyage art IA. Avec optimisation appropriée, choix matériels stratégiques et conception intelligente workflow, même cartes 4GB peuvent produire résultats impressionnants.

Votre Plan Action Optimisation

- Appliquez paramètres lancement appropriés pour votre niveau VRAM

- Choisissez modèles SD 1.5 pour compatibilité maximale

- Utilisez génération 512x512 avec upscaling IA

- Considérez solutions cloud pour génération occasionnelle haut de gamme

- Planifiez mises à niveau matériel basées sur vos schémas usage réels

- Essayez [Apatero.com](https://apatero.com) quand vous avez besoin résultats sans tracas technique

Rappelez-vous que limitations matérielles suscitent souvent créativité. Une partie art IA le plus innovant vient d'artistes qui ont appris travailler dans contraintes plutôt que malgré elles.

Que vous choisissiez optimiser configuration actuelle, mettre à niveau matériel, ou tirer parti solutions cloud comme Apatero.com, la clé est trouver approche qui vous permet concentrer sur créer plutôt que dépanner.

Prêt à commencer générer art IA incroyable indépendamment de votre matériel ? Apatero.com élimine toutes barrières techniques et vous met à créer immédiatement. Parce que meilleur outil art IA est celui qui s'efface et vous laisse créer.

Prêt à Créer Votre Influenceur IA?

Rejoignez 115 étudiants maîtrisant ComfyUI et le marketing d'influenceurs IA dans notre cours complet de 51 leçons.

Articles Connexes

Les 10 Erreurs ComfyUI les Plus Courantes chez les Débutants et Comment les Résoudre en 2025

Évitez les 10 principaux pièges ComfyUI qui frustrent les nouveaux utilisateurs. Guide de dépannage complet avec des solutions pour les erreurs VRAM, le chargement des modèles...

25 Astuces et Conseils ComfyUI que les Utilisateurs Professionnels ne Veulent pas que Vous Connaissiez en 2025

Découvrez 25 astuces ComfyUI avancées, des techniques d'optimisation de flux de travail et des astuces de niveau professionnel que les utilisateurs experts exploitent. Guide complet sur le réglage CFG, le traitement par lots et les améliorations de qualité.

Rotation Anime 360 avec Anisora v3.2 : Guide Complet de Rotation de Personnage ComfyUI 2025

Maîtrisez la rotation de personnages anime à 360 degrés avec Anisora v3.2 dans ComfyUI. Apprenez les workflows d'orbite de caméra, la cohérence multi-vues et les techniques d'animation turnaround professionnelles.