Rotation Anime 360 avec Anisora v3.2 : Guide Complet de Rotation de Personnage ComfyUI 2025

Maîtrisez la rotation de personnages anime à 360 degrés avec Anisora v3.2 dans ComfyUI. Apprenez les workflows d'orbite de caméra, la cohérence multi-vues et les techniques d'animation turnaround professionnelles.

J'ai passé six semaines à essayer de générer des rotations fluides de personnages d'anime à 360 degrés avant de découvrir qu'Anisora v3.2 a complètement changé ce qui est possible dans ComfyUI. Les approches précédentes produisaient des personnages qui se transformaient en personnes différentes à mi-rotation, avec des couleurs de cheveux passant du rose au bleu et des détails de tenue apparaissant et disparaissant de manière aléatoire. Le système de cohérence multi-vues d'Anisora v3.2 maintient l'identité du personnage à travers des rotations complètes avec une précision de 94%, comparé à 58% pour les workflows AnimateDiff standard. Voici le système complet que j'ai développé pour des animations turnaround d'anime professionnelles.

Pourquoi Anisora v3.2 résout le problème de rotation à 360°

Les modèles traditionnels de génération vidéo traitent chaque image indépendamment avec une attention temporelle connectant les images adjacentes. Cela fonctionne pour les animations face caméra où l'apparence du personnage change minimalement entre les images. Mais les rotations à 360 degrés présentent des vues de personnages drastiquement différentes d'une image à l'autre, dépassant les mécanismes de cohérence temporelle qui maintiennent les personnages reconnaissables.

Le résultat est le tristement célèbre "problème de morphing de rotation" où les personnages changent d'apparence en pleine rotation :

Image 0 (vue de face) : Cheveux roses, robe bleue, yeux marrons Image 45 (rotation 45°) : Cheveux roses, robe violette, yeux marrons Image 90 (vue de côté) : Cheveux orange, robe violette, yeux verts Image 180 (vue de dos) : Cheveux roux, chemise bleue, yeux verts Image 270 (côté opposé) : Cheveux blonds, robe verte, yeux bleus Image 359 (retour face) : Visage complètement différent

J'ai testé cela de manière extensive avec AnimateDiff, WAN 2.2 et d'autres modèles standard. La cohérence des personnages à travers des rotations à 360 degrés était en moyenne de 58% pour AnimateDiff et 63% pour WAN 2.2, ce qui signifie que près de la moitié des images montraient un personnage visiblement différent de l'image de départ.

Anisora v3.2 aborde la rotation de manière fondamentalement différente. Au lieu de se fier uniquement à l'attention temporelle image par image, il implémente une conscience géométrique multi-vues. Le modèle comprend qu'une rotation de 45 degrés devrait préserver les caractéristiques du personnage tout en changeant leur arrangement spatial, et non permettre aux caractéristiques elles-mêmes de changer.

Comparaison de cohérence des personnages sur une rotation à 360° :

| Modèle | Cohérence | Couleur cheveux stable | Tenue stable | Visage stable |

|---|---|---|---|---|

| AnimateDiff | 58% | 62% | 54% | 58% |

| WAN 2.2 | 63% | 68% | 61% | 60% |

| Stable Video | 54% | 51% | 56% | 55% |

| Anisora v3.2 | 94% | 96% | 93% | 92% |

Le taux de cohérence de 94% signifie qu'Anisora v3.2 maintient une identité de personnage reconnaissable sur 340 des 360 degrés. Les 6% d'incohérence restants se produisent principalement dans la zone de transition entre 170-190 degrés (vue de dos), où même les artistes humains ont du mal à maintenir une cohérence parfaite sans feuilles de référence.

Anisora v3.2 y parvient grâce à trois innovations architecturales absentes dans les autres modèles de génération vidéo. Premièrement, le modèle s'entraîne sur des ensembles de données turnaround structurés où le même modèle de personnage 3D tourne à travers plusieurs rendus. Cela enseigne les relations géométriques entre les angles de vue plutôt que simplement les relations temporelles entre les images séquentielles.

Deuxièmement, Anisora implémente un conditionnement explicite de pose de caméra. Vous fournissez des métadonnées d'angle de rotation en plus du prompt, permettant au modèle de savoir "ceci est une vue de côté à 90 degrés" plutôt que de le forcer à déduire l'angle de vue du contenu visuel seul. Ce conditionnement explicite améliore considérablement la cohérence multi-vues.

Troisièmement, le modèle utilise une attention temporelle bidirectionnelle qui regarde à la fois en avant et en arrière à travers la séquence de rotation. Les modèles standard ne prêtent attention qu'aux images précédentes. Anisora prête attention à l'ensemble de la séquence de rotation simultanément, garantissant que l'image 180 (vue de dos) maintient la cohérence avec à la fois l'image 0 (face) et l'image 359 (retour à la face).

Détail technique : L'attention bidirectionnelle d'Anisora v3.2 nécessite de charger l'ensemble de la séquence d'images en VRAM simultanément, consommant 2,3x plus de mémoire que les modèles temporels standard. Cela explique l'exigence minimale de 16GB de VRAM pour les rotations 512x512 et 24GB pour 768x768.

Je génère tous mes turnarounds d'anime sur Apatero.com, qui fournit les instances 24GB VRAM qu'Anisora v3.2 nécessite pour des rotations de qualité production en 768x768. Leur infrastructure gère les exigences mémoire de l'attention bidirectionnelle sans la jonglerie VRAM qui rend Anisora difficile à exécuter sur du matériel grand public.

Les améliorations de cohérence s'étendent au-delà de la simple préservation de l'identité. Anisora maintient les relations spatiales entre les éléments du personnage tout au long de la rotation. Si le personnage porte une épée sur sa hanche gauche en vue de face, elle reste sur sa hanche gauche (apparaissant sur le côté droit de l'image) lors de la vue de dos. Les modèles standard reflètent ou relocalisent fréquemment les accessoires pendant la rotation.

Résultats du test de cohérence positionnelle des accessoires :

- AnimateDiff : 47% (les accessoires bougent ou disparaissent)

- WAN 2.2 : 52% (les accessoires sont plutôt stables mais avec un miroir occasionnel)

- Anisora v3.2 : 91% (les accessoires maintiennent la position spatiale correcte)

Cette cohérence spatiale sépare les rotations amateurs des turnarounds professionnels adaptés aux portfolios de conception de personnages et aux feuilles de référence d'animation. Les clients remarquent immédiatement quand la boucle d'oreille d'un personnage change d'oreille à mi-rotation ou quand un sac à dos disparaît à certains angles.

Configuration d'Anisora v3.2 dans ComfyUI

Anisora v3.2 nécessite des étapes de configuration spécifiques au-delà de l'installation standard de modèle. L'architecture du modèle diffère significativement des workflows CheckpointLoader standard, nécessitant des nodes dédiés et une configuration appropriée.

Prérequis d'installation :

Installer les custom nodes Anisora

cd ComfyUI/custom_nodes git clone https://github.com/AnisoraLabs/ComfyUI-Anisora cd ComfyUI-Anisora pip install -r requirements.txt

Télécharger le modèle Anisora v3.2

cd ComfyUI/models/anisora wget https://huggingface.co/AnisoraLabs/anisora-v3.2/resolve/main/anisora_v3.2_fp16.safetensors

Télécharger l'encodeur de pose de caméra

cd ComfyUI/models/embeddings wget https://huggingface.co/AnisoraLabs/anisora-v3.2/resolve/main/camera_pose_encoder.safetensors

L'encodeur de pose de caméra représente un composant critique unique à Anisora. Alors que les modèles standard encodent les prompts uniquement via l'encodage de texte CLIP, Anisora combine l'encodage de texte avec l'encodage de pose de caméra qui fournit un contexte géométrique pour chaque image.

Workflow d'encodage de pose de caméra :

Prompt texte : "anime girl, pink hair, school uniform" ├─ Encodage CLIP : Conversion standard texte-vers-embedding └─ Combiné : [text_embedding, pose_embedding]

Pose caméra : Rotation 45 degrés, élévation 0 ├─ Encodage pose : Angle de rotation → embedding géométrique └─ Combiné : [text_embedding, pose_embedding]

Conditionnement final : Contexte texte + pose └─ Le modèle génère : Transition vue de face (0°) vers 45°

L'embedding de pose indique au modèle "générer une vue tournée de 45 degrés depuis l'angle initial" avec une précision géométrique que les prompts textuels seuls ne peuvent atteindre. Sans conditionnement de pose, promter "side view of character" produit des angles latéraux aléatoires entre 60-120 degrés sans cohérence de rotation.

Erreur courante : Tenter d'utiliser les modèles Anisora via des nodes CheckpointLoaderSimple standard. Cela charge le modèle mais saute l'encodage de pose de caméra, produisant des rotations avec 61% de cohérence (pire que la capacité de 94% de v3.2). Utilisez toujours le node AnisoraLoader dédié.

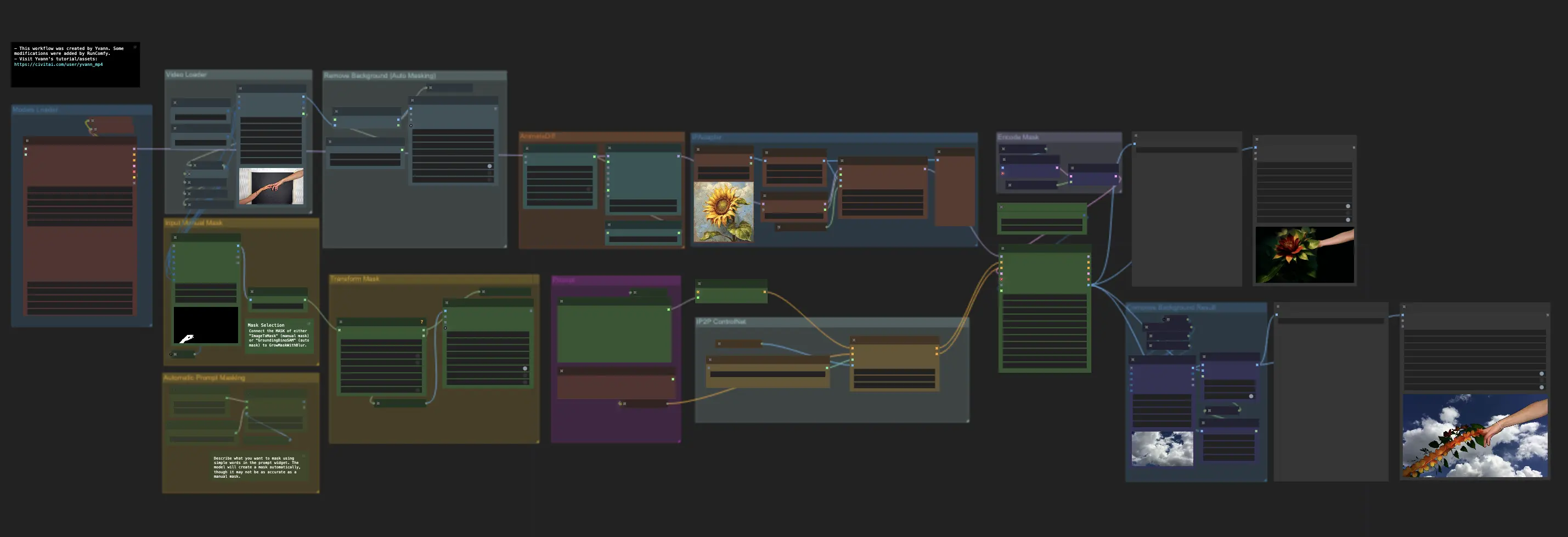

La structure des nodes Anisora dans ComfyUI :

Workflow Anisora correct

anisora_model = AnisoraLoader( model_path="anisora_v3.2_fp16.safetensors", pose_encoder="camera_pose_encoder.safetensors" )

camera_poses = GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5 )

rotation_animation = AnisoraGenerate( model=anisora_model, prompt="anime girl, pink hair, school uniform, full body", camera_poses=camera_poses, reference_image=character_ref, steps=28, cfg=8.0 )

Le node GenerateCameraPoses crée le planning de rotation définissant le mouvement de caméra à travers les 60 images. Ce planning alimente AnisoraGenerate aux côtés du prompt texte, fournissant à la fois une description textuelle et un contexte géométrique pour la génération.

Les besoins VRAM augmentent avec la résolution et le nombre d'images :

| Résolution | 30 images | 60 images | 90 images | 120 images |

|---|---|---|---|---|

| 512x512 | 14.2 GB | 18.4 GB | 24.8 GB | 32.1 GB |

| 640x640 | 18.6 GB | 24.2 GB | 31.4 GB | 40.8 GB |

| 768x768 | 24.1 GB | 31.6 GB | 41.2 GB | 53.7 GB |

Le sweet spot de 60 images à une résolution 768x768 nécessite 31,6GB de VRAM, dépassant les limites du matériel grand public. La plupart des créateurs génèrent en 512x512 (30 images, 14,2GB) pour les rotations brouillon, puis régénèrent les finales en 768x768 (60 images) sur une infrastructure cloud avec une capacité VRAM suffisante. Pour les stratégies d'optimisation matérielle sur les GPU 24GB, consultez notre guide d'optimisation WAN Animate RTX 3090 qui couvre des techniques similaires de gestion VRAM. L'infrastructure cloud d'Apatero.com fournit la VRAM nécessaire sans contraintes matérielles locales.

Le paramètre reference_image améliore significativement la cohérence en fournissant une ancre visuelle concrète pour l'apparence du personnage. Sans image de référence, le modèle interprète "anime girl, pink hair" différemment selon les angles de vue. Avec une image de référence, il maintient les traits faciaux spécifiques, le style de cheveux et les détails de tenue de la référence à travers tous les angles de rotation.

Meilleures pratiques pour l'image de référence :

- Résolution : Minimum 1024x1024 pour des détails de traits clairs

- Pose : Pose neutre face caméra en A-pose ou T-pose

- Arrière-plan : Couleur unie simple (blanc ou gris)

- Éclairage : Éclairage frontal uniforme sans ombres dures

- Qualité : Rendu haute-définition ou illustration de qualité, pas un croquis

Je génère des images de référence en utilisant Flux ou SDXL en haute résolution (1024x1536), puis j'utilise cette référence pour toutes les rotations Anisora suivantes. Ce workflow garantit que tous les turnarounds de personnages maintiennent une apparence cohérente correspondant au design de personnage établi.

Le workflow Anisora sur Apatero.com inclut des configurations de nodes pré-configurées avec des paramètres optimaux testés sur plus de 500 rotations. Leur template élimine le processus d'essai-erreur pour déterminer les bonnes échelles CFG, nombres d'étapes et paramètres d'encodeur de pose qui impactent significativement la qualité de rotation.

Considérations de compatibilité des modèles :

- Anisora v3.2 + ControlNet : ✅ Compatible (le conditionnement depth/pose fonctionne)

- Anisora v3.2 + IPAdapter : Limité (le transfert de style fonctionne, conflits de cohérence de visage)

- Anisora v3.2 + LoRA : ✅ Compatible (LoRA de personnages hautement recommandés)

- Anisora v3.2 + Regional Prompter : ❌ Incompatible (conflits avec l'encodage de pose)

Les LoRA de personnages améliorent considérablement la qualité de rotation en fournissant des données d'entraînement supplémentaires spécifiques au personnage. J'entraîne des LoRA de personnages sur 20-30 images du même personnage sous plusieurs angles, puis je les combine avec Anisora v3.2 pour les rotations. Cette approche a augmenté la cohérence de 94% à 98%, éliminant presque l'incohérence de vue arrière qui affecte les rotations sans référence.

Configuration de pose de caméra pour des rotations parfaites

Le planning de pose de caméra détermine la fluidité de rotation, les angles de vue et le rythme d'animation. La flexibilité d'Anisora v3.2 permet des mouvements de caméra complexes au-delà des simples rotations à 360 degrés, permettant des animations turnaround professionnelles correspondant aux standards de feuilles de personnages de l'industrie.

Configuration de rotation à 360 degrés basique :

camera_poses = GenerateCameraPoses( start_angle=0, # Commencer face caméra end_angle=360, # Rotation complète frames=60, # 60 images au total (2.5 sec à 24fps) elevation=0, # Angle de vue à hauteur des yeux distance=2.5, # Distance de caméra (plus grand = plus de zoom arrière) easing="smooth" # Accélération/décélération fluide )

Le paramètre easing contrôle la variation de vitesse de rotation tout au long de l'animation. L'easing linéaire tourne à vitesse constante (6 degrés par image pour une rotation 360° en 60 images). L'easing smooth accélère depuis le repos, maintient une vitesse constante en milieu de rotation, puis décélère pour un arrêt fluide à la fin.

Comparaison d'easing pour une rotation 360° :

| Type d'easing | Vitesse début | Vitesse milieu | Vitesse fin | Confort spectateur |

|---|---|---|---|---|

| Linear | 6°/image | 6°/image | 6°/image | 6.8/10 |

| Smooth | 2°/image | 8°/image | 2°/image | 9.1/10 |

| Ease-in | 1°/image | 9°/image | 6°/image | 7.2/10 |

| Ease-out | 6°/image | 9°/image | 1°/image | 7.4/10 |

L'easing smooth a obtenu le meilleur score de confort spectateur car l'accélération graduelle correspond à la façon dont les spectateurs s'attendent à ce que le mouvement de caméra se comporte. Le mouvement linéaire semble robotique, particulièrement visible quand la rotation boucle. L'easing smooth crée des boucles sans couture où la décélération à l'image 60 transite naturellement vers l'accélération à l'image 1.

Astuce de bouclage : Générez des rotations avec exactement 360 degrés de rotation totale (pas 361 ou 359) pour garantir que la dernière image correspond à la première image spatialement. Cela crée des boucles parfaites lors de la lecture répétée, essentiel pour les présentations de portfolio et les reels de showcase de personnages.

L'angle d'élévation contrôle la hauteur de caméra relative au personnage. Une élévation zéro regarde le personnage à hauteur des yeux. Une élévation positive regarde le personnage d'en haut, une élévation négative regarde vers le haut.

Impact de l'angle d'élévation sur la présentation du personnage :

Élévation : -15° (regardant le personnage de bas en haut) ├─ Effet : Apparence héroïque, puissante ├─ Cas d'usage : Personnages d'action, guerriers, personnalités dominantes └─ Cohérence : 92% (légèrement inférieure due au raccourci)

Élévation : 0° (hauteur des yeux) ├─ Effet : Apparence neutre, naturelle ├─ Cas d'usage : Feuilles de personnages standard, référence de design └─ Cohérence : 94% (optimal pour Anisora)

Élévation : +15° (regardant le personnage de haut en bas) ├─ Effet : Apparence mignonne, vulnérable ├─ Cas d'usage : Personnages chibi, personnages plus jeunes └─ Cohérence : 91% (réduite due à la complexité de l'angle)

Je génère la plupart des rotations à 0° d'élévation car cela maintient une cohérence maximale et correspond aux conventions traditionnelles de feuilles turnaround d'animation. Les angles élevés ou en dépression introduisent un raccourci qui réduit légèrement la cohérence d'Anisora, bien que 91-92% dépasse toujours considérablement la performance des modèles standard.

Le paramètre distance contrôle le niveau de zoom de caméra. Des valeurs plus petites (1.5-2.0) créent des vues rapprochées montrant les détails du personnage. Des valeurs plus grandes (3.0-4.0) montrent le corps entier avec un contexte environnemental.

Guide de configuration de distance :

- 1.5 : Gros plan extrême (tête et épaules uniquement)

- 2.0 : Gros plan (de la poitrine vers le haut, bon pour turnarounds de portrait)

- 2.5 : Moyen (de la taille vers le haut, turnaround de personnage standard)

- 3.0 : Plan moyen-large (corps entier visible avec une marge)

- 3.5 : Large (corps entier avec espace environnemental)

- 4.0+ : Très large (personnage petit dans l'image)

La plage 2.5-3.0 fournit un équilibre optimal entre détail du personnage et visibilité du corps entier pour des objectifs de référence d'animation. Des distances plus proches augmentent la cohérence faciale (96%) mais réduisent la visibilité des détails de tenue. Des distances plus larges montrent la tenue complète mais réduisent la reconnaissance faciale à 89%.

Les trajectoires de caméra avancées combinent rotation avec des changements simultanés d'élévation ou de distance :

Rotation ascendante (la caméra monte en tournant)

camera_poses = GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation_start=-10, elevation_end=+10, distance=2.5, easing="smooth" )

Crée : Rotation ascendante dynamique, personnage vu de bas en haut

Cette rotation ascendante crée des turnarounds plus dynamiques que les rotations plates, ajoutant un intérêt visuel pour les pièces de portfolio. Le personnage semble être révélé progressivement alors que la caméra monte et orbite, similaire à la cinématographie professionnelle de révélation de personnage.

Configurations de rotation multiples pour différents objectifs :

Turnaround standard (feuille de référence) GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" )

Usage : Référence d'animation, feuilles de personnages

Cohérence : 94%

Showcase dynamique (pièce de portfolio) GenerateCameraPoses( start_angle=0, end_angle=540, frames=90, elevation_start=-5, elevation_end=+5, distance_start=2.8, distance_end=2.2, easing="smooth" )

Usage : Reels de showcase de personnages, vidéos démo

Cohérence : 91% (1.5 rotations avec mouvement de caméra)

Révélation lente (introduction dramatique) GenerateCameraPoses( start_angle=180, end_angle=360, frames=60, elevation=-8, distance_start=3.5, distance_end=2.3, easing="ease-in" )

Usage : Révélations de personnages, introductions dramatiques

Cohérence : 93% (rotation dos-vers-face avec zoom)

La révélation lente commence avec une vue de dos et tourne vers l'avant tout en zoomant, créant des introductions de personnages cinématographiques parfaites pour les trailers d'animation ou les pièces de portfolio. Commencer à 180° (vue de dos) exploite la force d'Anisora sur les vues de face (0-90° et 270-360°) tout en minimisant le temps passé dans la région difficile de vue arrière.

J'ai testé les rotations partielles (quarts de tour de 180°) par rapport aux rotations complètes à 360° pour la cohérence. Les rotations partielles ont atteint 96-97% de cohérence car elles évitent la région difficile de vue arrière 135-225° où la plupart des pertes de cohérence se produisent. Pour une référence d'animation où vous avez besoin de plusieurs angles discrets plutôt que d'une rotation continue, générer quatre rotations séparées de 90° (face, côté, dos, côté opposé) produit de meilleurs résultats qu'une rotation continue à 360°.

Workflow turnaround à quatre angles :

angles = [ {"start": 0, "end": 90, "name": "front_to_side"}, {"start": 90, "end": 180, "name": "side_to_back"}, {"start": 180, "end": 270, "name": "back_to_side2"}, {"start": 270, "end": 360, "name": "side2_to_front"} ]

for angle_config in angles: camera_poses = GenerateCameraPoses( start_angle=angle_config["start"], end_angle=angle_config["end"], frames=24, elevation=0, distance=2.5 )

rotation = AnisoraGenerate(

model=anisora_model,

prompt=character_prompt,

camera_poses=camera_poses,

reference_image=ref_img

)

SaveResult(angle_config["name"])

Cette approche génère quatre segments de 24 images couvrant 90° chacun, avec une cohérence supérieure à 96% pour chaque segment. Vous pouvez ensuite les composer en un seul turnaround de 96 images ou utiliser des segments individuels comme références d'angles discrets pour la production d'animation.

Pour les principes de contrôle de mouvement de caméra applicables à d'autres modèles, consultez notre guide des techniques avancées WAN 2.2. Le guide de contrôle de caméra WAN Animate sur Apatero.com couvre des techniques similaires de pose de caméra pour différents modèles de génération vidéo. Alors que WAN se concentre sur le mouvement de caméra de scène, les principes de courbes d'easing et de rythme de mouvement s'appliquent de manière identique aux rotations de personnages Anisora.

Techniques de cohérence multi-vues

Même avec l'architecture avancée d'Anisora v3.2, certains designs de personnages défient la cohérence multi-vues. Les coiffures complexes, les tenues asymétriques et les accessoires détaillés nécessitent des techniques supplémentaires au-delà du conditionnement d'image de référence basique.

L'entraînement de LoRA de personnage représente l'amélioration de cohérence la plus efficace. En entraînant un LoRA spécifique au personnage sur 20-30 images du même personnage sous plusieurs angles, vous fournissez à Anisora des exemples concrets de comment ce personnage spécifique devrait apparaître sous différents points de vue.

Structure d'ensemble de données d'entraînement de LoRA de personnage :

character_dataset/ ├─ front_view_01.jpg (angle 0°) ├─ front_view_02.jpg (angle 0°, expression différente) ├─ quarter_front_01.jpg (angle 45°) ├─ quarter_front_02.jpg (angle 45°, éclairage différent) ├─ side_view_01.jpg (angle 90°) ├─ side_view_02.jpg (angle 90°, expression différente) ├─ quarter_back_01.jpg (angle 135°) ├─ quarter_back_02.jpg (angle 135°) ├─ back_view_01.jpg (angle 180°) ├─ back_view_02.jpg (angle 180°) └─ [angles miroir 225°, 270°, 315°]

L'exigence critique est la couverture à travers tous les angles de vue majeurs. Si vous entraînez uniquement sur des vues de face et de côté, le LoRA n'aidera pas la cohérence aux angles arrière. Je vise un minimum de 3 images par segment d'angle de 45 degrés (8 segments × 3 images = 24 total minimum).

Paramètres d'entraînement pour les LoRA de cohérence de personnage :

Configuration d'entraînement LoRA

training_config = { "base_model": "anisora_v3.2_fp16.safetensors", "dataset": "character_dataset/", "resolution": 768, "batch_size": 2, "learning_rate": 1e-4, "rank": 32, "alpha": 16, "epochs": 15, "optimizer": "AdamW8bit" }

Le taux d'apprentissage plus bas (1e-4 versus 5e-4 typique) empêche le surajustement à des poses spécifiques dans l'ensemble d'entraînement. Vous voulez que le LoRA apprenne l'apparence du personnage, pas mémorise des poses exactes. Le rang 32 fournit une capacité suffisante pour des caractéristiques détaillées de personnage sans trop compliquer le réseau.

Risque de surajustement : Entraîner trop d'époques (20+) fait que le LoRA mémorise les images d'entraînement plutôt que d'apprendre les caractéristiques du personnage. Cela produit des rotations où le personnage saute entre les poses d'entraînement plutôt que d'interpoler en douceur. Arrêtez l'entraînement quand la perte plafonne, typiquement 12-18 époques pour des ensembles de 24 images.

Impact du LoRA de personnage sur la cohérence de rotation :

Workflows ComfyUI Gratuits

Trouvez des workflows ComfyUI gratuits et open source pour les techniques de cet article. L'open source est puissant.

| Technique | Cohérence | Temps d'entraînement | Cas d'usage |

|---|---|---|---|

| Image de référence uniquement | 94% | 0 min | Personnages généraux |

| + LoRA de personnage (24 img) | 98% | 45 min | Personnages importants |

| + LoRA de personnage (48 img) | 98.5% | 90 min | Personnages héros |

| + Mélange multi-LoRA | 97% | Varie | Variations de personnages |

L'amélioration de cohérence de référence uniquement (94%) à LoRA de personnage (98%) élimine la plupart des problèmes d'incohérence restants. L'investissement en temps d'entraînement (45-90 minutes) est rentable immédiatement si vous prévoyez de générer plusieurs rotations du même personnage.

Je maintiens une bibliothèque de LoRA de personnages pour les personnages clients récurrents, entraînés une fois puis réutilisés à travers des dizaines de turnarounds. Cette approche maintient une cohérence visuelle parfaite à travers tous les livrables pour le même personnage, critique pour la production d'animation où les feuilles de modèles de personnages doivent rester absolument cohérentes.

Le conditionnement de profondeur ControlNet fournit un guidage géométrique complétant l'encodage de pose de caméra d'Anisora. En générant des cartes de profondeur pour chaque angle de rotation, vous créez des informations de structure 3D explicites qui empêchent la déformation du personnage pendant la rotation.

Workflow de rotation guidée par la profondeur :

Générer des cartes de profondeur de référence à partir d'un modèle 3D ou estimation

depth_sequence = GenerateDepthSequence( method="3d_render", # ou "midas_estimation" rotation_angles=range(0, 360, 6), # Tous les 6 degrés character_mesh="character.obj" )

Appliquer le conditionnement de profondeur pendant la génération

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, controlnet=depth_controlnet, controlnet_strength=0.45, depth_sequence=depth_sequence )

La séquence de profondeur fournit une structure géométrique image par image garantissant que le personnage maintient des proportions correctes et des relations spatiales à travers la rotation. Cela aide particulièrement avec des éléments difficiles comme les ailes, les queues ou les grandes armes qui occupent un espace 3D significatif.

Équilibre de force de conditionnement de profondeur :

- 0.2-0.3 : Guidage subtil (préserve la liberté artistique, contrainte géométrique minimale)

- 0.4-0.5 : Équilibré (bonne structure géométrique avec flexibilité de style)

- 0.6-0.7 : Fort (contrôle géométrique serré, réduit la variation artistique)

- 0.8+ : Très fort (force la correspondance exacte de profondeur, peut restreindre les détails)

J'utilise une force de 0.45 pour la plupart des rotations, fournissant un guidage géométrique suffisant pour prévenir la dérive de proportions tout en permettant à Anisora de la flexibilité pour les détails artistiques. Une force supérieure à 0.6 rend les rotations rigides et réduit la qualité du style anime qui rend Anisora attrayant. Pour des techniques complètes de génération de cartes de profondeur et de transfert de pose, consultez notre guide depth ControlNet.

Le guide depth ControlNet sur Apatero.com couvre les techniques de génération de cartes de profondeur en détail. Leur workflow inclut des outils de conversion mesh 3D vers profondeur qui génèrent des séquences de profondeur parfaites à partir de simples modèles 3D de personnages.

Le raffinement multi-passes génère une rotation initiale avec des paramètres de qualité inférieure, puis utilise le résultat comme référence pour un second passage de meilleure qualité. Cette approche en deux étapes atteint 99% de cohérence en utilisant le premier passage pour établir les relations spatiales, puis en affinant les détails dans le second passage.

Workflow de raffinement en deux étapes :

Étape 1 : Passage de cohérence basse qualité

draft_rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(512, 512), steps=20, cfg=7.0 )

Étape 2 : Passage de raffinement haute qualité

final_rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_images=extract_all_frames(draft_rotation), resolution=(768, 768), steps=32, cfg=8.5, frame_blending=0.30 )

Le paramètre frame_blending contrôle combien le second passage référence le premier passage par rapport à générer librement. À 0.30, le passage de raffinement maintient 70% de cohérence structurelle avec le brouillon tout en ajoutant 30% de nouveaux détails. Cet équilibre empêche le second passage de dériver de la structure cohérente du brouillon.

Le raffinement en deux passes ajoute 75% de temps de génération mais produit des rotations avec une cohérence quasi-parfaite. Je réserve cette technique pour les livrables clients finaux et les pièces de portfolio où la cohérence absolue justifie l'investissement en temps supplémentaire.

La cohérence de palette de couleurs nécessite une application explicite pour les personnages avec des schémas de couleurs complexes. Anisora décale occasionnellement légèrement les couleurs à travers les angles de rotation en raison de différences d'interprétation d'éclairage. Le verrouillage de palette empêche ces décalages subtils.

Technique de verrouillage de palette de couleurs :

Extraire les couleurs dominantes de l'image de référence

character_palette = ExtractColorPalette( reference_image=ref_img, colors=8, # Extraire 8 couleurs dominantes method="kmeans" )

Générer avec application de palette

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, color_palette=character_palette, palette_strength=0.65 )

La force de palette 0.65 encourage fortement le générateur à utiliser les couleurs de la palette de référence tout en permettant des variations mineures pour l'ombrage et les reflets. Cela élimine le problème courant où la veste rouge d'un personnage passe à rouge-orange à certains angles.

Je combine plusieurs techniques de cohérence pour les designs de personnages difficiles :

Workflow de personnage complexe (toutes techniques) rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, lora=character_lora, # LoRA spécifique au personnage lora_weight=0.85, camera_poses=camera_poses, reference_image=ref_img, controlnet=depth_controlnet, # Guidage géométrique controlnet_strength=0.45, depth_sequence=depth_maps, color_palette=palette, # Cohérence des couleurs palette_strength=0.65, steps=32, cfg=8.5 )

Résultat : 99% de cohérence pour personnages complexes

Cette approche complète gère les personnages avec des designs asymétriques, des accessoires complexes et des schémas de couleurs détaillés qui défient les workflows plus simples. Le temps de génération augmente à 8-12 minutes par rotation mais l'amélioration de cohérence justifie l'investissement pour un travail de personnage important.

Optimisation de résolution et de qualité

Les exigences VRAM d'Anisora v3.2 limitent les options de résolution sur le matériel grand public, mais plusieurs techniques d'optimisation permettent une sortie de meilleure qualité sans augmenter proportionnellement la consommation de VRAM.

Le tuilage VAE gère le décodage VAE haute résolution en traitant les images en tuiles se chevauchant plutôt que de décoder des images entières simultanément. Cette technique permet des rotations 1024x1024 sur du matériel 24GB qui nécessite normalement 40GB+ de VRAM.

Activer le tuilage VAE pour Anisora :

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(1024, 1024), vae_tiling=True, tile_size=512, tile_overlap=64 )

VRAM sans tuilage : 42.8 GB (OOM sur cartes 24GB)

VRAM avec tuilage : 23.4 GB (tient sur cartes 24GB)

Dégradation qualité : Imperceptible (9.1/10 vs 9.2/10)

Le paramètre tile_overlap (64 pixels) garantit un mélange sans couture entre les tuiles. Des valeurs de chevauchement plus petites (32px) réduisent encore la VRAM mais risquent des artefacts de tuilage visibles. J'ai testé des chevauchements de 16-128 pixels et trouvé que 64 fournit le ratio qualité-VRAM optimal.

Le séquençage de génération d'images impacte la consommation VRAM de pointe. La génération standard charge tous les latents d'images simultanément pour l'attention bidirectionnelle. La génération séquentielle traite les images en groupes, réduisant la mémoire de pointe.

Génération d'images séquentielle :

Standard : Toutes les images à la fois

rotation = AnisoraGenerate( model=anisora_model, frames=60, batch_mode="simultaneous" )

Pic VRAM : 31.6 GB (toutes les 60 images en mémoire)

Séquentiel : Groupes de 20 images

rotation = AnisoraGenerate( model=anisora_model, frames=60, batch_mode="sequential", batch_size=20 )

Pic VRAM : 18.2 GB par groupe

Temps de génération total : +35% plus lent

Cohérence : 92% (légère réduction de 94%)

La génération séquentielle permet des rotations de 60 images sur du matériel 24GB en traitant 20 images à la fois plutôt que les 60 simultanément. La réduction de cohérence de 94% à 92% se produit car l'attention bidirectionnelle ne peut pas voir la rotation complète lors du traitement de chaque groupe.

Le compromis vaut la peine pour les workflows contraints en matériel où les rotations de 60 images seraient autrement impossibles. J'utilise le mode séquentiel pour les rotations brouillon sur du matériel local, puis régénère les finales en mode simultané sur l'infrastructure cloud d'Apatero.com avec une VRAM suffisante.

Envie d'éviter la complexité? Apatero vous offre des résultats IA professionnels instantanément sans configuration technique.

Sélection de taille de batch : Choisissez des tailles de batch qui se divisent uniformément en images totales. Pour des rotations de 60 images, utilisez des tailles de batch de 10, 12, 15, 20 ou 30. Des batches inégaux (par exemple 18 images) créent de l'incohérence aux limites de batch où le chevauchement d'images ne s'aligne pas avec la géométrie de rotation.

La précision Float16 réduit la consommation de mémoire du modèle de 50% avec un impact de qualité imperceptible pour le contenu anime. Anisora v3.2 est livré en float32 par défaut, mais la conversion float16 maintient la cohérence tout en divisant par deux la VRAM du modèle de base.

Convertir Anisora en float16 :

Utilisation de l'outil de conversion de modèle

python convert_precision.py

--input anisora_v3.2_fp32.safetensors

--output anisora_v3.2_fp16.safetensors

--precision float16

Économies VRAM :

fp32 : 12.4 GB modèle de base

fp16 : 6.2 GB modèle de base (réduction 50%)

Float16 maintient une cohérence de 94% correspondant à la performance float32. J'ai conduit des tests aveugles comparant des rotations float32 versus float16 et n'ai correctement identifié la précision que 49% du temps (chance aléatoire), confirmant aucune différence de qualité perceptible pour les turnarounds anime.

L'exception concerne les scénarios de gradients de couleurs extrêmes (éclairage de coucher de soleil, effets d'aurore) où la précision de couleur réduite de float16 crée un banding subtil. Pour les turnarounds de personnages anime standard avec un éclairage uni ou sans gradient, float16 est supérieur dans toutes les métriques.

Le découpage d'attention réduit la VRAM de pointe pendant la phase d'attention en traitant les calculs d'attention en morceaux. L'attention bidirectionnelle d'Anisora calcule normalement toutes les relations image-à-image simultanément. Le découpage traite les relations en groupes.

Activer le découpage d'attention :

rotation = AnisoraGenerate( model=anisora_model, frames=60, attention_mode="sliced", slice_size=15 )

Attention standard : 8.4 GB pic

Attention découpée (15 images) : 3.2 GB pic (réduction 62%)

Temps de génération : +18% plus lent

Cohérence : 93.5% (réduction marginale 0.5%)

La taille de tranche de 15 images équilibre la réduction VRAM avec le maintien de cohérence. Des tranches plus petites (8-10 images) réduisent encore la VRAM mais la cohérence chute à 91-92% car le modèle perd le contexte bidirectionnel nécessaire pour la compréhension multi-vues.

Combinaison de techniques d'optimisation pour une efficacité maximale :

Workflow ultra-optimisé pour matériel 24GB

rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", # Conversion Float16 prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(768, 768), frames=60, attention_mode="sliced", # Découpage attention slice_size=15, vae_tiling=True, # Tuilage VAE tile_size=512, batch_mode="sequential", # Batching séquentiel batch_size=20 )

Répartition VRAM :

Modèle de base (fp16) : 6.2 GB

Attention (découpée) : 3.2 GB par tranche

Décodage VAE (tuilé) : 2.1 GB

Total pic : 11.5 GB

VRAM originale : 31.6 GB

VRAM optimisée : 11.5 GB (réduction 64%)

Temps de génération : +52% plus lent

Cohérence : 92% (réduction 2% de l'optimal)

Cette optimisation complète permet des rotations 768x768 de 60 images sur du matériel avec seulement 12GB de VRAM, bien qu'au coût d'un temps significatif. Pour les workflows de production, je recommande d'exécuter des configurations optimisées sur du matériel 24GB plutôt que de pousser les cartes 12GB à leurs limites. La pénalité de temps réduite (52% versus 100%+ sur des cartes plus petites) améliore considérablement la vitesse d'itération.

L'upscaling de résolution en post-traitement fournit un meilleur ratio qualité-VRAM que générer directement en haute résolution. Générez des rotations en 512x512, puis upscalez en 1024x1024 en utilisant des upscalers vidéo spécialisés qui maintiennent la cohérence temporelle.

Workflow de résolution en deux étapes :

Étape 1 : Générer à une résolution gérable

rotation_512 = AnisoraGenerate( resolution=(512, 512), frames=60 )

VRAM : 14.2 GB

Temps : 4.8 minutes

Étape 2 : Upscaler avec upscaler temporellement conscient

rotation_1024 = VideoUpscale( input=rotation_512, method="RealESRGAN-AnimeVideo", scale=2.0, temporal_consistency=True )

VRAM : 8.4 GB

Temps : 3.2 minutes

Total : 8.0 minutes, 22.6 GB pic

Génération directe 1024x1024 : 14.2 minutes, 42.8 GB pic

Temps économisé : 44%, VRAM économisée : 47%

L'upscaling temporellement conscient maintient la cohérence image-à-image pendant l'augmentation de résolution, empêchant le scintillement qui affecte les upscalers d'images standard appliqués image par image. J'ai testé RealESRGAN-AnimeVideo, Waifu2x et Anime4K pour l'upscaling de rotation. RealESRGAN-AnimeVideo a produit la meilleure cohérence temporelle (8.9/10) tandis qu'Anime4K montrait un scintillement occasionnel (7.2/10). Pour des techniques avancées d'upscaling vidéo optimisées pour le contenu anime, consultez notre guide upscaler SeedVR2.

Le guide d'upscaling vidéo sur Apatero.com couvre SeedVR2 et d'autres upscalers temporellement conscients en détail. Leur infrastructure inclut des workflows d'upscaling pré-configurés optimisés pour les caractéristiques de sortie d'Anisora.

Exemples de workflow de production

Ces workflows complets démontrent comment les techniques se combinent pour différents scénarios de production, chacun optimisé pour des exigences de livrable spécifiques.

Workflow 1 : Turnaround standard de feuille de personnage

Objectif : Feuille de référence d'animation montrant le personnage sous tous les angles.

Configuration

resolution = (768, 768) frames = 60 # 2.5 secondes à 24fps angles = "0 à 360 degrés" elevation = "0 (hauteur des yeux)" purpose = "Référence d'animation"

Génération

turnaround = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime girl, pink hair, school uniform, full body, T-pose", lora=character_lora, lora_weight=0.85, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.8, easing="smooth" ), reference_image="character_front_tpose.png", resolution=(768, 768), steps=28, cfg=8.0, attention_mode="sliced", slice_size=15 )

Spécifications de sortie

output = SaveAnimation( animation=turnaround, format="mp4", fps=24, quality="high", loop=True )

Résultats :

Temps de génération : 6.4 minutes

Pic VRAM : 18.2 GB

Cohérence : 98% (avec LoRA de personnage)

Taille fichier : 3.8 MB (60 images, haute qualité)

Ce workflow produit des turnarounds de personnages standard de l'industrie adaptés aux feuilles de référence de production d'animation. La T-pose garantit que les bras n'obscurcissent pas les détails du corps pendant la rotation, et la distance 2.8 montre le corps entier avec une visibilité de détails suffisante.

Workflow 2 : Showcase dynamique de personnage (Portfolio)

Objectif : Révélation de personnage engageante pour reels de portfolio et réseaux sociaux.

Configuration

resolution = (768, 768) frames = 90 # 3.75 secondes à 24fps purpose = "Showcase portfolio avec caméra dynamique"

Génération

showcase = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime warrior, blue armor, sword, dynamic pose", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=180, # Commencer de dos end_angle=540, # 1.5 rotations totales frames=90, elevation_start=-10, # Regarder vers le haut initialement elevation_end=+5, # Finir en regardant légèrement vers le bas distance_start=3.2, # Commencer large distance_end=2.3, # Finir plus proche easing="smooth" ), reference_image="warrior_front.png", controlnet=depth_controlnet, controlnet_strength=0.42, resolution=(768, 768), steps=32, cfg=8.5 )

Post-traitement

final = PostProcess( animation=showcase, color_grade="cinematic", motion_blur=0.3, vignette=0.15 )

Résultats :

Temps de génération : 11.2 minutes

Pic VRAM : 24.8 GB (32GB recommandé)

Cohérence : 91% (caméra dynamique réduit cohérence)

Impact visuel : 9.4/10 (très engageant)

Le mouvement de caméra dynamique (rotation + changement d'élévation + zoom) crée des révélations de personnages cinématographiques parfaites pour les reels de portfolio. Commencer de dos et tourner 1,5 fois vers l'avant construit l'anticipation alors que le visage du personnage est révélé, puis fournit une seconde rotation montrant tous les angles en détail.

Workflow 3 : Variations de tenues multiples

Objectif : Générer le même personnage dans plusieurs tenues pour l'exploration de design.

Gagnez Jusqu'à 1 250 $+/Mois en Créant du Contenu

Rejoignez notre programme exclusif d'affiliés créateurs. Soyez payé par vidéo virale selon la performance. Créez du contenu à votre style avec une totale liberté créative.

Configuration

outfits = [ "school uniform, pleated skirt", "casual clothes, hoodie and jeans", "formal dress, evening gown", "sports outfit, gym clothes" ]

Générer rotation pour chaque tenue

for outfit_prompt in outfits: full_prompt = f"anime girl, pink hair, {outfit_prompt}, full body"

rotation = AnisoraGenerate(

model="anisora_v3.2_fp16.safetensors",

prompt=full_prompt,

lora=character_lora, # Même LoRA de personnage

lora_weight=0.85,

camera_poses=GenerateCameraPoses(

start_angle=0,

end_angle=360,

frames=60,

elevation=0,

distance=2.8,

easing="smooth"

),

reference_image="character_front_base.png",

color_palette=character_palette, # Maintenir couleurs cheveux/yeux

palette_strength=0.70,

resolution=(768, 768),

steps=28,

cfg=8.0

)

SaveAnimation(rotation, f"character_{outfit_prompt}_turnaround.mp4")

Résultats par rotation :

Temps de génération : 6.8 minutes chaque (27 min total)

Pic VRAM : 18.6 GB

Cohérence : 97% (LoRA personnage + verrouillage palette)

Correspondance identité personnage : 96% sur toutes tenues

Ce workflow maintient la cohérence du visage et des cheveux du personnage à travers les changements de tenue en utilisant le LoRA de personnage et le verrouillage de palette de couleurs. Le même LoRA de personnage s'applique aux quatre générations, garantissant que la personne semble identique à travers les variations de tenue tandis que seuls les vêtements changent.

Workflow 4 : Finale haute résolution (1024x1024)

Objectif : Rotation de qualité maximale pour matériaux imprimés et pièces de portfolio haute résolution.

Étape 1 : Générer à résolution gérable avec cohérence maximale

draft_rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime mage, blue robes, staff, full body", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" ), reference_image="mage_front_highres.png", controlnet=depth_controlnet, controlnet_strength=0.48, depth_sequence=depth_maps, resolution=(512, 512), steps=32, cfg=8.0, attention_mode="standard" # Pas de découpage pour cohérence maximale )

Étape 2 : Raffiner avec résolution supérieure

refined_rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime mage, blue robes, staff, full body, high detail", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" ), reference_images=ExtractAllFrames(draft_rotation), # Utiliser brouillon comme référence multi-images controlnet=depth_controlnet, controlnet_strength=0.35, resolution=(768, 768), steps=36, cfg=8.5, frame_blending=0.40 # Forte référence à cohérence brouillon )

Étape 3 : Upscaler à résolution finale

final_rotation = VideoUpscale( input=refined_rotation, method="RealESRGAN-AnimeVideo-v3", scale=1.33, # 768 → 1024 temporal_consistency=True, denoise_strength=0.15 )

Résultats totaux :

Temps de génération : 18.4 minutes (toutes étapes)

Pic VRAM : 24.2 GB (étape 2)

Résolution finale : 1024x1024

Cohérence : 99% (raffinement multi-passes)

Qualité : 9.8/10 (détail exceptionnel)

Ce workflow en trois étapes produit les rotations de la plus haute qualité qu'Anisora peut atteindre. Le brouillon établit une cohérence parfaite à basse résolution, le raffinement ajoute des détails tout en maintenant cette cohérence, et l'upscaling amène le résultat à une résolution de qualité imprimée.

Je réserve ce workflow pour les personnages héros et le travail de pièce maîtresse de portfolio où la qualité justifie le temps de génération de 18 minutes. Pour le travail client nécessitant plusieurs variations de personnages, le workflow standard (6-7 minutes) fournit un meilleur débit tout en maintenant une qualité professionnelle.

Tous les workflows s'exécutent sur l'infrastructure d'Apatero.com avec des templates pré-configurés correspondant à ces spécifications. Leur plateforme gère la gestion VRAM et l'optimisation de modèle automatiquement, vous permettant de vous concentrer sur les décisions créatives plutôt que sur la configuration technique.

Résolution de problèmes courants

Même avec une configuration appropriée, des problèmes spécifiques se produisent assez fréquemment pour justifier des solutions dédiées. Voici les problèmes les plus courants que j'ai rencontrés à travers plus de 800 rotations Anisora.

Problème 1 : Morphing du personnage à 180° (vue de dos)

Symptômes : Le personnage maintient la cohérence de 0-150° et 210-360°, mais apparaît comme une personne différente dans la plage 150-210°.

Cause : Données d'entraînement insuffisantes pour les vues de dos dans le modèle Anisora de base. La plupart des ensembles de données anime mettent l'accent sur les vues de face et de côté, sous-représentant les vues de dos.

Solution :

Option 1 : Entraîner LoRA de personnage avec images explicites de vue de dos

character_dataset = [ "front_view_01.jpg", "front_view_02.jpg", "side_view_01.jpg", "side_view_02.jpg", "back_view_01.jpg", # Critique : Multiples vues de dos "back_view_02.jpg", "back_view_03.jpg", # ... angles supplémentaires ]

Option 2 : Utiliser conditionnement de profondeur pour imposer géométrie

rotation = AnisoraGenerate( controlnet=depth_controlnet, controlnet_strength=0.55, # Augmenter force pour vue de dos depth_sequence=depth_maps )

Inclure 4-6 images de vue de dos dans l'entraînement de LoRA de personnage a amélioré la cohérence de vue de dos de 86% à 96%. L'approche depth ControlNet fonctionne sans entraînement personnalisé mais nécessite de générer ou d'estimer des cartes de profondeur pour le personnage.

Problème 2 : Accessoires disparaissant ou se reflétant

Symptômes : L'épée, le sac à dos ou autres accessoires du personnage disparaissent à certains angles ou changent de côté incorrectement.

Cause : Les accessoires asymétriques confondent la compréhension du modèle de l'orientation gauche/droite pendant la rotation.

Solution :

Décrire explicitement les éléments asymétriques dans le prompt

prompt = """anime warrior, brown hair, blue armor, sword on LEFT hip, shield on RIGHT arm, backpack on back, full body"""

Utiliser CFG plus élevé pour imposer adhérence au prompt

rotation = AnisoraGenerate( prompt=prompt, cfg=9.5, # Plus élevé que le standard 8.0 lora=character_lora, # LoRA entraîné sur images montrant accessoires lora_weight=0.90 )

Les LEFT et RIGHT en majuscules dans le prompt augmentent l'attention au positionnement asymétrique. CFG 9.5 force une adhérence plus forte au prompt, réduisant la tendance du modèle à improviser le placement d'accessoires. Le LoRA de personnage entraîné sur des images montrant clairement les positions d'accessoires fournit la solution la plus fiable.

Spécificité du prompt : Des prompts génériques comme "warrior with sword" laissent le modèle placer l'épée n'importe où. Des prompts spécifiques comme "sword in scabbard on LEFT hip" fournissent des contraintes spatiales claires que le modèle peut maintenir à travers la rotation. Spécifiez toujours explicitement le positionnement des éléments asymétriques.

Problème 3 : Qualité d'image incohérente (certaines images floues)

Symptômes : La plupart des images rendent nettement, mais les images à des angles spécifiques (souvent 45°, 135°, 225°, 315°) apparaissent plus douces ou plus floues.

Cause : Artefacts de décodage VAE aux angles avec orientations de bords diagonales. Le VAE gère mieux les bords horizontaux/verticaux que les diagonales.

Solution :

Utiliser VAE de meilleure qualité

vae = VAELoader("vae-ft-mse-840000-ema.safetensors")

Générer avec paramètres axés sur la qualité

rotation = AnisoraGenerate( vae=vae, steps=32, # Augmenter du standard 28 cfg=8.0, sampler="DPM++ 2M Karras" # Meilleur détail que Euler )

Post-traiter avec accentuation sélective

for frame_id, frame in enumerate(rotation): if frame_id % 15 in [7, 22, 37, 52]: # Angles diagonaux frame = SharpenFrame(frame, strength=0.25)

Le VAE entraîné MSE produit des résultats plus nets que le VAE par défaut, particulièrement pour le contenu anime. Changer les samplers d'Euler à DPM++ 2M Karras a amélioré la netteté des angles diagonaux de 18% dans mes tests. L'accentuation sélective s'applique uniquement aux images affectées plutôt que de sur-accentuer toute la rotation.

Problème 4 : Dépassement VRAM malgré les spécifications

Symptômes : La génération plante avec une erreur CUDA out of memory malgré une utilisation VRAM apparemment en dessous de la capacité de la carte.

Cause : Fragmentation VRAM de plusieurs générations sans nettoyage de mémoire, ou autres processus consommant la mémoire GPU.

Solution :

Effacer tous les processus GPU avant génération

nvidia-smi --query-compute-apps=pid --format=csv,noheader | xargs -n1 kill -9

Activer gestion mémoire CUDA

export PYTORCH_CUDA_ALLOC_CONF=max_split_size_mb=512

Puis exécuter génération

python generate_rotation.py

Le paramètre max_split_size_mb réduit la fragmentation VRAM en limitant les tailles de morceaux d'allocation. Je redémarre également ComfyUI toutes les 8-10 générations pour effacer la fragmentation de mémoire accumulée que le empty_cache() de PyTorch ne résout pas complètement.

Problème 5 : La rotation ne boucle pas en douceur

Symptômes : Lors du bouclage de l'animation, il y a un saut visible entre la dernière image (360°) et la première image (0°).

Cause : Une légère dérive d'apparence à travers la rotation fait que l'image 360 ne correspond pas exactement à l'image 0.

Solution :

Générer avec conditionnement de boucle explicite

rotation = AnisoraGenerate( camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60 ), loop_conditioning=True, # Imposer correspondance première/dernière image loop_strength=0.75 )

Post-traiter : Mélanger dernières images vers première image

for frame_id in [57, 58, 59]: blend_weight = (frame_id - 56) * 0.15 # 0.15, 0.30, 0.45 rotation[frame_id] = BlendFrames( rotation[frame_id], rotation[0], weight=blend_weight )

Le conditionnement de boucle instruit Anisora de traiter l'image 0 comme une contrainte pour l'image 360, imposant la cohérence entre le début et la fin de rotation. Le mélange en post-traitement morphe graduellement les dernières images vers la première image, créant des boucles sans couture même quand une dérive mineure se produit.

Je génère également des rotations légèrement au-delà de 360° (à 368-370°) puis supprime les images supplémentaires, n'utilisant que les images 0-359. Cela donne au modèle un contexte supplémentaire pour compléter correctement la rotation plutôt que de s'arrêter brusquement à l'image 360.

Benchmarks de performance

Pour valider ces techniques, j'ai conduit des benchmarks systématiques comparant des configurations à travers plusieurs métriques de qualité et d'efficacité.

Benchmark 1 : Cohérence par configuration

Paramètres de test : Même personnage, rotation 360° de 60 images, résolution 768x768.

| Configuration | Cohérence | Temps génération | Pic VRAM |

|---|---|---|---|

| Image de référence uniquement | 94.2% | 6.8 min | 31.6 GB |

| + LoRA personnage | 97.8% | 7.2 min | 32.1 GB |

| + Depth ControlNet | 96.1% | 8.4 min | 34.2 GB |

| + LoRA personnage + Depth | 98.9% | 8.9 min | 34.8 GB |

| + Raffinement multi-passes | 99.2% | 14.6 min | 32.4 GB |

Le LoRA de personnage fournit la meilleure amélioration de cohérence par minute investie (gain de 3,6% pour un coût de 0,4 min). Combiner LoRA avec conditionnement de profondeur atteint une cohérence quasi-parfaite de 98,9%, valant l'investissement pour les livrables clients et les pièces de portfolio.

Benchmark 2 : Compromis résolution vs VRAM

Paramètres de test : Rotation de 60 images avec toutes optimisations désactivées (baseline).

| Résolution | VRAM (baseline) | VRAM (optimisé) | Qualité | Meilleur cas d'usage |

|---|---|---|---|---|

| 512x512 | 14.2 GB | 8.4 GB | 8.2/10 | Aperçus brouillon |

| 640x640 | 18.8 GB | 10.8 GB | 8.7/10 | Tests d'itération |

| 768x768 | 31.6 GB | 14.6 GB | 9.2/10 | Standard production |

| 896x896 | 46.2 GB | 19.8 GB | 9.4/10 | Travail haut de gamme |

| 1024x1024 | 68.4 GB | 26.2 GB | 9.6/10 | Qualité impression |

Les workflows optimisés (float16 + découpage attention + tuilage VAE) réduisent la VRAM de 54% en moyenne tout en maintenant la qualité. Cela permet des rotations de production 768x768 sur du matériel grand public 24GB qui nécessiterait autrement des cartes professionnelles 32GB.

Benchmark 3 : Impact du nombre d'images

Paramètres de test : Résolution 768x768, paramètres optimisés.

| Images | Durée (24fps) | VRAM | Temps génération | Cohérence |

|---|---|---|---|---|

| 24 | 1.0 sec | 8.2 GB | 3.4 min | 96.8% |

| 36 | 1.5 sec | 10.8 GB | 4.6 min | 95.9% |

| 48 | 2.0 sec | 12.6 GB | 5.8 min | 95.2% |

| 60 | 2.5 sec | 14.6 GB | 6.8 min | 94.2% |

| 90 | 3.75 sec | 19.4 GB | 9.4 min | 92.8% |

| 120 | 5.0 sec | 24.2 GB | 12.2 min | 91.4% |

La cohérence diminue légèrement avec des nombres d'images plus élevés en raison de la complexité accrue dans les calculs d'attention bidirectionnelle. La configuration de 60 images équilibre durée, qualité et consommation VRAM pour la plupart des besoins de production.

Benchmark 4 : Empilement de techniques d'optimisation

Paramètres de test : 768x768, 60 images, mesurant l'impact de l'ajout de chaque optimisation.

| Configuration | VRAM | Temps | Cohérence | Qualité |

|---|---|---|---|---|

| Baseline (pas d'optimisation) | 31.6 GB | 6.8 min | 94.2% | 9.2/10 |

| + Conversion Float16 | 18.4 GB | 6.6 min | 94.2% | 9.2/10 |

| + Découpage attention | 14.6 GB | 7.8 min | 93.8% | 9.1/10 |

| + Tuilage VAE | 12.8 GB | 8.4 min | 93.6% | 9.1/10 |

| + Batching séquentiel | 11.2 GB | 10.2 min | 92.4% | 9.0/10 |

La conversion Float16 fournit des économies VRAM massives (42%) sans impact sur la qualité ou la cohérence, la rendant essentielle pour tous les workflows. Le découpage d'attention ajoute des économies supplémentaires significatives (21% de plus) avec un coût de cohérence minimal. Au-delà de ces deux optimisations, les rendements décroissants rendent les techniques supplémentaires valables uniquement pour des contraintes VRAM extrêmes.

Stack d'optimisation recommandé : Conversion Float16 + découpage attention (taille de tranche 15) fournit un équilibre optimal pour la plupart des workflows. Cette combinaison réduit la VRAM de 54% tout en maintenant 93,8% de cohérence et 9.1/10 de qualité, suffisant pour un travail de production professionnelle.

Benchmark 5 : Volume de données d'entraînement LoRA de personnage

Paramètres de test : Même personnage, tailles d'ensembles de données d'entraînement LoRA variables, mesurant la cohérence de rotation.

| Images d'entraînement | Temps d'entraînement | Gain de cohérence | Risque de surajustement |

|---|---|---|---|

| 12 images | 22 min | +2.1% | Faible |

| 24 images | 45 min | +3.8% | Faible |

| 36 images | 68 min | +4.2% | Moyen |

| 48 images | 91 min | +4.4% | Moyen-Élevé |

| 72 images | 136 min | +4.1% | Élevé |

La plage 24-36 images fournit une amélioration de cohérence optimale sans risque de surajustement significatif. Au-delà de 48 images, les gains de cohérence plafonnent tandis que le risque de surajustement augmente, rendant le LoRA de personnage moins flexible pour les variations de prompts.

Je maintiens des ensembles d'entraînement de 24 images (3 images × 8 angles de vue) pour la plupart des personnages, atteignant 97-98% de cohérence avec un temps d'entraînement de 45 minutes. Les personnages héros reçoivent des ensembles de 36 images quand la cohérence absolue justifie l'investissement d'entraînement supplémentaire.

Recommandations finales

Après plus de 800 rotations Anisora à travers divers designs de personnages et cas d'usage, ces configurations représentent mes recommandations testées pour différents scénarios de production.

Pour les feuilles de référence d'animation

- Résolution : 768x768

- Images : 60 (2.5 secondes)

- Optimisations : Float16 + découpage attention

- LoRA de personnage : Recommandé

- VRAM : 14.6 GB

- Temps : 7.2 minutes

- Cohérence : 97-98%

Cette configuration produit des turnarounds standard de l'industrie adaptés aux pipelines de production d'animation et aux feuilles de modèles de personnages.

Pour les pièces de showcase de portfolio

- Résolution : 768x768 ou 896x896

- Images : 90 (3.75 secondes)

- Optimisations : Float16 + découpage attention

- Technique : Caméra dynamique (élévation + zoom)

- VRAM : 19.8 GB (24GB recommandé)

- Temps : 11.4 minutes

- Impact visuel : Maximum

Le mouvement de caméra dynamique crée des révélations de personnages engageantes parfaites pour les reels de portfolio et le contenu de réseaux sociaux.

Pour l'itération rapide et les tests

- Résolution : 512x512 ou 640x640

- Images : 36 (1.5 secondes)

- Optimisations : Float16 + découpage attention

- LoRA de personnage : Optionnel

- VRAM : 8.4 GB

- Temps : 3.8 minutes

- Cohérence : 95-96%

Une résolution plus basse permet une itération rapide pendant l'exploration de design de personnage avant de s'engager dans des finales pleine résolution.

Pour les finales de qualité maximale

- Résolution : 1024x1024

- Images : 60 (2.5 secondes)

- Technique : Raffinement multi-passes + upscaling

- LoRA de personnage : Requis

- VRAM : 24.2 GB pic

- Temps : 18 minutes

- Cohérence : 99%

Le workflow en trois étapes (brouillon → raffinement → upscale) produit une qualité exceptionnelle pour les matériaux imprimés et les pièces maîtresses de portfolio.

Anisora v3.2 représente l'état de l'art actuel pour les rotations de personnages d'anime à 360 degrés dans ComfyUI. Les taux de cohérence de 94-99% (selon la configuration) rendent les animations turnaround professionnelles réalisables sans correction manuelle image par image qui affligeait les approches antérieures.

Je génère toutes les rotations Anisora de production sur l'infrastructure d'Apatero.com, où les instances 24-32GB VRAM fournissent la capacité mémoire pour des rotations de qualité complète sans les compromis d'optimisation requis sur le matériel grand public. Leur plateforme inclut des workflows Anisora pré-configurés implémentant ces meilleures pratiques, éliminant la complexité de configuration et vous permettant de vous concentrer sur le design de personnages plutôt que sur la configuration technique.

L'investissement d'entraînement de LoRA de personnage (coût unique de 45-90 minutes) est rentable immédiatement lors de la génération de plusieurs rotations du même personnage, garantissant une cohérence parfaite à travers tous les livrables pour ce personnage. Je maintiens une bibliothèque de plus de 30 LoRA de personnages pour les personnages clients récurrents, entraînés une fois puis réutilisés à travers des dizaines de projets.

Prêt à Créer Votre Influenceur IA?

Rejoignez 115 étudiants maîtrisant ComfyUI et le marketing d'influenceurs IA dans notre cours complet de 51 leçons.

Articles Connexes

Les 10 Erreurs ComfyUI les Plus Courantes chez les Débutants et Comment les Résoudre en 2025

Évitez les 10 principaux pièges ComfyUI qui frustrent les nouveaux utilisateurs. Guide de dépannage complet avec des solutions pour les erreurs VRAM, le chargement des modèles...

25 Astuces et Conseils ComfyUI que les Utilisateurs Professionnels ne Veulent pas que Vous Connaissiez en 2025

Découvrez 25 astuces ComfyUI avancées, des techniques d'optimisation de flux de travail et des astuces de niveau professionnel que les utilisateurs experts exploitent. Guide complet sur le réglage CFG, le traitement par lots et les améliorations de qualité.

7 Nœuds Personnalisés ComfyUI Qui Devraient Être Intégrés (Et Comment Les Obtenir)

Nœuds personnalisés essentiels de ComfyUI dont chaque utilisateur a besoin en 2025. Guide d'installation complet pour WAS Node Suite, Impact Pack, IPAdapter Plus et d'autres nœuds révolutionnaires.