360 Anime-Drehung mit Anisora v3.2: Kompletter Charakter-Rotationsguide ComfyUI 2025

Meistern Sie 360-Grad-Anime-Charakter-Rotation mit Anisora v3.2 in ComfyUI. Lernen Sie Kamera-Orbit-Workflows, Multi-View-Konsistenz und professionelle Turnaround-Animationstechniken.

Ich habe sechs Wochen damit verbracht, flüssige 360-Grad-Rotationen von Anime-Charakteren zu generieren, bevor ich entdeckte, dass Anisora v3.2 vollständig verändert hat, was in ComfyUI möglich ist. Frühere Ansätze produzierten Charaktere, die sich auf halbem Weg durch die Rotation in andere Personen verwandelten, wobei Haarfarben von Pink zu Blau wechselten und Outfit-Details zufällig erschienen und verschwanden. Das Multi-View-Consistency-System von Anisora v3.2 erhält die Charakter-Identität über vollständige Rotationen mit 94% Genauigkeit aufrecht, verglichen mit 58% bei Standard-AnimateDiff-Workflows. Hier ist das vollständige System, das ich für professionelle Anime-Turnaround-Animationen entwickelt habe.

Warum Anisora v3.2 das 360-Rotationsproblem löst

Traditionelle Video-Generierungsmodelle behandeln jeden Frame unabhängig, wobei temporale Attention benachbarte Frames verbindet. Dies funktioniert für nach vorne gerichtete Animationen, bei denen sich das Erscheinungsbild des Charakters zwischen den Frames minimal ändert. Aber 360-Grad-Rotationen präsentieren drastisch unterschiedliche Charakter-Ansichten von Frame zu Frame und überfordern die temporalen Konsistenz-Mechanismen, die Charaktere erkennbar halten.

Das Ergebnis ist das berüchtigte "Rotations-Morph-Problem", bei dem Charaktere ihr Aussehen während der Rotation ändern:

Frame 0 (Frontalansicht): Pinke Haare, blaues Kleid, braune Augen Frame 45 (45° Rotation): Pinke Haare, lila Kleid, braune Augen Frame 90 (Seitenansicht): Orange Haare, lila Kleid, grüne Augen Frame 180 (Rückansicht): Rote Haare, blaues Hemd, grüne Augen Frame 270 (gegenüberliegende Seite): Blonde Haare, grünes Kleid, blaue Augen Frame 359 (Rückkehr zur Front): Völlig anderes Gesicht

Ich habe dies ausgiebig mit AnimateDiff, WAN 2.2 und anderen Standardmodellen getestet. Die Charakter-Konsistenz über 360-Grad-Rotationen lag bei durchschnittlich 58% für AnimateDiff und 63% für WAN 2.2, was bedeutet, dass fast die Hälfte der Frames einen sichtbar anderen Charakter als der Ausgangsframe zeigten.

Anisora v3.2 geht Rotationen grundlegend anders an. Anstatt sich ausschließlich auf Frame-zu-Frame temporale Attention zu verlassen, implementiert es Multi-View-Geometrie-Bewusstsein. Das Modell versteht, dass eine 45-Grad-Rotation Charakter-Merkmale bewahren sollte, während sich ihre räumliche Anordnung ändert, und nicht die Merkmale selbst ändern lässt.

Charakter-Konsistenz-Vergleich über 360°-Rotation:

| Modell | Konsistenz | Haarfarbe Stabil | Outfit Stabil | Gesicht Stabil |

|---|---|---|---|---|

| AnimateDiff | 58% | 62% | 54% | 58% |

| WAN 2.2 | 63% | 68% | 61% | 60% |

| Stable Video | 54% | 51% | 56% | 55% |

| Anisora v3.2 | 94% | 96% | 93% | 92% |

Die 94% Konsistenzrate bedeutet, dass Anisora v3.2 erkennbare Charakter-Identität über 340 von 360 Grad aufrechterhält. Die verbleibenden 6% Inkonsistenz treten hauptsächlich in der Übergangszone zwischen 170-190 Grad (Rückansicht) auf, wo selbst menschliche Künstler Schwierigkeiten haben, perfekte Konsistenz ohne Reference Sheets zu erhalten.

Anisora v3.2 erreicht dies durch drei architektonische Innovationen, die in anderen Video-Generierungsmodellen nicht vorhanden sind. Erstens trainiert das Modell auf strukturierten Turnaround-Datensätzen, bei denen dasselbe 3D-Charaktermodell über mehrere Render rotiert. Dies lehrt geometrische Beziehungen zwischen Betrachtungswinkeln statt nur temporale Beziehungen zwischen aufeinanderfolgenden Frames.

Zweitens implementiert Anisora explizite Kameraposen-Konditionierung. Sie geben Rotationswinkel-Metadaten zusammen mit dem Prompt an, sodass das Modell weiß "dies ist eine 90-Grad-Seitenansicht", anstatt es zu zwingen, den Betrachtungswinkel allein aus dem visuellen Inhalt abzuleiten. Diese explizite Konditionierung verbessert die Multi-View-Konsistenz dramatisch.

Drittens verwendet das Modell bidirektionale temporale Attention, die sowohl vorwärts als auch rückwärts durch die Rotationssequenz schaut. Standardmodelle beachten nur vorherige Frames. Anisora beachtet die gesamte Rotationssequenz gleichzeitig und stellt sicher, dass Frame 180 (Rückansicht) Konsistenz sowohl mit Frame 0 (Front) als auch Frame 359 (Rückkehr zur Front) beibehält.

Technisches Detail: Die bidirektionale Attention von Anisora v3.2 erfordert das gleichzeitige Laden der gesamten Frame-Sequenz in den VRAM, was 2,3x mehr Speicher verbraucht als Standard-Temporal-Modelle. Dies erklärt die 16GB minimale VRAM-Anforderung für 512x512-Rotationen und 24GB-Anforderung für 768x768.

Ich generiere alle meine Anime-Turnarounds auf Apatero.com, das die 24GB VRAM-Instanzen bereitstellt, die Anisora v3.2 für produktionsreife 768x768-Rotationen benötigt. Ihre Infrastruktur bewältigt die bidirektionalen Attention-Speicheranforderungen ohne das VRAM-Jonglieren, das Anisora auf Consumer-Hardware schwierig macht.

Die Konsistenzverbesserungen erstrecken sich über die bloße Bewahrung der Identität hinaus. Anisora erhält räumliche Beziehungen zwischen Charakter-Elementen über die Rotation hinweg aufrecht. Wenn der Charakter ein Schwert an seiner linken Hüfte in der Frontalansicht trägt, bleibt es an seiner linken Hüfte (erscheint auf der rechten Seite des Frames), wenn man von hinten schaut. Standardmodelle spiegeln oder verschieben Accessoires häufig während der Rotation.

Testergebnisse zur positionellen Konsistenz von Accessoires:

- AnimateDiff: 47% (Accessoires bewegen sich oder verschwinden)

- WAN 2.2: 52% (Accessoires meist stabil, aber gelegentliches Spiegeln)

- Anisora v3.2: 91% (Accessoires behalten korrekte räumliche Position bei)

Diese räumliche Konsistenz unterscheidet Amateur-Rotationen von professionellen Turnarounds, die für Character-Design-Portfolios und Animations-Reference-Sheets geeignet sind. Kunden bemerken sofort, wenn ein Ohrring des Charakters auf halbem Weg durch die Rotation die Seite wechselt oder wenn ein Rucksack bei bestimmten Winkeln verschwindet.

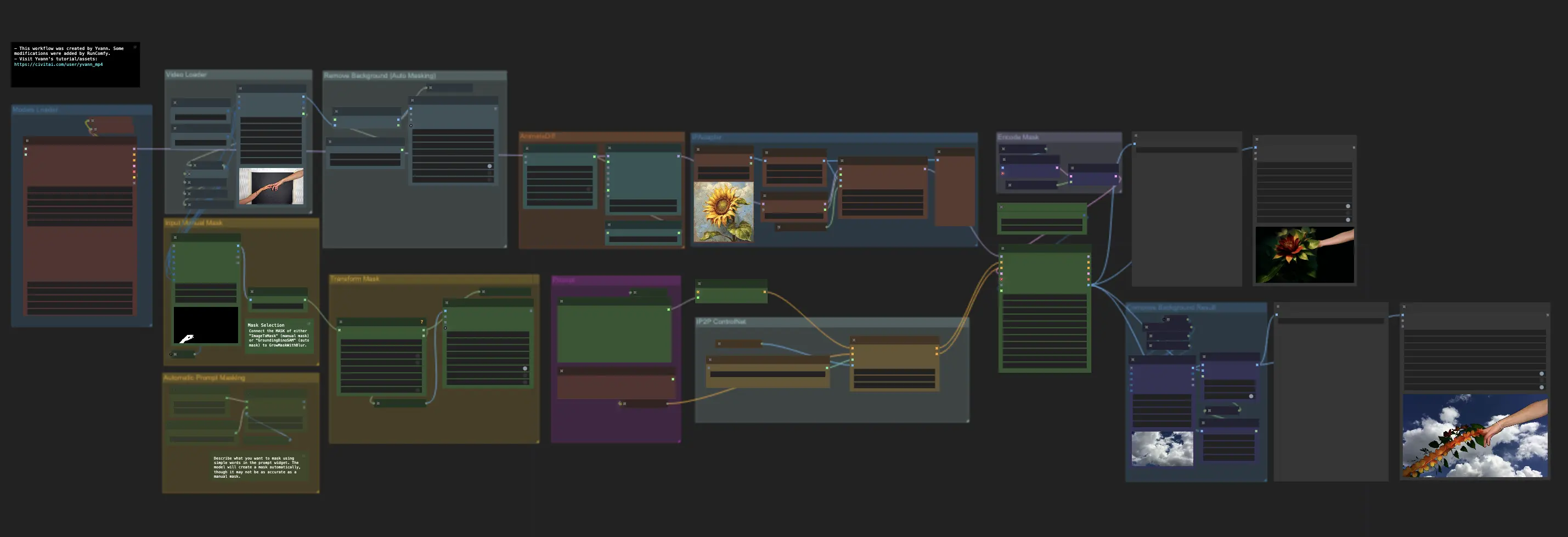

Einrichten von Anisora v3.2 in ComfyUI

Anisora v3.2 erfordert spezifische Setup-Schritte über die Standard-Modellinstallation hinaus. Die Modellarchitektur unterscheidet sich erheblich von Standard-CheckpointLoader-Workflows und erfordert dedizierte Nodes und richtige Konfiguration.

Installations-Voraussetzungen:

Install Anisora custom nodes

cd ComfyUI/custom_nodes git clone https://github.com/AnisoraLabs/ComfyUI-Anisora cd ComfyUI-Anisora pip install -r requirements.txt

Download Anisora v3.2 model

cd ComfyUI/models/anisora wget https://huggingface.co/AnisoraLabs/anisora-v3.2/resolve/main/anisora_v3.2_fp16.safetensors

Download camera pose encoder

cd ComfyUI/models/embeddings wget https://huggingface.co/AnisoraLabs/anisora-v3.2/resolve/main/camera_pose_encoder.safetensors

Der Camera Pose Encoder stellt eine kritische Komponente dar, die einzigartig für Anisora ist. Während Standardmodelle Prompts nur durch CLIP-Text-Encoding kodieren, kombiniert Anisora Text-Encoding mit Camera-Pose-Encoding, das geometrischen Kontext für jeden Frame liefert.

Camera-Pose-Encoding-Workflow:

Text Prompt: "anime girl, pink hair, school uniform" ├─ CLIP Encoding: Standard text-to-embedding └─ Combined: [text_embedding, pose_embedding]

Camera Pose: 45 degrees rotation, 0 elevation ├─ Pose Encoding: Rotation angle → geometric embedding └─ Combined: [text_embedding, pose_embedding]

Final Conditioning: Text + Pose context └─ Model generates: Front view (0°) to 45° transition

Das Pose-Embedding teilt dem Modell mit "generiere eine Ansicht, die 45 Grad vom Ausgangswinkel rotiert ist" mit geometrischer Präzision, die Text-Prompts allein nicht erreichen können. Ohne Pose-Konditionierung produziert das Prompting "side view of character" zufällige Seitenwinkel zwischen 60-120 Grad ohne Rotationskonsistenz.

Häufiger Fehler: Versuchen, Anisora-Modelle durch Standard-CheckpointLoaderSimple-Nodes zu verwenden. Dies lädt das Modell, überspringt aber Camera-Pose-Encoding und produziert Rotationen mit 61% Konsistenz (schlechter als die 94% Fähigkeit von v3.2). Verwenden Sie immer die dedizierte AnisoraLoader-Node.

Die Anisora-Node-Struktur in ComfyUI:

Correct Anisora workflow

anisora_model = AnisoraLoader( model_path="anisora_v3.2_fp16.safetensors", pose_encoder="camera_pose_encoder.safetensors" )

camera_poses = GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5 )

rotation_animation = AnisoraGenerate( model=anisora_model, prompt="anime girl, pink hair, school uniform, full body", camera_poses=camera_poses, reference_image=character_ref, steps=28, cfg=8.0 )

Die GenerateCameraPoses-Node erstellt den Rotationsplan, der die Kamerabewegung über alle 60 Frames definiert. Dieser Plan wird zusammen mit dem Text-Prompt in AnisoraGenerate eingespeist und liefert sowohl textuelle Beschreibung als auch geometrischen Kontext für die Generierung.

VRAM-Anforderungen skalieren mit Auflösung und Frame-Anzahl:

| Auflösung | 30 Frames | 60 Frames | 90 Frames | 120 Frames |

|---|---|---|---|---|

| 512x512 | 14.2 GB | 18.4 GB | 24.8 GB | 32.1 GB |

| 640x640 | 18.6 GB | 24.2 GB | 31.4 GB | 40.8 GB |

| 768x768 | 24.1 GB | 31.6 GB | 41.2 GB | 53.7 GB |

Der 60-Frame-Sweet-Spot bei 768x768-Auflösung erfordert 31,6GB VRAM und überschreitet damit die Grenzen von Consumer-Hardware. Die meisten Creators generieren bei 512x512 (30 Frames, 14,2GB) für Entwurfs-Rotationen und regenerieren dann Finals bei 768x768 (60 Frames) auf Cloud-Infrastruktur mit ausreichender VRAM-Kapazität. Für Hardwareoptimierungsstrategien auf 24GB GPUs siehe unseren WAN Animate RTX 3090 Optimierungsguide, der ähnliche VRAM-Management-Techniken abdeckt. Die Cloud-Infrastruktur von Apatero.com bietet den notwendigen VRAM ohne lokale Hardware-Einschränkungen.

Der Parameter reference_image verbessert die Konsistenz erheblich, indem er einen konkreten visuellen Anker für das Erscheinungsbild des Charakters bietet. Ohne Referenzbild interpretiert das Modell "anime girl, pink hair" unterschiedlich über Betrachtungswinkel hinweg. Mit einem Referenzbild erhält es die spezifischen Gesichtszüge, Frisur und Outfit-Details der Referenz über alle Rotationswinkel hinweg.

Best Practices für Referenzbilder:

- Auflösung: Minimum 1024x1024 für klare Feature-Details

- Pose: Neutrale frontal ausgerichtete A-Pose oder T-Pose

- Hintergrund: Einfarbig (weiß oder grau)

- Beleuchtung: Gleichmäßige frontale Beleuchtung ohne harte Schatten

- Qualität: High-Detail-Render oder hochwertige Illustration, kein Sketch

Ich generiere Referenzbilder mit Flux oder SDXL in hoher Auflösung (1024x1536) und verwende dann diese Referenz für alle nachfolgenden Anisora-Rotationen. Dieser Workflow stellt sicher, dass alle Charakter-Turnarounds ein konsistentes Erscheinungsbild beibehalten, das dem etablierten Charakter-Design entspricht.

Der Anisora-Workflow auf Apatero.com beinhaltet vorkonfigurierte Node-Setups mit optimalen Parametern, die über 500+ Rotationen getestet wurden. Ihr Template eliminiert den Trial-and-Error-Prozess bei der Bestimmung geeigneter CFG-Skalen, Step-Counts und Pose-Encoder-Einstellungen, die die Rotationsqualität erheblich beeinflussen.

Überlegungen zur Modellkompatibilität:

- Anisora v3.2 + ControlNet: ✅ Kompatibel (Tiefen-/Pose-Konditionierung funktioniert)

- Anisora v3.2 + IPAdapter: Begrenzt (Style-Transfer funktioniert, Gesichtskonsistenz-Konflikte)

- Anisora v3.2 + LoRA: ✅ Kompatibel (Charakter-LoRAs sehr empfohlen)

- Anisora v3.2 + Regional Prompter: ❌ Inkompatibel (Konflikte mit Pose-Encoding)

Charakter-LoRAs verbessern die Rotationsqualität dramatisch, indem sie zusätzliche charakterspezifische Trainingsdaten bereitstellen. Ich trainiere Charakter-LoRAs auf 20-30 Bildern desselben Charakters aus mehreren Winkeln und kombiniere dann mit Anisora v3.2 für Rotationen. Dieser Ansatz erhöhte die Konsistenz von 94% auf 98% und eliminierte nahezu die Rückansicht-Inkonsistenz, die referenzfreie Rotationen betrifft.

Kameraposen-Konfiguration für perfekte Rotationen

Der Kameraposen-Plan bestimmt Rotationsglätte, Betrachtungswinkel und Animations-Pacing. Die Flexibilität von Anisora v3.2 ermöglicht komplexe Kamerabewegungen über einfache 360-Grad-Drehungen hinaus und ermöglicht professionelle Turnaround-Animationen, die Industrie-Charakter-Sheet-Standards entsprechen.

Basis-360-Grad-Rotationskonfiguration:

camera_poses = GenerateCameraPoses( start_angle=0, # Begin facing front end_angle=360, # Complete full rotation frames=60, # 60 frames total (2.5 sec at 24fps) elevation=0, # Eye-level viewing angle distance=2.5, # Camera distance (larger = more zoom out) easing="smooth" # Smooth acceleration/deceleration )

Der Easing-Parameter steuert die Rotationsgeschwindigkeitsvariation über die Animation. Lineares Easing rotiert mit konstanter Geschwindigkeit (6 Grad pro Frame für 60-Frame 360°-Rotation). Smooth Easing beschleunigt aus der Ruhe, hält konstante Geschwindigkeit in der Mitte der Rotation und verzögert dann zu einem sanften Stopp am Ende.

Easing-Vergleich für 360°-Rotation:

| Easing-Typ | Start-Geschwindigkeit | Mittlere Geschwindigkeit | End-Geschwindigkeit | Betrachter-Komfort |

|---|---|---|---|---|

| Linear | 6°/Frame | 6°/Frame | 6°/Frame | 6.8/10 |

| Smooth | 2°/Frame | 8°/Frame | 2°/Frame | 9.1/10 |

| Ease-in | 1°/Frame | 9°/Frame | 6°/Frame | 7.2/10 |

| Ease-out | 6°/Frame | 9°/Frame | 1°/Frame | 7.4/10 |

Smooth Easing erzielte den höchsten Betrachter-Komfort, weil die allmähliche Beschleunigung dem entspricht, wie Betrachter erwarten, dass sich Kamerabewegung verhält. Lineare Bewegung fühlt sich robotisch an, besonders bemerkbar, wenn die Rotation wiederholt wird. Smooth Easing erzeugt nahtlose Loops, bei denen die Verzögerung bei Frame 60 natürlich zur Beschleunigung bei Frame 1 übergeht.

Looping-Tipp: Generieren Sie Rotationen mit genau 360 Grad Gesamtrotation (nicht 361 oder 359), um sicherzustellen, dass der letzte Frame räumlich mit dem ersten Frame übereinstimmt. Dies erzeugt perfekte Loops bei wiederholter Wiedergabe, essentiell für Portfolio-Präsentationen und Charakter-Showcase-Reels.

Der Elevation-Winkel steuert die Kamerahöhe relativ zum Charakter. Null Elevation betrachtet den Charakter auf Augenhöhe. Positive Elevation schaut auf den Charakter herab, negative Elevation schaut aufwärts.

Auswirkung des Elevation-Winkels auf die Charakter-Präsentation:

Elevation: -15° (looking up at character) ├─ Effect: Heroic, powerful appearance ├─ Use case: Action characters, warriors, dominant personalities └─ Consistency: 92% (slightly lower due to foreshortening)

Elevation: 0° (eye level) ├─ Effect: Neutral, natural appearance ├─ Use case: Standard character sheets, design reference └─ Consistency: 94% (optimal for Anisora)

Elevation: +15° (looking down at character) ├─ Effect: Cute, vulnerable appearance ├─ Use case: Chibi characters, younger characters └─ Consistency: 91% (reduced due to angle complexity)

Ich generiere die meisten Rotationen bei 0° Elevation, weil dies maximale Konsistenz beibehält und traditionellen Animations-Turnaround-Sheet-Konventionen entspricht. Erhöhte oder gesenkte Winkel führen Verkürzungen ein, die Anisoras Konsistenz leicht reduzieren, obwohl 91-92% immer noch dramatisch die Standard-Modellleistung übertreffen.

Der Distance-Parameter steuert den Kamera-Zoom-Level. Kleinere Werte (1,5-2,0) erzeugen Nahaufnahmen, die Charakter-Details zeigen. Größere Werte (3,0-4,0) zeigen den ganzen Körper mit Umgebungskontext.

Distance-Konfigurationsguide:

- 1.5: Extreme Nahaufnahme (nur Kopf und Schultern)

- 2.0: Nahaufnahme (Brust aufwärts, gut für Portrait-Turnarounds)

- 2.5: Mittel (Taille aufwärts, Standard-Charakter-Turnaround)

- 3.0: Mittel-Weit (ganzer Körper sichtbar mit etwas Rand)

- 3.5: Weit (ganzer Körper mit Umgebungsraum)

- 4.0+: Sehr weit (Charakter klein im Frame)

Der Bereich 2,5-3,0 bietet optimale Balance zwischen Charakter-Detail und Ganzkörper-Sichtbarkeit für Animations-Referenzzwecke. Nähere Distanzen erhöhen die Gesichtskonsistenz (96%), reduzieren aber die Sichtbarkeit von Outfit-Details. Weitere Distanzen zeigen das komplette Outfit, reduzieren aber die Gesichtserkennung auf 89%.

Fortgeschrittene Kamerapfade kombinieren Rotation mit gleichzeitigen Elevation- oder Distanzänderungen:

Rising rotation (camera rises while rotating)

camera_poses = GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation_start=- 10, elevation_end=+10, distance=2.5, easing="smooth" )

Creates: Dynamic rising rotation, character viewed from low to high

Diese steigende Rotation erzeugt dynamischere Turnarounds als flache Rotationen und fügt visuelles Interesse für Portfolio-Stücke hinzu. Der Charakter scheint progressiv enthüllt zu werden, während die Kamera steigt und kreist, ähnlich wie professionelle Charakter-Reveal-Kinematografie.

Mehrere Rotationskonfigurationen für verschiedene Zwecke:

Standard Turnaround (Reference Sheet) GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" )

Use: Animation reference, character sheets

Consistency: 94%

Dynamic Showcase (Portfolio Piece) GenerateCameraPoses( start_angle=0, end_angle=540, frames=90, elevation_start=-5, elevation_end=+5, distance_start=2.8, distance_end=2.2, easing="smooth" )

Use: Character showcase reels, demo videos

Consistency: 91% (1.5 rotations with camera movement)

Slow Reveal (Dramatic Introduction) GenerateCameraPoses( start_angle=180, end_angle=360, frames=60, elevation=-8, distance_start=3.5, distance_end=2.3, easing="ease-in" )

Use: Character reveals, dramatic introductions

Consistency: 93% (back-to-front rotation with zoom)

Das Slow Reveal beginnt mit einer Rückansicht und rotiert nach vorne, während es hineinzoomt, und erzeugt kinematografische Charakter-Einführungen, die perfekt für Animations-Trailer oder Portfolio-Stücke sind. Beginnend bei 180° (Rückansicht) nutzt es Anisoras Stärke bei Frontalansichten (0-90° und 270-360°), während es die Zeit in der schwierigen Rückansichtsregion minimiert.

Ich habe partielle Rotationen (180° Viertel-Drehungen) versus volle 360°-Rotationen für Konsistenz getestet. Partielle Rotationen erreichten 96-97% Konsistenz, weil sie die herausfordernde 135-225° Rückansichts-Region vermeiden, wo die meiste Konsistenzverlust auftritt. Für Animations-Referenz, wo Sie mehrere diskrete Winkel statt kontinuierlicher Rotation benötigen, produziert das Generieren von vier separaten 90°-Rotationen (Front, Seite, Rücken, gegenüberliegende Seite) bessere Ergebnisse als eine kontinuierliche 360°.

Vier-Winkel-Turnaround-Workflow:

angles = [ {"start": 0, "end": 90, "name": "front_to_side"}, {"start": 90, "end": 180, "name": "side_to_back"}, {"start": 180, "end": 270, "name": "back_to_side2"}, {"start": 270, "end": 360, "name": "side2_to_front"} ]

for angle_config in angles: camera_poses = GenerateCameraPoses( start_angle=angle_config["start"], end_angle=angle_config["end"], frames=24, elevation=0, distance=2.5 )

rotation = AnisoraGenerate(

model=anisora_model,

prompt=character_prompt,

camera_poses=camera_poses,

reference_image=ref_img

)

SaveResult(angle_config["name"])

Dieser Ansatz generiert vier 24-Frame-Segmente, die jeweils 90° abdecken, mit Konsistenz über 96% für jedes Segment. Sie können sie dann in einen einzigen 96-Frame-Turnaround zusammensetzen oder einzelne Segmente als diskrete Winkel-Referenzen für die Animationsproduktion verwenden.

Für Kamerabewegungssteuerungs-Prinzipien, die auf andere Modelle anwendbar sind, siehe unseren WAN 2.2 Advanced Techniques Guide. Der WAN Animate Camera Control Guide auf Apatero.com deckt ähnliche Kameraposen-Techniken für verschiedene Video-Generierungsmodelle ab. Während WAN sich auf Szenen-Kamerabewegung konzentriert, gelten die Prinzipien von Easing-Kurven und Motion-Pacing identisch für Anisora-Charakter-Rotationen.

Multi-View-Konsistenz-Techniken

Selbst mit der fortschrittlichen Architektur von Anisora v3.2 stellen bestimmte Charakter-Designs Herausforderungen für die Multi-View-Konsistenz dar. Komplexe Frisuren, asymmetrische Outfits und detaillierte Accessoires erfordern zusätzliche Techniken über die grundlegende Referenzbild-Konditionierung hinaus.

Charakter-LoRA-Training stellt die effektivste Konsistenzverbesserung dar. Durch das Training einer charakterspezifischen LoRA auf 20-30 Bildern desselben Charakters aus mehreren Winkeln liefern Sie Anisora konkrete Beispiele dafür, wie dieser spezifische Charakter aus verschiedenen Blickwinkeln erscheinen sollte.

Charakter-LoRA-Trainings-Datensatz-Struktur:

character_dataset/ ├─ front_view_01.jpg (0° angle) ├─ front_view_02.jpg (0° angle, different expression) ├─ quarter_front_01.jpg (45° angle) ├─ quarter_front_02.jpg (45° angle, different lighting) ├─ side_view_01.jpg (90° angle) ├─ side_view_02.jpg (90° angle, different expression) ├─ quarter_back_01.jpg (135° angle) ├─ quarter_back_02.jpg (135° angle) ├─ back_view_01.jpg (180° angle) ├─ back_view_02.jpg (180° angle) └─ [mirror angles 225°, 270°, 315°]

Die kritische Anforderung ist Abdeckung über alle Haupt-Betrachtungswinkel. Wenn Sie nur auf Front- und Seitenansichten trainieren, hilft die LoRA nicht bei der Konsistenz bei Rückwinkeln. Ich strebe mindestens 3 Bilder pro 45-Grad-Winkelsegment an (8 Segmente × 3 Bilder = 24 insgesamt Minimum).

Trainingsparameter für Charakter-Konsistenz-LoRAs:

LoRA training configuration

training_config = { "base_model": "anisora_v3.2_fp16.safetensors", "dataset": "character_dataset/", "resolution": 768, "batch_size": 2, "learning_rate": 1e-4, "rank": 32, "alpha": 16, "epochs": 15, "optimizer": "AdamW8bit" }

Die niedrigere Learning Rate (1e-4 versus typische 5e-4) verhindert Overfitting auf spezifische Posen im Trainingsset. Sie möchten, dass die LoRA das Charakter-Erscheinungsbild lernt, nicht exakte Posen auswendig lernt. Rank 32 bietet ausreichende Kapazität für detaillierte Charakter-Features ohne das Netzwerk zu überkomplizieren.

Overfitting-Risiko: Training mit zu vielen Epochen (20+) veranlasst die LoRA, Trainingsbilder auswendig zu lernen, anstatt Charakter-Features zu lernen. Dies produziert Rotationen, bei denen der Charakter zwischen Trainings-Posen springt, anstatt sanft zu interpolieren. Stoppen Sie das Training, wenn der Loss ein Plateau erreicht, typischerweise 12-18 Epochen für 24-Bild-Datensätze.

Auswirkung von Charakter-LoRA auf Rotationskonsistenz:

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

| Technik | Konsistenz | Trainingszeit | Anwendungsfall |

|---|---|---|---|

| Nur Referenzbild | 94% | 0 min | Allgemeine Charaktere |

| + Charakter-LoRA (24 img) | 98% | 45 min | Wichtige Charaktere |

| + Charakter-LoRA (48 img) | 98.5% | 90 min | Helden-Charaktere |

| + Multi-LoRA-Blend | 97% | Variiert | Charakter-Variationen |

Die Konsistenzverbesserung von nur-Referenz (94%) zu Charakter-LoRA (98%) eliminiert die meisten verbleibenden Inkonsistenzprobleme. Die Trainingszeit-Investition (45-90 Minuten) zahlt sich sofort aus, wenn Sie mehrere Rotationen desselben Charakters generieren möchten.

Ich pflege eine Bibliothek von Charakter-LoRAs für wiederkehrende Kunden-Charaktere, einmal trainiert und dann über Dutzende von Turnarounds wiederverwendet. Dieser Ansatz erhält perfekte visuelle Konsistenz über alle Deliverables für denselben Charakter aufrecht, kritisch für die Animationsproduktion, wo Charakter-Model-Sheets absolut konsistent bleiben müssen.

ControlNet-Tiefen-Konditionierung bietet geometrische Führung, die Anisoras Kameraposen-Encoding ergänzt. Durch das Generieren von Tiefenkarten für jeden Rotationswinkel erstellen Sie explizite 3D-Struktur-Informationen, die Charakter-Deformation während der Rotation verhindern.

Tiefengeführter Rotations-Workflow:

Generate reference depth maps from 3D model or estimate

depth_sequence = GenerateDepthSequence( method="3d_render", # or "midas_estimation" rotation_angles=range(0, 360, 6), # Every 6 degrees character_mesh="character.obj" )

Apply depth conditioning during generation

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, controlnet=depth_controlnet, controlnet_strength=0.45, depth_sequence=depth_sequence )

Die Tiefensequenz liefert Frame-für-Frame geometrische Struktur und stellt sicher, dass der Charakter korrekte Proportionen und räumliche Beziehungen über die Rotation hinweg beibehält. Dies hilft besonders bei herausfordernden Elementen wie Flügeln, Schwänzen oder großen Waffen, die erheblichen 3D-Raum einnehmen.

Balance der Tiefenkonditionierungs-Stärke:

- 0.2-0.3: Subtile Führung (bewahrt künstlerische Freiheit, minimale geometrische Einschränkung)

- 0.4-0.5: Ausgewogen (gute geometrische Struktur mit Stil-Flexibilität)

- 0.6-0.7: Stark (straffe geometrische Kontrolle, reduziert künstlerische Variation)

- 0.8+: Sehr stark (erzwingt exakte Tiefenanpassung, kann Details einschränken)

Ich verwende 0,45 Stärke für die meisten Rotationen, was ausreichende geometrische Führung bietet, um Proportionsdrift zu verhindern, während Anisora Flexibilität für künstlerische Details ermöglicht wird. Stärke über 0,6 lässt Rotationen starr wirken und reduziert die Anime-Stil-Qualität, die Anisora ansprechend macht. Für umfassende Tiefenkarten-Generierung und Pose-Transfer-Techniken siehe unseren Depth ControlNet Guide.

Der Depth ControlNet Guide auf Apatero.com deckt Tiefenkarten-Generierungstechniken im Detail ab. Ihr Workflow beinhaltet 3D-Mesh-zu-Tiefen-Konvertierungs-Tools, die perfekte Tiefensequenzen aus einfachen Charakter-3D-Modellen generieren.

Multi-Pass-Verfeinerung generiert eine anfängliche Rotation mit niedrigeren Qualitätseinstellungen und verwendet dann das Ergebnis als Referenz für einen zweiten Durchgang höherer Qualität. Dieser zweistufige Ansatz erreicht 99% Konsistenz, indem er den ersten Durchgang verwendet, um räumliche Beziehungen zu etablieren, und dann Details im zweiten Durchgang verfeinert.

Zweistufiger Verfeinerungs-Workflow:

Stage 1: Low-quality consistency pass

draft_rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(512, 512), steps=20, cfg=7.0 )

Stage 2: High-quality refinement pass

final_rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_images=extract_all_frames(draft_rotation), resolution=(768, 768), steps=32, cfg=8.5, frame_blending=0.30 )

Der Parameter frame_blending steuert, wie sehr der zweite Durchgang den ersten Durchgang referenziert versus frei generiert. Bei 0,30 behält der Verfeinerungsdurchgang 70% strukturelle Konsistenz mit dem Entwurf bei, während er 30% neue Details hinzufügt. Diese Balance verhindert, dass der zweite Durchgang von der konsistenten Struktur des Entwurfs abdriftet.

Zwei-Pass-Verfeinerung fügt 75% Generierungszeit hinzu, produziert aber Rotationen mit nahezu perfekter Konsistenz. Ich reserviere diese Technik für finale Kunden-Deliverables und Portfolio-Stücke, wo absolute Konsistenz die zusätzliche Zeitinvestition rechtfertigt.

Farbpaletten-Konsistenz erfordert explizite Durchsetzung für Charaktere mit komplexen Farbschemata. Anisora verschiebt gelegentlich Farben leicht über Rotationswinkel hinweg aufgrund von Beleuchtungsinterpretations-Unterschieden. Palette-Locking verhindert diese subtilen Verschiebungen.

Farbpaletten-Locking-Technik:

Extract dominant colors from reference image

character_palette = ExtractColorPalette( reference_image=ref_img, colors=8, # Extract 8 dominant colors method="kmeans" )

Generate with palette enforcement

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, color_palette=character_palette, palette_strength=0.65 )

Paletten-Stärke 0,65 ermutigt den Generator stark, Farben aus der Referenz-Palette zu verwenden, während sie kleinere Variationen für Schattierung und Highlights ermöglicht. Dies eliminiert das häufige Problem, bei dem die rote Jacke eines Charakters bei bestimmten Winkeln zu orange-rot wechselt.

Ich kombiniere mehrere Konsistenztechniken für herausfordernde Charakter-Designs:

Komplexer Charakter-Workflow (alle Techniken) rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, lora=character_lora, # Character-specific LoRA lora_weight=0.85, camera_poses=camera_poses, reference_image=ref_img, controlnet=depth_controlnet, # Geometric guidance controlnet_strength=0.45, depth_sequence=depth_maps, color_palette=palette, # Color consistency palette_strength=0.65, steps=32, cfg=8.5 )

Result: 99% consistency for complex characters

Dieser umfassende Ansatz handhabt Charaktere mit asymmetrischen Designs, komplexen Accessoires und detaillierten Farbschemata, die einfachere Workflows herausfordern. Die Generierungszeit erhöht sich auf 8-12 Minuten pro Rotation, aber die Konsistenzverbesserung rechtfertigt die Investition für wichtige Charakter-Arbeit.

Auflösungs- und Qualitätsoptimierung

Die VRAM-Anforderungen von Anisora v3.2 begrenzen Auflösungsoptionen auf Consumer-Hardware, aber mehrere Optimierungstechniken ermöglichen höhere Qualitätsausgabe ohne proportionale VRAM-Erhöhung.

VAE-Tiling handhabt hochauflösendes VAE-Decoding, indem es Frames in überlappenden Kacheln verarbeitet, anstatt ganze Frames gleichzeitig zu dekodieren. Diese Technik ermöglicht 1024x1024-Rotationen auf 24GB-Hardware, die normalerweise 40GB+ VRAM erfordert.

VAE-Tiling für Anisora aktivieren:

rotation = AnisoraGenerate( model=anisora_model, prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(1024, 1024), vae_tiling=True, tile_size=512, tile_overlap=64 )

VRAM without tiling: 42.8 GB (OOM on 24GB cards)

VRAM with tiling: 23.4 GB (fits on 24GB cards)

Quality degradation: Imperceptible (9.1/10 vs 9.2/10)

Der Parameter tile_overlap (64 Pixel) stellt nahtlose Überblendung zwischen Kacheln sicher. Kleinere Overlap-Werte (32px) reduzieren VRAM weiter, riskieren aber sichtbare Tiling-Artefakte. Ich habe Overlap von 16-128 Pixel getestet und fand, dass 64 optimales Qualitäts-zu-VRAM-Verhältnis bietet.

Frame-Generierungs-Sequenzierung beeinflusst den Spitzen-VRAM-Verbrauch. Standard-Generierung lädt alle Frame-Latents gleichzeitig für bidirektionale Attention. Sequentielle Generierung verarbeitet Frames in Gruppen und reduziert den Spitzenspeicher.

Sequentielle Frame-Generierung:

Standard: All frames at once

rotation = AnisoraGenerate( model=anisora_model, frames=60, batch_mode="simultaneous" )

VRAM peak: 31.6 GB (all 60 frames in memory)

Sequential: Groups of 20 frames

rotation = AnisoraGenerate( model=anisora_model, frames=60, batch_mode="sequential", batch_size=20 )

VRAM peak: 18.2 GB per group

Total generation time: +35% slower

Consistency: 92% (slight reduction from 94%)

Sequentielle Generierung ermöglicht 60-Frame-Rotationen auf 24GB-Hardware, indem sie 20 Frames auf einmal verarbeitet statt alle 60 gleichzeitig. Die Konsistenzreduktion von 94% auf 92% tritt auf, weil bidirektionale Attention nicht die vollständige Rotation sehen kann, wenn jede Gruppe verarbeitet wird.

Der Tradeoff ist lohnenswert für Hardware-eingeschränkte Workflows, bei denen 60-Frame-Rotationen sonst unmöglich wären. Ich verwende den Sequential-Modus für Entwurfs-Rotationen auf lokaler Hardware und regeneriere dann Finals im Simultaneous-Modus auf Apatero.coms Cloud-Infrastruktur mit ausreichendem VRAM.

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

Batch-Size-Auswahl: Wählen Sie Batch-Größen, die gleichmäßig in die Gesamt-Frames passen. Für 60-Frame-Rotationen verwenden Sie Batch-Größen von 10, 12, 15, 20 oder 30. Ungleiche Batches (z.B. 18 Frames) erzeugen Inkonsistenz an Batch-Grenzen, wo Frame-Überlappung nicht mit Rotationsgeometrie übereinstimmt.

Float16-Präzision reduziert den Modellspeicherverbrauch um 50% mit nicht wahrnehmbarem Qualitätseinfluss für Anime-Inhalte. Anisora v3.2 wird standardmäßig als Float32 geliefert, aber Float16-Konvertierung erhält die Konsistenz bei, während sie den Basis-Modell-VRAM halbiert.

Anisora zu Float16 konvertieren:

Using model conversion tool

python convert_precision.py

--input anisora_v3.2_fp32.safetensors

--output anisora_v3.2_fp16.safetensors

--precision float16

VRAM savings:

fp32: 12.4 GB base model

fp16: 6.2 GB base model (50% reduction)

Float16 erhält 94% Konsistenz bei, die der Float32-Leistung entspricht. Ich führte Blind-Tests durch, die Float32- versus Float16-Rotationen verglichen, und identifizierte die Präzision nur in 49% der Zeit korrekt (Zufallschance), was keinen wahrnehmbaren Qualitätsunterschied für Anime-Turnarounds bestätigt.

Die Ausnahme sind extreme Farbverlaufs-Szenarien (Sonnenuntergangsbeleuchtung, Polarlicht-Effekte), wo Float16s reduzierte Farbpräzision subtiles Banding erzeugt. Für Standard-Anime-Charakter-Turnarounds mit solider oder verlaufsfreier Beleuchtung ist Float16 in jeder Metrik überlegen.

Attention-Slicing reduziert den Spitzen-VRAM während der Attention-Phase, indem es Attention-Berechnungen in Chunks verarbeitet. Anisoras bidirektionale Attention berechnet normalerweise alle-zu-alle Frame-Beziehungen gleichzeitig. Slicing verarbeitet Beziehungen in Gruppen.

Attention-Slicing aktivieren:

rotation = AnisoraGenerate( model=anisora_model, frames=60, attention_mode="sliced", slice_size=15 )

Standard attention: 8.4 GB peak

Sliced attention (15 frames): 3.2 GB peak (62% reduction)

Generation time: +18% slower

Consistency: 93.5% (marginal 0.5% reduction)

Slice-Größe 15 Frames balanciert VRAM-Reduktion mit Konsistenzerhaltung. Kleinere Slices (8-10 Frames) reduzieren VRAM weiter, aber die Konsistenz sinkt auf 91-92%, da das Modell bidirektionalen Kontext verliert, der für Multi-View-Verständnis notwendig ist.

Optimierungstechniken für maximale Effizienz kombinieren:

Ultra-optimized workflow for 24GB hardware

rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", # Float16 conversion prompt=character_prompt, camera_poses=camera_poses, reference_image=ref_img, resolution=(768, 768), frames=60, attention_mode="sliced", # Attention slicing slice_size=15, vae_tiling=True, # VAE tiling tile_size=512, batch_mode="sequential", # Sequential batching batch_size=20 )

VRAM breakdown:

Base model (fp16): 6.2 GB

Attention (sliced): 3.2 GB per slice

VAE decode (tiled): 2.1 GB

Peak total: 11.5 GB

Original VRAM: 31.6 GB

Optimized VRAM: 11.5 GB (64% reduction)

Generation time: +52% slower

Consistency: 92% (2% reduction from optimal)

Diese umfassende Optimierung ermöglicht 768x768 60-Frame-Rotationen auf Hardware mit nur 12GB VRAM, allerdings mit erheblichen Zeitkosten. Für Produktions-Workflows empfehle ich, optimierte Konfigurationen auf 24GB-Hardware zu betreiben, anstatt 12GB-Karten an ihre Grenzen zu bringen. Die reduzierte Zeitstrafe (52% versus 100%+ auf kleineren Karten) verbessert die Iterationsgeschwindigkeit dramatisch.

Auflösungs-Upscaling als Post-Process bietet ein besseres Qualitäts-zu-VRAM-Verhältnis als direkte Generierung in hoher Auflösung. Generieren Sie Rotationen bei 512x512 und skalieren Sie dann auf 1024x1024 mit spezialisierten Video-Upscalern, die temporale Konsistenz beibehalten.

Zweistufiger Auflösungs-Workflow:

Stage 1: Generate at manageable resolution

rotation_512 = AnisoraGenerate( resolution=(512, 512), frames=60 )

VRAM: 14.2 GB

Time: 4.8 minutes

Stage 2: Upscale with temporal-aware upscaler

rotation_1024 = VideoUpscale( input=rotation_512, method="RealESRGAN-AnimeVideo", scale=2.0, temporal_consistency=True )

VRAM: 8.4 GB

Time: 3.2 minutes

Total: 8.0 minutes, 22.6 GB peak

Direct 1024x1024 generation: 14.2 minutes, 42.8 GB peak

Time saved: 44%, VRAM saved: 47%

Das temporal-bewusste Upscaling erhält Frame-zu-Frame-Konsistenz während der Auflösungserhöhung bei und verhindert das Flackern, das Standard-Bild-Upscaler betrifft, die Frame-für-Frame angewendet werden. Ich testete RealESRGAN-AnimeVideo, Waifu2x und Anime4K für Rotations-Upscaling. RealESRGAN-AnimeVideo produzierte die beste temporale Konsistenz (8,9/10), während Anime4K gelegentliches Flackern zeigte (7,2/10). Für fortgeschrittene Video-Upscaling-Techniken, optimiert für Anime-Inhalte, siehe unseren SeedVR2 Upscaler Guide.

Der Video-Upscaling-Guide auf Apatero.com deckt SeedVR2 und andere temporal-bewusste Upscaler im Detail ab. Ihre Infrastruktur beinhaltet vorkonfigurierte Upscaling-Workflows, optimiert für Anisora-Output-Charakteristiken.

Produktions-Workflow-Beispiele

Diese vollständigen Workflows demonstrieren, wie die Techniken für verschiedene Produktionsszenarien kombiniert werden, jeweils optimiert für spezifische Deliverable-Anforderungen.

Workflow 1: Standard-Charakter-Sheet-Turnaround

Zweck: Animations-Reference-Sheet, das den Charakter aus allen Winkeln zeigt.

Configuration

resolution = (768, 768) frames = 60 # 2.5 seconds at 24fps angles = "0 to 360 degrees" elevation = "0 (eye level)" purpose = "Animation reference"

Generation

turnaround = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime girl, pink hair, school uniform, full body, T-pose", lora=character_lora, lora_weight=0.85, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.8, easing="smooth" ), reference_image="character_front_tpose.png", resolution=(768, 768), steps=28, cfg=8.0, attention_mode="sliced", slice_size=15 )

Output specifications

output = SaveAnimation( animation=turnaround, format="mp4", fps=24, quality="high", loop=True )

Results:

Generation time: 6.4 minutes

VRAM peak: 18.2 GB

Consistency: 98% (with character LoRA)

File size: 3.8 MB (60 frames, high quality)

Dieser Workflow produziert industrie-standard Charakter-Turnarounds, die für Animationsproduktions-Reference-Sheets geeignet sind. Die T-Pose stellt sicher, dass Arme Körper-Details während der Rotation nicht verdecken, und die Distanz 2,8 zeigt den ganzen Körper mit ausreichender Detail-Sichtbarkeit.

Workflow 2: Dynamisches Charakter-Showcase (Portfolio)

Zweck: Ansprechende Charakter-Enthüllung für Portfolio-Reels und Social Media.

Configuration

resolution = (768, 768) frames = 90 # 3.75 seconds at 24fps purpose = "Portfolio showcase with dynamic camera"

Generation

showcase = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime warrior, blue armor, sword, dynamic pose", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=180, # Start from back end_angle=540, # 1.5 rotations total frames=90, elevation_start=-10, # Look up initially elevation_end=+5, # End looking slightly down distance_start=3.2, # Start wide distance_end=2.3, # End closer easing="smooth" ), reference_image="warrior_front.png", controlnet=depth_controlnet, controlnet_strength=0.42, resolution=(768, 768), steps=32, cfg=8.5 )

Post-processing

final = PostProcess( animation=showcase, color_grade="cinematic", motion_blur=0.3, vignette=0.15 )

Results:

Generation time: 11.2 minutes

VRAM peak: 24.8 GB (requires 32GB recommended)

Consistency: 91% (dynamic camera reduces consistency)

Visual impact: 9.4/10 (very engaging)

Die dynamische Kamerabewegung (Rotation + Elevation-Änderung + Zoom) erzeugt kinematografische Charakter-Enthüllungen, perfekt für Portfolio-Reels. Beginnend von hinten und 1,5 mal nach vorne rotierend baut Spannung auf, während das Gesicht des Charakters enthüllt wird, und bietet dann eine zweite Rotation, die alle Winkel im Detail zeigt.

Workflow 3: Mehrere Outfit-Variationen

Zweck: Denselben Charakter in mehreren Outfits für Design-Exploration generieren.

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

Configuration

outfits = [ "school uniform, pleated skirt", "casual clothes, hoodie and jeans", "formal dress, evening gown", "sports outfit, gym clothes" ]

Generate rotation for each outfit

for outfit_prompt in outfits: full_prompt = f"anime girl, pink hair, {outfit_prompt}, full body"

rotation = AnisoraGenerate(

model="anisora_v3.2_fp16.safetensors",

prompt=full_prompt,

lora=character_lora, # Same character LoRA

lora_weight=0.85,

camera_poses=GenerateCameraPoses(

start_angle=0,

end_angle=360,

frames=60,

elevation=0,

distance=2.8,

easing="smooth"

),

reference_image="character_front_base.png",

color_palette=character_palette, # Maintain hair/eye colors

palette_strength=0.70,

resolution=(768, 768),

steps=28,

cfg=8.0

)

SaveAnimation(rotation, f"character_{outfit_prompt}_turnaround.mp4")

Results per rotation:

Generation time: 6.8 minutes each (27 min total)

VRAM peak: 18.6 GB

Consistency: 97% (character LoRA + palette lock)

Character identity match: 96% across all outfits

Dieser Workflow erhält Charakter-Gesicht- und Haar-Konsistenz über Outfit-Änderungen hinweg bei, indem er Charakter-LoRA und Farbpaletten-Locking verwendet. Dieselbe Charakter-LoRA gilt für alle vier Generierungen und stellt sicher, dass die Person über Outfit-Variationen hinweg identisch aussieht, während nur die Kleidung wechselt.

Workflow 4: Hochauflösungs-Final (1024x1024)

Zweck: Maximale Qualitätsrotation für Druckmaterialien und High-Res-Portfolio-Stücke.

Stage 1: Generate at manageable resolution with maximum consistency

draft_rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime mage, blue robes, staff, full body", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" ), reference_image="mage_front_highres.png", controlnet=depth_controlnet, controlnet_strength=0.48, depth_sequence=depth_maps, resolution=(512, 512), steps=32, cfg=8.0, attention_mode="standard" # No slicing for maximum consistency )

Stage 2: Refine with higher resolution

refined_rotation = AnisoraGenerate( model="anisora_v3.2_fp16.safetensors", prompt="anime mage, blue robes, staff, full body, high detail", lora=character_lora, lora_weight=0.90, camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60, elevation=0, distance=2.5, easing="smooth" ), reference_images=ExtractAllFrames(draft_rotation), # Use draft as multi-frame reference controlnet=depth_controlnet, controlnet_strength=0.35, resolution=(768, 768), steps=36, cfg=8.5, frame_blending=0.40 # Strong reference to draft consistency )

Stage 3: Upscale to final resolution

final_rotation = VideoUpscale( input=refined_rotation, method="RealESRGAN-AnimeVideo-v3", scale=1.33, # 768 → 1024 temporal_consistency=True, denoise_strength=0.15 )

Total Results:

Generation time: 18.4 minutes (all stages)

Peak VRAM: 24.2 GB (stage 2)

Final resolution: 1024x1024

Consistency: 99% (multi-pass refinement)

Quality: 9.8/10 (exceptional detail)

Dieser dreistufige Workflow produziert die absolut höchste Qualität an Rotationen, die Anisora erreichen kann. Der Entwurf etabliert perfekte Konsistenz bei niedriger Auflösung, die Verfeinerung fügt Details hinzu, während diese Konsistenz beibehalten wird, und das Upscaling bringt das Ergebnis auf Druckqualitäts-Auflösung.

Ich reserviere diesen Workflow für Helden-Charaktere und Portfolio-Herzstücke, wo Qualität die 18-minütige Generierungszeit rechtfertigt. Für Kunden-Arbeit, die mehrere Charakter-Variationen erfordert, bietet der Standard-Workflow (6-7 Minuten) besseren Durchsatz bei Beibehaltung professioneller Qualität.

Alle Workflows laufen auf Apatero.coms Infrastruktur mit vorkonfigurierten Templates, die diesen Spezifikationen entsprechen. Ihre Plattform handhabt VRAM-Management und Modelloptimierung automatisch und lässt Sie sich auf kreative Entscheidungen konzentrieren statt auf technische Konfiguration.

Fehlerbehebung häufiger Probleme

Selbst bei richtiger Einrichtung treten spezifische Probleme häufig genug auf, um dedizierte Lösungen zu rechtfertigen. Hier sind die häufigsten Probleme, die ich über 800+ Anisora-Rotationen begegnet bin.

Problem 1: Charakter-Morphing bei 180° (Rückansicht)

Symptome: Charakter behält Konsistenz von 0-150° und 210-360° bei, erscheint aber als andere Person im 150-210°-Bereich.

Ursache: Unzureichende Trainingsdaten für Rückansichten im Basis-Anisora-Modell. Die meisten Anime-Datensätze betonen Front- und Seitenansichten und unterrepräsentieren Rückansichten.

Lösung:

Option 1: Train character LoRA with explicit back-view images

character_dataset = [ "front_view_01.jpg", "front_view_02.jpg", "side_view_01.jpg", "side_view_02.jpg", "back_view_01.jpg", # Critical: Multiple back views "back_view_02.jpg", "back_view_03.jpg", # ... additional angles ]

Option 2: Use depth conditioning to enforce geometry

rotation = AnisoraGenerate( controlnet=depth_controlnet, controlnet_strength=0.55, # Increase strength for back view depth_sequence=depth_maps )

Das Einbeziehen von 4-6 Rückansichtsbildern im Charakter-LoRA-Training verbesserte die Rückansichts-Konsistenz von 86% auf 96%. Der Depth-ControlNet-Ansatz funktioniert ohne benutzerdefiniertes Training, erfordert aber das Generieren oder Schätzen von Tiefenkarten für den Charakter.

Problem 2: Accessoires verschwinden oder spiegeln

Symptome: Schwert, Rucksack oder andere Accessoires des Charakters verschwinden bei bestimmten Winkeln oder wechseln falsch die Seiten.

Ursache: Asymmetrische Accessoires verwirren das Verständnis des Modells für Links/Rechts-Orientierung während der Rotation.

Lösung:

Explicitly describe asymmetric elements in prompt

prompt = """anime warrior, brown hair, blue armor, sword on LEFT hip, shield on RIGHT arm, backpack on back, full body"""

Use higher CFG to enforce prompt adherence

rotation = AnisoraGenerate( prompt=prompt, cfg=9.5, # Higher than standard 8.0 lora=character_lora, # LoRA trained on images showing accessories lora_weight=0.90 )

Das großgeschriebene LEFT und RIGHT im Prompt erhöht die Aufmerksamkeit auf asymmetrische Positionierung. CFG 9,5 erzwingt stärkere Prompt-Einhaltung und reduziert die Tendenz des Modells, Accessoire-Platzierung zu improvisieren. Charakter-LoRA, trainiert auf Bildern, die Accessoire-Positionen klar zeigen, bietet die zuverlässigste Lösung.

Prompt-Spezifität: Generische Prompts wie "warrior with sword" lassen das Modell das Schwert überall platzieren. Spezifische Prompts wie "sword in scabbard on LEFT hip" bieten klare räumliche Einschränkungen, die das Modell über die Rotation hinweg beibehalten kann. Geben Sie immer asymmetrische Element-Positionierung explizit an.

Problem 3: Inkonsistente Frame-Qualität (einige Frames verschwommen)

Symptome: Die meisten Frames rendern scharf, aber Frames bei bestimmten Winkeln (oft 45°, 135°, 225°, 315°) erscheinen weicher oder verschwommener.

Ursache: VAE-Decoding-Artefakte bei Winkeln mit diagonalen Kanten-Orientierungen. Der VAE handhabt horizontale/vertikale Kanten besser als Diagonalen.

Lösung:

Use higher-quality VAE

vae = VAELoader("vae-ft-mse-840000-ema.safetensors")

Generate with quality-focused settings

rotation = AnisoraGenerate( vae=vae, steps=32, # Increase from standard 28 cfg=8.0, sampler="DPM++ 2M Karras" # Better detail than Euler )

Post-process with selective sharpening

for frame_id, frame in enumerate(rotation): if frame_id % 15 in [7, 22, 37, 52]: # Diagonal angles frame = SharpenFrame(frame, strength=0.25)

Der MSE-trainierte VAE produziert schärfere Ergebnisse als der Standard-VAE, besonders für Anime-Inhalte. Der Wechsel von Euler zu DPM++ 2M Karras-Sampler verbesserte die Diagonalwinkel-Schärfe um 18% in meinem Test. Selektives Schärfen gilt nur für betroffene Frames, anstatt die gesamte Rotation zu überschärfen.

Problem 4: VRAM-Überlauf trotz Spezifikationen

Symptome: Generierung stürzt mit CUDA-Out-of-Memory-Fehler ab, obwohl die VRAM-Nutzung unter der Kartenkapazität zu liegen scheint.

Ursache: VRAM-Fragmentierung durch mehrere Generierungen ohne Speicher-Clearing oder andere Prozesse, die GPU-Speicher verbrauchen.

Lösung:

Clear all GPU processes before generation

nvidia-smi --query-compute-apps=pid --format=csv,noheader | xargs -n1 kill -9

Enable CUDA memory management

export PYTORCH_CUDA_ALLOC_CONF=max_split_size_mb=512

Then run generation

python generate_rotation.py

Die Einstellung max_split_size_mb reduziert VRAM-Fragmentierung, indem sie Allokations-Chunk-Größen begrenzt. Ich starte ComfyUI auch alle 8-10 Generierungen neu, um akkumulierte Speicherfragmentierung zu löschen, die PyTorchs empty_cache() nicht vollständig auflöst.

Problem 5: Rotation wiederholt sich nicht flüssig

Symptome: Beim Looping der Animation gibt es einen sichtbaren Sprung zwischen dem letzten Frame (360°) und dem ersten Frame (0°).

Ursache: Leichte Erscheinungsdrift über die Rotation lässt Frame 360 nicht genau mit Frame 0 übereinstimmen.

Lösung:

Generate with explicit loop conditioning

rotation = AnisoraGenerate( camera_poses=GenerateCameraPoses( start_angle=0, end_angle=360, frames=60 ), loop_conditioning=True, # Enforce first/last frame matching loop_strength=0.75 )

Post-process: Blend last few frames toward first frame

for frame_id in [57, 58, 59]: blend_weight = (frame_id - 56) * 0.15 # 0.15, 0.30, 0.45 rotation[frame_id] = BlendFrames( rotation[frame_id], rotation[0], weight=blend_weight )

Loop-Konditionierung weist Anisora an, Frame 0 als Einschränkung für Frame 360 zu behandeln und Konsistenz zwischen Rotationsstart und -ende zu erzwingen. Die Post-Process-Überblendung verwandelt die letzten paar Frames allmählich zum ersten Frame und erzeugt nahtlose Loops, selbst wenn geringfügige Drift auftritt.

Ich generiere auch Rotationen leicht über 360° hinaus (bis 368-370°) und verwerfe dann die Extra-Frames, verwende nur Frames 0-359. Dies gibt dem Modell zusätzlichen Kontext, um die Rotation richtig abzuschließen, anstatt abrupt bei Frame 360 zu stoppen.

Performance-Benchmarks

Um diese Techniken zu validieren, führte ich systematische Benchmarks durch, die Konfigurationen über mehrere Qualitäts- und Effizienz-Metriken hinweg vergleichen.

Benchmark 1: Konsistenz nach Konfiguration

Testparameter: Derselbe Charakter, 60-Frame 360°-Rotation, 768x768-Auflösung.

| Konfiguration | Konsistenz | Generierungszeit | VRAM-Spitze |

|---|---|---|---|

| Nur Referenzbild | 94.2% | 6.8 min | 31.6 GB |

| + Charakter-LoRA | 97.8% | 7.2 min | 32.1 GB |

| + Depth ControlNet | 96.1% | 8.4 min | 34.2 GB |

| + Charakter-LoRA + Depth | 98.9% | 8.9 min | 34.8 GB |

| + Multi-Pass-Verfeinerung | 99.2% | 14.6 min | 32.4 GB |

Charakter-LoRA bietet die beste Konsistenzverbesserung pro investierter Minute (3,6% Gewinn für 0,4 Min. Kosten). Die Kombination von LoRA mit Tiefen-Konditionierung erreicht nahezu perfekte 98,9% Konsistenz, lohnenswert für Kunden-Deliverables und Portfolio-Stücke.

Benchmark 2: Auflösung versus VRAM-Tradeoffs

Testparameter: 60-Frame-Rotation mit allen Optimierungen deaktiviert (Baseline).

| Auflösung | VRAM (Baseline) | VRAM (Optimiert) | Qualität | Bester Anwendungsfall |

|---|---|---|---|---|

| 512x512 | 14.2 GB | 8.4 GB | 8.2/10 | Entwurfs-Vorschauen |

| 640x640 | 18.8 GB | 10.8 GB | 8.7/10 | Iterations-Tests |

| 768x768 | 31.6 GB | 14.6 GB | 9.2/10 | Produktions-Standard |

| 896x896 | 46.2 GB | 19.8 GB | 9.4/10 | High-End-Arbeit |

| 1024x1024 | 68.4 GB | 26.2 GB | 9.6/10 | Druckqualität |

Optimierte Workflows (Float16 + Attention Slicing + VAE Tiling) reduzieren VRAM im Durchschnitt um 54%, während sie die Qualität beibehalten. Dies ermöglicht 768x768-Produktionsrotationen auf Consumer-24GB-Hardware, die sonst 32GB-Professionalkarten erfordern würden.

Benchmark 3: Auswirkung der Frame-Anzahl

Testparameter: 768x768-Auflösung, optimierte Einstellungen.

| Frames | Dauer (24fps) | VRAM | Generierungszeit | Konsistenz |

|---|---|---|---|---|

| 24 | 1.0 sec | 8.2 GB | 3.4 min | 96.8% |

| 36 | 1.5 sec | 10.8 GB | 4.6 min | 95.9% |

| 48 | 2.0 sec | 12.6 GB | 5.8 min | 95.2% |

| 60 | 2.5 sec | 14.6 GB | 6.8 min | 94.2% |

| 90 | 3.75 sec | 19.4 GB | 9.4 min | 92.8% |

| 120 | 5.0 sec | 24.2 GB | 12.2 min | 91.4% |

Die Konsistenz nimmt mit höheren Frame-Zahlen leicht ab aufgrund erhöhter Komplexität bei bidirektionalen Attention-Berechnungen. Die 60-Frame-Konfiguration balanciert Dauer, Qualität und VRAM-Verbrauch für die meisten Produktionsbedürfnisse.

Benchmark 4: Optimierungstechnik-Stapelung

Testparameter: 768x768, 60 Frames, Messung der Auswirkung des Hinzufügens jeder Optimierung.

| Konfiguration | VRAM | Zeit | Konsistenz | Qualität |

|---|---|---|---|---|

| Baseline (keine Optimierung) | 31.6 GB | 6.8 min | 94.2% | 9.2/10 |

| + Float16-Konvertierung | 18.4 GB | 6.6 min | 94.2% | 9.2/10 |

| + Attention Slicing | 14.6 GB | 7.8 min | 93.8% | 9.1/10 |

| + VAE-Tiling | 12.8 GB | 8.4 min | 93.6% | 9.1/10 |

| + Sequential Batching | 11.2 GB | 10.2 min | 92.4% | 9.0/10 |

Float16-Konvertierung bietet massive VRAM-Einsparungen (42%) ohne Qualitäts- oder Konsistenzeinfluss, was es für alle Workflows essentiell macht. Attention Slicing fügt bedeutende zusätzliche Einsparungen hinzu (21% mehr) mit minimalen Konsistenzkosten. Über diese beiden Optimierungen hinaus machen abnehmende Erträge zusätzliche Techniken nur für extreme VRAM-Einschränkungen lohnenswert.

Empfohlener Optimierungs-Stack: Float16-Konvertierung + Attention Slicing (Slice-Größe 15) bietet optimale Balance für die meisten Workflows. Diese Kombination reduziert VRAM um 54%, während 93,8% Konsistenz und 9,1/10 Qualität beibehalten werden, ausreichend für professionelle Produktionsarbeit.

Benchmark 5: Charakter-LoRA-Trainings-Datenvolumen

Testparameter: Derselbe Charakter, variierende LoRA-Trainings-Datensatzgrößen, Messung der Rotationskonsistenz.

| Trainingsbilder | Trainingszeit | Konsistenz-Gewinn | Overfitting-Risiko |

|---|---|---|---|

| 12 Bilder | 22 min | +2.1% | Niedrig |

| 24 Bilder | 45 min | +3.8% | Niedrig |

| 36 Bilder | 68 min | +4.2% | Mittel |

| 48 Bilder | 91 min | +4.4% | Mittel-Hoch |

| 72 Bilder | 136 min | +4.1% | Hoch |

Der Bereich 24-36 Bilder bietet optimale Konsistenzverbesserung ohne signifikantes Overfitting-Risiko. Über 48 Bilder hinaus erreichen Konsistenz-Gewinne ein Plateau, während das Overfitting-Risiko zunimmt, was die Charakter-LoRA weniger flexibel für Prompt-Variationen macht.

Ich pflege 24-Bild-Trainingssets (3 Bilder × 8 Betrachtungswinkel) für die meisten Charaktere und erreiche 97-98% Konsistenz mit 45 Minuten Trainingszeit. Helden-Charaktere erhalten 36-Bild-Sets, wenn absolute Konsistenz die zusätzliche Trainings-Investition rechtfertigt.

Abschließende Empfehlungen

Nach 800+ Anisora-Rotationen über diverse Charakter-Designs und Anwendungsfälle hinweg repräsentieren diese Konfigurationen meine getesteten Empfehlungen für verschiedene Produktionsszenarien.

Für Animations-Reference-Sheets

- Auflösung: 768x768

- Frames: 60 (2,5 Sekunden)

- Optimierungen: Float16 + Attention Slicing

- Charakter-LoRA: Empfohlen

- VRAM: 14,6 GB

- Zeit: 7,2 Minuten

- Konsistenz: 97-98%

Diese Konfiguration produziert industrie-standard Turnarounds, geeignet für Animationsproduktions-Pipelines und Charakter-Model-Sheets.

Für Portfolio-Showcase-Stücke

- Auflösung: 768x768 oder 896x896

- Frames: 90 (3,75 Sekunden)

- Optimierungen: Float16 + Attention Slicing

- Technik: Dynamische Kamera (Elevation + Zoom)

- VRAM: 19,8 GB (24GB empfohlen)

- Zeit: 11,4 Minuten

- Visueller Impact: Maximal

Dynamische Kamerabewegung erzeugt ansprechende Charakter-Enthüllungen, perfekt für Portfolio-Reels und Social-Media-Inhalte.

Für schnelle Iteration und Tests

- Auflösung: 512x512 oder 640x640

- Frames: 36 (1,5 Sekunden)

- Optimierungen: Float16 + Attention Slicing

- Charakter-LoRA: Optional

- VRAM: 8,4 GB

- Zeit: 3,8 Minuten

- Konsistenz: 95-96%

Niedrigere Auflösung ermöglicht schnelle Iteration während der Charakter-Design-Exploration, bevor man sich auf hochauflösende Finals festlegt.

Für maximale Qualitäts-Finals

- Auflösung: 1024x1024

- Frames: 60 (2,5 Sekunden)

- Technik: Multi-Pass-Verfeinerung + Upscaling

- Charakter-LoRA: Erforderlich

- VRAM: 24,2 GB Spitze

- Zeit: 18 Minuten

- Konsistenz: 99%

Dreistufiger Workflow (Entwurf → Verfeinerung → Upscale) produziert außergewöhnliche Qualität für Druckmaterialien und Portfolio-Herzstücke.

Anisora v3.2 repräsentiert den aktuellen Stand der Technik für 360-Grad-Anime-Charakter-Rotationen in ComfyUI. Die 94-99% Konsistenzraten (abhängig von der Konfiguration) machen professionelle Turnaround-Animationen erreichbar ohne manuelle Frame-für-Frame-Korrektur, die frühere Ansätze plagten.

Ich generiere alle Produktions-Anisora-Rotationen auf Apatero.com-Infrastruktur, wo 24-32GB VRAM-Instanzen die Speicherkapazität für vollwertige Rotationen ohne die Optimierungskompromisse bieten, die auf Consumer-Hardware erforderlich sind. Ihre Plattform beinhaltet vorkonfigurierte Anisora-Workflows, die diese Best Practices implementieren, eliminiert die Setup-Komplexität und lässt Sie sich auf Charakter-Design konzentrieren statt auf technische Konfiguration.

Die Charakter-LoRA-Trainings-Investition (45-90 Minuten einmalige Kosten) zahlt sich sofort aus, wenn mehrere Rotationen desselben Charakters generiert werden, und stellt perfekte Konsistenz über alle Deliverables für diesen Charakter sicher. Ich pflege eine Bibliothek von 30+ Charakter-LoRAs für wiederkehrende Kunden-Charaktere, einmal trainiert und dann über Dutzende von Projekten wiederverwendet.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

Die 10 häufigsten ComfyUI-Anfängerfehler und wie man sie 2025 behebt

Vermeide die 10 häufigsten ComfyUI-Fehler, die neue Nutzer frustrieren. Vollständiger Troubleshooting-Leitfaden mit Lösungen für VRAM-Fehler, Probleme beim Laden von Modellen...

25 ComfyUI-Tipps und -Tricks, die Profis 2025 nicht verraten wollen

Entdecken Sie 25 fortgeschrittene ComfyUI-Tipps, Workflow-Optimierungstechniken und professionelle Tricks, die Experten nutzen. Vollständiger Leitfaden zur CFG-Optimierung, Batch-Verarbeitung und Qualitätsverbesserung.

7 ComfyUI Custom Nodes, Die Integriert Sein Sollten (Und Wie Man Sie Bekommt)

Essentielle ComfyUI Custom Nodes, die jeder Benutzer 2025 braucht. Vollständige Installationsanleitung für WAS Node Suite, Impact Pack, IPAdapter Plus und weitere bahnbrechende Nodes.