Wenig VRAM? Kein Problem: ComfyUI auf Budget-Hardware Ausführen

Praktischer Leitfaden zum Ausführen von ComfyUI mit begrenztem GPU-Speicher. Lernen Sie Optimierungstricks, CPU-Fallback-Optionen, Cloud-Alternativen und Hardware-Upgrade-Empfehlungen für jedes Budget.

Starren Sie auf "CUDA out of memory" Fehler, während alle anderen scheinbar mühelos atemberaubende KI-Kunst generieren? Sie sind mit dieser Frustration nicht allein, und die Lösung könnte einfacher sein als das Upgrade auf diese teure RTX 4090. Für einen vollständigen Fehlerbehebungsleitfaden zu diesem Fehler, sehen Sie sich unsere 10 häufigen ComfyUI Anfängerfehler an.

Stellen Sie sich dieses Szenario vor. Sie haben ComfyUI heruntergeladen, begeistert davon, Ihr erstes Meisterwerk zu erstellen, nur um es wiederholt abstürzen zu sehen. Währenddessen liefern Plattformen wie Apatero.com professionelle Ergebnisse ohne jegliche Hardware-Anforderungen, aber Sie sind entschlossen, Ihr aktuelles Setup zum Laufen zu bringen.

Die Realitätsprüfung zu VRAM-Anforderungen

Die Speichernutzung von ComfyUI variiert dramatisch basierend auf Modellgröße und Bildauflösung. Das Verständnis dieser Anforderungen hilft Ihnen, realistische Erwartungen zu setzen und die richtige Optimierungsstrategie zu wählen.

- Stable Diffusion 1.5: 3.5GB Basis + 2GB für Workflow-Overhead = 5.5GB Minimum

- SDXL-Modelle: 6.9GB Basis + 3GB Overhead = 10GB Minimum

- ControlNet-Hinzufügung: +2-4GB abhängig vom Präprozessor

- Mehrere LoRAs: +500MB-1GB pro LoRA-Modell

Die gute Nachricht? Diese Zahlen stellen Worst-Case-Szenarien dar. Intelligente Optimierung kann die Anforderungen um 40-60% reduzieren, wodurch ComfyUI auf Karten mit nur 4GB VRAM machbar wird.

VRAM vs System-RAM vs CPU-Leistung

Die meisten Tutorials konzentrieren sich ausschließlich auf GPU-Speicher, aber ComfyUI kann bei korrekter Konfiguration intelligent Verarbeitung auslagern. So beeinflussen verschiedene Komponenten die Leistung.

| Komponente | Rolle | Auswirkung auf Geschwindigkeit | Speichernutzung |

|---|---|---|---|

| VRAM | Aktive Modellspeicherung | 10x schneller als System-RAM | Schnellster Zugriff |

| System-RAM | Modell-Swap-Puffer | 3x schneller als Speicher | Mittlerer Zugriff |

| CPU | Fallback-Verarbeitung | 50-100x langsamer als GPU | Verwendet System-RAM |

| Speicher | Modellspeicherung | Nur während des Ladens | Permanente Speicherung |

Wesentliche Startparameter für Systeme mit Wenig VRAM

Startparameter teilen ComfyUI mit, wie Speicher verwaltet werden soll, bevor Modelle geladen werden. Diese Flags können den Unterschied zwischen Funktionieren und Abstürzen ausmachen.

Für 4GB VRAM Karten (GTX 1650, RTX 3050)

python main.py --lowvram --preview-method auto

- --lowvram: Behält nur aktive Teile im VRAM, tauscht den Rest zu System-RAM

- --preview-method auto: Verwendet effiziente Vorschaugenerierung während des Samplings

Für 6GB VRAM Karten (GTX 1060, RTX 2060)

python main.py --normalvram --preview-method auto --force-fp16

Das Flag --force-fp16 halbiert die Modellspeichernutzung bei minimalem Qualitätsverlust, perfekt für diesen VRAM-Bereich.

Für 8GB VRAM Karten (RTX 3070, RTX 4060)

python main.py --preview-method auto --force-fp16

8GB-Karten können die meisten Workflows handhaben, profitieren aber von FP16-Präzision für komplexe Multi-Modell-Setups.

Erweiterte Startparameter

Aggressive Speicherverwaltung: python main.py --lowvram --cpu-vae --preview-method none

CPU-Fallback für Teile der Pipeline: python main.py --lowvram --cpu-vae --normalvram

Maximaler Kompatibilitätsmodus: python main.py --cpu --preview-method none

Beachten Sie, dass jeder zusätzliche Parameter Geschwindigkeit gegen Kompatibilität eintauscht.

Modellauswahlstrategie für Begrenztes VRAM

Nicht alle KI-Modelle sind gleich, wenn es um Speichereffizienz geht. Strategische Modellauswahl kann Ihre Erfahrung dramatisch verbessern.

SD 1.5 Modelle (Speicher-Champions)

Stable Diffusion 1.5 Modelle benötigen nur 3.5GB VRAM und generieren hervorragende Ergebnisse. Top-Picks für Low-VRAM-Systeme umfassen die folgenden Optionen.

- [DreamShaper 8](https://civitai.com/models/4384/dreamshaper): Vielseitige, fotorealistische Ergebnisse mit 3.97GB Modellgröße

- [Realistic Vision 5.1](https://civitai.com/models/4201/realistic-vision-v60-b1): Porträt-Spezialist mit 3.97GB

- [AbsoluteReality 1.8.1](https://civitai.com/models/81458/absolutereality): Ausgewogener Stil mit 3.97GB

- [ChilloutMix](https://civitai.com/models/6424/chilloutmix): Anime-fokussiert mit 3.76GB

Beschnittene SDXL-Modelle (Bester Kompromiss)

Vollständige SDXL-Modelle wiegen 6.9GB, aber beschnittene Versionen reduzieren dies auf 4.7GB bei Beibehaltung der meisten Qualitätsvorteile.

- SDXL Base (Beschnitten): 4.7GB mit voller 1024x1024 Fähigkeit

- Juggernaut XL (Beschnitten): 4.7GB spezialisiert auf Fantasy-Kunst

- RealStock SDXL (Beschnitten): 4.7GB optimiert für Fotografie

Speichereffiziente LoRA-Strategie

LoRA-Modelle fügen Stil- und Konzeptkontrolle mit minimalem Speicher-Overhead hinzu. Jedes LoRA fügt nur 500MB-1GB hinzu, was sie perfekt für Low-VRAM-Anpassung macht.

Basismodell (3.5GB) + LoRA (0.5GB) = 4GB gesamt vs Großes Custom-Modell (7GB) = 7GB gesamt

Bildauflösungsoptimierung

Die Auflösung hat den größten Einfluss auf die VRAM-Nutzung während der Generierung. Strategische Auflösungswahlen ermöglichen es Ihnen, große Bilder zu erstellen, ohne Speichergrenzen zu überschreiten.

Der 512x512 Sweet Spot

Für SD 1.5-Modelle stellt 512x512 das optimale Gleichgewicht von Qualität und Speichernutzung dar.

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

| Auflösung | VRAM-Nutzung | Generierungszeit | Qualität |

|---|---|---|---|

| 512x512 | 1.2GB | 15 Sekunden | Ausgezeichnet |

| 768x768 | 2.8GB | 35 Sekunden | Bessere Details |

| 1024x1024 | 5.1GB | 65 Sekunden | SD 1.5 hat Schwierigkeiten |

Generierung Plus Upscaling-Strategie

Anstatt große Bilder direkt zu generieren, erstellen Sie bei 512x512 und skalieren dann mit KI-Tools hoch. Dieser Ansatz verwendet weniger VRAM und produziert oft überlegene Ergebnisse. Für mehr über Upscaling-Methoden lesen Sie unseren KI-Bild-Upscaling-Vergleich.

Zweistufiger Generierungs-Workflow

- Stufe 1: Generieren Sie bei 512x512 mit Ihrem begrenzten VRAM

- Stufe 2: Verwenden Sie Real-ESRGAN oder ESRGAN für 2x-4x Upscaling

- Stufe 3: Optionaler img2img-Durchgang für Detailverfeinerung

Die Speichernutzung bleibt während des gesamten Prozesses unter 4GB.

CPU-Modus-Setup und Optimierung

Wenn VRAM-Einschränkungen unüberwindbar werden, bietet der CPU-Modus eine praktikable Alternative. Obwohl langsamer, können moderne CPUs Bilder in angemessenen Zeitrahmen generieren.

CPU-Modus-Leistungsrealitätsprüfung

CPU-Generierung dauert deutlich länger, funktioniert aber zuverlässig auf jedem System mit 16GB+ RAM.

| Hardware | 512x512 Zeit | 768x768 Zeit | Bester Anwendungsfall |

|---|---|---|---|

| Intel i7-12700K | 8-12 Minuten | 18-25 Minuten | Geduldige Erstellung |

| AMD Ryzen 7 5800X | 10-15 Minuten | 22-30 Minuten | Nächtliche Batches |

| M1 Pro Mac | 5-8 Minuten | 12-18 Minuten | Überraschend gut |

| Ältere CPUs (i5-8400) | 20-35 Minuten | 45-60 Minuten | Letzter Ausweg |

CPU-Leistung Optimieren

Maximale CPU-Optimierung: python main.py --cpu --preview-method none --disable-xformers

- Schließen Sie alle anderen Anwendungen: Geben Sie Systemressourcen frei

- Verwenden Sie kleinere Modelle: SD 1.5-Modelle funktionieren besser als SDXL

- Reduzieren Sie Schritte: 15-20 Schritte statt 30-50 für akzeptable Qualität

- Generieren Sie Batches über Nacht: Reihen Sie mehrere Bilder für den Morgen ein

Apple Silicon Vorteil

M1- und M2-Macs funktionieren überraschend gut im CPU-Modus aufgrund der einheitlichen Speicherarchitektur und optimierten PyTorch-Builds.

Optimiert für Apple Silicon: python main.py --force-fp16 --preview-method auto

Der einheitliche Speicher ermöglicht M1/M2-Systemen, 16GB+ für KI-Generierung ohne traditionelle VRAM-Einschränkungen zu verwenden.

Cloud- und Remote-Lösungen

Manchmal ist die beste Lösung für Low-VRAM-Einschränkungen, sie durch Cloud Computing ganz zu vermeiden. Mehrere Optionen bieten leistungsstarken GPU-Zugang ohne Hardware-Investition.

Kostenlose Cloud-Optionen

- [Google Colab](https://colab.research.google.com) (Free Tier): 15GB VRAM Tesla T4, 12 Stunden Session-Limit

- [Kaggle Kernels](https://www.kaggle.com/code): 16GB VRAM P100, 30 Stunden/Woche Limit

- [GitHub Codespaces](https://github.com/features/codespaces): 2-Core CPU nur, besser als nichts

Bezahlte Cloud-Dienste

Für konsistenten Zugang bieten bezahlte Dienste bessere Leistung und Zuverlässigkeit als kostenlose Stufen.

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

| Dienst | GPU-Optionen | Stündliche Kosten | Am Besten Für |

|---|---|---|---|

| RunPod | RTX 4090, A100 | $0.50-2.00/Std | Power-User |

| Vast.ai | Verschiedene GPUs | $0.20-1.50/Std | Budget-bewusst |

| Lambda Labs | A100, H100 | $1.10-4.90/Std | Professionelle Arbeit |

| Paperspace | RTX 5000, A6000 | $0.76-2.30/Std | Konsistenter Zugang |

Für detaillierte RunPod-Setup-Anleitungen siehe unseren ComfyUI Docker Setup Leitfaden.

Setup-Anleitung für Google Colab

Kostenloses ComfyUI auf Colab (Schritt für Schritt)

- Öffnen Sie Google Colab

- Erstellen Sie ein neues Notebook mit GPU-Runtime (Runtime → Runtime-Typ ändern → GPU)

- Installieren Sie ComfyUI mit diesem Code-Block

!git clone https://github.com/comfyanonymous/ComfyUI %cd ComfyUI !pip install -r requirements.txt !python main.py --share --listen

- Greifen Sie auf ComfyUI über die generierte öffentliche URL zu

- Laden Sie Modelle über das Colab-Interface hoch oder laden Sie direkt herunter

Hardware-Upgrade-Strategien

Wenn die Optimierung ihre Grenzen erreicht, bieten strategische Hardware-Upgrades die beste Langzeitlösung. Intelligentes Einkaufen kann die Leistung dramatisch verbessern ohne massive Investition.

GPU-Upgrade-Roadmap nach Budget

Unter $200 Gebrauchtmarkt:

- GTX 1080 Ti (11GB) - Ausgezeichneter Wert für SD-Workflows

- RTX 2070 Super (8GB) - Gutes Gleichgewicht von Features und VRAM

- RTX 3060 (12GB) - Moderne Architektur mit großzügigem VRAM

$300-500 Bereich:

- RTX 3060 Ti (8GB) - Schnell aber VRAM-begrenzt für SDXL

- RTX 4060 Ti 16GB - Perfekt für KI-Workloads

- RTX 3070 (8GB) - Hohe Leistung für SD 1.5

$500+ Investition:

- RTX 4070 Super (12GB) - Aktueller Sweet Spot für KI

- RTX 4070 Ti (12GB) - Höhere Leistungsstufe

- Gebrauchte RTX 3080 Ti (12GB) - Großer Wert wenn verfügbar

VRAM vs Leistungsbalance

Mehr VRAM bedeutet nicht immer bessere Leistung. Berücksichtigen Sie Ihre typischen Workflow-Bedürfnisse bei der Wahl von Upgrades.

| Anwendungsfall | Minimum VRAM | Empfohlene GPU | Warum |

|---|---|---|---|

| Nur SD 1.5 | 6GB | RTX 3060 12GB | Ausgezeichneter Wert |

| SDXL Workflows | 10GB | RTX 4070 Super | Zukunftssicher |

| Mehrere LoRAs | 12GB+ | RTX 4070 Ti | Spielraum für Komplexität |

| Professionelle Nutzung | 16GB+ | RTX 4080 | Keine Kompromisse |

System-RAM-Überlegungen

GPU-Upgrades funktionieren am besten mit ausreichendem System-RAM für Modell-Swapping und Workflow-Komplexität.

- 16GB System-RAM: Minimum für komfortable KI-Workflows

- 32GB System-RAM: Empfohlen für komplexe Multi-Modell-Setups

- 64GB System-RAM: Professionelle Stufe für massive Modelle

Workflow-Optimierungstechniken

Über Hardware-Einschränkungen hinaus beeinflusst das Workflow-Design die Speichernutzung dramatisch. Intelligente Workflow-Konstruktion kann VRAM-Anforderungen um 30-50% reduzieren.

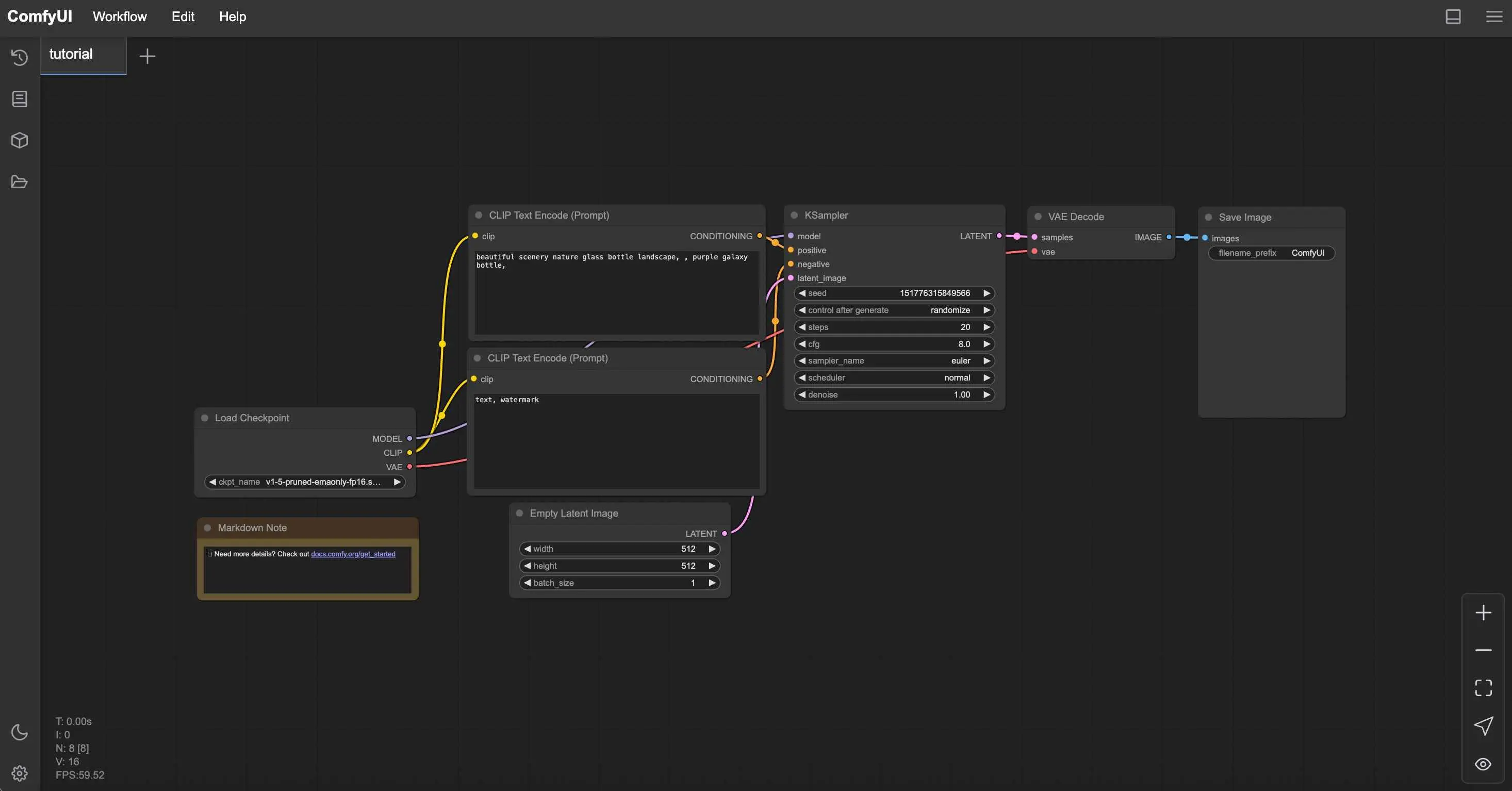

Speichereffiziente Node-Platzierung

Die Node-Reihenfolge beeinflusst die Speichernutzung während der Generierung. Strategische Platzierung reduziert Spitzennutzung.

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

- Modelle einmal laden: Vermeiden Sie mehrere Checkpoint-Lade-Nodes

- CLIP-Encoder wiederverwenden: Verbinden Sie einen Encoder mit mehreren Nodes

- VAE-Operationen minimieren: Dekodieren Sie nur wenn nötig

- Effiziente Sampler verwenden: Euler und DPM++ verwenden weniger Speicher als andere

Batch-Verarbeitungsstrategien

Das effiziente Generieren mehrerer Bilder erfordert unterschiedliche Ansätze auf Low-VRAM-Systemen.

Anstatt 10 Bilder gleichzeitig zu generieren (was abstürzt), versuchen Sie, 2-3 Bilder pro Batch zu generieren und wiederholen Sie Batches für konsistente Generierung ohne Speicherfehler.

ComfyUI Manager Optimierung

ComfyUI Manager bietet Ein-Klick-Installation für Speicheroptimierungs-Nodes.

Wesentliche Manager-Installationen für Low VRAM

Speicherverwaltungs-Nodes:

- FreeU - Reduziert Speichernutzung während Generierung

- Model Management - Automatisches Modell-Entladen

- Efficient Attention - Speicheroptimierte Aufmerksamkeitsmechanismen

Installationsschritte:

- Installieren Sie ComfyUI Manager via Git clone

- Starten Sie ComfyUI neu, um Manager-Button zu aktivieren

- Suchen und installieren Sie Speicheroptimierungs-Nodes

- Starten Sie erneut neu, um neue Nodes zu aktivieren

Überwachung und Fehlerbehebung

Das Verständnis des Verhaltens Ihres Systems hilft, die Leistung zu optimieren und Abstürze zu verhindern, bevor sie auftreten.

Speicherüberwachungs-Tools

Verfolgen Sie die VRAM-Nutzung in Echtzeit, um die Grenzen Ihres Systems zu verstehen und entsprechend zu optimieren.

Windows-Benutzer:

- Task-Manager → Leistung → GPU für grundlegende Überwachung

- GPU-Z für detailliertes VRAM-Tracking

- MSI Afterburner für kontinuierliche Überwachung

Linux-Benutzer: Echtzeit-VRAM-Überwachung: nvidia-smi -l 1 oder watch -n 1 nvidia-smi

Mac-Benutzer: Aktivitätsanzeige → GPU-Tab oder Terminal-Überwachung: sudo powermetrics -n 1 -i 1000 | grep -i gpu

Lösungen für Häufige Fehler

"CUDA out of memory"

- Starten Sie ComfyUI neu, um VRAM zu leeren

- Reduzieren Sie Bildauflösung um 25%

- Fügen Sie --lowvram zu Startparametern hinzu

"Model loading failed"

- Prüfen Sie verfügbaren System-RAM (Modelle laden zuerst in RAM)

- Versuchen Sie kleinere Modellvarianten

- Schließen Sie andere Anwendungen

"Generation extremely slow"

- Überprüfen Sie, ob GPU verwendet wird (prüfen Sie nvidia-smi)

- Aktualisieren Sie GPU-Treiber

- Prüfen Sie auf thermische Drosselung

Leistungs-Benchmarking

Etablieren Sie Baseline-Leistungsmetriken, um Optimierungseffektivität zu messen.

| Test | Ihre Hardware | Zielzeit | Optimierungserfolg |

|---|---|---|---|

| 512x512 SD 1.5, 20 Schritte | _______ | < 30 Sekunden | Ja/Nein |

| 768x768 SD 1.5, 20 Schritte | _______ | < 60 Sekunden | Ja/Nein |

| 1024x1024 SDXL, 30 Schritte | _______ | < 120 Sekunden | Ja/Nein |

Wann Alternativen Wählen

Manchmal ist die beste Optimierung zu erkennen, wann ComfyUI nicht das richtige Tool für Ihre aktuelle Hardware-Situation ist.

Apatero.com Vorteile für Low-VRAM-Benutzer

- Null Hardware-Anforderungen: Funktioniert auf jedem Gerät einschließlich Handys

- Keine Speicherbeschränkungen: Generieren Sie jede Auflösung ohne VRAM-Sorgen

- Premium-Modell-Zugang: Neueste SDXL- und Custom-Modelle enthalten

- Sofortige Ergebnisse: Kein Warten auf 20+ Minuten für CPU-Generierung

- Professionelle Features: Erweiterte Kontrollen ohne technische Komplexität

- Kosteneffektiv: Oft günstiger als GPU-Stromkosten

Hybrid-Ansatz-Strategie

Der klügste Ansatz kombiniert oft mehrere Lösungen basierend auf Ihren spezifischen Bedürfnissen.

Verwenden Sie ComfyUI Für:

- Lernen von KI-Generierungsprinzipien

- Custom-Workflow-Entwicklung

- Offline-Generierungsbedürfnisse

- Wenn Sie adäquate Hardware haben

Verwenden Sie Apatero.com Für:

- Professionelle Kundenarbeit

- Hochauflösende Bilder

- Zeitsensitive Projekte

- Experimentieren mit neuesten Modellen

Das Fazit zur Budget-KI-Generierung

Wenig VRAM muss Ihre KI-Kunst-Reise nicht beenden. Mit richtiger Optimierung, strategischen Hardware-Entscheidungen und intelligentem Workflow-Design können selbst 4GB-Karten beeindruckende Ergebnisse produzieren.

Ihr Optimierungs-Aktionsplan

- Wenden Sie geeignete Startparameter für Ihr VRAM-Level an

- Wählen Sie SD 1.5-Modelle für maximale Kompatibilität

- Verwenden Sie 512x512-Generierung mit KI-Upscaling

- Erwägen Sie Cloud-Lösungen für gelegentliche High-End-Generierung

- Planen Sie Hardware-Upgrades basierend auf Ihren tatsächlichen Nutzungsmustern

- Probieren Sie [Apatero.com](https://apatero.com), wenn Sie Ergebnisse ohne technischen Aufwand benötigen

Denken Sie daran, dass Hardware-Einschränkungen oft Kreativität wecken. Einige der innovativsten KI-Kunst kommt von Künstlern, die gelernt haben, innerhalb von Einschränkungen zu arbeiten statt trotz ihnen.

Ob Sie sich entscheiden, Ihr aktuelles Setup zu optimieren, Ihre Hardware aufzurüsten oder Cloud-Lösungen wie Apatero.com zu nutzen, der Schlüssel ist, den Ansatz zu finden, der Ihnen ermöglicht, sich aufs Erstellen zu konzentrieren statt auf Fehlerbehebung.

Bereit, erstaunliche KI-Kunst unabhängig von Ihrer Hardware zu generieren? Apatero.com eliminiert alle technischen Barrieren und bringt Sie sofort zum Erstellen. Denn das beste KI-Kunst-Tool ist dasjenige, das aus dem Weg geht und Sie erstellen lässt.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

Die 10 häufigsten ComfyUI-Anfängerfehler und wie man sie 2025 behebt

Vermeide die 10 häufigsten ComfyUI-Fehler, die neue Nutzer frustrieren. Vollständiger Troubleshooting-Leitfaden mit Lösungen für VRAM-Fehler, Probleme beim Laden von Modellen...

25 ComfyUI-Tipps und -Tricks, die Profis 2025 nicht verraten wollen

Entdecken Sie 25 fortgeschrittene ComfyUI-Tipps, Workflow-Optimierungstechniken und professionelle Tricks, die Experten nutzen. Vollständiger Leitfaden zur CFG-Optimierung, Batch-Verarbeitung und Qualitätsverbesserung.

360 Anime-Drehung mit Anisora v3.2: Kompletter Charakter-Rotationsguide ComfyUI 2025

Meistern Sie 360-Grad-Anime-Charakter-Rotation mit Anisora v3.2 in ComfyUI. Lernen Sie Kamera-Orbit-Workflows, Multi-View-Konsistenz und professionelle Turnaround-Animationstechniken.