ComfyUI 초보자 가이드: 2025년 노드 기반 AI 이미지 생성 시작하기

완전한 ComfyUI 초보자 가이드. 설치, 첫 워크플로우, 필수 노드 및 노드 기반 Stable Diffusion 시작 팁.

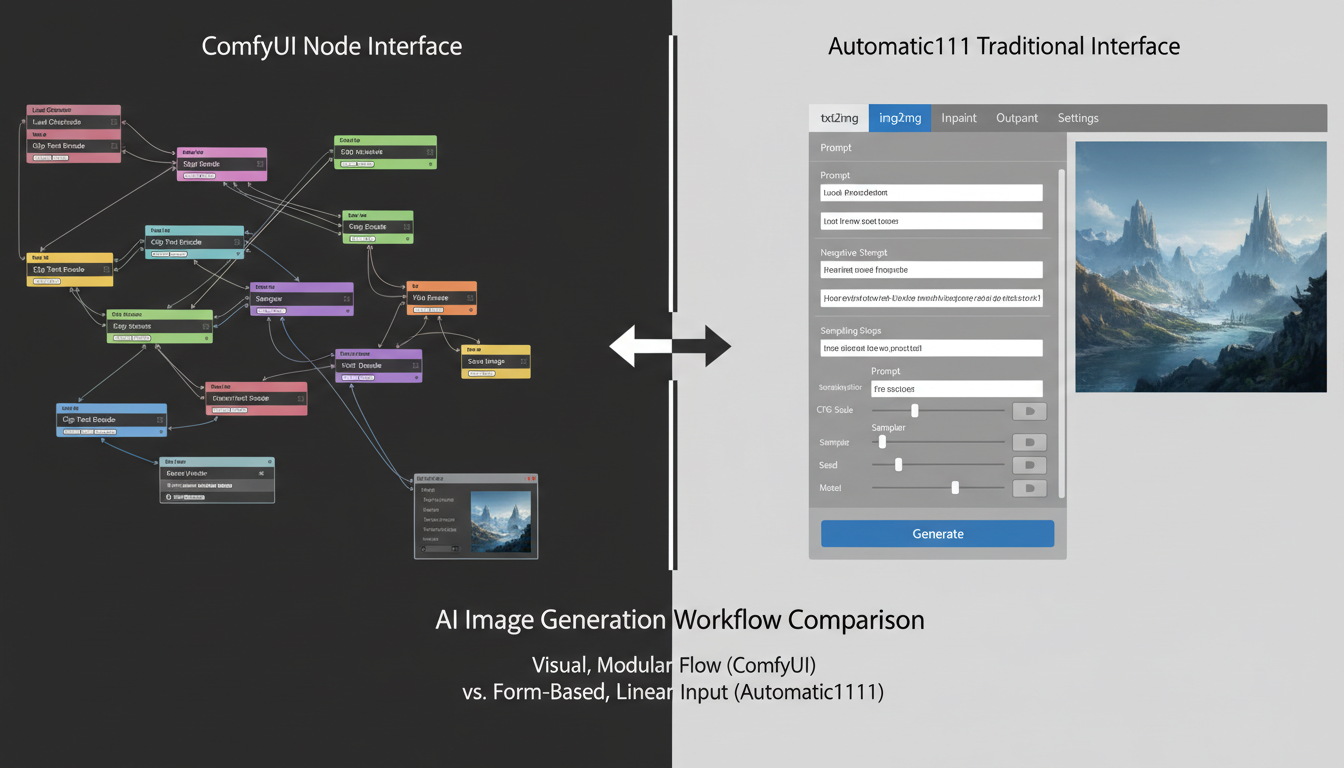

ComfyUI는 Stable Diffusion을 위한 가장 강력한 인터페이스입니다. 초보자에게는 위협적이기도 합니다. 노드 기반 인터페이스는 복잡해 보이지만, 기본을 이해하면 다른 어떤 옵션보다 더 많은 제어를 제공합니다.

빠른 답변: ComfyUI는 최대의 유연성과 성능을 제공하는 Stable Diffusion용 노드 기반 인터페이스입니다. 휴대용 버전(Windows) 또는 git clone(Mac/Linux)을 통해 설치하고, 체크포인트 모델을 다운로드하고, 기본 워크플로우를 로드한 다음 첫 번째 이미지를 생성하는 것으로 시작합니다. 학습 곡선은 기본 숙련도까지 약 2-4시간입니다.

- ComfyUI는 Automatic1111보다 더 많은 제어를 제공하지만 학습 곡선이 있습니다

- 휴대용 버전으로 설치하는 데 15-30분 소요

- 기본 워크플로우: 체크포인트 로드 → 텍스트 인코드 → KSampler → VAE 디코드 → 저장

- 노드 연결은 데이터 흐름을 나타냅니다—색상은 데이터 유형을 나타냅니다

- 최소 8GB VRAM, 12GB+ 권장

- 한 번 배우면 워크플로우를 쉽게 저장하고 공유할 수 있습니다

Automatic1111 대신 ComfyUI를 선택하는 이유?

ComfyUI를 배울 가치가 있는 이유를 설명하겠습니다:

ComfyUI의 장점

성능:

- 동일한 작업에 더 적은 VRAM 사용

- 많은 경우 더 빠른 생성

- 더 나은 메모리 관리

- 효율적인 배치 처리

유연성:

- 모든 단계에 대한 완전한 제어

- 다양한 모델을 쉽게 혼합

- 복잡한 워크플로우 가능

- 실험하기 쉬움

재현성:

- 워크플로우가 독립적입니다

- 정확한 구성 공유

- 시각적으로 디버그

- 무슨 일이 일어나고 있는지 이해

고급 기능:

- 더 나은 ControlNet 처리

- 복잡한 LoRA 조합

- 다중 모델 파이프라인

- 커스텀 노드 생태계

Automatic1111로 충분한 경우

- 빠르고 간단한 생성

- 익숙한 인터페이스를 원함

- 복잡한 워크플로우가 필요 없음

- 기술적 관심이 제한적

내 추천

ComfyUI를 배우세요. 초기 학습 곡선은 더 많은 기능과 Stable Diffusion 작동 방식에 대한 더 나은 이해로 보상받습니다.

ComfyUI는 초기 복잡성을 대가로 더 많은 성능을 제공합니다

ComfyUI는 초기 복잡성을 대가로 더 많은 성능을 제공합니다

설치

Windows (휴대용 - 권장)

1단계: 다운로드

- ComfyUI GitHub releases로 이동

- 최신 휴대용 패키지 다운로드

- 폴더에 압축 해제(경로에 공백 피하기)

2단계: 첫 실행

run_nvidia_gpu.bat더블 클릭- 초기 설정 대기(처음에는 몇 분 소요)

- 브라우저가

http://127.0.0.1:8188로 열림

3단계: 모델 다운로드

- CivitAI 또는 Hugging Face에서 체크포인트 가져오기

ComfyUI/models/checkpoints/에 배치- 인터페이스 새로고침

Mac/Linux (Git Clone)

1단계: 사전 요구 사항

## Python 3.10+ 필요

python3 --version

## Git 필요

git --version

2단계: 복제 및 설치

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

pip install -r requirements.txt

3단계: 실행

python main.py

## 브라우저가 http://127.0.0.1:8188로 열림

폴더 구조

설치 후 폴더를 이해하세요:

ComfyUI/

├── models/

│ ├── checkpoints/ # 메인 모델 (.safetensors)

│ ├── loras/ # LoRA 파일

│ ├── vae/ # VAE 파일

│ ├── controlnet/ # ControlNet 모델

│ ├── upscale_models/ # 업스케일러

│ └── embeddings/ # 텍스처 인버전

├── input/ # 입력 이미지

├── output/ # 생성된 이미지

└── custom_nodes/ # 확장

노드 이해하기

ComfyUI는 선으로 연결된 노드를 사용합니다. 각 노드는 한 가지 일을 합니다. 선은 노드 간에 데이터를 전달합니다.

노드 작동 방식

입력(왼쪽):

- 다른 노드로부터 데이터 수신

- 색상 점은 데이터 유형을 나타냄

- 호환 가능한 유형을 연결해야 함

출력(오른쪽):

- 다른 노드로 데이터 전송

- 색상이 데이터 유형과 일치

- 여러 입력에 연결 가능

노드 본체:

- 설정/매개변수 포함

- 선택을 위한 드롭다운 메뉴

- 값을 위한 숫자 입력

데이터 유형(색상)

| 색상 | 데이터 유형 | 설명 |

|---|---|---|

| 분홍색 | MODEL | 로드된 체크포인트 모델 |

| 노란색 | CLIP | 텍스트 인코더 구성 요소 |

| 보라색 | VAE | 이미지 인코더/디코더 |

| 주황색 | CONDITIONING | 인코딩된 텍스트 프롬프트 |

| 청록색 | LATENT | 잠재 공간의 이미지 |

| 녹색 | IMAGE | 실제 이미지 데이터 |

노드를 연결할 때 색상이 일치해야 합니다. MODEL을 CONDITIONING에 직접 연결할 수 없습니다.

필수 노드

체크포인트 로드:

- 모델 파일 로드

- 출력: MODEL, CLIP, VAE

CLIP 텍스트 인코드:

- 텍스트를 컨디셔닝으로 변환

- 입력: CLIP, 텍스트

- 출력: CONDITIONING

KSampler:

- 실제 생성이 여기서 발생

- 입력: MODEL, 긍정/부정 컨디셔닝, LATENT

- 출력: LATENT (생성된 이미지)

VAE 디코드:

- 잠재를 볼 수 있는 이미지로 변환

- 입력: VAE, LATENT

- 출력: IMAGE

이미지 저장:

- 출력 폴더에 저장

- 입력: IMAGE

노드 연결 이해가 ComfyUI의 핵심입니다

노드 연결 이해가 ComfyUI의 핵심입니다

첫 번째 워크플로우

기본 이미지 생성 워크플로우 만들기를 안내하겠습니다.

1단계: 기본 워크플로우 로드

ComfyUI가 시작되면 기본 워크플로우가 나타납니다. 그렇지 않으면:

- "Load Default" 버튼 클릭

- 또는 워크플로우 PNG를 드래그

기본 워크플로우에는 기본 생성에 필요한 모든 것이 포함되어 있습니다.

2단계: 모델 선택

- "Load Checkpoint" 노드 찾기

- 드롭다운 클릭

- 다운로드한 모델 선택

- 모델이 나타나지 않으면

models/checkpoints/에 배치하지 않은 것입니다

3단계: 프롬프트 작성

긍정 프롬프트(원하는 것):

- "positive"에 연결된 CLIP 텍스트 인코드 찾기

- 텍스트 상자에 프롬프트 입력

- 예:

아름다운 풍경, 산, 일몰, 디테일, 8k

부정 프롬프트(피할 것):

- "negative"에 연결된 CLIP 텍스트 인코드 찾기

- 품질 부정어 입력

- 예:

흐릿한, 저품질, 나쁜, 추한

4단계: 설정 구성

KSampler 노드에서:

무료 ComfyUI 워크플로우

이 글의 기술에 대한 무료 오픈소스 ComfyUI 워크플로우를 찾아보세요. 오픈소스는 강력합니다.

seed: 재현성을 위한 난수. 랜덤은 -1 사용.

steps: 생성 단계. 대부분의 모델에서 20-30.

cfg: 프롬프트 준수도. 일반적으로 5-8.

sampler_name: 알고리즘. euler 또는 dpmpp_2m이 좋은 기본값입니다.

scheduler: 단계 스케줄러. normal 또는 karras가 잘 작동합니다.

denoise: 얼마나 변경할지. 텍스트-투-이미지는 1.0.

5단계: 생성

- "Queue Prompt" 버튼 클릭(또는 Ctrl+Enter 누르기)

- 노드 테두리에서 진행 상황 관찰

- 이미지가 미리보기/저장 노드에 나타남

output/폴더에서 저장된 이미지 찾기

첫 생성 문제 해결

"체크포인트가 로드되지 않음":

- 모델이 올바른 폴더에 있는지 확인

- 모델 추가 후 페이지 새로고침

- 파일 확장자가 .safetensors 또는 .ckpt인지 확인

메모리 부족:

- 더 작은 해상도 시도 (768x768 → 512x512)

- GPU를 사용하는 다른 프로그램 닫기

- 더 작은 모델 사용

검은색 또는 노이즈 이미지:

- VAE가 연결되었는지 확인

- 모델이 해상도와 호환되는지 확인

- 다른 시드 시도

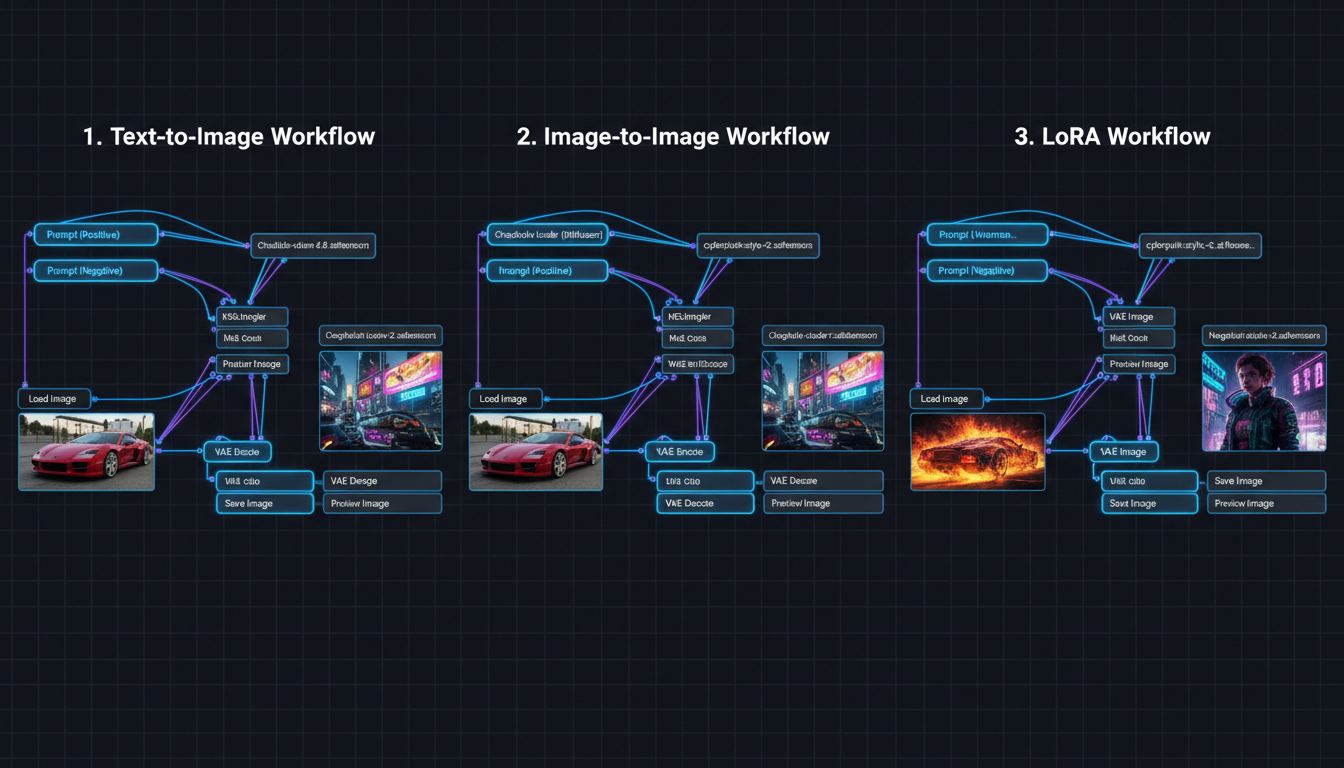

실용적인 워크플로우

텍스트-투-이미지 (기본)

기본 워크플로우. 다음이 있습니다:

- 모델을 로드하는 체크포인트

- 두 개의 CLIP 인코더 (긍정/부정)

- 빈 잠재 이미지 (빈 캔버스)

- 생성하는 KSampler

- 이미지를 드러내는 VAE 디코드

- 결과를 저장하는 이미지 저장

이미지-투-이미지

기존 이미지 수정:

- "Load Image" 노드 추가

- "VAE Encode" 노드에 연결

- VAE 인코드 출력 → KSampler latent_image 입력

- denoise < 1.0 설정 (일반적으로 0.5-0.8)

낮은 denoise = 원본을 더 많이 보존.

LoRA 사용

스타일/캐릭터 LoRA 추가:

- "Load LoRA" 노드 추가

- 체크포인트 MODEL → LoRA MODEL 입력 연결

- 체크포인트 CLIP → LoRA CLIP 입력 연결

- LoRA 출력 → 워크플로우의 나머지 부분 연결

- 강도 설정 (0.5-1.0)

여러 LoRA? 함께 연결하세요.

복잡함을 건너뛰고 싶으신가요? Apatero 는 기술적 설정 없이 즉시 전문 AI 결과를 제공합니다.

업스케일링

해상도 향상:

- "Upscale Image" 또는 모델 기반 업스케일러 추가

- VAE 디코드 후 연결

- 업스케일된 버전 저장

또는 더 나은 품질을 위해 잠재 업스케일링 사용 (더 복잡한 워크플로우).

다양한 사용 사례를 위한 다양한 워크플로우

다양한 사용 사례를 위한 다양한 워크플로우

커스텀 노드

ComfyUI의 강력함은 기능을 추가하는 확장인 커스텀 노드에서 나옵니다.

커스텀 노드 설치

방법 1: ComfyUI Manager (권장)

- 먼저 ComfyUI Manager 설치

- ComfyUI 재시작

- "Manager" 버튼 클릭

- 노드 찾아보기 및 설치

- 설치 후 재시작

방법 2: 수동

cd ComfyUI/custom_nodes

git clone https://github.com/[author]/[node-repo].git

## ComfyUI 재시작

필수 커스텀 노드

ComfyUI Manager:

- 노드/모델 설치 프로그램

- 문제 해결 도구

- 모두에게 필수

Impact Pack:

- 추가 샘플러

- 업스케일링 도구

- 얼굴 수정

ControlNet 보조 전처리기:

- 포즈 감지

- 깊이 맵

- 엣지 감지

IPAdapter:

- 얼굴/스타일 전송

- 캐릭터 일관성

- 참조 기반 생성

WAS 노드 스위트:

- 많은 유틸리티 노드

- 텍스트 도구

- 이미지 작업

워크플로우 찾기

워크플로우는 임베디드 데이터가 있는 PNG 파일로 공유됩니다:

- CivitAI (많은 워크플로우 공유)

- OpenArt.ai (워크플로우 라이브러리)

- Reddit r/comfyui

- GitHub 저장소

워크플로우 PNG를 ComfyUI로 드래그하여 로드하세요.

NSFW 구성

ComfyUI에는 내장 콘텐츠 필터가 없습니다. NSFW 생성의 경우:

콘텐츠 제작으로 월 $1,250+ 벌기

독점 크리에이터 제휴 프로그램에 참여하세요. 바이럴 동영상 성과에 따라 수익을 받으세요. 완전한 창작 자유로 자신만의 스타일로 콘텐츠를 만드세요.

적절한 모델 사용

- CyberRealistic (사실적)

- Pony Diffusion (애니메이션)

- epiCRealism (사실적)

models/checkpoints/에 배치.

NSFW LoRA

- CivitAI에서 찾기

models/loras/에 배치- 로드 LoRA 노드 추가

- 적절한 강도 설정

추가 구성 불필요

Automatic1111과 달리 ComfyUI에는 비활성화할 안전 검사기가 없습니다. 모델 자체가 기능을 결정합니다.

일반적인 문제 및 해결 방법

문제: 노드가 연결되지 않음

원인: 호환되지 않는 데이터 유형.

해결 방법: 색상이 일치하는지 확인하세요. MODEL을 IMAGE에 직접 연결할 수 없습니다.

문제: 워크플로우 오류

원인: 모델 또는 노드 누락.

해결 방법:

- 누락된 커스텀 노드 설치

- 필요한 모델 다운로드

- 파일 경로 확인

문제: 느린 생성

원인: 높은 해상도, 많은 단계, 제한된 VRAM.

해결 방법:

- 해상도 낮추기

- 더 적은 단계 (20으로도 충분)

- 다른 프로그램 닫기

- 가능한 경우 fp16/fp8 사용

문제: 매번 동일한 출력

원인: 고정된 시드.

해결 방법: 시드를 -1로 설정하여 랜덤으로 만드세요.

문제: 저장된 이미지를 찾을 수 없음

원인: 잘못된 폴더를 찾고 있음.

해결 방법: ComfyUI/output/ 폴더를 확인하세요.

초보자를 위한 팁

간단하게 시작

즉시 복잡한 워크플로우를 시도하지 마세요. 먼저 기본 텍스트-투-이미지를 마스터하세요.

작동하는 워크플로우 저장

무언가가 작동하면:

- "Save" 버튼 클릭

- .json 파일로 저장

- 또는 워크플로우 이미지 저장 (임베디드 데이터 포함)

미리보기 노드 사용

중간 결과를 보기 위해 어디든 "Preview Image" 노드를 추가하세요. 디버깅에 도움이 됩니다.

키보드 단축키 배우기

- Ctrl+Enter: 프롬프트 대기열

- Ctrl+Shift+Enter: 맨 앞 대기열

- Ctrl+D: 선택한 노드 복제

- Ctrl+A: 모두 선택

- Delete/Backspace: 선택 삭제

노드 설명 읽기

노드와 입력 위에 마우스를 올려 기능을 설명하는 툴팁을 확인하세요.

커뮤니티 가입

- Reddit: r/comfyui

- Discord 서버

- YouTube 튜토리얼

- CivitAI 워크플로우

클라우드 대안을 사용할 때

ComfyUI는 강력하지만 다음이 필요합니다:

- 하드웨어 투자

- 학습 시간

- 지속적인 유지 관리

Apatero와 같은 플랫폼은 다음을 제공합니다:

- 설정 불필요

- 내장 캐릭터 일관성

- 비디오 생성

- 사용량 기반 가격

다음의 경우 클라우드 고려:

- 강력한 GPU가 없음

- 즉각적인 결과를 원함

- 캐릭터 일관성이 우선 순위

- 비디오 생성이 필요

다음의 경우 로컬 고려:

- 하드웨어가 있음

- 최대 제어를 원함

- 개인 정보 보호가 중요

- 기술 학습을 즐김

자주 묻는 질문

ComfyUI가 Automatic1111보다 어렵나요?

처음에는 그렇습니다. 하지만 노드를 이해하면 더 직관적이 됩니다. 시각적 흐름은 무슨 일이 일어나고 있는지 이해하는 데 도움이 됩니다.

어떤 GPU가 필요한가요?

최소 8GB VRAM (GTX 1070, RTX 2060 수준). 편안한 사용을 위해 12GB+ 권장 (RTX 3060, 4070). 더 많은 VRAM = 더 높은 해상도와 더 빠른 생성.

Automatic1111 확장을 사용할 수 있나요?

아니요, 호환되지 않습니다. 하지만 대부분의 A1111 기능은 커스텀 노드를 통해 ComfyUI에서 동등한 기능을 갖습니다.

ComfyUI를 어떻게 업데이트하나요?

휴대용: 새 릴리스를 다운로드하고 모델 폴더를 복사하세요.

git용: ComfyUI 디렉토리에서 git pull.

모델은 어디서 찾나요?

CivitAI와 Hugging Face가 주요 소스입니다. .safetensors 파일을 다운로드하고 적절한 폴더에 배치하세요.

ComfyUI로 비디오를 만들 수 있나요?

예, AnimateDiff, WAN 또는 유사한 커스텀 노드를 사용하면 됩니다. 이미지보다 복잡하지만 가능합니다.

시작 체크리스트

설정:

- ComfyUI 다운로드 (휴대용 또는 git)

- 좋은 위치에 설치/압축 해제

- 최소 하나의 체크포인트 모델 다운로드

- 모델을 models/checkpoints/에 배치

- ComfyUI 성공적으로 실행

첫 생성:

- 기본 워크플로우 로드

- 체크포인트 로드에서 모델 선택

- 간단한 긍정 프롬프트 작성

- 기본 부정 프롬프트 추가

- 프롬프트 대기열 클릭

- output/에서 저장된 이미지 찾기

다음 단계:

- ComfyUI Manager 설치

- img2img 워크플로우 시도

- LoRA 추가

- 커스텀 노드 탐색

- 첫 번째 커스텀 워크플로우 저장

최종 생각

ComfyUI는 학습 곡선이 있지만, 사용 가능한 가장 강력한 Stable Diffusion 인터페이스입니다. 시각적 노드 시스템은 복잡한 워크플로우를 가능하게 하고 AI 이미지 생성이 실제로 어떻게 작동하는지 이해하는 데 도움이 됩니다.

기본 워크플로우로 시작하세요. 몇 가지 이미지를 생성하세요. 설정을 실험하세요. 점진적으로 복잡성을 추가하세요. 몇 시간 안에 편안해질 것입니다. 며칠 안에 다른 인터페이스보다 선호하게 될 것입니다.

시간 투자는 기능과 이해로 보상받습니다. 생성한 워크플로우는 시간이 지남에 따라 저장, 공유 및 개선될 수 있습니다.

관련 가이드: Stable Diffusion NSFW 설정, 캐릭터 일관성 가이드, 최고의 무검열 AI 생성기

AI 인플루언서를 만들 준비가 되셨나요?

완전한 51레슨 과정에서 ComfyUI와 AI 인플루언서 마케팅을 마스터하는 115명의 학생들과 함께하세요.

관련 기사

AI 딥페이크: 2025년 윤리, 법적 위험 및 책임 있는 사용

딥페이크 윤리와 합법성에 대한 완전한 가이드. 무엇이 허용되고 무엇이 허용되지 않는지, 그리고 법적 위험 없이 AI 콘텐츠를 책임감 있게 만드는 방법.

AI 헨타이 생성: 2025년 애니메이션 스타일 성인 아트 완벽 가이드

고품질 AI 헨타이와 애니메이션 성인 아트를 생성하는 방법. 전문 애니메이션 NSFW 콘텐츠를 위한 모델, 프롬프트, 스타일 및 기술.

2025년 최고의 무검열 AI 이미지 생성기: 완벽 비교 가이드

무검열 AI 이미지 생성기 종합 비교. 필터 없음, 제한 없음, 완전한 창작 자유. 어떤 플랫폼이 실제로 고품질 NSFW 콘텐츠를 제공할까요?