ComfyUI Anfängerleitfaden: Erste Schritte mit knotenbasierter KI-Bildgenerierung 2025

Vollständiger ComfyUI-Leitfaden für Anfänger. Installation, erster Workflow, wesentliche Knoten und Tipps für den Einstieg in knotenbasierte Stable Diffusion.

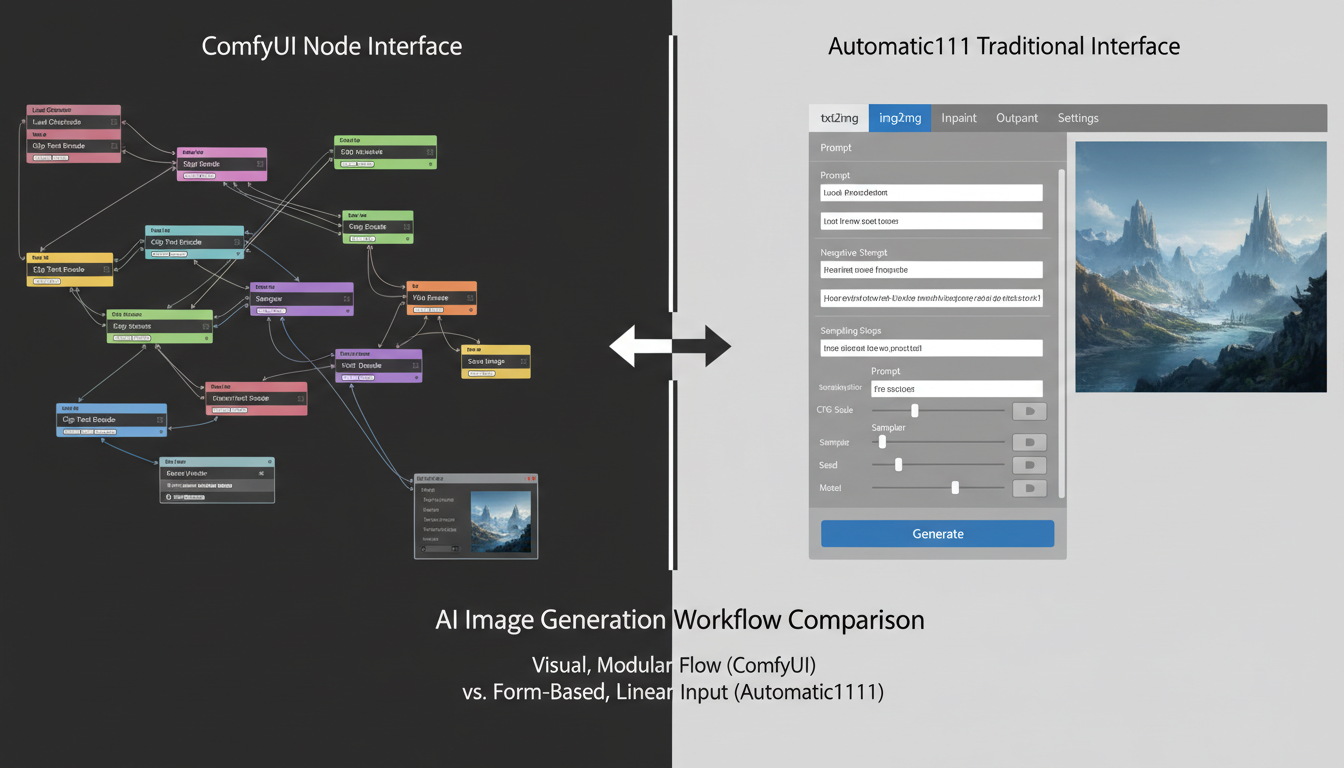

ComfyUI ist die leistungsstärkste Benutzeroberfläche für Stable Diffusion. Für Anfänger ist es auch einschüchternd. Die knotenbasierte Oberfläche sieht komplex aus, aber sobald Sie die Grundlagen verstehen, bietet sie mehr Kontrolle als jede andere Option.

Schnelle Antwort: ComfyUI ist eine knotenbasierte Benutzeroberfläche für Stable Diffusion, die maximale Flexibilität und Leistung bietet. Beginnen Sie mit der Installation über die portable Version (Windows) oder git clone (Mac/Linux), laden Sie ein Checkpoint-Modell herunter, laden Sie den Standard-Workflow und generieren Sie Ihr erstes Bild. Die Lernkurve beträgt ca. 2-4 Stunden bis zur grundlegenden Kompetenz.

- ComfyUI bietet mehr Kontrolle als Automatic1111, aber mit einer Lernkurve

- Installation dauert 15-30 Minuten mit der portablen Version

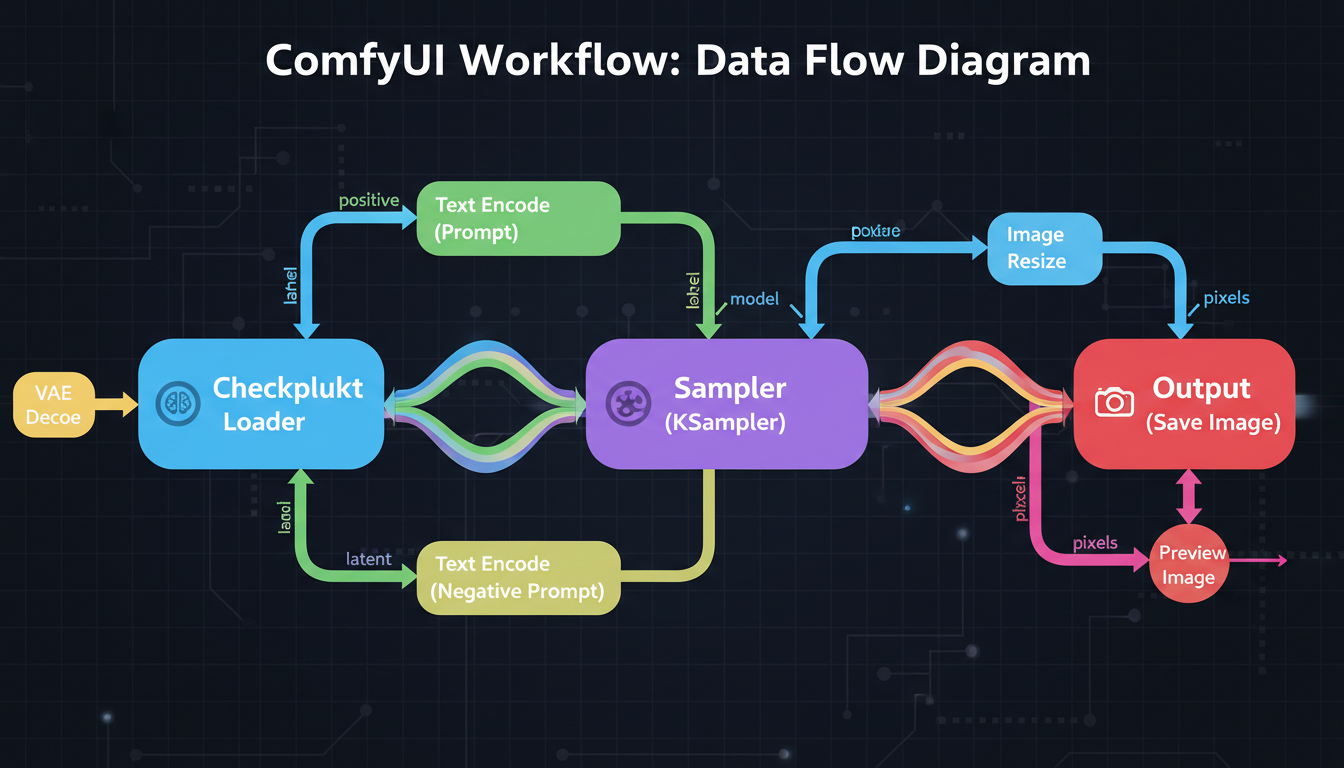

- Grundlegender Workflow: Checkpoint laden → Text kodieren → KSampler → VAE dekodieren → Speichern

- Knotenverbindungen repräsentieren Datenfluss—Farben zeigen Datentypen an

- Mindestens 8 GB VRAM, 12 GB+ empfohlen

- Einmal gelernt, können Workflows einfach gespeichert und geteilt werden

Warum ComfyUI statt Automatic1111?

Lassen Sie mich erklären, warum sich das Erlernen von ComfyUI lohnt:

Vorteile von ComfyUI

Leistung:

- Nutzt weniger VRAM für dieselben Aufgaben

- In vielen Fällen schnellere Generierung

- Besseres Speichermanagement

- Effiziente Stapelverarbeitung

Flexibilität:

- Vollständige Kontrolle über jeden Schritt

- Verschiedene Modelle einfach mischen

- Komplexe Workflows möglich

- Einfaches Experimentieren

Reproduzierbarkeit:

- Workflows sind in sich geschlossen

- Exakte Konfigurationen teilen

- Visuelles Debugging

- Verstehen, was passiert

Erweiterte Funktionen:

- Bessere ControlNet-Handhabung

- Komplexe LoRA-Kombinationen

- Multi-Modell-Pipelines

- Benutzerdefiniertes Knoten-Ökosystem

Wann Automatic1111 ausreicht

- Schnelle, einfache Generierung

- Sie wollen eine vertraute Oberfläche

- Keine komplexen Workflows erforderlich

- Begrenztes technisches Interesse

Meine Empfehlung

Lernen Sie ComfyUI. Die anfängliche Lernkurve zahlt sich mit mehr Fähigkeiten und besserem Verständnis der Funktionsweise von Stable Diffusion aus.

ComfyUI bietet mehr Leistung auf Kosten der anfänglichen Komplexität

ComfyUI bietet mehr Leistung auf Kosten der anfänglichen Komplexität

Installation

Windows (Portabel - Empfohlen)

Schritt 1: Herunterladen

- Gehen Sie zu ComfyUI GitHub Releases

- Laden Sie das neueste portable Paket herunter

- Entpacken Sie in einen Ordner (vermeiden Sie Leerzeichen im Pfad)

Schritt 2: Erster Start

- Doppelklicken Sie auf

run_nvidia_gpu.bat - Warten Sie auf die erste Einrichtung (kann beim ersten Mal einige Minuten dauern)

- Browser öffnet sich bei

http://127.0.0.1:8188

Schritt 3: Modell herunterladen

- Holen Sie sich einen Checkpoint von CivitAI oder Hugging Face

- Platzieren Sie ihn in

ComfyUI/models/checkpoints/ - Aktualisieren Sie die Oberfläche

Mac/Linux (Git Clone)

Schritt 1: Voraussetzungen

## Python 3.10+ erforderlich

python3 --version

## Git erforderlich

git --version

Schritt 2: Klonen und Installieren

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

pip install -r requirements.txt

Schritt 3: Ausführen

python main.py

## Browser öffnet sich bei http://127.0.0.1:8188

Ordnerstruktur

Nach der Installation sollten Sie die Ordner verstehen:

ComfyUI/

├── models/

│ ├── checkpoints/ # Hauptmodelle (.safetensors)

│ ├── loras/ # LoRA-Dateien

│ ├── vae/ # VAE-Dateien

│ ├── controlnet/ # ControlNet-Modelle

│ ├── upscale_models/ # Upscaler

│ └── embeddings/ # Textuelle Inversionen

├── input/ # Eingabebilder

├── output/ # Generierte Bilder

└── custom_nodes/ # Erweiterungen

Knoten verstehen

ComfyUI verwendet durch Linien verbundene Knoten. Jeder Knoten macht eine Sache. Linien übertragen Daten zwischen Knoten.

Wie Knoten funktionieren

Eingänge (linke Seite):

- Empfangen Daten von anderen Knoten

- Farbige Punkte zeigen Datentyp an

- Müssen kompatible Typen verbinden

Ausgänge (rechte Seite):

- Senden Daten an andere Knoten

- Farbe entspricht Datentyp

- Können mit mehreren Eingängen verbunden werden

Knoten-Körper:

- Enthält Einstellungen/Parameter

- Dropdown-Menüs für Auswahlen

- Zahleneingaben für Werte

Datentypen (Farben)

| Farbe | Datentyp | Beschreibung |

|---|---|---|

| Rosa | MODEL | Geladenes Checkpoint-Modell |

| Gelb | CLIP | Text-Encoder-Komponente |

| Lila | VAE | Bild-Encoder/Decoder |

| Orange | CONDITIONING | Kodierte Text-Prompts |

| Cyan | LATENT | Bild im latenten Raum |

| Grün | IMAGE | Tatsächliche Bilddaten |

Beim Verbinden von Knoten müssen die Farben übereinstimmen. Sie können MODEL nicht direkt mit CONDITIONING verbinden.

Wesentliche Knoten

Checkpoint laden:

- Lädt Ihre Modelldatei

- Ausgänge: MODEL, CLIP, VAE

CLIP Text Encode:

- Konvertiert Text in Conditioning

- Eingänge: CLIP, Text

- Ausgänge: CONDITIONING

KSampler:

- Hier findet die eigentliche Generierung statt

- Eingänge: MODEL, positives/negatives Conditioning, LATENT

- Ausgänge: LATENT (generiertes Bild)

VAE Decode:

- Konvertiert Latent in sichtbares Bild

- Eingänge: VAE, LATENT

- Ausgänge: IMAGE

Bild speichern:

- Speichert in Ausgabeordner

- Eingänge: IMAGE

Das Verstehen von Knotenverbindungen ist der Schlüssel zu ComfyUI

Das Verstehen von Knotenverbindungen ist der Schlüssel zu ComfyUI

Ihr erster Workflow

Lassen Sie mich Sie durch die Erstellung eines grundlegenden Bildgenerierungs-Workflows führen.

Schritt 1: Standard-Workflow laden

Wenn ComfyUI startet, erscheint ein Standard-Workflow. Falls nicht:

- Klicken Sie auf die Schaltfläche „Load Default"

- Oder ziehen Sie ein Workflow-PNG hinein

Der Standard-Workflow enthält alles, was für die grundlegende Generierung erforderlich ist.

Schritt 2: Modell auswählen

- Finden Sie den Knoten „Load Checkpoint"

- Klicken Sie auf das Dropdown-Menü

- Wählen Sie Ihr heruntergeladenes Modell

- Wenn keine Modelle erscheinen, haben Sie keine in

models/checkpoints/platziert

Schritt 3: Prompts schreiben

Positiver Prompt (was Sie wollen):

- Finden Sie den CLIP Text Encode, der mit „positive" verbunden ist

- Geben Sie Ihren Prompt in das Textfeld ein

- Beispiel:

schöne Landschaft, Berge, Sonnenuntergang, detailliert, 8k

Negativer Prompt (was zu vermeiden ist):

- Finden Sie den CLIP Text Encode, der mit „negative" verbunden ist

- Geben Sie Qualitätsnegative ein

- Beispiel:

verschwommen, niedrige Qualität, schlecht, hässlich

Schritt 4: Einstellungen konfigurieren

Im KSampler-Knoten:

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

seed: Zufallszahl für Reproduzierbarkeit. Verwenden Sie -1 für zufällig.

steps: Generierungsschritte. 20-30 für die meisten Modelle.

cfg: Prompt-Befolgung. 5-8 typisch.

sampler_name: Algorithmus. euler oder dpmpp_2m sind gute Standardwerte.

scheduler: Schritt-Scheduler. normal oder karras funktionieren gut.

denoise: Wie viel zu ändern ist. 1.0 für Text-zu-Bild.

Schritt 5: Generieren

- Klicken Sie auf die Schaltfläche „Queue Prompt" (oder drücken Sie Strg+Enter)

- Beobachten Sie den Fortschritt in den Knotenrändern

- Das Bild erscheint im Vorschau-/Speicherknoten

- Finden Sie das gespeicherte Bild im

output/-Ordner

Fehlerbehebung bei der ersten Generierung

„Kein Checkpoint geladen":

- Stellen Sie sicher, dass das Modell im richtigen Ordner ist

- Aktualisieren Sie die Seite nach dem Hinzufügen von Modellen

- Überprüfen Sie, ob die Dateierweiterung .safetensors oder .ckpt ist

Nicht genug Speicher:

- Versuchen Sie eine kleinere Auflösung (768x768 → 512x512)

- Schließen Sie andere GPU-nutzende Programme

- Verwenden Sie ein kleineres Modell

Schwarzes oder verrauschtes Bild:

- Überprüfen Sie, ob VAE verbunden ist

- Überprüfen Sie, ob das Modell mit der Auflösung kompatibel ist

- Versuchen Sie einen anderen Seed

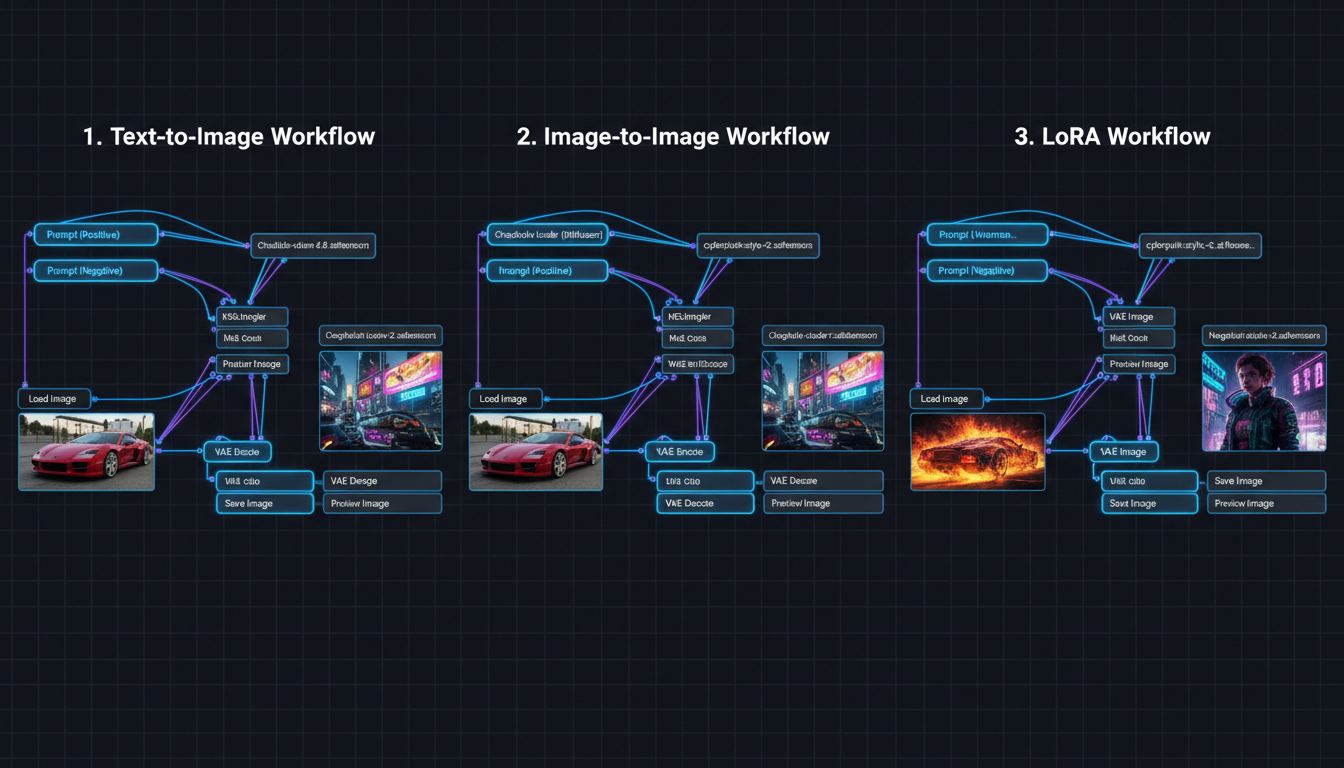

Praktische Workflows

Text zu Bild (Grundlegend)

Der Standard-Workflow. Sie haben:

- Checkpoint lädt Ihr Modell

- Zwei CLIP-Encoder (positiv/negativ)

- Leeres Latent-Bild (leere Leinwand)

- KSampler führt Generierung durch

- VAE Decode zeigt Bild

- Bild speichern speichert Ergebnis

Bild zu Bild

Vorhandenes Bild ändern:

- Fügen Sie den Knoten „Load Image" hinzu

- Verbinden Sie mit dem Knoten „VAE Encode"

- VAE Encode-Ausgang → KSampler latent_image-Eingang

- Setzen Sie denoise < 1.0 (typisch 0.5-0.8)

Niedrigerer Denoise = mehr vom Original erhalten.

Mit LoRAs

Stil-/Charakter-LoRAs hinzufügen:

- Fügen Sie den Knoten „Load LoRA" hinzu

- Verbinden Sie Checkpoint MODEL → LoRA MODEL-Eingang

- Verbinden Sie Checkpoint CLIP → LoRA CLIP-Eingang

- Verbinden Sie LoRA-Ausgänge → Rest des Workflows

- Setzen Sie Stärke (0.5-1.0)

Mehrere LoRAs? Verketten Sie sie.

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

Upscaling

Auflösung verbessern:

- Fügen Sie „Upscale Image" oder modellbasierten Upscaler hinzu

- Verbinden Sie nach VAE Decode

- Speichern Sie die vergrößerte Version

Oder verwenden Sie Latent-Upscaling für bessere Qualität (komplexerer Workflow).

Verschiedene Workflows für verschiedene Anwendungsfälle

Verschiedene Workflows für verschiedene Anwendungsfälle

Benutzerdefinierte Knoten

Die Leistung von ComfyUI kommt von benutzerdefinierten Knoten—Erweiterungen, die Funktionen hinzufügen.

Installation benutzerdefinierter Knoten

Methode 1: ComfyUI Manager (Empfohlen)

- Installieren Sie zuerst ComfyUI Manager

- Starten Sie ComfyUI neu

- Klicken Sie auf die Schaltfläche „Manager"

- Durchsuchen und installieren Sie Knoten

- Starten Sie nach der Installation neu

Methode 2: Manuell

cd ComfyUI/custom_nodes

git clone https://github.com/[author]/[node-repo].git

## ComfyUI neu starten

Wesentliche benutzerdefinierte Knoten

ComfyUI Manager:

- Knoten-/Modell-Installer

- Fehlerbehebungstools

- Unverzichtbar für jeden

Impact Pack:

- Zusätzliche Sampler

- Upscaling-Tools

- Gesichtskorrekturen

ControlNet Auxiliary Preprocessors:

- Posenerkennung

- Tiefenkarten

- Kantenerkennung

IPAdapter:

- Gesichts-/Stil-Transfer

- Charakterkonsistenz

- Referenzbasierte Generierung

WAS Node Suite:

- Viele Utility-Knoten

- Text-Tools

- Bildoperationen

Workflows finden

Workflows werden als PNG-Dateien mit eingebetteten Daten geteilt:

- CivitAI (viele geteilte Workflows)

- OpenArt.ai (Workflow-Bibliothek)

- Reddit r/comfyui

- GitHub-Repositories

Ziehen Sie ein Workflow-PNG in ComfyUI, um es zu laden.

NSFW-Konfiguration

ComfyUI hat keine eingebauten Inhaltsfilter. Für NSFW-Generierung:

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

Verwenden Sie geeignete Modelle

- CyberRealistic (realistisch)

- Pony Diffusion (Anime)

- epiCRealism (realistisch)

Platzieren Sie in models/checkpoints/.

NSFW-LoRAs

- Finden Sie auf CivitAI

- Platzieren Sie in

models/loras/ - Fügen Sie Load LoRA-Knoten hinzu

- Setzen Sie geeignete Stärke

Keine zusätzliche Konfiguration erforderlich

Im Gegensatz zu Automatic1111 hat ComfyUI keine Sicherheitsprüfer zum Deaktivieren. Die Modelle selbst bestimmen die Fähigkeit.

Häufige Probleme und Lösungen

Problem: Knoten verbinden sich nicht

Ursache: Inkompatible Datentypen.

Lösung: Überprüfen Sie, ob Farben übereinstimmen. Können MODEL nicht direkt mit IMAGE verbinden.

Problem: Workflow-Fehler

Ursache: Fehlende Modelle oder Knoten.

Lösung:

- Installieren Sie fehlende benutzerdefinierte Knoten

- Laden Sie erforderliche Modelle herunter

- Überprüfen Sie Dateipfade

Problem: Langsame Generierung

Ursache: Hohe Auflösung, viele Schritte, begrenzter VRAM.

Lösung:

- Niedrigere Auflösung

- Weniger Schritte (20 ist oft genug)

- Schließen Sie andere Programme

- Verwenden Sie fp16/fp8, falls verfügbar

Problem: Jedes Mal gleiche Ausgabe

Ursache: Fester Seed.

Lösung: Setzen Sie Seed auf -1 für zufällig.

Problem: Gespeicherte Bilder nicht gefunden

Ursache: Im falschen Ordner suchen.

Lösung: Überprüfen Sie den ComfyUI/output/-Ordner.

Tipps für Anfänger

Einfach anfangen

Versuchen Sie nicht sofort komplexe Workflows. Meistern Sie zuerst das grundlegende Text-zu-Bild.

Funktionierende Workflows speichern

Wenn etwas funktioniert:

- Klicken Sie auf die Schaltfläche „Save"

- Speichern Sie als .json-Datei

- Oder speichern Sie Workflow-Bild (hat eingebettete Daten)

Verwenden Sie Vorschau-Knoten

Fügen Sie überall „Preview Image"-Knoten hinzu, um Zwischenergebnisse zu sehen. Hilft beim Debugging.

Lernen Sie Tastaturkürzel

- Strg+Enter: Prompt in Warteschlange stellen

- Strg+Umschalt+Enter: Vorne in Warteschlange stellen

- Strg+D: Ausgewählte Knoten duplizieren

- Strg+A: Alles auswählen

- Entf/Rücktaste: Ausgewähltes löschen

Lesen Sie Knotenbeschreibungen

Bewegen Sie den Mauszeiger über Knoten und Eingänge für Tooltips, die erklären, was sie tun.

Treten Sie der Community bei

- Reddit: r/comfyui

- Discord-Server

- YouTube-Tutorials

- CivitAI-Workflows

Wann Cloud-Alternativen verwenden

ComfyUI ist leistungsstark, erfordert aber:

- Hardware-Investition

- Lernzeit

- Laufende Wartung

Plattformen wie Apatero bieten:

- Keine Einrichtung erforderlich

- Eingebaute Charakterkonsistenz

- Videogenerierung

- Pay-per-Use-Preise

Erwägen Sie Cloud, wenn:

- Sie keine leistungsfähige GPU haben

- Sie sofortige Ergebnisse wollen

- Charakterkonsistenz Priorität hat

- Sie Videogenerierung benötigen

Erwägen Sie lokal, wenn:

- Sie Hardware haben

- Sie maximale Kontrolle wollen

- Datenschutz kritisch ist

- Sie technisches Lernen genießen

Häufig gestellte Fragen

Ist ComfyUI schwieriger als Automatic1111?

Anfangs ja. Aber es wird intuitiver, sobald Sie Knoten verstehen. Der visuelle Ablauf hilft Ihnen zu verstehen, was passiert.

Welche GPU brauche ich?

Mindestens 8 GB VRAM (GTX 1070, RTX 2060-Level). 12 GB+ empfohlen für komfortable Nutzung (RTX 3060, 4070). Mehr VRAM = höhere Auflösung und schnellere Generierung.

Kann ich Automatic1111-Erweiterungen verwenden?

Nein, sie sind inkompatibel. Aber die meisten A1111-Funktionen haben ComfyUI-Äquivalente durch benutzerdefinierte Knoten.

Wie aktualisiere ich ComfyUI?

Für portabel: Neue Version herunterladen, Modellordner kopieren.

Für git: git pull im ComfyUI-Verzeichnis.

Wo finde ich Modelle?

CivitAI und Hugging Face sind die Hauptquellen. Laden Sie .safetensors-Dateien herunter und platzieren Sie sie in den entsprechenden Ordnern.

Kann ComfyUI Videos machen?

Ja, mit benutzerdefinierten Knoten für AnimateDiff, WAN oder ähnliches. Komplexer als Bilder, aber möglich.

Erste Schritte Checkliste

Einrichtung:

- ComfyUI herunterladen (portabel oder git)

- An guten Ort installieren/entpacken

- Mindestens ein Checkpoint-Modell herunterladen

- Modell in models/checkpoints/ platzieren

- ComfyUI erfolgreich ausführen

Erste Generierung:

- Standard-Workflow laden

- Modell in Load Checkpoint auswählen

- Einfachen positiven Prompt schreiben

- Grundlegenden negativen Prompt hinzufügen

- Auf Queue Prompt klicken

- Gespeichertes Bild in output/ finden

Nächste Schritte:

- ComfyUI Manager installieren

- img2img-Workflow ausprobieren

- LoRA hinzufügen

- Benutzerdefinierte Knoten erkunden

- Ersten benutzerdefinierten Workflow speichern

Abschließende Gedanken

ComfyUI hat eine Lernkurve, aber es ist die leistungsfähigste verfügbare Stable Diffusion-Schnittstelle. Das visuelle Knotensystem macht komplexe Workflows möglich und hilft Ihnen zu verstehen, wie KI-Bildgenerierung tatsächlich funktioniert.

Beginnen Sie mit dem Standard-Workflow. Generieren Sie einige Bilder. Experimentieren Sie mit Einstellungen. Fügen Sie schrittweise Komplexität hinzu. Innerhalb weniger Stunden werden Sie sich wohl fühlen. Innerhalb weniger Tage werden Sie es anderen Schnittstellen vorziehen.

Die Zeitinvestition zahlt sich in Fähigkeiten und Verständnis aus. Und die von Ihnen erstellten Workflows können im Laufe der Zeit gespeichert, geteilt und verfeinert werden.

Verwandte Leitfäden: Stable Diffusion NSFW-Einstellungen, Charakterkonsistenz-Leitfaden, Beste unzensierte KI-Generatoren

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

KI-Deepfakes: Ethik, rechtliche Risiken und verantwortungsvoller Einsatz 2025

Der vollständige Leitfaden zu Deepfake-Ethik und -Legalität. Was erlaubt ist, was nicht, und wie man KI-Inhalte verantwortungsvoll ohne rechtliches Risiko erstellt.

AI-Hentai-Generierung: Vollständiger Leitfaden für Anime-Kunst im Erwachsenenbereich 2025

So generieren Sie hochwertige AI-Hentai- und Anime-Erwachsenenkunst. Modelle, Prompts, Stile und Techniken für professionelle Anime-NSFW-Inhalte.

Beste Unzensierte KI-Bildgeneratoren 2025: Vollständiger Vergleichsleitfaden

Umfassender Vergleich unzensierter KI-Bildgeneratoren. Keine Filter, keine Einschränkungen, volle kreative Freiheit. Welche Plattformen liefern tatsächlich hochwertige NSFW-Inhalte?