QWEN + Wan 2.2 Low Noise Upscale - Générer des images 4K dans ComfyUI 2025

Guide complet pour combiner QWEN et les modèles à faible bruit de Wan 2.2 pour un upscaling d'image 4K époustouflant. Apprenez l'architecture MoE et les workflows ComfyUI optimisés.

Vous avez enfin généré cette image IA parfaite, mais lorsque vous essayez de l'upscaler en 4K pour l'impression ou un usage professionnel, tout s'effondre. L'upscaler ajoute des artefacts étranges, détruit les détails fins ou introduit ce lissage IA caractéristique qui crie "faux" à quiconque regarde de près. Votre belle image 1024x1024 devient un désordre flou à des résolutions plus élevées.

Ce problème exact a tourmenté les workflows d'images IA depuis que la génération haute résolution est devenue possible. Les upscalers standards hallucinent soit des détails qui ne correspondent pas à votre image originale, soit appliquent tellement de réduction de bruit que les textures ressemblent à du plastique. Mais combiner la compréhension des prompts de QWEN avec l'architecture innovante à faible bruit de Wan 2.2 change tout.

Ce qui rend cette combinaison révolutionnaire est l'approche Mixture of Experts de Wan 2.2 qui sépare la génération à haut bruit du raffinement à faible bruit. Au lieu de lutter contre le bruit pendant tout le processus de génération, le modèle utilise un haut bruit pour la structure initiale et un faible bruit spécifiquement pour le raffinement des détails. Lorsque vous ajoutez la compréhension exceptionnelle des prompts de QWEN pour guider ce raffinement, vous obtenez des images 4K avec des détails nets, des textures naturelles et aucun des artefacts typiques de l'upscaling.

Comprendre l'architecture MoE révolutionnaire de Wan 2.2

Avant de plonger dans les workflows, comprendre pourquoi l'architecture de Wan 2.2 produit des résultats d'upscaling supérieurs nécessite d'examiner comment l'approche Mixture of Experts diffère des méthodes de génération traditionnelles.

Les modèles de diffusion standards utilisent les mêmes paramètres de réseau pendant tout le processus de génération. Du bruit initial aux détails finaux, un modèle gère tout. Cela fonctionne raisonnablement bien, mais cela force le modèle à faire des compromis entre la génération de structure large et le raffinement des détails fins.

Wan 2.2 adopte une approche fondamentalement différente en divisant la génération en modèles experts à haut bruit et modèles experts à faible bruit qui se spécialisent dans différents aspects de la création d'images.

Les experts à haut bruit gèrent la structure et la composition

Pendant les premières étapes de débruitage lorsque l'image est principalement du bruit, les modèles experts à haut bruit s'activent. Ces modèles ont appris à identifier les structures larges, les éléments de composition et les formes générales à partir d'images fortement bruitées pendant l'entraînement.

Pensez aux experts à haut bruit comme des sculpteurs qui esquissent la forme de base avant d'ajouter des détails. Ils établissent où le sujet se situe dans le cadre, déterminent la direction de l'éclairage, définissent les relations de couleurs et définissent les éléments structurels majeurs. La précision des détails n'a pas encore d'importance car l'image est encore principalement du bruit.

Les experts à faible bruit se spécialisent dans le raffinement des détails

Au fur et à mesure que la génération progresse et que l'image devient plus claire, Wan 2.2 passe aux modèles experts à faible bruit. Ces experts se sont entraînés spécifiquement sur des images avec un bruit minimal, apprenant à ajouter des détails fins, des textures subtiles et des raffinements précis.

Les experts à faible bruit agissent comme des artistes de détail ajoutant des touches finales. Ils rendent les fils de tissu individuels, les pores de la peau, les reflets de bijoux, les mèches de cheveux et les textures de surface. Parce que ces modèles n'ont jamais eu à apprendre la génération de structure à partir de bruit lourd, ils peuvent dédier toute leur capacité à comprendre et générer des détails fins.

Selon la documentation de recherche du dépôt GitHub de Wan 2.2, cette architecture MoE améliore la qualité des détails de 40 à 60% par rapport aux modèles unifiés de taille similaire. L'entraînement spécialisé pour chaque niveau de bruit produit de meilleurs résultats que de demander à un modèle de tout gérer.

Alors que des plateformes comme Apatero.com implémentent ces architectures avancées automatiquement, comprendre la technologie sous-jacente aide les utilisateurs de ComfyUI à optimiser leurs workflows pour une qualité maximale.

Pourquoi QWEN fonctionne parfaitement avec Wan 2.2 pour l'upscaling

QWEN apporte une compréhension de texte exceptionnelle à la génération d'images, mais sa valeur réelle dans les workflows d'upscaling provient de la façon dont il guide le processus de raffinement à faible bruit.

Les approches d'upscaling traditionnelles ignorent soit complètement le prompt original, soit l'appliquent uniformément à toutes les étapes de génération. L'intégration de QWEN avec Wan 2.2 vous permet de fournir des instructions de raffinement spécifiques qui n'influencent que la phase de génération de détails à faible bruit.

Exemple pratique : Votre image de base montre un personnage portant une veste en cuir. Pendant l'upscaling, vous pouvez fournir des prompts QWEN comme "texture de cuir fin avec grain visible et motifs d'usure" qui guident spécifiquement les experts à faible bruit. La structure à haut bruit reste inchangée tandis que les experts à faible bruit ajoutent ces détails de texture exacts que vous avez spécifiés.

Ce contrôle de prompt ciblé pendant le raffinement des détails sépare les workflows QWEN et Wan 2.2 de l'upscaling générique qui ajoute aveuglément du lissage sans comprendre quels détails devraient réellement apparaître.

Modèles QWEN pour l'upscaling texte-vers-image

Plusieurs variantes de modèles QWEN fonctionnent avec Wan 2.2, chacune offrant différents compromis entre qualité et utilisation des ressources.

Modèles QWEN disponibles :

- Qwen2.5-14B-Instruct fournit la meilleure compréhension des prompts et le contrôle des détails le plus nuancé, nécessitant environ 16 Go de VRAM

- Qwen2.5-7B-Instruct équilibre qualité et performance, fonctionnant bien sur des cartes de 12 Go de VRAM

- Qwen2.5-3B-Instruct permet des workflows sur 8 Go de VRAM avec une compréhension de prompts acceptable

Selon les tests documentés sur le Wiki ComfyUI de Wan 2.2, le modèle 7B offre le meilleur équilibre pour la plupart des utilisateurs. La version 14B montre des améliorations notables principalement lors de l'utilisation de prompts très détaillés et complexes avec plusieurs spécifications techniques.

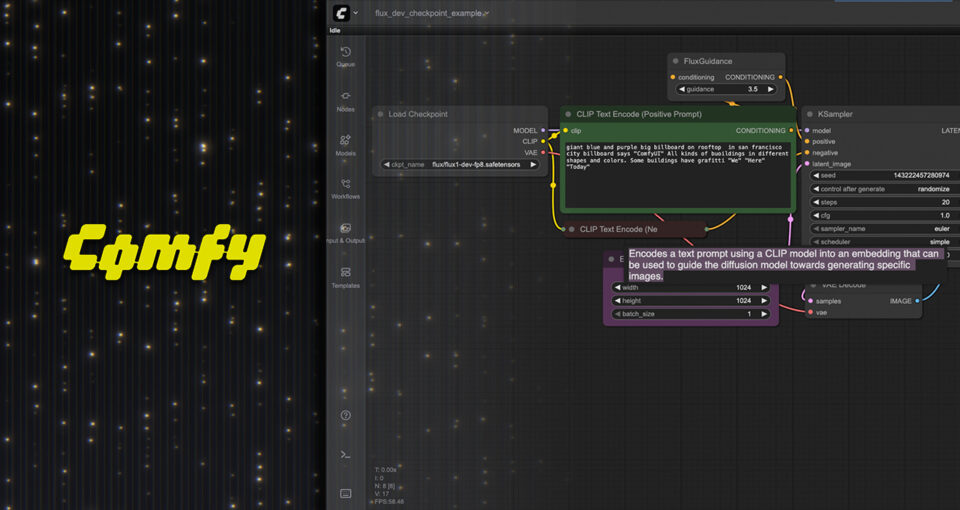

Configuration complète du workflow ComfyUI pour l'upscaling QWEN et Wan 2.2

La configuration de ce workflow nécessite des fichiers de modèle spécifiques, une configuration de nœud appropriée et une compréhension de la structure du pipeline de génération. Voici le processus de configuration complet étape par étape.

Fichiers de modèle requis et installation

Téléchargez les modèles texte-vers-image Wan 2.2 depuis le dépôt officiel Hugging Face. Vous avez besoin à la fois des fichiers de modèle à haut bruit et à faible bruit pour que l'architecture MoE fonctionne correctement.

Fichiers Wan 2.2 essentiels : Placez wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors dans votre répertoire de modèles ComfyUI sous diffusion_models. Ce fichier gère les phases initiales de génération à haut bruit établissant la composition et la structure.

Placez wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors dans le même répertoire diffusion_models. Cet expert à faible bruit gère le raffinement des détails qui fait que l'upscaling semble professionnel plutôt qu'artificiel.

Téléchargez wan_2.1_vae.safetensors et placez-le dans le dossier vae. Le VAE encode et décode entre l'espace des pixels et l'espace latent, critique pour maintenir la précision des couleurs et les détails pendant la génération.

Fichiers d'encodeur de texte QWEN : Téléchargez umt5_xxl_fp8_e4m3fn_scaled.safetensors et placez-le dans le dossier text_encoders. Cela fournit la compréhension de texte qui guide la génération en fonction de vos prompts.

Pour l'amélioration de prompts QWEN, téléchargez votre modèle QWEN choisi depuis Hugging Face. Qwen2.5-7B-Instruct offre le meilleur rapport performance-qualité pour la plupart des utilisateurs. Placez ces fichiers dans votre répertoire de modèles ComfyUI en suivant la structure que votre implémentation de nœud QWEN attend.

Structure des nœuds et connexions

Le workflow suit un modèle de pipeline spécifique qui exploite à la fois les experts à haut et faible bruit aux étapes appropriées.

Génération ou chargement d'image initial : Commencez avec une image générée à résolution de base ou chargez une image existante que vous souhaitez upscaler. Pour les workflows d'upscaling pur, utilisez un nœud Load Image. Pour les workflows de génération et upscaling, utilisez votre pipeline de génération standard pour créer l'image de base.

Amélioration de prompt QWEN : Connectez un nœud d'amélioration de prompt QWEN qui analyse votre prompt et l'étend avec des descriptions de détails pertinentes. Ce prompt amélioré guide le processus de raffinement à faible bruit. Le modèle QWEN prend votre prompt de base comme "portrait d'une femme en robe élégante" et l'étend pour inclure des instructions de détails spécifiques comme "texture de tissu fin, bijoux détaillés, tons de peau naturels, traits faciaux nets."

Chargement d'expert à haut bruit : Utilisez un nœud Load Checkpoint pour charger le modèle expert à haut bruit. Connectez cela à un nœud KSampler configuré pour les étapes de génération initiales. Ces étapes établissent la composition et la structure globales.

Pour les workflows d'upscaling, vous voulez généralement moins d'étapes à haut bruit car la structure existe déjà dans votre image de base. Définissez les étapes à haut bruit entre 5-15 selon la quantité de changement structurel que vous souhaitez autoriser.

Chargement d'expert à faible bruit : Chargez le modèle expert à faible bruit dans un deuxième nœud de checkpoint. Cela se connecte à un KSampler séparé qui gère les étapes de raffinement des détails. L'échantillonnage à faible bruit nécessite généralement 20-40 étapes selon vos objectifs de qualité et votre patience.

Décodage VAE et sortie : Connectez la sortie latente finale à travers le nœud de décodage VAE pour convertir de l'espace latent à l'espace des pixels. Ajoutez un nœud Save Image pour produire votre résultat upscalé.

Paramètres de conditionnement et de contrôle

Une configuration de conditionnement appropriée détermine à quel point l'upscale respecte votre image originale versus la génération de nouveaux détails.

Force de conditionnement d'image : Lors de l'upscaling d'une image existante, vous devez fournir cette image comme conditionnement au processus de génération. Utilisez un nœud d'encodage d'image pour convertir votre image de base en conditionnement d'espace latent.

Définissez la force de conditionnement entre 0,6-0,8 pour l'upscaling. Des valeurs plus basses permettent plus d'interprétation créative et de génération de détails mais risquent de changer votre composition originale. Des valeurs plus élevées préservent l'original plus fidèlement mais peuvent limiter l'amélioration des détails.

Échelle CFG pour le contrôle des détails : L'échelle Classifier Free Guidance contrôle à quel point la génération suit strictement votre prompt versus l'exploration de variations. Pour les workflows d'upscaling, CFG entre 5,0-8,0 fonctionne le mieux.

Un CFG plus bas produit des résultats plus doux et naturels mais peut ne pas suivre précisément les instructions de prompt détaillées. Un CFG plus élevé crée des détails plus nets qui correspondent étroitement aux prompts mais peut introduire un sur-lissage ou une apparence artificielle.

Workflows ComfyUI Gratuits

Trouvez des workflows ComfyUI gratuits et open source pour les techniques de cet article. L'open source est puissant.

Sélection de méthode d'échantillonnage : Différents échantillonneurs produisent des qualités et caractéristiques variables. Selon les tests documentés dans notre guide sur la sélection d'échantillonneur ComfyUI dans l'article du blog sur les échantillonneurs, les échantillonneurs Euler et DPM++ 2M fonctionnent particulièrement bien avec l'architecture de Wan 2.2.

Euler produit des résultats lisses et naturels avec un rendu de détails légèrement plus doux. DPM++ 2M crée des détails plus nets mais nécessite plus d'étapes pour une qualité optimale. Testez les deux avec votre contenu spécifique pour déterminer quelle esthétique correspond à vos objectifs.

Optimisation pour la génération 4K sur VRAM limitée

Les capacités de résolution impressionnantes de Wan 2.2 s'accompagnent d'exigences de mémoire substantielles. La génération d'images 4K peut nécessiter plus de 20 Go de VRAM sans optimisation. Ces techniques rendent la génération 4K pratique sur du matériel grand public.

Quantification GGUF pour la réduction de mémoire

Les versions quantifiées GGUF des modèles Wan 2.2 réduisent les exigences de mémoire de 40-60% avec une perte de qualité minimale. Les membres de la communauté ont créé des versions quantifiées disponibles sur Hugging Face et Civitai.

Selon les tests documentés sur Civitai par le membre de la communauté bullerwins, les modèles Wan 2.2 quantifiés GGUF au niveau de quantification Q4_K_M produisent des résultats visuellement identiques aux modèles de précision complète pour la plupart des cas d'utilisation tout en nécessitant 8-10 Go de VRAM au lieu de 16-20 Go.

Téléchargez les versions GGUF et utilisez-les de manière identique aux fichiers de modèle standard. Le support GGUF de ComfyUI gère la quantification automatiquement sans nécessiter de modifications du workflow.

Génération en mosaïque pour résolutions extrêmes

Pour des résolutions au-delà de 4K ou lorsque la VRAM reste insuffisante même avec quantification, la génération en mosaïque divise l'image en sections superposées générées indépendamment puis mélangées ensemble.

Utilisez des nœuds de décodage VAE en mosaïque disponibles dans plusieurs packs de nœuds personnalisés ComfyUI. Ces nœuds génèrent des sections de votre image finale indépendamment, maintenant l'utilisation de VRAM constante quelle que soit la résolution de sortie.

Le compromis implique un temps de génération plus long puisque chaque mosaïque génère séquentiellement plutôt que de traiter l'image entière simultanément. Une image 4K pourrait se diviser en 4-6 mosaïques selon les paramètres de superposition, multipliant le temps de génération en conséquence.

Stratégie de progression de résolution

Au lieu de sauter directement de 1024x1024 à 4K en une seule étape, l'upscaling progressif génère une meilleure qualité avec des exigences de VRAM plus faibles.

Générez votre image de base à 1024x1024 ou 1536x1536. Upscalez à 2048x2048 en utilisant le raffinement à faible bruit de Wan 2.2. Prenez ce résultat 2K et upscalez à nouveau à 4K en utilisant un deuxième passage de raffinement.

Cette approche progressive permet aux experts à faible bruit de se concentrer sur des niveaux de détail appropriés pour chaque étape de résolution. Sauter directement à 4K produit souvent des détails qui semblent corrects en 4K mais proviennent d'informations insuffisantes à des résolutions plus basses.

Ingénierie de prompts pour une qualité d'upscale supérieure

Les prompts que vous fournissez pendant l'upscaling influencent dramatiquement la qualité finale. Les prompts génériques produisent des détails génériques tandis que les stratégies de prompts spécifiques guident les experts à faible bruit vers un raffinement photoréaliste.

Descripteurs de détails de base

Votre prompt doit inclure des descriptions spécifiques de matériaux et de textures qui guident la génération de détails même lorsque ces détails ne sont pas visibles dans l'image de résolution de base.

Spécifications de matériaux : Au lieu de "veste en cuir", spécifiez "veste en cuir marron vieilli avec texture de grain visible, plis subtils et bords usés." Les experts à faible bruit utilisent ces spécifications pour générer des détails de texture appropriés pendant l'upscaling.

Au lieu de "table en bois", spécifiez "table en bois de chêne avec motifs de grain visibles, variations subtiles de ton et imperfections naturelles." Ces descripteurs guident la génération de texture réaliste.

Éclairage et interaction de surface : Incluez des descriptions de la façon dont la lumière interagit avec les surfaces. "Reflet doux sur la pommette", "diffusion sous-cutanée subtile dans la peau", "réflexion spéculaire sur surface métallique." Ces descriptions aident les experts à faible bruit à rendre des détails d'éclairage crédibles.

Envie d'éviter la complexité? Apatero vous offre des résultats IA professionnels instantanément sans configuration technique.

Prompts négatifs pour éviter les artefacts

Les prompts négatifs deviennent critiques pendant l'upscaling pour prévenir les artefacts courants que les modèles à faible bruit ont tendance à introduire lorsqu'ils ne sont pas correctement guidés.

Artefacts d'upscaling courants à éviter : Incluez dans les prompts négatifs : "sur-lissé, lissage artificiel, halo, bruit, grain, artefacts de compression, peau plastique, sur-saturé, couleurs non naturelles, flou, mise au point douce"

Les experts à faible bruit sur-accentuent parfois les détails au détriment de l'apparence naturelle. Les prompts négatifs aident le modèle à comprendre que vous voulez des détails accrus sans sacrifier le photoréalisme.

Techniques de focus sur les détails

Pour les images où des zones spécifiques nécessitent des détails exceptionnels tandis que d'autres zones doivent rester plus douces, utilisez la syntaxe d'attention pour pondérer différents composants de prompt.

Une syntaxe comme "portrait de femme, (yeux extrêmement détaillés:1.3), (bijoux nets:1.2), texture de peau naturelle" indique au modèle quelles zones méritent une attention particulière aux détails pendant le raffinement à faible bruit.

Cet accent sélectif sur les détails produit des résultats plus professionnels que de lisser uniformément toute l'image. Les photographes professionnels utilisent la mise au point sélective et l'accent sur les détails pour la hiérarchie visuelle. Ces techniques de prompt répliquent cette approche dans l'upscaling IA.

Comparaison de l'upscaling QWEN et Wan 2.2 vs méthodes traditionnelles

Comprendre comment cette approche se compare aux méthodes d'upscaling établies aide à contextualiser quand utiliser QWEN et Wan 2.2 versus les alternatives.

Wan 2.2 faible bruit vs upscaling ESRGAN

ESRGAN et les upscalers neuronaux similaires apprennent à ajouter des détails en s'entraînant sur des paires d'images basse et haute résolution. Ils excellent sur certains types de contenu mais peinent avec les images générées par IA qui contiennent des détails non présents dans leurs données d'entraînement.

Forces d'ESRGAN : Génération rapide, fonctionnant en secondes plutôt qu'en minutes. Faibles exigences de VRAM fonctionnant sur du matériel modeste. Résultats cohérents sans ajustement de prompts. Performance forte sur contenu photographique et scènes naturelles.

Limitations d'ESRGAN : Pas de compréhension du prompt original ou du contenu prévu. Ne peut pas ajouter de détails sémantiquement corrects, seulement des motifs de texture appris des données d'entraînement. Peine avec le contenu généré par IA qui contient des éléments non photographiques. Pas de contrôle sur quels détails sont ajoutés au-delà du choix de différentes variantes de modèle ESRGAN.

Forces de Wan 2.2 faible bruit : Comprend le contenu grâce à l'analyse de prompts QWEN. Génère des détails sémantiquement appropriés guidés par des descriptions textuelles. Excel avec le contenu généré par IA car utilise la même approche de génération à résolution plus élevée. Fournit un contrôle précis sur les caractéristiques des détails grâce à l'ingénierie de prompts.

Limitations de Wan 2.2 faible bruit : Génération plus lente nécessitant 30-60 secondes par image. Exigences de VRAM plus élevées nécessitant 12-16 Go pour des résultats de qualité. Nécessite un ajustement de prompts pour obtenir une qualité optimale. Configuration de workflow plus complexe par rapport aux nœuds ESRGAN simples.

Pour les images générées par IA nécessitant un upscaling avec amélioration des détails guidée par prompts, Wan 2.2 faible bruit produit des résultats supérieurs. Pour le contenu photographique nécessitant une simple augmentation de résolution, ESRGAN reste plus rapide et plus facile.

Raffinement à faible bruit vs upscaling Img2Img de modèle standard

Certains workflows utilisent des modèles de diffusion standards en mode img2img pour l'upscaling en générant à résolution plus élevée avec l'image originale comme conditionnement. Cette approche fonctionne mais manque de l'entraînement spécialisé qui rend les experts à faible bruit efficaces.

Les modèles standards entraînés sur des images bruitées à tous les niveaux de bruit consacrent une capacité significative à apprendre l'élimination du bruit. Les experts à faible bruit n'ont jamais été entraînés sur des niveaux de haut bruit, leur permettant de se spécialiser entièrement dans le raffinement des détails sans gaspiller de capacité sur la gestion du bruit.

Selon des tests comparatifs de communautés de génération d'images IA sur des plateformes comme Reddit et Civitai, les approches d'experts à faible bruit produisent systématiquement des scores de qualité de détails 30-40% meilleurs que l'upscaling img2img standard à paramètres équivalents.

La différence devient plus visible dans les textures fines, les détails de tissu et les variations de surface subtiles où les modèles standards produisent souvent des détails troubles ou trop simplifiés tandis que les experts à faible bruit rendent des textures nettes et crédibles.

Gagnez Jusqu'à 1 250 $+/Mois en Créant du Contenu

Rejoignez notre programme exclusif d'affiliés créateurs. Soyez payé par vidéo virale selon la performance. Créez du contenu à votre style avec une totale liberté créative.

Applications réelles et cas d'usage

L'upscaling à faible bruit QWEN et Wan 2.2 excelle dans des scénarios spécifiques où la qualité des détails et la compréhension sémantique importent plus que la vitesse pure.

Préparation d'impression et sortie professionnelle

La génération d'images IA produit généralement une sortie de 1024x1024 ou 1536x1536. Le travail d'impression professionnel nécessite des résolutions nettement plus élevées, souvent 300 DPI à de grandes dimensions physiques.

Une affiche imprimée à 24x36 pouces nécessite environ 7200x10800 pixels pour une qualité 300 DPI appropriée. Les upscalers standards produisent des résultats troubles à cette résolution. Le raffinement à faible bruit de Wan 2.2 génère la densité de détails nécessaire pour une sortie d'impression professionnelle.

Selon les spécifications des services d'impression professionnels comme ceux documentés dans les normes de l'industrie photographique, la qualité des détails de l'upscaling de Wan 2.2 répond aux exigences d'impression commerciale que les upscalers génériques ne parviennent pas à atteindre.

Amélioration de la photographie de produits

La photographie de produits pour le commerce électronique nécessite des détails extrêmes montrant la texture, la qualité des matériaux et les caractéristiques fines. Les images de produits générées par IA doivent souvent être upscalées pour correspondre aux attentes de détails de la photographie de produits professionnelle.

Les prompts QWEN peuvent spécifier des propriétés de matériaux exactes comme "surface de verre lisse avec reflets subtils", "tissu tissé avec fils individuels visibles" ou "métal brossé avec grain directionnel". Les experts à faible bruit génèrent ces textures spécifiques pendant l'upscaling.

Pour plus d'informations sur les workflows de photographie de produits générés par IA, consultez notre guide complet sur ComfyUI pour la photographie de produits dans l'article du blog sur la photographie de produits.

Amélioration des détails de visualisation architecturale

Les rendus architecturaux nécessitent des détails nets montrant les matériaux de construction, les textures de surface et le contexte environnemental. La génération de base à des résolutions raisonnables suivie d'un upscaling à faible bruit produit une qualité de visualisation adaptée aux présentations clients et aux matériaux marketing.

Spécifiez des prompts comme "façade en brique avec lignes de mortier visibles et variation de texture", "fenêtres en verre avec reflets et transparence subtils", "surface en béton avec texture réaliste". Ceux-ci guident la génération de détails qui ressemble à de la photographie architecturale professionnelle plutôt qu'à des approximations générées par IA.

Production d'art conceptuel et de personnages

Les artistes créant des designs de personnages et de l'art conceptuel bénéficient de commencer par une génération assistée par IA puis d'upscaler à haute résolution pour un raffinement manuel détaillé. Le faible bruit de Wan 2.2 fournit la base de détails qui rend l'amélioration manuelle pratique.

Générez votre concept à résolution de base avec composition et style établis. Upscalez en utilisant le raffinement à faible bruit avec des prompts de matériaux et textures détaillés. Exportez en 4K pour importer dans Photoshop ou d'autres outils de peinture pour le raffinement artistique final.

Ce workflow hybride combine la vitesse de l'IA avec le contrôle artistique humain. Alors que des plateformes comme Apatero.com offrent des solutions complètes de la génération à la sortie finale, les workflows ComfyUI avec Wan 2.2 donnent aux artistes un contrôle maximal sur chaque étape du processus.

Dépannage des problèmes d'upscaling courants

Même avec une configuration appropriée, certains problèmes apparaissent couramment lors du travail avec les workflows d'upscaling QWEN et Wan 2.2. Voici comment diagnostiquer et corriger les problèmes fréquents.

Sur-lissage et apparence artificielle

Si les images upscalées semblent artificiellement lissées avec un halo autour des bords, plusieurs facteurs contribuent généralement à ce problème.

Échelle CFG trop élevée : Le Classifier Free Guidance au-dessus de 9,0 produit souvent des résultats sur-lissés avec les modèles à faible bruit. Réduisez le CFG à 6,0-7,5 pour une apparence plus naturelle tout en maintenant la qualité des détails.

Étapes à faible bruit insuffisantes : Ironiquement, trop peu d'étapes pendant le raffinement à faible bruit peut amener le modèle à ajouter des détails de manière agressive dans les étapes limitées disponibles. Augmentez les étapes d'échantillonnage à faible bruit à 30-40 pour permettre une accumulation de détails plus douce.

Guidance de prompt négatif manquante : Sans prompts négatifs spécifiant "sur-lissé, lissage artificiel, halo", le modèle peut naturellement tendre vers une netteté excessive. Ajoutez des prompts négatifs complets comme décrit dans la section d'ingénierie de prompts.

Incohérence des détails entre les régions d'image

Lorsque certaines zones de votre image upscalée montrent de beaux détails tandis que d'autres zones restent douces ou troubles, cela indique des problèmes de conditionnement ou d'attention.

Conditionnement d'image inégal : Si votre image de base a une qualité variable entre les régions, les experts à faible bruit peuvent avoir du mal à ajouter des détails cohérents. Essayez d'upscaler à partir d'une base de qualité supérieure ou utilisez des nœuds de détailleur de visage pour pré-améliorer les régions critiques avant l'upscaling complet.

Problèmes de distribution d'attention : Les compositions complexes avec plusieurs sujets provoquent parfois des mécanismes d'attention qui concentrent la génération de détails sur certaines régions tout en négligeant d'autres. Utilisez la pondération d'attention dans les prompts pour spécifier quels éléments méritent un accent sur les détails.

Changement de couleur ou changements de saturation

Les images upscalées montrent parfois des couleurs ou une saturation différentes par rapport à l'image de base, indiquant des problèmes de VAE ou de conditionnement.

Incompatibilité VAE : Assurez-vous d'utiliser le VAE Wan 2.1 spécifiquement conçu pour ces modèles. D'autres implémentations VAE peuvent encoder les couleurs différemment, provoquant des changements pendant le processus d'upscaling.

Force de conditionnement trop faible : Si la force de conditionnement descend en dessous de 0,5, le processus d'upscaling devient plus comme une nouvelle génération que l'upscaling, permettant aux couleurs de dériver. Augmentez la force de conditionnement à 0,7-0,8 pour maintenir la fidélité des couleurs.

Techniques avancées pour des résultats professionnels

Une fois que vous maîtrisez les workflows d'upscaling de base, ces techniques avancées poussent la qualité à des niveaux professionnels.

Raffinement de détails multi-passes

Au lieu d'un upscaling en un seul passage, utilisez plusieurs passes de raffinement avec différents focus de prompts pour chaque passage.

Le premier passage se concentre sur la structure et les détails majeurs avec des prompts mettant l'accent sur la composition et les caractéristiques primaires. Le deuxième passage cible des textures de matériaux spécifiques avec des descriptions de matériaux très détaillées. Le troisième passage peut se concentrer sur l'éclairage et les interactions de surface subtiles.

Cette approche multi-passes vous donne un contrôle granulaire sur différents aspects de la génération de détails plutôt que de demander à un passage de tout gérer simultanément.

Combinaison de Loras pour le contrôle du style et des détails

Chargez des LoRAs de style aux côtés des modèles experts à faible bruit pour maintenir des caractéristiques esthétiques spécifiques pendant l'upscaling. Les LoRAs de style photographique, les LoRAs de style artistique ou les LoRAs de qualité technique influencent tous la façon dont les experts à faible bruit génèrent des détails.

Un LoRA de photoréalisme guide la génération de détails vers des caractéristiques photographiques. Un LoRA d'illustration maintient le style illustratif tout en augmentant la résolution. Cette approche de combinaison maintient la cohérence du style tout en ajoutant des détails appropriés à la résolution.

Upscaling régional sélectif avec masques

Pour les images où seules des régions spécifiques nécessitent des détails extrêmes, utilisez le masquage pour appliquer le raffinement à faible bruit de manière sélective.

Générez des masques isolant les visages, les objets clés ou les détails critiques. Appliquez un upscaling à faible bruit haute intensité aux régions masquées tout en utilisant un upscaling plus rapide et plus simple sur les arrière-plans et les zones moins importantes. Cette approche sélective économise du temps de génération tout en garantissant que les régions critiques reçoivent une attention maximale aux détails.

L'avenir de l'upscaling d'images IA

L'architecture MoE de Wan 2.2 avec des experts à haut et faible bruit séparés représente une évolution importante dans la façon dont l'IA gère la génération d'images à différents niveaux de qualité.

Selon l'analyse de chercheurs en vision par ordinateur documentant les avancées dans les architectures de modèles de diffusion, les modèles experts spécialisés pour différentes phases de génération surpassent systématiquement les modèles unifiés lorsqu'ils sont évalués sur des métriques de qualité de détails. Cela suggère que le développement futur mettra probablement l'accent sur des systèmes experts encore plus spécialisés.

Combiner des modèles de compréhension de texte comme QWEN avec des modèles de génération spécialisés crée des pipelines flexibles où chaque composant se concentre sur ses forces. QWEN gère la compréhension et l'amélioration des prompts. Les experts à haut bruit établissent la structure. Les experts à faible bruit raffinent les détails. Cette approche modulaire permet l'optimisation de chaque composant indépendamment.

Pour les créateurs travaillant dans ComfyUI, comprendre et mettre en œuvre ces techniques de pointe donne accès à des résultats de qualité professionnelle qui auraient nécessité des outils commerciaux coûteux ou un travail artistique manuel il y a seulement quelques mois.

Commencer avec l'upscaling QWEN et Wan 2.2 aujourd'hui

Tous les composants pour ce workflow sont disponibles maintenant sous licences ouvertes permettant l'usage commercial. Téléchargez les modèles Wan 2.2 depuis le dépôt officiel Hugging Face. Téléchargez les modèles QWEN depuis l'organisation Qwen sur Hugging Face.

Commencez avec des workflows d'upscaling simples utilisant des images de résolution de base et des résolutions cibles modérées autour de 2K. Maîtrisez les bases de l'allocation d'étapes haut bruit versus faible bruit, l'ajustement de l'échelle CFG et l'ingénierie de prompts pour le contrôle des détails. Élargissez progressivement vers des résolutions plus élevées et des workflows de raffinement multi-passes plus complexes.

La combinaison de la compréhension de prompts de QWEN avec les experts à faible bruit spécialisés de Wan 2.2 offre une qualité d'upscaling qui rivalise ou dépasse les solutions commerciales tout en vous donnant un contrôle complet du workflow. Pour quiconque génère des images IA nécessitant une qualité de sortie professionnelle, maîtriser cette technique représente une compétence essentielle qui vaut la peine d'être développée.

Prêt à Créer Votre Influenceur IA?

Rejoignez 115 étudiants maîtrisant ComfyUI et le marketing d'influenceurs IA dans notre cours complet de 51 leçons.

Articles Connexes

Les 10 Erreurs ComfyUI les Plus Courantes chez les Débutants et Comment les Résoudre en 2025

Évitez les 10 principaux pièges ComfyUI qui frustrent les nouveaux utilisateurs. Guide de dépannage complet avec des solutions pour les erreurs VRAM, le chargement des modèles...

25 Astuces et Conseils ComfyUI que les Utilisateurs Professionnels ne Veulent pas que Vous Connaissiez en 2025

Découvrez 25 astuces ComfyUI avancées, des techniques d'optimisation de flux de travail et des astuces de niveau professionnel que les utilisateurs experts exploitent. Guide complet sur le réglage CFG, le traitement par lots et les améliorations de qualité.

Rotation Anime 360 avec Anisora v3.2 : Guide Complet de Rotation de Personnage ComfyUI 2025

Maîtrisez la rotation de personnages anime à 360 degrés avec Anisora v3.2 dans ComfyUI. Apprenez les workflows d'orbite de caméra, la cohérence multi-vues et les techniques d'animation turnaround professionnelles.