QWEN + Wan 2.2 Low Noise Upscale - 4K-Bilder in ComfyUI generieren 2025

Vollständiger Leitfaden zur Kombination von QWEN und Wan 2.2's Low Noise Modellen für beeindruckende 4K-Bildskalierung. Lernen Sie die MoE-Architektur und optimierte ComfyUI-Workflows kennen.

Sie haben endlich das perfekte KI-Bild generiert, aber wenn Sie versuchen, es für Druck oder professionelle Nutzung auf 4K hochzuskalieren, fällt alles auseinander. Der Upscaler fügt seltsame Artefakte hinzu, zerstört feine Details oder führt diese verräterische KI-Schärfung ein, die jedem, der genau hinschaut, sofort "Fälschung" zuruft. Ihr schönes 1024x1024-Bild wird zu einem verschwommenen Durcheinander bei höheren Auflösungen.

Genau dieses Problem plagt KI-Bild-Workflows, seit hochauflösende Generierung möglich wurde. Standard-Upscaler halluzinieren entweder Details, die nicht zu Ihrem Originalbild passen, oder wenden so viel Rauschunterdrückung an, dass Texturen wie Plastik aussehen. Aber die Kombination von QWENs Prompt-Verständnis mit Wan 2.2's innovativer Low Noise Architektur ändert alles.

Was diese Kombination revolutionär macht, ist Wan 2.2's Mixture of Experts Ansatz, der High Noise Generierung von Low Noise Verfeinerung trennt. Anstatt während des gesamten Generierungsprozesses gegen Rauschen zu kämpfen, verwendet das Modell High Noise für die anfängliche Struktur und Low Noise speziell für die Detailverfeinerung. Wenn Sie QWENs außergewöhnliches Prompt-Verständnis hinzufügen, um diese Verfeinerung zu leiten, erhalten Sie 4K-Bilder mit gestochen scharfen Details, natürlichen Texturen und keinen der typischen Upscaling-Artefakte.

Wan 2.2's revolutionäre MoE-Architektur verstehen

Bevor wir in Workflows eintauchen, erfordert das Verständnis, warum Wan 2.2's Architektur überlegene Upscaling-Ergebnisse produziert, die Untersuchung, wie sich der Mixture of Experts Ansatz von traditionellen Generierungsmethoden unterscheidet.

Standard-Diffusionsmodelle verwenden während des gesamten Generierungsprozesses dieselben Netzwerkparameter. Von anfänglichem Rauschen bis zu finalen Details handhabt ein Modell alles. Dies funktioniert einigermaßen gut, aber es zwingt das Modell zu Kompromissen zwischen breiter Strukturgenerierung und feiner Detailverfeinerung.

Wan 2.2 verfolgt einen grundlegend anderen Ansatz, indem es die Generierung in High Noise Experten-Modelle und Low Noise Experten-Modelle aufteilt, die sich auf verschiedene Aspekte der Bilderstellung spezialisieren.

High Noise Experten kümmern sich um Struktur und Komposition

Während der ersten Denoising-Schritte, wenn das Bild hauptsächlich aus Rauschen besteht, aktivieren sich die High Noise Experten-Modelle. Diese Modelle lernten, breite Strukturen, Kompositionselemente und allgemeine Formen aus stark verrauschten Bildern während des Trainings zu identifizieren.

Denken Sie an High Noise Experten als Bildhauer, die die Grundform skizzieren, bevor sie Details hinzufügen. Sie legen fest, wo das Subjekt im Rahmen sitzt, bestimmen die Beleuchtungsrichtung, setzen Farbbeziehungen auf und definieren wichtige Strukturelemente. Detailgenauigkeit ist noch nicht wichtig, weil das Bild noch hauptsächlich aus Rauschen besteht.

Low Noise Experten spezialisieren sich auf Detailverfeinerung

Wenn die Generierung fortschreitet und das Bild klarer wird, wechselt Wan 2.2 zu Low Noise Experten-Modellen. Diese Experten trainierten speziell auf Bildern mit minimalem Rauschen und lernten, feine Details, subtile Texturen und präzise Verfeinerungen hinzuzufügen.

Low Noise Experten agieren wie Detailkünstler, die letzte Akzente setzen. Sie rendern einzelne Stofffäden, Hautporen, Schmuckreflexionen, Haarsträhnen und Oberflächentexturen. Da diese Modelle nie Strukturgenerierung aus starkem Rauschen lernen mussten, können sie ihre gesamte Kapazität dem Verständnis und der Generierung feiner Details widmen.

Laut Forschungsdokumentation aus dem Wan 2.2 GitHub-Repository verbessert diese MoE-Architektur die Detailqualität um 40-60% im Vergleich zu einheitlichen Modellen ähnlicher Größe. Das spezialisierte Training für jede Rauschstufe produziert bessere Ergebnisse, als ein Modell zu bitten, alles zu handhaben.

Während Plattformen wie Apatero.com diese fortschrittlichen Architekturen automatisch implementieren, hilft das Verständnis der zugrunde liegenden Technologie ComfyUI-Benutzern, ihre Workflows für maximale Qualität zu optimieren.

Warum QWEN perfekt mit Wan 2.2 für Upscaling funktioniert

QWEN bringt außergewöhnliches Textverständnis zur Bildgenerierung, aber sein wirklicher Wert in Upscaling-Workflows kommt daher, wie es den Low Noise Verfeinerungsprozess leitet.

Traditionelle Upscaling-Ansätze ignorieren entweder den ursprünglichen Prompt vollständig oder wenden ihn einheitlich über alle Generierungsschritte an. QWENs Integration mit Wan 2.2 ermöglicht es Ihnen, spezifische Verfeinerungsanweisungen bereitzustellen, die nur die Low Noise Detailgenerierungsphase beeinflussen.

Praktisches Beispiel: Ihr Basisbild zeigt einen Charakter, der eine Lederjacke trägt. Während des Upscalings können Sie QWEN-Prompts wie "feine Ledertextur mit sichtbarer Körnung und Abnutzungsmustern" bereitstellen, die speziell die Low Noise Experten leiten. Die High Noise Struktur bleibt unverändert, während Low Noise Experten genau die von Ihnen angegebenen Texturdetails hinzufügen.

Diese gezielte Prompt-Kontrolle während der Detailverfeinerung unterscheidet QWEN und Wan 2.2 Workflows von generischem Upscaling, das blind Schärfung hinzufügt, ohne zu verstehen, welche Details tatsächlich erscheinen sollten.

QWEN-Modelle für Text-zu-Bild-Upscaling

Mehrere QWEN-Modellvarianten funktionieren mit Wan 2.2, jede bietet unterschiedliche Kompromisse zwischen Qualität und Ressourcennutzung.

Verfügbare QWEN-Modelle:

- Qwen2.5-14B-Instruct bietet das beste Prompt-Verständnis und die nuancierteste Detailsteuerung, benötigt etwa 16GB VRAM

- Qwen2.5-7B-Instruct balanciert Qualität und Performance, funktioniert gut auf 12GB VRAM-Karten

- Qwen2.5-3B-Instruct ermöglicht Workflows auf 8GB VRAM mit akzeptablem Prompt-Verständnis

Laut Tests, die im Wan 2.2 ComfyUI Wiki dokumentiert sind, bietet das 7B-Modell das beste Gleichgewicht für die meisten Benutzer. Die 14B-Version zeigt hauptsächlich merkliche Verbesserungen bei der Verwendung sehr detaillierter, komplexer Prompts mit mehreren technischen Spezifikationen.

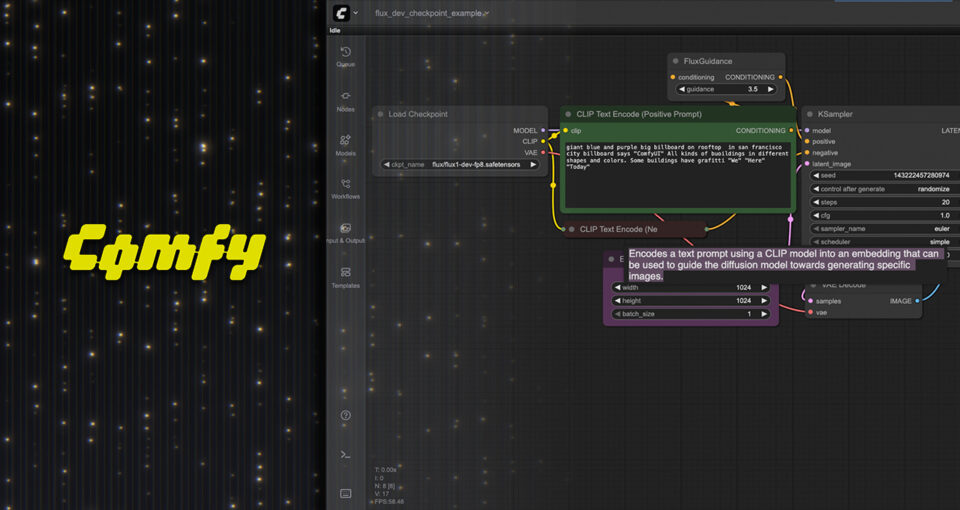

Vollständiges ComfyUI-Workflow-Setup für QWEN und Wan 2.2 Upscaling

Das Einrichten dieses Workflows erfordert spezifische Modelldateien, ordnungsgemäße Knotenkonfiguration und das Verständnis der Generierungs-Pipeline-Struktur. Hier ist der vollständige Schritt-für-Schritt-Einrichtungsprozess.

Erforderliche Modelldateien und Installation

Laden Sie die Wan 2.2 Text-zu-Bild-Modelle aus dem offiziellen Hugging Face Repository herunter. Sie benötigen sowohl die High Noise als auch die Low Noise Modelldateien, damit die MoE-Architektur ordnungsgemäß funktioniert.

Wesentliche Wan 2.2 Dateien: Platzieren Sie wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors in Ihrem ComfyUI-Modellverzeichnis unter diffusion_models. Diese Datei verarbeitet die anfänglichen High Noise Generierungsphasen, die Komposition und Struktur festlegen.

Platzieren Sie wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors im selben diffusion_models Verzeichnis. Dieser Low Noise Experte verarbeitet die Detailverfeinerung, die Upscaling professionell statt künstlich aussehen lässt.

Laden Sie wan_2.1_vae.safetensors herunter und platzieren Sie es im vae-Ordner. Der VAE kodiert und dekodiert zwischen Pixelraum und latentem Raum, kritisch für die Aufrechterhaltung der Farbgenauigkeit und Details während der Generierung.

QWEN Text-Encoder-Dateien: Laden Sie umt5_xxl_fp8_e4m3fn_scaled.safetensors herunter und platzieren Sie es im text_encoders-Ordner. Dies bietet das Textverständnis, das die Generierung basierend auf Ihren Prompts leitet.

Für QWEN-Prompt-Verbesserung laden Sie Ihr gewähltes QWEN-Modell von Hugging Face herunter. Qwen2.5-7B-Instruct bietet das beste Performance-zu-Qualitäts-Verhältnis für die meisten Benutzer. Platzieren Sie diese Dateien in Ihrem ComfyUI-Modellverzeichnis gemäß der Struktur, die Ihre QWEN-Knotenimplementierung erwartet.

Knotenstruktur und Verbindungen

Der Workflow folgt einem spezifischen Pipeline-Muster, das sowohl High Noise als auch Low Noise Experten in geeigneten Phasen nutzt.

Initiale Bildgenerierung oder Laden: Beginnen Sie entweder mit einem generierten Bild in Basisauflösung oder laden Sie ein vorhandenes Bild, das Sie hochskalieren möchten. Für reine Upscaling-Workflows verwenden Sie einen Load Image Knoten. Für Generierungs-und-Upscaling-Workflows verwenden Sie Ihre Standard-Generierungs-Pipeline, um das Basisbild zu erstellen.

QWEN-Prompt-Verbesserung: Verbinden Sie einen QWEN-Prompt-Verbesserungsknoten, der Ihren Prompt analysiert und ihn mit relevanten Detailbeschreibungen erweitert. Dieser erweiterte Prompt leitet den Low Noise Verfeinerungsprozess. Das QWEN-Modell nimmt Ihren Basis-Prompt wie "Porträt einer Frau in elegantem Kleid" und erweitert ihn um spezifische Detailanweisungen wie "feine Stofftextur, detaillierter Schmuck, natürliche Hauttöne, scharfe Gesichtszüge."

High Noise Experten-Laden: Verwenden Sie einen Load Checkpoint Knoten, um das High Noise Experten-Modell zu laden. Verbinden Sie dies mit einem KSampler-Knoten, der für initiale Generierungsschritte konfiguriert ist. Diese Schritte etablieren die Gesamtkomposition und Struktur.

Für Upscaling-Workflows möchten Sie normalerweise weniger High Noise Schritte, da die Struktur bereits in Ihrem Basisbild vorhanden ist. Setzen Sie High Noise Schritte zwischen 5-15, abhängig davon, wie viel strukturelle Änderung Sie zulassen möchten.

Low Noise Experten-Laden: Laden Sie das Low Noise Experten-Modell in einem zweiten Checkpoint-Knoten. Dies verbindet sich mit einem separaten KSampler, der die Detailverfeinerungsschritte verarbeitet. Low Noise Sampling benötigt normalerweise 20-40 Schritte, abhängig von Ihren Qualitätszielen und Geduld.

VAE-Dekodierung und Ausgabe: Verbinden Sie die finale latente Ausgabe durch den VAE-Dekodierknoten, um vom latenten Raum zum Pixelraum zu konvertieren. Fügen Sie einen Save Image Knoten hinzu, um Ihr hochskaliertes Ergebnis auszugeben.

Konditionierungs- und Steuerungseinstellungen

Eine ordnungsgemäße Konditionierungseinstellung bestimmt, wie sehr das Upscale Ihr Originalbild respektiert versus neue Details generiert.

Bildkonditionierungsstärke: Beim Hochskalieren eines vorhandenen Bildes müssen Sie dieses Bild als Konditionierung für den Generierungsprozess bereitstellen. Verwenden Sie einen Bildkodierungsknoten, um Ihr Basisbild in latente Raumkonditionierung zu konvertieren.

Setzen Sie die Konditionierungsstärke zwischen 0.6-0.8 für Upscaling. Niedrigere Werte ermöglichen mehr kreative Interpretation und Detailgenerierung, riskieren aber eine Änderung Ihrer Originalkomposition. Höhere Werte bewahren das Original treuer, können aber die Detailverbesserung einschränken.

CFG-Skala für Detailsteuerung: Die Classifier Free Guidance Skala steuert, wie strikt die Generierung Ihrem Prompt folgt versus Variationen erkundet. Für Upscaling-Workflows funktioniert CFG zwischen 5.0-8.0 am besten.

Niedrigeres CFG produziert weichere, natürlichere Ergebnisse, folgt aber möglicherweise nicht präzise detaillierten Prompt-Anweisungen. Höheres CFG erstellt schärfere Details, die Prompts eng entsprechen, kann aber Über-Schärfung oder künstliches Aussehen einführen.

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

Sampling-Methoden-Auswahl: Verschiedene Sampler produzieren unterschiedliche Qualität und Eigenschaften. Laut Tests, die in unserem Leitfaden zur ComfyUI-Sampler-Auswahl im Blog-Sampler-Artikel dokumentiert sind, funktionieren Euler und DPM++ 2M Sampler besonders gut mit Wan 2.2's Architektur.

Euler produziert glatte, natürliche Ergebnisse mit etwas weicherer Detailwiedergabe. DPM++ 2M erstellt schärfere Details, benötigt aber mehr Schritte für optimale Qualität. Testen Sie beide mit Ihrem spezifischen Inhalt, um zu bestimmen, welche Ästhetik Ihren Zielen entspricht.

Optimierung für 4K-Generierung bei begrenztem VRAM

Die beeindruckenden Auflösungsfähigkeiten von Wan 2.2 kommen mit erheblichen Speicheranforderungen. Die Generierung von 4K-Bildern kann ohne Optimierung 20GB+ VRAM erfordern. Diese Techniken machen 4K-Generierung auf Consumer-Hardware praktikabel.

GGUF-Quantisierung für Speicherreduzierung

GGUF-quantisierte Versionen von Wan 2.2-Modellen reduzieren die Speicheranforderungen um 40-60% bei minimalem Qualitätsverlust. Community-Mitglieder haben quantisierte Versionen erstellt, die auf Hugging Face und Civitai verfügbar sind.

Laut Tests, die auf Civitai von Community-Mitglied bullerwins dokumentiert wurden, produzieren GGUF-quantisierte Wan 2.2-Modelle auf Q4_K_M-Quantisierungsstufe für die meisten Anwendungsfälle visuell identische Ergebnisse wie Vollpräzisionsmodelle, während sie 8-10GB VRAM anstelle von 16-20GB benötigen.

Laden Sie die GGUF-Versionen herunter und verwenden Sie sie identisch zu Standard-Modelldateien. ComfyUI's GGUF-Unterstützung verarbeitet die Quantisierung automatisch ohne erforderliche Workflow-Änderungen.

Gekachelte Generierung für extreme Auflösungen

Für Auflösungen über 4K oder wenn VRAM selbst mit Quantisierung unzureichend bleibt, teilt gekachelte Generierung das Bild in überlappende Abschnitte auf, die unabhängig generiert und dann zusammengemischt werden.

Verwenden Sie gekachelte VAE-Dekodierknoten, die in mehreren ComfyUI-Custom-Node-Paketen verfügbar sind. Diese Knoten generieren Abschnitte Ihres finalen Bildes unabhängig und halten die VRAM-Nutzung unabhängig von der Ausgabeauflösung konstant.

Der Kompromiss beinhaltet längere Generierungszeit, da jede Kachel sequenziell generiert wird, anstatt das gesamte Bild gleichzeitig zu verarbeiten. Ein 4K-Bild könnte sich je nach Überlappungseinstellungen in 4-6 Kacheln aufteilen und die Generierungszeit entsprechend vervielfachen.

Auflösungsprogression-Strategie

Anstatt direkt von 1024x1024 zu 4K in einem Schritt zu springen, generiert progressives Upscaling bessere Qualität mit niedrigeren VRAM-Anforderungen.

Generieren Sie Ihr Basisbild bei 1024x1024 oder 1536x1536. Skalieren Sie auf 2048x2048 mit Wan 2.2 Low Noise Verfeinerung hoch. Nehmen Sie dieses 2K-Ergebnis und skalieren Sie es erneut auf 4K mit einem zweiten Verfeinerungsdurchgang hoch.

Dieser progressive Ansatz ermöglicht es den Low Noise Experten, sich auf angemessene Detailstufen für jeden Auflösungsschritt zu konzentrieren. Das direkte Springen zu 4K produziert oft Details, die bei 4K korrekt aussehen, aber aus unzureichenden Informationen bei niedrigeren Auflösungen stammen.

Prompt-Engineering für überlegene Upscale-Qualität

Die Prompts, die Sie während des Upscalings bereitstellen, beeinflussen die finale Qualität dramatisch. Generische Prompts produzieren generische Details, während spezifische Prompt-Strategien die Low Noise Experten zu fotorealistischer Verfeinerung leiten.

Basis-Detail-Deskriptoren

Ihr Prompt sollte spezifische Material- und Texturbeschreibungen enthalten, die die Detailgenerierung leiten, selbst wenn diese Details im Basisbild nicht sichtbar sind.

Materialspezifikationen: Anstelle von "Lederjacke" spezifizieren Sie "abgenutzte braune Lederjacke mit sichtbarer Körnung, subtilen Falten und abgenutzten Kanten." Die Low Noise Experten verwenden diese Spezifikationen, um während des Upscalings geeignete Texturdetails zu generieren.

Anstelle von "Holztisch" spezifizieren Sie "Eichenholztisch mit sichtbaren Maserungsmustern, subtilen Tonvariationen und natürlichen Unvollkommenheiten." Diese Deskriptoren leiten realistische Texturgenerierung.

Beleuchtungs- und Oberflächeninteraktion: Fügen Sie Beschreibungen hinzu, wie Licht mit Oberflächen interagiert. "Weiches Highlight auf Wangenknochen," "subtile Subsurface Scattering in Haut," "Spiegelreflexion auf Metalloberfläche." Diese Beschreibungen helfen Low Noise Experten, glaubwürdige Beleuchtungsdetails zu rendern.

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

Negative Prompts zur Vermeidung von Artefakten

Negative Prompts werden während des Upscalings kritisch, um häufige Artefakte zu verhindern, die Low Noise Modelle tendenziell einführen, wenn sie nicht ordnungsgemäß geleitet werden.

Häufige Upscaling-Artefakte zum Vermeiden: In negative Prompts einschließen: "überschärft, künstliche Schärfung, Haloing, Rauschen, Körnung, Kompressionsartefakte, Plastikhaut, übersättigt, unnatürliche Farben, verschwommen, Soft-Fokus"

Low Noise Experten überzeichnen manchmal Details auf Kosten des natürlichen Aussehens. Negative Prompts helfen dem Modell zu verstehen, dass Sie erhöhte Details ohne Opferung des Fotorealismus wünschen.

Detail-Fokus-Techniken

Für Bilder, bei denen bestimmte Bereiche außergewöhnliche Details erfordern, während andere Bereiche weicher bleiben sollten, verwenden Sie Aufmerksamkeitssyntax, um verschiedene Prompt-Komponenten zu gewichten.

Syntax wie "Porträt einer Frau, (extrem detaillierte Augen:1.3), (scharfer Schmuck:1.2), natürliche Hauttextur" sagt dem Modell, welche Bereiche während der Low Noise Verfeinerung zusätzliche Detailaufmerksamkeit verdienen.

Diese selektive Detailbetonung produziert professionellere Ergebnisse als das gleichmäßige Schärfen des gesamten Bildes. Professionelle Fotografen verwenden selektiven Fokus und Detailbetonung für visuelle Hierarchie. Diese Prompt-Techniken replizieren diesen Ansatz beim KI-Upscaling.

Vergleich von QWEN und Wan 2.2 Upscaling vs. traditionellen Methoden

Das Verständnis, wie sich dieser Ansatz mit etablierten Upscaling-Methoden vergleicht, hilft zu kontextualisieren, wann QWEN und Wan 2.2 versus Alternativen verwendet werden sollten.

Wan 2.2 Low Noise vs. ESRGAN Upscaling

ESRGAN und ähnliche neuronale Upscaler lernen, Details hinzuzufügen, indem sie auf Paaren von niedrig- und hochauflösenden Bildern trainieren. Sie zeichnen sich bei bestimmten Inhaltstypen aus, haben aber Schwierigkeiten mit KI-generierten Bildern, die Details enthalten, die nicht in ihren Trainingsdaten vorhanden sind.

ESRGAN Stärken: Schnelle Generierung, funktioniert in Sekunden statt Minuten. Niedrige VRAM-Anforderungen, läuft auf bescheidener Hardware. Konsistente Ergebnisse ohne Prompt-Tuning. Starke Leistung bei fotografischen Inhalten und natürlichen Szenen.

ESRGAN Einschränkungen: Kein Verständnis des ursprünglichen Prompts oder beabsichtigten Inhalts. Kann keine semantisch korrekten Details hinzufügen, nur Texturmuster, die aus Trainingsdaten gelernt wurden. Kämpft mit KI-generierten Inhalten, die nicht-fotografische Elemente enthalten. Keine Kontrolle darüber, welche Details hinzugefügt werden, außer der Auswahl verschiedener ESRGAN-Modellvarianten.

Wan 2.2 Low Noise Stärken: Versteht den Inhalt durch QWEN-Prompt-Analyse. Generiert semantisch angemessene Details, die durch Textbeschreibungen geleitet werden. Hervorragend geeignet für KI-generierten Inhalt, da derselbe Generierungsansatz bei höherer Auflösung verwendet wird. Bietet präzise Kontrolle über Detailmerkmale durch Prompt-Engineering.

Wan 2.2 Low Noise Einschränkungen: Langsamere Generierung, erfordert 30-60 Sekunden pro Bild. Höhere VRAM-Anforderungen, benötigt 12-16GB für Qualitätsergebnisse. Erfordert Prompt-Tuning, um optimale Qualität zu erreichen. Komplexeres Workflow-Setup im Vergleich zu einfachen ESRGAN-Knoten.

Für KI-generierte Bilder, die Upscaling mit Prompt-gesteuerter Detailverbesserung erfordern, produziert Wan 2.2 Low Noise überlegene Ergebnisse. Für fotografische Inhalte, die eine einfache Auflösungserhöhung erfordern, bleibt ESRGAN schneller und einfacher.

Low Noise Verfeinerung vs. Standard-Modell Img2Img Upscaling

Einige Workflows verwenden Standard-Diffusionsmodelle im Img2Img-Modus für Upscaling, indem sie bei höherer Auflösung mit dem Originalbild als Konditionierung generieren. Dieser Ansatz funktioniert, fehlt aber das spezialisierte Training, das Low Noise Experten effektiv macht.

Standard-Modelle, die auf verrauschten Bildern bei allen Rauschstufen trainiert wurden, widmen erhebliche Kapazität dem Erlernen der Rauschentfernung. Low Noise Experten trainierten nie auf hohen Rauschstufen, was es ihnen ermöglicht, sich vollständig auf Detailverfeinerung zu spezialisieren, ohne Kapazität für Rauschbehandlung zu verschwenden.

Laut vergleichenden Tests von KI-Bildgenerierungs-Communities auf Plattformen wie Reddit und Civitai produzieren Low Noise Experten-Ansätze konsistent 30-40% bessere Detailqualitätswerte als Standard-Img2Img-Upscaling bei äquivalenten Einstellungen.

Der Unterschied wird am deutlichsten bei feinen Texturen, Stoffdetails und subtilen Oberflächenvariationen, wo Standard-Modelle oft verschlammte oder übervereinfachte Details produzieren, während Low Noise Experten gestochen scharfe, glaubwürdige Texturen rendern.

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

Reale Anwendungen und Anwendungsfälle

QWEN und Wan 2.2 Low Noise Upscaling zeichnet sich in spezifischen Szenarien aus, in denen Detailqualität und semantisches Verständnis mehr zählen als reine Geschwindigkeit.

Druck- und professionelle Ausgabevorbereitung

KI-Bildgenerierung produziert typischerweise 1024x1024 oder 1536x1536 Ausgabe. Professionelle Druckarbeiten erfordern deutlich höhere Auflösungen, oft 300 DPI bei großen physischen Abmessungen.

Ein Poster, das bei 24x36 Zoll gedruckt wird, erfordert etwa 7200x10800 Pixel für ordnungsgemäße 300 DPI Qualität. Standard-Upscaler produzieren schlammige Ergebnisse bei dieser Auflösung. Wan 2.2 Low Noise Verfeinerung generiert die Detaildichte, die für professionelle Druckausgabe benötigt wird.

Laut Spezifikationen von professionellen Druckdiensten wie denen, die in Fotografiebranchenstandards dokumentiert sind, erfüllt die Detailqualität vom Wan 2.2 Upscaling kommerzielle Druckanforderungen, die generische Upscaler nicht erreichen.

Produktfotografie-Verbesserung

Produktfotografie für E-Commerce erfordert extreme Details, die Textur, Materialqualität und feine Merkmale zeigen. KI-generierte Produktbilder müssen oft hochskaliert werden, um den Detailerwartungen professioneller Produktfotografie zu entsprechen.

QWEN-Prompts können exakte Materialeigenschaften wie "glatte Glasoberfläche mit subtilen Reflexionen," "gewebter Stoff mit sichtbaren einzelnen Fäden" oder "gebürstetes Metall mit gerichteter Maserung" spezifizieren. Die Low Noise Experten generieren diese spezifischen Texturen während des Upscalings.

Für weitere Informationen zu KI-generierten Produktfotografie-Workflows siehe unseren umfassenden Leitfaden zu ComfyUI für Produktfotografie im Blog-Produktfotografie-Artikel.

Architekturvisualisierungs-Detail-Verbesserung

Architektur-Renderings erfordern gestochen scharfe Details, die Baumaterialien, Oberflächentexturen und Umgebungskontext zeigen. Basis-Generierung bei vernünftigen Auflösungen gefolgt von Low Noise Upscaling produziert Visualisierungsqualität, die für Kundenpräsentationen und Marketingmaterialien geeignet ist.

Spezifizieren Sie Prompts wie "Ziegelfassade mit sichtbaren Mörtelfugen und Texturvariation," "Glasfenster mit subtilen Reflexionen und Transparenz," "Betonoberfläche mit realistischer Textur." Diese leiten Detailgenerierung, die wie professionelle Architekturfotografie aussieht statt KI-generierter Annäherungen.

Charakter- und Konzeptkunstproduktion

Künstler, die Charakterdesigns und Konzeptkunst erstellen, profitieren davon, mit KI-unterstützter Generierung zu beginnen und dann für detaillierte manuelle Verfeinerung auf hohe Auflösung hochzuskalieren. Wan 2.2 Low Noise bietet die Detailgrundlage, die manuelle Verbesserung praktikabel macht.

Generieren Sie Ihr Konzept bei Basisauflösung mit etablierter Komposition und Stil. Skalieren Sie mit Low Noise Verfeinerung mit detaillierten Material- und Textur-Prompts hoch. Exportieren Sie bei 4K für den Import in Photoshop oder andere Malwerkzeuge für finale künstlerische Verfeinerung.

Dieser Hybrid-Workflow kombiniert KI-Geschwindigkeit mit menschlicher künstlerischer Kontrolle. Während Plattformen wie Apatero.com komplette Lösungen von der Generierung bis zur finalen Ausgabe bieten, geben ComfyUI-Workflows mit Wan 2.2 Künstlern maximale Kontrolle über jede Phase des Prozesses.

Fehlerbehebung häufiger Upscaling-Probleme

Selbst bei ordnungsgemäßer Einrichtung treten bestimmte Probleme häufig bei der Arbeit mit QWEN und Wan 2.2 Upscaling-Workflows auf. Hier erfahren Sie, wie Sie häufige Probleme diagnostizieren und beheben.

Über-Schärfung und künstliches Aussehen

Wenn hochskalierte Bilder künstlich scharf mit Haloing um Kanten aussehen, tragen normalerweise mehrere Faktoren zu diesem Problem bei.

CFG-Skala zu hoch: Classifier Free Guidance über 9.0 produziert oft überschärfte Ergebnisse mit den Low Noise Modellen. Reduzieren Sie CFG auf 6.0-7.5 für natürlicheres Aussehen bei Beibehaltung der Detailqualität.

Unzureichende Low Noise Schritte: Ironischerweise können zu wenige Schritte während der Low Noise Verfeinerung dazu führen, dass das Modell in den verfügbaren begrenzten Schritten aggressiv Details hinzufügt. Erhöhen Sie Low Noise Sampling-Schritte auf 30-40, um sanftere Detailakkumulation zu ermöglichen.

Fehlende Negative Prompt-Führung: Ohne negative Prompts, die "überschärft, künstliche Schärfung, Haloing" spezifizieren, kann das Modell natürlich zu übermäßiger Schärfe neigen. Fügen Sie umfassende negative Prompts hinzu, wie im Prompt-Engineering-Abschnitt beschrieben.

Detail-Inkonsistenz über Bildbereiche

Wenn einige Bereiche Ihres hochskalierten Bildes schöne Details zeigen, während andere Bereiche weich oder schlammig bleiben, deutet dies auf Konditionierungs- oder Aufmerksamkeitsprobleme hin.

Ungleichmäßige Bildkonditionierung: Wenn Ihr Basisbild über Bereiche hinweg unterschiedliche Qualität hat, können die Low Noise Experten Schwierigkeiten haben, konsistente Details hinzuzufügen. Versuchen Sie, von einer höheren Qualitätsbasis hochzuskalieren oder verwenden Sie Face Detailer Knoten zur Vorverbesserung kritischer Bereiche vor vollem Upscaling.

Aufmerksamkeitsverteilungsprobleme: Komplexe Kompositionen mit mehreren Subjekten verursachen manchmal, dass Aufmerksamkeitsmechanismen die Detailgenerierung auf bestimmte Bereiche fokussieren, während andere vernachlässigt werden. Verwenden Sie Aufmerksamkeitsgewichtung in Prompts, um zu spezifizieren, welche Elemente Detailbetonung verdienen.

Farbverschiebung oder Sättigungsänderungen

Hochskalierte Bilder zeigen manchmal unterschiedliche Farben oder Sättigung im Vergleich zum Basisbild, was VAE- oder Konditionierungsprobleme anzeigt.

VAE-Mismatch: Stellen Sie sicher, dass Sie den Wan 2.1 VAE verwenden, der speziell für diese Modelle entwickelt wurde. Andere VAE-Implementierungen können Farben anders kodieren, was während des Upscaling-Prozesses zu Verschiebungen führt.

Konditionierungsstärke zu niedrig: Wenn die Konditionierungsstärke unter 0.5 fällt, wird der Upscaling-Prozess eher wie neue Generierung als Upscaling, was Farben abdriften lässt. Erhöhen Sie die Konditionierungsstärke auf 0.7-0.8, um Farbtreue zu bewahren.

Fortgeschrittene Techniken für professionelle Ergebnisse

Sobald Sie grundlegende Upscaling-Workflows beherrschen, bringen diese fortgeschrittenen Techniken die Qualität auf professionelles Niveau.

Multi-Pass-Detail-Verfeinerung

Anstelle von Single-Pass-Upscaling verwenden Sie mehrere Verfeinerungsdurchgänge mit unterschiedlichen Prompt-Fokussen für jeden Durchgang.

Der erste Durchgang konzentriert sich auf Struktur und Hauptdetails mit Prompts, die Komposition und primäre Merkmale betonen. Der zweite Durchgang zielt auf spezifische Materialtexturen mit hochdetaillierten Materialbeschreibungen. Der dritte Durchgang kann sich auf Beleuchtung und subtile Oberflächeninteraktionen konzentrieren.

Dieser Multi-Pass-Ansatz gibt Ihnen granulare Kontrolle über verschiedene Aspekte der Detailgenerierung, anstatt einen Durchgang zu bitten, alles gleichzeitig zu handhaben.

Kombination von Loras für Stil- und Detailsteuerung

Laden Sie Stil-LoRAs neben den Low Noise Experten-Modellen, um spezifische ästhetische Eigenschaften während des Upscalings beizubehalten. Fotografie-Stil-LoRAs, künstlerische Stil-LoRAs oder technische Qualitäts-LoRAs beeinflussen alle, wie die Low Noise Experten Details generieren.

Ein Fotorealismus-LoRA leitet Detailgenerierung zu fotografischen Eigenschaften. Ein Illustrations-LoRA erhält illustrativen Stil bei Auflösungserhöhung. Dieser Kombinationsansatz erhält Stilkonsistenz bei Hinzufügen auflösungsgerechter Details.

Selektives regionales Upscaling mit Masken

Für Bilder, bei denen nur bestimmte Bereiche extreme Details erfordern, verwenden Sie Maskierung, um Low Noise Verfeinerung selektiv anzuwenden.

Generieren Sie Masken, die Gesichter, Schlüsselobjekte oder kritische Details isolieren. Wenden Sie hochintensives Low Noise Upscaling auf maskierte Bereiche an, während Sie schnelleres, einfacheres Upscaling auf Hintergründe und weniger wichtige Bereiche verwenden. Dieser selektive Ansatz spart Generierungszeit und stellt gleichzeitig sicher, dass kritische Bereiche maximale Detailaufmerksamkeit erhalten.

Die Zukunft des KI-Bild-Upscalings

Wan 2.2's MoE-Architektur mit getrennten High Noise und Low Noise Experten repräsentiert eine wichtige Evolution darin, wie KI die Bildgenerierung auf verschiedenen Qualitätsstufen handhabt.

Laut Analysen von Computer-Vision-Forschern, die Fortschritte in Diffusionsmodell-Architekturen dokumentieren, übertreffen spezialisierte Expertenmodelle für verschiedene Generierungsphasen konsistent einheitliche Modelle bei der Bewertung von Detailqualitätsmetriken. Dies deutet darauf hin, dass zukünftige Entwicklungen wahrscheinlich noch spezialisierte Expertensysteme betonen werden.

Die Kombination von Textverständnismodellen wie QWEN mit spezialisierten Generierungsmodellen schafft flexible Pipelines, in denen sich jede Komponente auf ihre Stärken konzentriert. QWEN handhabt Prompt-Verständnis und -Verbesserung. High Noise Experten etablieren Struktur. Low Noise Experten verfeinern Details. Dieser modulare Ansatz ermöglicht die unabhängige Optimierung jeder Komponente.

Für Kreative, die in ComfyUI arbeiten, bietet das Verständnis und die Implementierung dieser Spitzentechniken Zugang zu professioneller Qualitätsergebnissen, die noch vor Monaten teure kommerzielle Tools oder manuelle künstlerische Arbeit erfordert hätten.

Erste Schritte mit QWEN und Wan 2.2 Upscaling heute

Alle Komponenten für diesen Workflow sind jetzt unter offenen Lizenzen verfügbar, die kommerzielle Nutzung erlauben. Laden Sie Wan 2.2 Modelle aus dem offiziellen Hugging Face Repository herunter. Laden Sie QWEN-Modelle von der Qwen-Organisation auf Hugging Face herunter.

Beginnen Sie mit einfachen Upscaling-Workflows unter Verwendung von Basis-Auflösungsbildern und moderaten Zielauflösungen um 2K. Beherrschen Sie die Grundlagen der High Noise versus Low Noise Schrittzuteilung, CFG-Skalen-Tuning und Prompt-Engineering für Detailsteuerung. Erweitern Sie schrittweise zu höheren Auflösungen und komplexeren Multi-Pass-Verfeinerungs-Workflows.

Die Kombination von QWENs Prompt-Verständnis mit Wan 2.2's spezialisierten Low Noise Experten liefert Upscaling-Qualität, die kommerzielle Lösungen rivalisiert oder übertrifft, während sie Ihnen vollständige Workflow-Kontrolle gibt. Für jeden, der KI-Bilder generiert, die professionelle Ausgabequalität benötigen, stellt das Beherrschen dieser Technik eine wesentliche, lohnenswerte Fähigkeit dar.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

Die 10 häufigsten ComfyUI-Anfängerfehler und wie man sie 2025 behebt

Vermeide die 10 häufigsten ComfyUI-Fehler, die neue Nutzer frustrieren. Vollständiger Troubleshooting-Leitfaden mit Lösungen für VRAM-Fehler, Probleme beim Laden von Modellen...

25 ComfyUI-Tipps und -Tricks, die Profis 2025 nicht verraten wollen

Entdecken Sie 25 fortgeschrittene ComfyUI-Tipps, Workflow-Optimierungstechniken und professionelle Tricks, die Experten nutzen. Vollständiger Leitfaden zur CFG-Optimierung, Batch-Verarbeitung und Qualitätsverbesserung.

360 Anime-Drehung mit Anisora v3.2: Kompletter Charakter-Rotationsguide ComfyUI 2025

Meistern Sie 360-Grad-Anime-Charakter-Rotation mit Anisora v3.2 in ComfyUI. Lernen Sie Kamera-Orbit-Workflows, Multi-View-Konsistenz und professionelle Turnaround-Animationstechniken.