Video ControlNet Erklärt: Pose-, Tiefen- und Kantenkontrolle

Meistern Sie Video ControlNet in ComfyUI mit CogVideoX-Integration. Fortgeschrittene Posekontrolle, Tiefenschätzung und Kantenerkennung für professionelle Videogenerierung im Jahr 2025.

Sie haben statisches Bild-ControlNet gemeistert, aber Video fühlt sich unmöglich an. Jeder Versuch einer pose-geführten Videogenerierung führt zu zittrigen Bewegungen, inkonsistenten Tiefenbeziehungen oder Charakteren, die sich zwischen Frames verformen. Traditionelle Videobearbeitungstools können die benötigte Präzision nicht liefern, und manuelle Frame-für-Frame-Kontrolle würde Monate dauern.

Video ControlNet in ComfyUI verändert alles. Mit der fortgeschrittenen Integration von CogVideoX, DWPose-Schätzung und ausgeklügelter Tiefen-/Kantenkontrolle im Jahr 2025 können Sie professionelle Videos mit pixelgenauer Posekonsistenz, realistischen räumlichen Beziehungen und flüssigem zeitlichem Ablauf generieren.

Dieser umfassende Leitfaden enthüllt die professionellen Techniken, die Amateur-Videogenerierung von rundfunkqualitativ hochwertigen Ergebnissen unterscheiden. Meistern Sie zuerst statisches Bild-ControlNet mit unserem ControlNet-Kombinationen-Leitfaden, und wenden Sie dann diese Prinzipien auf Video an. Für Videomodell-Vergleiche sehen Sie sich unseren Top 6 Text-zu-Video-Modelle-Leitfaden an.

- CogVideoX-Integration für professionelle Videogenerierungs-Workflows

- DWPose vs OpenPose Auswahl für optimale menschliche Posekontrolle

- Fortgeschrittene Tiefenschätzungstechniken für räumliche Konsistenz

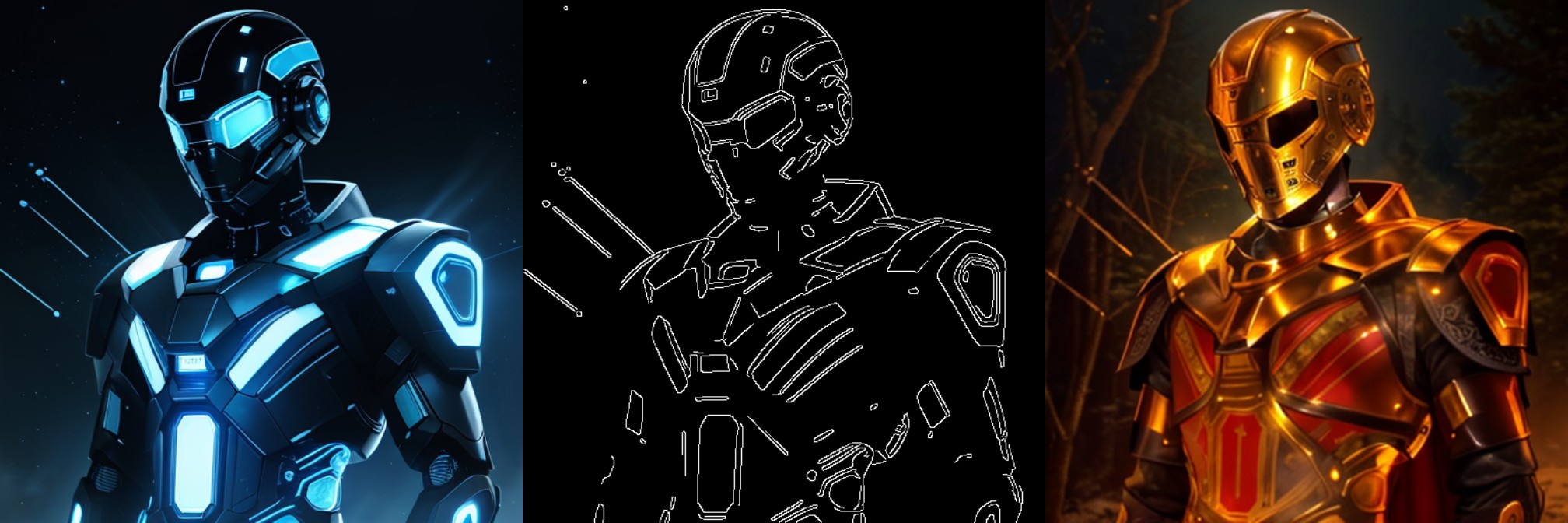

- Canny-Kantenerkennung für strukturelle Videoführung

- Multi-ControlNet-Workflows für komplexe Szenenkontrolle

Bevor Sie sich in komplexe Video-Workflows und Multi-ControlNet-Konfigurationen vertiefen, sollten Sie bedenken, dass Plattformen wie Apatero.com professionelle Videogenerierung mit automatischer Pose-, Tiefen- und Kantenkontrolle bereitstellen. Manchmal ist die beste Lösung eine, die makellose Ergebnisse liefert, ohne dass Sie ein Experte für zeitliche Konsistenzalgorithmen werden müssen.

Die Video-ControlNet-Revolution

Die meisten Benutzer denken, Video ControlNet sei einfach "Bild-ControlNet, aber länger." Das ist, als würde man sagen, Kino sei nur "Fotografie in Sequenz." Video ControlNet erfordert das Verständnis von zeitlicher Konsistenz, Bewegungskohärenz und Frame-zu-Frame-Beziehungserhaltung, die in statischen Workflows nicht existiert.

Warum traditionelle Ansätze scheitern

Statische Bild-Denkweise:

- Video Frame-für-Frame generieren

- ControlNet auf jeden Frame unabhängig anwenden

- Auf zeitliche Konsistenz hoffen

- Zittrige, verformende Ergebnisse akzeptieren

Professioneller Video-Ansatz:

- Zeitliche Beziehungen über gesamte Sequenzen analysieren

- ControlNet-Führung mit Bewegungsbewusstsein anwenden

- Glatte Übergänge zwischen Kontrollzuständen sicherstellen

- Rundfunkqualitativ hochwertige zeitliche Konsistenz liefern

Das Video-ControlNet-Ökosystem 2025

Moderne ComfyUI-Video-Workflows integrieren mehrere fortgeschrittene Systeme. CogVideoX treibt die Szenengenerierung mit zeitlichem Bewusstsein an, das von Grund auf eingebaut ist. ControlNet-Integration bietet Pose-, Kanten- und Tiefenführung ohne Frame-Konsistenz zu brechen. Live Portrait-Technologie verfeinert Gesichtsdetails und schauspielerische Leistung für charaktergetriebenen Inhalt.

Dies ist keine inkrementelle Verbesserung gegenüber 2024-Methoden. Es ist eine grundlegende architektonische Änderung, die professionelle Videogenerierung zugänglich macht.

Wesentliche Modell-Downloads und Installation

Bevor Sie sich in Workflows vertiefen, benötigen Sie die richtigen Modelle. Hier sind die offiziellen Download-Links und Installationsanweisungen.

CogVideoX-Modelle

Offizielle Hugging Face Repositories:

- CogVideoX-5B: THUDM/CogVideoX-5b - Haupt-Text-zu-Video-Modell

- CogVideoX-5B I2V: THUDM/CogVideoX-5b-I2V - Bild-zu-Video-Variante

- Einzeldatei-Modelle: Kijai/CogVideoX-comfy - Optimiert für ComfyUI

ControlNet-Erweiterungen:

- Canny ControlNet: TheDenk/cogvideox-2b-controlnet-canny-v1

- Pose-Kontroll-Modelle: Verfügbar über die Haupt-CogVideoX-Repositories mit Pose-Pipeline-Unterstützung

OpenPose ControlNet-Modelle

Primäre Modelle (Hugging Face):

- SD 1.5 OpenPose: lllyasviel/control_v11p_sd15_openpose

- SDXL OpenPose: thibaud/controlnet-openpose-sdxl-1.0

- Hochleistungs-SDXL: xinsir/controlnet-openpose-sdxl-1.0

Direkte Downloads:

- control_v11p_sd15_openpose.pth (1.45 GB) - Empfohlen für die meisten Workflows

- control_sd15_openpose.pth (5.71 GB) - Originalmodell mit voller Präzision

DWPose-Integration

DWPose-Modelle sind über die controlnet_aux Bibliothek integriert und funktionieren mit bestehenden ControlNet-Modellen für verbesserte Poseerkennung.

ComfyUI-Installationsanleitung

CogVideoX Wrapper installieren:

- Navigieren Sie zu ComfyUI/custom_nodes/

- Git clone https://github.com/kijai/ComfyUI-CogVideoXWrapper.git

- Abhängigkeiten installieren: pip install --pre onediff onediffx nexfort

ControlNet Auxiliary installieren:

- Git clone https://github.com/Fannovel16/comfyui_controlnet_aux.git

- Modelle werden bei erster Verwendung automatisch heruntergeladen

Erforderliches Hugging Face Token:

- Token von huggingface.co/settings/tokens erhalten

- Erforderlich für automatische Modell-Downloads

Modelle werden automatisch nach ComfyUI/models/CogVideo/ bzw. ComfyUI/models/controlnet/ heruntergeladen.

CogVideoX-Integration - Die Grundschicht

CogVideoX repräsentiert den Durchbruch, der Video ControlNet für professionelle Nutzung praktikabel macht. Anders als frühere Videogenerierungsmodelle, die mit Konsistenz kämpften, wurde CogVideoX speziell für langformatige, kontrollierbare Videosynthese entwickelt.

CogVideoX-Fähigkeiten verstehen

Zeitliche Architektur:

- Native 48-Frame-Generierung (6 Sekunden bei 8fps)

- Erweiterbar auf 64+ Frames mit ausreichender Hardware

- Eingebaute Bewegungskohärenz und Objektpersistenz

- Professionelle Frame-Interpolations-Kompatibilität

Kontroll-Integration:

- ControlNet-Führung ohne zeitliche Unterbrechungen

- Mehrere Kontrolltypen gleichzeitig

- Echtzeit-Stärkeanpassung während der Generierung

- Frame-genaue Kontrollpunkt-Spezifikation

Professionelle CogVideoX-Konfiguration

Optimale Auflösungseinstellungen:

- Breite: 768px, Höhe: 432px für Standard-Workflows

- 1024x576 für hochwertige Produktion (erfordert 16GB+ VRAM)

- 16:9-Seitenverhältnis für professionelle Kompatibilität beibehalten

- Vielfaches von 64 Pixeln für optimale Modell-Leistung verwenden

Frame-Management:

- Standard: 48 Frames für zuverlässige Generierung

- Erweitert: 64 Frames für längere Sequenzen

- Batch-Verarbeitung: Mehrere 48-Frame-Segmente mit Blending

- Loop-Erstellung: Erster/letzter Frame-Konsistenz sicherstellen

DWPose vs OpenPose - Ihre Posekontrolle wählen

Die Wahl zwischen DWPose und OpenPose beeinflusst grundlegend Ihre Videoqualität und Verarbeitungsgeschwindigkeit. Das Verständnis der Unterschiede ermöglicht optimale Workflow-Entscheidungen.

DWPose-Vorteile für Video

Überlegene zeitliche Konsistenz:

- Von Grund auf für Videoanwendungen entwickelt

- Reduziertes Pose-Zittern zwischen Frames

- Besserer Umgang mit teilweisen Verdeckungen

- Glattere Übergänge bei schnellen Bewegungen

Leistungsvorteile:

- Schnellere Verarbeitung als OpenPose

- Niedrigere VRAM-Anforderungen

- Bessere Optimierung für Batch-Verarbeitung

- Verbesserte Genauigkeit für herausfordernde Posen

Professionelle Anwendungen:

- Charakteranimations-Workflows

- Tanz- und Performance-Erfassung

- Sport- und Action-Sequenz-Generierung

- Kommerzielle Videoproduktion

OpenPose-Präzision für komplexe Szenen

Detaillierte Erkennungsfähigkeiten:

- Körperskelett: 18 Keypoints mit hoher Präzision

- Gesichtsausdrücke: 70 Gesichts-Keypoints

- Handdetails: 21 Hand-Keypoints pro Hand

- Fußhaltung: 6 Fuß-Keypoints

Multi-Personen-Handhabung:

- Gleichzeitige Erkennung mehrerer Subjekte

- Individuelle Pose-Verfolgung über Frames

- Komplexe Interaktionsszenen-Analyse

- Menschenmassen-Szenen-Pose-Management

Anwendungsfälle:

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

- Multi-Charakter-Narrative-Videos

- Komplexe Interaktionsszenarien

- Detaillierte Handgesten-Anforderungen

- Gesichtsausdrucksgetriebener Inhalt

Auswahlrichtlinien für professionelle Arbeit

Wählen Sie DWPose, wenn:

- Primärer Fokus auf Körperpose und Bewegung liegt

- Verarbeitungsgeschwindigkeit kritisch ist

- Mit Einzelcharakter-Inhalt gearbeitet wird

- Zeitliche Konsistenz von größter Bedeutung ist

Wählen Sie OpenPose, wenn:

- Detaillierte Hand- und Gesichtskontrolle benötigt wird

- Multi-Charakter-Szenen erforderlich sind

- Komplexe Interaktionsszenarien vorliegen

- Maximale Pose-Erkennungspräzision wesentlich ist

Fortgeschrittene Tiefenkontrolle für räumliche Konsistenz

Depth ControlNet transformiert die Videogenerierung von flachen, inkonsistenten Ergebnissen zu professionell beleuchteten, räumlich kohärenten Sequenzen, die traditionelle Kinematografie rivalisieren.

Video-Tiefen-Herausforderungen verstehen

Statische Bild-Tiefe:

- Einzelframe-Tiefenschätzung

- Keine zeitlichen Tiefenbeziehungen

- Inkonsistente Beleuchtung und Schatten

- Räumliche Sprünge zwischen Frames

Video-Tiefen-Anforderungen:

- Glatte Tiefenübergänge über die Zeit

- Konsistente räumliche Beziehungen

- Natürliche Beleuchtungsprogression

- Objektverdeckungshandhabung

Professionelle Tiefenschätzungs-Workflows

MiDaS-Integration für Video:

- Zeitliche Glättungsalgorithmen

- Konsistente Tiefenskala über Frames

- Kantenerhaltende Tiefenschätzung

- Echtzeit-Tiefenkarten-Generierung

Tiefenkarten-Vorverarbeitung:

- Gaußscher Weichzeichner für zeitliche Glättung

- Kantenverbesserung für strukturelle Erhaltung

- Tiefengradienten-Analyse für Konsistenzprüfung

- Multi-Frame-Tiefen-Mittelung für Stabilität

Fortgeschrittene Tiefen-Anwendungen

Kinematografische Tiefenkontrolle:

- Rack-Focus-Effekte mit tiefengesteuerten Übergängen

- Tiefenschärfe-Simulation für professionellen Look

- Z-Tiefen-basierte Partikeleffekte und Atmosphäre

- Volumetrische Beleuchtung geführt durch Tiefeninformationen

Räumliche Konsistenztechniken:

- Objektpermanenz über Tiefenänderungen hinweg

- Natürliche Verdeckungs- und Enthüllungssequenzen

- Perspektivkorrekte Kamerabewegungssimulation

- Tiefenbewusste Bewegungsunschärfe-Generierung

Canny-Kantenerkennung für strukturelle Führung

Canny-Kantenerkennung in Video-Workflows bietet das strukturelle Rückgrat, das generierten Inhalt kohärent hält, während kreative Freiheit innerhalb definierter Grenzen ermöglicht wird.

Video-Kantenerkennungs-Herausforderungen

Frame-zu-Frame-Kantenkonsistenz:

- Kantenflackern verhindern

- Strukturelle Beziehungen aufrechterhalten

- Bewegungsunschärfe und schnelle Bewegung handhaben

- Details während der Skalierung bewahren

Zeitliche Kantenglättung:

- Multi-Frame-Kanten-Mittelung

- Bewegungskompensierte Kantenverfolgung

- Adaptive Schwellenwerterstellung

- Kantenpersistenz über Verdeckungen hinweg

Professionelle Canny-Workflows für Video

Kanten-Vorverarbeitungs-Pipeline:

- Zeitliche Glättung: Sanfte Unschärfe über 3-5 Frames anwenden

- Kantenverbesserung: Strukturelle Grenzen schärfen

- Rauschunterdrückung: Zeitliches Kantenrauschen entfernen

- Konsistenzprüfung: Kantenkontinuität validieren

Adaptive Schwellenwert-Verwaltung:

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

- Niedrigere Schwellenwerte (50-100) für sanfte Führung

- Mittlere Schwellenwerte (100-150) für strukturelle Kontrolle

- Höhere Schwellenwerte (150-200) für strikte Kanteneinhaltung

- Dynamische Anpassung basierend auf Szenenkomplexität

Kreative Anwendungen

Architekturvisualisierung:

- Gebäudekontur-Erhaltung während Stil-Transfer

- Strukturelle Konsistenz in animierten Durchgängen

- Detail-Erhaltung während Beleuchtungsänderungen

- Geometrische Genauigkeit in technischen Animationen

Charakteranimation:

- Kostüm- und Kleidungsgrenzerhaltung

- Haar- und Stoffkantenerhaltung

- Gesichtsmerkmalskonsistenz

- Accessoire-Detail-Beibehaltung

Multi-ControlNet-Video-Workflows

Professionelle Videogenerierung erfordert die Kombination mehrerer ControlNet-Typen für umfassende Szenenkontrolle. Diese Integration erfordert sorgfältiges Gleichgewicht und Optimierung.

Der Triple-Control Professional Stack

Schicht 1 - Pose-Grundlage:

- DWPose oder OpenPose für Charakterbewegung

- Stärke: 0.8-1.0 für primäre Charakterkontrolle

- Anwendung: Vollständige Sequenz für Charakterkonsistenz

Schicht 2 - Tiefen-Raumkontrolle:

- MiDaS-Tiefe für räumliche Beziehungen

- Stärke: 0.6-0.8 für Umgebungskonsistenz

- Anwendung: Szeneneinrichtung und Kamerabewegung

Schicht 3 - Kanten-Strukturführung:

- Canny-Kanten für strukturelle Erhaltung

- Stärke: 0.4-0.6 für sanfte Grenzführung

- Anwendung: Detail-Erhaltung und Stilkontrolle

Workflow-Balance und Optimierung

ControlNet-Stärke-Management:

- Mit ausgewogenen Stärken beginnen (0.7 über alle Kontrollen)

- Primärkontrolle (Pose) auf 0.9-1.0 anpassen

- Sekundäre Kontrollen basierend auf Szenenanforderungen reduzieren

- Mit kurzen Sequenzen testen vor vollständiger Generierung

Zeitliche Synchronisierung:

- Alle ControlNet-Eingaben auf identisches Frame-Timing ausrichten

- Vorverarbeitungskonsistenz über Kontrolltypen hinweg sicherstellen

- Kontrollstärke-Progression über Sequenz validieren

- Auf widersprüchliche Kontrollführung überwachen

Hardware-Optimierung für Video ControlNet

Video-ControlNet-Workflows erfordern deutlich mehr Rechenressourcen als statische Bildgenerierung und benötigen strategische Optimierung.

VRAM-Anforderungen nach Workflow-Komplexität

Basis-Single-ControlNet-Video:

- 12GB: 48 Frames bei 768x432 Auflösung

- 16GB: 64 Frames oder höhere Auflösung

- 20GB: Multi-ControlNet mit Standardeinstellungen

- 24GB+: Professionelle Multi-ControlNet-Workflows

Fortgeschrittene Multi-ControlNet-Produktion:

- 16GB Minimum für jeden Multi-Control-Workflow

- 24GB empfohlen für professionelle Produktion

- 32GB optimal für komplexe Szenen mit mehreren Charakteren

- 48GB+ für Echtzeit-Vorschau und Iteration

Verarbeitungsgeschwindigkeits-Optimierung

| Hardware-Konfiguration | 48-Frame-Generierung | 64-Frame-Erweitert | Multi-ControlNet |

|---|---|---|---|

| RTX 4070 12GB | 8-12 Minuten | 12-18 Minuten | 15-25 Minuten |

| RTX 4080 16GB | 5-8 Minuten | 8-12 Minuten | 10-16 Minuten |

| RTX 4090 24GB | 3-5 Minuten | 5-8 Minuten | 6-12 Minuten |

| RTX 5090 32GB | 2-3 Minuten | 3-5 Minuten | 4-8 Minuten |

Speicherverwaltungsstrategien

Modell-Lade-Optimierung:

- Häufig verwendete ControlNet-Modelle im VRAM behalten

- Modell-Offloading für weniger kritische Kontrollen verwenden

- Intelligentes Caching für sich wiederholende Workflows implementieren

- VRAM-Nutzung während langer Sequenzen überwachen

Batch-Verarbeitungs-Konfiguration:

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

- In 48-Frame-Segmenten für Speichereffizienz verarbeiten

- Frame-Überlappung für nahtloses Blending verwenden

- Checkpoint-Speicherung für lange Sequenzen implementieren

- Mehrere Workflow-Variationen in Warteschlange stellen

Fortgeschrittene Video-Vorverarbeitungstechniken

Professionelles Video ControlNet erfordert ausgeklügelte Vorverarbeitung, die weit über grundlegende Frame-Extraktion hinausgeht.

Zeitliche Konsistenz-Vorverarbeitung

Bewegungsanalyse:

- Optischer Fluss-Berechnung zwischen Frames

- Bewegungsvektor-Glättung für Konsistenz

- Szenenwechsel-Erkennung und -Handhabung

- Kamerabewegungskompensation

Frame-Interpolations-Integration:

- RIFE oder ähnliches für glatte Bewegung

- Frame-Timing-Optimierung

- Bewegungsbewusste Interpolationseinstellungen

- Qualitätsvalidierung über interpolierte Sequenzen

Kontrolldaten-Glättung

Pose-Glättungsalgorithmen:

- Kalman-Filterung für Pose-Vorhersage

- Zeitliche Median-Filterung für Rauschreduzierung

- Bewegungsbeschränkte Pose-Korrektur

- Anatomisch bewusste Pose-Validierung

Tiefenkarten-Stabilisierung:

- Multi-Frame-Tiefen-Mittelung

- Kantenerhaltende Glättungsfilter

- Tiefengradienten-Konsistenzprüfung

- Zeitliche Tiefenkarten-Ausrichtung

Professionelle Qualitätsbewertung

Die Unterscheidung zwischen akzeptablen und rundfunkqualitativ hochwertigen Video-ControlNet-Ergebnissen erfordert systematische Bewertung über mehrere Qualitätsdimensionen hinweg.

Zeitliche Konsistenz-Metriken

Frame-zu-Frame-Analyse:

- Pose-Abweichungsmessung über Sequenzen

- Tiefenkarten-Konsistenz-Bewertung

- Kantenerhaltungs-Validierung

- Objektidentitäts-Aufrechterhaltung

Bewegungsqualitäts-Bewertung:

- Natürliche Bewegungsfluss-Evaluierung

- Abwesenheit von zeitlichen Artefakten

- Glatte Übergangs-Validierung

- Charakterkontinuitäts-Verifizierung

Professionelle Lieferstandards

Technische Qualitätsanforderungen:

- 30fps Minimum für professionelle Anwendungen

- Konsistentes Frame-Timing ohne Ausfälle

- Audio-Synchronisierung wo anwendbar

- Farbkonsistenz über Sequenzen hinweg

Kreative Qualitäts-Benchmarks:

- Natürliche Pose-Übergänge ohne Zittern

- Glaubwürdige räumliche Beziehungen

- Konsistente Beleuchtung und Atmosphäre

- Professioneller kinematografischer Fluss

Fehlerbehebung bei häufigen Video-ControlNet-Problemen

Professionelle Workflows erfordern das Verständnis häufiger Fehlermodi und ihrer systematischen Lösungen.

Problem 1 - Pose-Zittern und Inkonsistenz

Ursache: Unzureichende zeitliche Glättung in der Poseerkennung Lösung: Multi-Frame-Pose-Mittelung und Kalman-Filterung implementieren Prävention: DWPose für bessere zeitliche Konsistenz verwenden, Pose-Daten vor Verarbeitung validieren

Problem 2 - Tiefenkarten-Flackern

Ursache: Frame-für-Frame-Tiefenschätzung ohne zeitliches Bewusstsein Lösung: Zeitliche Median-Filterung und Tiefenkarten-Stabilisierung anwenden Prävention: Konsistente Tiefenschätzungseinstellungen und Multi-Frame-Mittelung verwenden

Problem 3 - Kantengrenz-Sprünge

Ursache: Canny-Schwellenwert-Inkonsistenz über Frames hinweg Lösung: Adaptive Schwellenwerterstellung und Kantenverfolgung implementieren Prävention: Bewegungskompensierte Kantenerkennung und zeitliche Glättung verwenden

Problem 4 - Multi-ControlNet-Konflikte

Ursache: Konkurrierende Kontrollsignale verursachen instabile Generierung Lösung: Widersprüchliche Kontrollstärken reduzieren und hierarchische Kontrollpriorität implementieren Prävention: Kontrollkombinationen an kurzen Sequenzen testen vor vollständiger Produktion

Die Produktions-Video-Pipeline

Professionelle Video-ControlNet-Anwendungen erfordern systematische Workflows, die konsistente, hochwertige Ergebnisse über lange Sequenzen hinweg sicherstellen.

Pre-Produktions-Planung

Inhaltsanalyse:

- Szenenkomplexitätsbewertung

- Charakterbewegungsplanung

- Kamerabewegungsdesign

- Kontrolltypauswahl-Strategie

Technische Vorbereitung:

- Hardware-Anforderungs-Validierung

- Modell-Download und -Tests

- Workflow-Template-Erstellung

- Qualitätskontroll-Checkpoint-Planung

Produktions-Workflow

Phase 1 - Kontrolldaten-Generierung:

- Quellvideo-Analyse und Vorverarbeitung

- Multi-Control-Daten-Extraktion (Pose, Tiefe, Kanten)

- Zeitliche Glättung und Konsistenzvalidierung

- Kontrolldaten-Qualitätsbewertung

Phase 2 - Videogenerierung:

- Workflow-Konfiguration und -Tests

- Segmentbasierte Verarbeitung mit Überlappung

- Echtzeit-Qualitätsüberwachung

- Zwischenergebnis-Validierung

Phase 3 - Nachbearbeitung:

- Segment-Blending und nahtloses Zusammenfügen

- Farbkorrektur und Konsistenz-Anpassung

- Audio-Integration wo anwendbar

- Finale Qualitätskontrolle und Liefervorbereitung

Qualitätskontroll-Integration

Automatisierte Qualitätsprüfungen:

- Frame-Konsistenz-Bewertung

- Zeitliche Artefakterkennung

- Kontrolleinhaltungs-Validierung

- Technische Spezifikations-Compliance

Manueller Review-Prozess:

- Schlüssel-Frame-Qualitätsbewertung

- Bewegungsfluss-Evaluierung

- Kreativziel-Erreichungs-Verifizierung

- Kunden-Lieferprodukt-Vorbereitung

Die Investitionsentscheidung treffen

Video-ControlNet-Workflows bieten beispiellose kreative Kontrolle, erfordern aber erhebliche Lerninvestition und Rechenressourcen.

Investieren Sie in fortgeschrittenes Video ControlNet, wenn Sie:

- Professionelle Videoinhalte erstellen, die präzise Charakterkontrolle erfordern

- Konsistente Pose-, Tiefen- und Strukturführung über lange Sequenzen benötigen

- Ausreichende Hardware-Ressourcen haben (16GB+ VRAM empfohlen)

- Mit Kunden arbeiten, die rundfunkqualitativ hochwertige zeitliche Konsistenz fordern

- Freude daran haben, komplexe technische Workflows für kreative Anwendungen zu optimieren

Erwägen Sie Alternativen, wenn Sie:

- Gelegentlich grundlegende Videogenerierung ohne präzise Kontrollanforderungen benötigen

- Einfache, automatisierte Lösungen gegenüber technischer Workflow-Optimierung bevorzugen

- Begrenzte Hardware-Ressourcen oder Verarbeitungszeit-Einschränkungen haben

- Sich auf kreative Inhalte statt technische Implementierung konzentrieren möchten

- Sofortige Ergebnisse ohne Erlernen komplexer Multi-ControlNet-Workflows benötigen

Die professionelle Alternative

Nachdem Sie CogVideoX-Integration, Multi-ControlNet-Workflows und fortgeschrittene zeitliche Konsistenztechniken erkundet haben, fragen Sie sich vielleicht, ob es einen einfacheren Weg gibt, professionelle Videogenerierung mit präziser Pose-, Tiefen- und Kantenkontrolle zu erreichen.

Apatero.com bietet genau diese Lösung. Anstatt Wochen damit zu verbringen, Video-ControlNet-Workflows zu meistern, zeitliche Konsistenz zu beheben oder Multi-Control-Konfigurationen zu optimieren, können Sie einfach Ihre Vision beschreiben und sofort rundfunkqualitativ hochwertige Ergebnisse erhalten.

Professionelle Videogenerierung ohne die Komplexität:

- Fortgeschrittene Posekontrolle mit automatischer zeitlicher Konsistenz

- Intelligente Tiefenschätzung für realistische räumliche Beziehungen

- Ausgeklügelte Kantenerkennung für strukturelle Führung

- Multi-Charakter-Unterstützung ohne Workflow-Komplikationen

- Professionelle zeitliche Glättung in jede Generierung eingebaut

Unsere Plattform übernimmt die gesamte technische Komplexität hinter den Kulissen - von CogVideoX-Integration und DWPose-Optimierung bis hin zu Multi-ControlNet-Balancierung und zeitlicher Artefakt-Prävention. Keine Knoten zum Verbinden, keine Modelle zum Herunterladen, keine Hardware-Einschränkungen zum Navigieren.

Was Apatero.com automatisch liefert:

- Rundfunkqualitativ hochwertige zeitliche Konsistenz

- Professioneller kinematografischer Fluss

- Natürliche Charakterbewegung und Interaktion

- Ausgeklügelte Beleuchtungs- und Tiefenbeziehungen

- Nahtlose Integration mehrerer Kontrolltypen

Manchmal ist das mächtigste Werkzeug nicht das komplexeste. Es ist dasjenige, das außergewöhnliche Ergebnisse liefert, während Sie sich auf Storytelling statt technische Optimierung konzentrieren können. Probieren Sie Apatero.com aus und erleben Sie professionelle KI-Videogenerierung, die einfach funktioniert.

Ob Sie sich entscheiden, ComfyUIs fortgeschrittene Video-ControlNet-Fähigkeiten zu meistern oder die Einfachheit automatisierter professioneller Lösungen bevorzugen, der wichtigste Faktor ist, einen Ansatz zu finden, der Ihren kreativen Prozess eher verbessert als verkompliziert. Die Wahl hängt letztendlich von Ihren spezifischen Bedürfnissen, verfügbarer Lernzeit und gewünschtem Grad der technischen Kontrolle über den Videogenerierungsprozess ab.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

KI-Musikvideos: Wie Künstler die Produktion revolutionieren und Tausende sparen

Entdecken Sie, wie Musiker wie Kanye West, A$AP Rocky und unabhängige Künstler KI-Videogenerierung nutzen, um beeindruckende Musikvideos bei 90% niedrigeren Kosten zu erstellen.

KI-Video für E-Learning: Lehrinhalte in großem Maßstab generieren

Transformieren Sie die Erstellung von Bildungsinhalten mit KI-Videogenerierung. Synthesia, HeyGen und fortschrittliche Plattformen für skalierbare, personalisierte E-Learning-Videos im Jahr 2025.