ComfyUI Grundlegende Essentielle Nodes, die Jeder Anfänger Kennen Muss

Beherrschen Sie die grundlegenden ComfyUI-Nodes im Jahr 2025. Vollständiger Anfängerleitfaden zu Load Checkpoint, CLIP Text Encode, KSampler, VAE Decode und grundlegender Workflow-Erstellung.

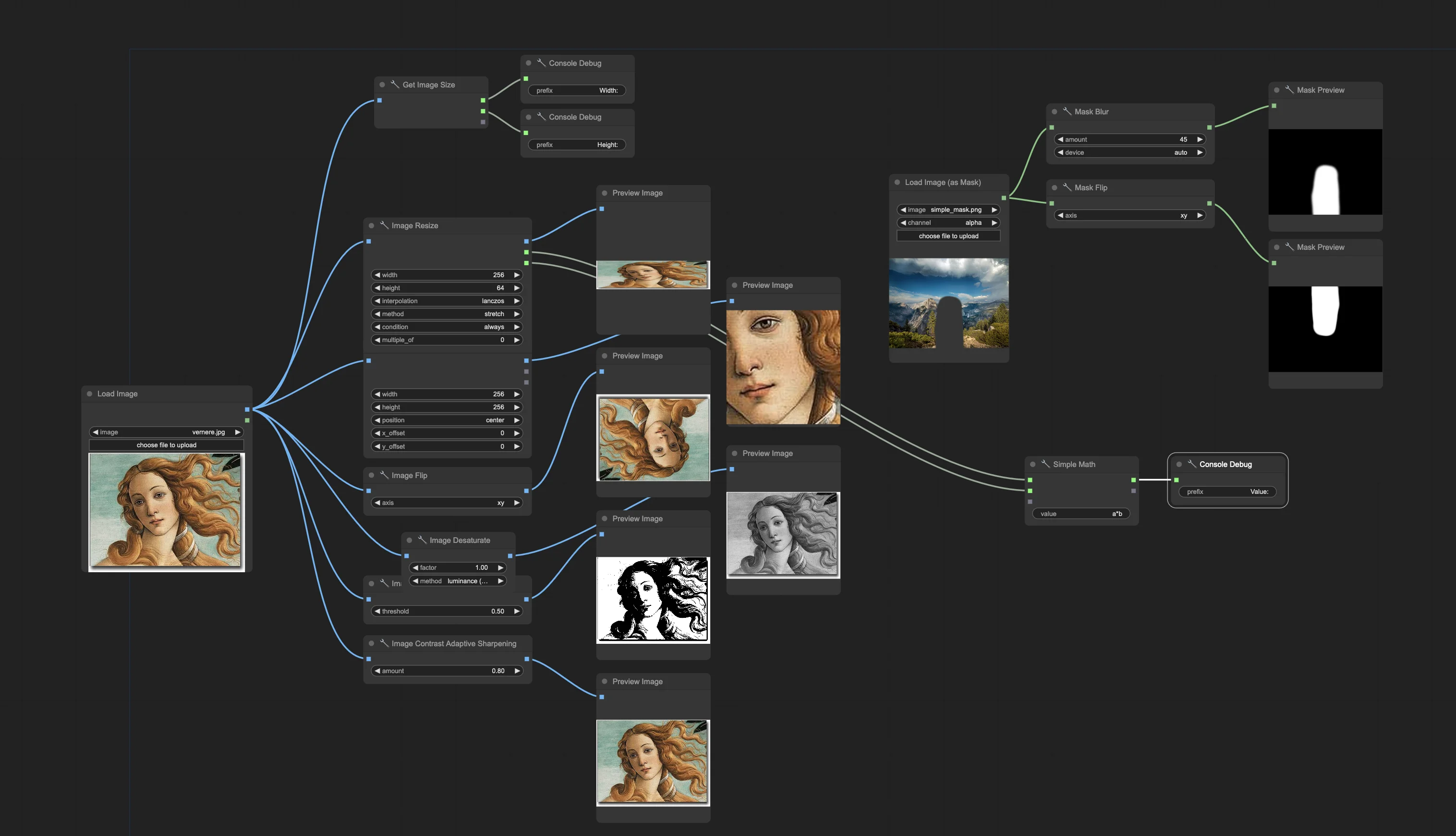

Sie haben von der unglaublichen Leistung von ComfyUI für KI-Bildgenerierung gehört, aber beim ersten Öffnen fühlt es sich an, als würden Sie auf eine Leiterplatte starren. Nodes überall, Verbindungen, die keinen Sinn ergeben, und Workflows, die eher wie technische Diagramme als kreative Werkzeuge aussehen.

Jeder Experte hat genau dort angefangen, wo Sie jetzt sind - verwirrt von der Oberfläche, aber begeistert von den Möglichkeiten. Der Unterschied zwischen Aufgeben und Beherrschen von ComfyUI liegt darin, fünf essentielle Nodes zu verstehen, die das Rückgrat jedes Workflows bilden.

Sobald Sie diese Grundlagen verstehen, verwandelt sich ComfyUI von einem einschüchternden Labyrinth in eine intuitive Leinwand, auf der Ihre kreativen Ideen zu beeindruckenden KI-generierten Bildern werden.

ComfyUI-Nodes Verstehen - Die Bausteine

Denken Sie an ComfyUI-Nodes wie LEGO-Steine für KI-Bildgenerierung. Jeder Node führt eine bestimmte Aufgabe aus, und Sie verbinden sie miteinander, um vollständige Workflows zu erstellen. Im Gegensatz zu anderen KI-Tools, die den Prozess hinter einfachen Schaltflächen verbergen, zeigt Ihnen ComfyUI genau, wie Bildgenerierung funktioniert.

Was Nodes leistungsstark macht: Jeder Node hat drei Teile - Eingänge (linke Seite), Ausgänge (rechte Seite) und Parameter (zentrale Steuerelemente). Sie verbinden Ausgänge eines Nodes mit Eingängen eines anderen und erstellen einen Datenfluss, der Ihren Textprompt in ein endgültiges Bild verwandelt.

Warum das wichtig ist: Das Verständnis von Nodes gibt Ihnen vollständige Kontrolle über den Generierungsprozess. Anstatt auf voreingestellte Optionen beschränkt zu sein, können Sie jeden Aspekt der Erstellung Ihrer Bilder anpassen.

Während Plattformen wie Apatero.com sofortige KI-Bildgenerierung ohne Setup-Komplexität bieten, gibt Ihnen das Erlernen des Node-Systems von ComfyUI beispiellose kreative Kontrolle und Anpassungsmöglichkeiten.

Die 5 Essentiellen Nodes, die Sie Kennen Müssen

1. Load Checkpoint - Ihr KI-Modell-Fundament

Was er tut: Der Load Checkpoint Node lädt Ihr KI-Modell (wie Stable Diffusion 1.5, SDXL oder FLUX) und stellt drei wesentliche Komponenten für die Bildgenerierung bereit.

Drei Ausgänge erklärt:

- MODEL: Der eigentliche Bildgenerator, der Bilder aus Rauschen erstellt

- CLIP: Der Textprozessor, der Ihre Prompts versteht

- VAE: Der Übersetzer zwischen für Menschen sichtbaren Bildern und von KI lesbaren Daten

Wie man ihn verwendet:

- Fügen Sie einen Load Checkpoint Node zu Ihrer Leinwand hinzu

- Klicken Sie auf das Dropdown-Menü des Modellnamens, um Ihr bevorzugtes Modell auszuwählen

- Verbinden Sie die drei Ausgänge mit anderen Nodes, die sie benötigen

Häufige Modelle für Anfänger:

- Stable Diffusion 1.5: Schnell, zuverlässig, hervorragend zum Lernen

- SDXL: Höhere Qualität, etwas langsamer

- FLUX: Neueste Technologie, ausgezeichnete Ergebnisse

2. CLIP Text Encode - Umwandlung von Worten in KI-Sprache

Was er tut: CLIP Text Encode Nodes wandeln Ihre Textprompts in mathematische Darstellungen um, die das KI-Modell verstehen und für die Bildgenerierung verwenden kann.

Zwei Typen, die Sie benötigen:

- Positiver Prompt: Beschreibt, was Sie im Bild wollen

- Negativer Prompt: Beschreibt, was Sie nicht wollen

Grundlegende Einrichtung:

- Fügen Sie zwei CLIP Text Encode Nodes zu Ihrem Workflow hinzu

- Verbinden Sie den CLIP-Ausgang von Load Checkpoint mit beiden Nodes

- Geben Sie Ihren positiven Prompt im ersten Node ein

- Geben Sie Ihren negativen Prompt im zweiten Node ein (wie "verschwommen, niedrige Qualität")

Tipps zum Schreiben von Prompts:

- Halten Sie Prompts einfach und beschreibend

- Verwenden Sie Kommas, um verschiedene Elemente zu trennen

- Beginnen Sie mit grundlegenden Beschreibungen, bevor Sie Stilelemente hinzufügen

3. Empty Latent Image - Einstellen Ihrer Leinwandgröße

Was er tut: Erstellt eine leere "Leinwand" im mathematischen Raum der KI (genannt Latent Space), wo Ihr Bild generiert wird. Denken Sie daran als Festlegung Ihrer Bildabmessungen.

Schlüsseleinstellungen:

- Breite & Höhe: Ihre endgültige Bildgröße in Pixeln

- Batch-Größe: Wie viele Bilder gleichzeitig generiert werden sollen

Empfohlene Größen für Anfänger:

- 512x512: Schnelle Generierung, gut zum Testen

- 768x768: Bessere Qualität, etwas langsamer

- 1024x1024: Hohe Qualität, erfordert mehr VRAM

Verbindung: Der Latent-Ausgang verbindet sich mit dem KSampler Node als Ausgangspunkt für die Bildgenerierung.

4. KSampler - Das Herz der Bildgenerierung

Was er tut: KSampler ist der Ort, wo die Magie passiert. Er nimmt Ihren Textprompt, die leere Leinwand und das KI-Modell und verwandelt dann schrittweise zufälliges Rauschen durch einen Entrauschungsprozess in Ihr gewünschtes Bild.

Wesentliche Einstellungen:

| Einstellung | Empfohlener Wert | Was es Tut |

|---|---|---|

| Steps | 20-30 | Wie viele Verfeinerungsdurchläufe gemacht werden |

| CFG Scale | 7-12 | Wie genau Ihrem Prompt gefolgt werden soll |

| Sampler Name | euler_a oder dpmpp_2m | Der Generierungsalgorithmus |

| Scheduler | normal | Wie Schritte verteilt werden |

| Seed | -1 (zufällig) | Startpunkt für die Generierung |

Um mehr über Seeds und reproduzierbare Ergebnisse zu erfahren, lesen Sie unseren umfassenden Seed-Management-Leitfaden.

Kostenlose ComfyUI Workflows

Finden Sie kostenlose Open-Source ComfyUI-Workflows für Techniken in diesem Artikel. Open Source ist stark.

Erforderliche Verbindungen:

- MODEL-Eingang: Von Load Checkpoint

- Positive-Eingang: Von positivem CLIP Text Encode

- Negative-Eingang: Von negativem CLIP Text Encode

- Latent Image: Von Empty Latent Image

5. VAE Decode - Bilder Sichtbar Machen

Was er tut: Wandelt die mathematische Darstellung der KI (Latent Space) zurück in ein normales Bild um, das Sie sehen und speichern können. Ohne diesen Schritt hätten Sie nur Daten, die die KI versteht.

Einfache Einrichtung:

- Fügen Sie einen VAE Decode Node hinzu

- Verbinden Sie den VAE-Eingang mit dem VAE-Ausgang von Load Checkpoint

- Verbinden Sie den Samples-Eingang mit dem LATENT-Ausgang von KSampler

- Der IMAGE-Ausgang zeigt Ihr endgültig generiertes Bild

Erstellen Ihres Ersten Grundlegenden Workflows

Schritt-für-Schritt Workflow-Erstellung

Schritt 1: Fügen Sie Ihre Nodes Hinzu Rechtsklicken Sie auf die leere Leinwand und fügen Sie diese fünf Nodes hinzu:

- Load Checkpoint

- CLIP Text Encode (fügen Sie zwei davon hinzu)

- Empty Latent Image

- KSampler

- VAE Decode

Schritt 2: Konfigurieren Sie Ihr Modell Klicken Sie auf den Load Checkpoint Node und wählen Sie ein Stable Diffusion Modell aus dem Dropdown-Menü.

Schritt 3: Stellen Sie Ihre Leinwandgröße Ein Im Empty Latent Image Node stellen Sie Breite und Höhe auf 512 ein (gute Startgröße für Anfänger).

Schritt 4: Schreiben Sie Ihre Prompts

- Erster CLIP Text Encode: "ein wunderschöner Sonnenuntergang über Bergen, fotorealistisch"

- Zweiter CLIP Text Encode: "verschwommen, niedrige Qualität, verzerrt"

Schritt 5: Verbinden Sie Alles Machen Sie diese Verbindungen, indem Sie von Ausgabepunkten zu Eingangspunkten ziehen:

| Von Node | Ausgang | Zu Node | Eingang |

|---|---|---|---|

| Load Checkpoint | MODEL | KSampler | model |

| Load Checkpoint | CLIP | CLIP Text Encode #1 | clip |

| Load Checkpoint | CLIP | CLIP Text Encode #2 | clip |

| Load Checkpoint | VAE | VAE Decode | vae |

| CLIP Text Encode #1 | CONDITIONING | KSampler | positive |

| CLIP Text Encode #2 | CONDITIONING | KSampler | negative |

| Empty Latent Image | LATENT | KSampler | latent_image |

| KSampler | LATENT | VAE Decode | samples |

Schritt 6: Generieren Sie Ihr Bild Klicken Sie auf "Queue Prompt" und beobachten Sie, wie Ihr erstes ComfyUI-Bild generiert wird!

Wesentliche Node-Parameter Erklärt

KSampler Einstellungen Tiefenanalyse

Steps (20-30 empfohlen): Mehr Schritte = höhere Qualität, aber langsamere Generierung. Beginnen Sie mit 20 zum Testen, erhöhen Sie auf 30 für finale Bilder.

Möchten Sie die Komplexität überspringen? Apatero liefert Ihnen sofort professionelle KI-Ergebnisse ohne technische Einrichtung.

CFG Scale (7-12 empfohlen): Steuert Prompt-Einhaltung. Niedrigere Werte (7-8) = mehr kreative Freiheit. Höhere Werte (10-12) = strengeres Befolgen des Prompts.

Sampler-Methoden:

- euler_a: Schnell, gute Qualität, hervorragend für Anfänger

- dpmpp_2m: Etwas bessere Qualität, minimaler Geschwindigkeitsunterschied

- ddim: Ältere Methode, immer noch zuverlässig

Scheduler-Optionen:

- normal: Standardabstand, funktioniert für die meisten Fälle

- karras: Etwas unterschiedlicher Schrittabstand, manchmal bessere Ergebnisse Für eine Tiefenanalyse, wie Scheduler Ihre Bilder beeinflussen, schauen Sie sich unseren Karras Scheduler Erklärungs-Leitfaden an.

Häufige Parameter-Kombinationen

| Bildtyp | Steps | CFG | Sampler | Am Besten Für |

|---|---|---|---|---|

| Schnelltest | 15 | 7 | euler_a | Schnelle Iteration |

| Ausgewogene Qualität | 25 | 8 | dpmpp_2m | Allgemeiner Gebrauch |

| Hohe Qualität | 30 | 10 | dpmpp_2m | Endausgaben |

| Kreative Freiheit | 20 | 6 | euler_a | Künstlerische Erkundung |

Arbeiten mit Verschiedenen Bildgrößen

Auflösungsrichtlinien

Standardgrößen für Verschiedene Modelle:

| Modelltyp | Empfohlene Größen | VRAM-Nutzung | Generierungszeit |

|---|---|---|---|

| SD 1.5 | 512x512, 512x768 | Niedrig | Schnell |

| SDXL | 1024x1024, 768x1344 | Mittel | Moderat |

| FLUX | 1024x1024, 896x1152 | Hoch | Langsamer |

Seitenverhältnis-Tipps:

- Quadrat (1:1): 512x512, 1024x1024

- Hochformat (3:4): 512x768, 768x1024

- Querformat (4:3): 768x512, 1024x768

- Breitbild (16:9): 512x896, 1024x576

Node-Verbindungen Verstehen

Verbindungstypen und Farben

Visueller Verbindungsleitfaden:

| Verbindungsfarbe | Datentyp | Häufige Verwendung |

|---|---|---|

| Lila | MODEL | KI-Generierungs-Engine |

| Gelb | CLIP | Textverarbeitung |

| Rot | VAE | Bildcodierung/-decodierung |

| Orange | CONDITIONING | Verarbeitete Prompts |

| Weiß | LATENT | Arbeitsbereich der KI |

| Grün | IMAGE | Endgültige sichtbare Bilder |

Verbindungsregeln

Was Verbunden Werden Kann:

- Ausgänge und Eingänge gleicher Farbe können verbunden werden

- Ein Ausgang kann sich mit mehreren Eingängen verbinden

- Jeder Eingang akzeptiert nur eine Verbindung

Häufige Verbindungsfehler:

- Versuchen, verschiedenfarbige Verbindungen zu verbinden

- Vergessen, alle erforderlichen Eingänge zu verbinden

- Ausgänge mit Ausgängen verbinden (unmöglich)

Wenn Sie Probleme mit Fehlern haben, schauen Sie sich unseren Leitfaden zu 10 häufigen ComfyUI-Anfängerfehlern für vollständige Fehlerbehebungslösungen an.

Fehlerbehebung bei Häufigen Anfängerproblemen

"Fehlende Eingabe"-Fehler

Problem: Roter Text zeigt fehlende Verbindungen an Lösung: Überprüfen Sie, dass alle erforderlichen Eingänge (Punkte links) Verbindungen von geeigneten Ausgängen haben

Verdiene Bis Zu 1.250 $+/Monat Mit Content

Tritt unserem exklusiven Creator-Affiliate-Programm bei. Werde pro viralem Video nach Leistung bezahlt. Erstelle Inhalte in deinem Stil mit voller kreativer Freiheit.

Checkliste für erforderliche Verbindungen:

- KSampler benötigt: model, positive, negative, latent_image

- VAE Decode benötigt: vae, samples

- CLIP Text Encode benötigt: clip

Schwarze oder Beschädigte Bilder

Problem: Generierte Bilder erscheinen schwarz oder verzerrt Lösung:

- Überprüfen Sie, dass VAE Decode korrekt verbunden ist

- Stellen Sie sicher, dass Sie kompatible Modell/VAE-Kombinationen verwenden

- Stellen Sie sicher, dass die Bildgröße den Modellanforderungen entspricht

Speicherfehler

Problem: Generierung schlägt mit CUDA/Speicherfehlern fehl Lösung:

- Reduzieren Sie Bildabmessungen (versuchen Sie 512x512)

- Reduzieren Sie die Batch-Größe auf 1

- Starten Sie ComfyUI neu, um Speicher zu löschen

- Schließen Sie andere GPU-intensive Anwendungen

Langsame Generierungsgeschwindigkeit

Leistungsoptimierungstipps:

- Verwenden Sie kleinere Bildgrößen zum Testen

- Reduzieren Sie die Anzahl der Schritte für schnelle Iterationen

- Wählen Sie effiziente Sampler (euler_a, dpmpp_2m)

- Generieren Sie anfangs jeweils ein Bild

Praktische Workflow-Beispiele

Grundlegende Portraitgenerierung

Workflow-Konfiguration:

- Load Checkpoint: Realistisches Modell

- Positiver Prompt: "professionelles Portraitfoto einer Person, Studiolicht, scharfer Fokus"

- Negativer Prompt: "verschwommen, verzerrt, niedrige Qualität, Cartoon"

- Größe: 512x768 (Hochformat)

- Steps: 25, CFG: 8

Einfache Landschaftserstellung

Workflow-Konfiguration:

- Load Checkpoint: Landschaftsorientiertes Modell

- Positiver Prompt: "malerische Berglandschaft, goldene Stunde, detailliert, fotorealistisch"

- Negativer Prompt: "Menschen, Gebäude, Text, verschwommen"

- Größe: 768x512 (Querformat)

- Steps: 30, CFG: 9

Schnelle Konzeptkunst

Workflow-Konfiguration:

- Load Checkpoint: Künstlerisches Modell

- Positiver Prompt: "Konzeptkunst, Fantasy-Schloss, dramatische Beleuchtung, detailliert"

- Negativer Prompt: "fotorealistisch, verschwommen, wenig Detail"

- Größe: 512x512 (quadratisch)

- Steps: 20, CFG: 7

Nächste Schritte Nach der Beherrschung der Grundlagen

Gradueller Kompetenzaufbau

Woche 1-2: Beherrschen Sie das Wesentliche

- Üben Sie das Verbinden der 5 grundlegenden Nodes

- Experimentieren Sie mit verschiedenen Prompts

- Probieren Sie verschiedene Bildgrößen und Einstellungen aus

Woche 3-4: Erweitern Sie Ihren Werkzeugkasten

- Fügen Sie Preview Image Nodes hinzu, um Zwischenergebnisse zu sehen

- Probieren Sie verschiedene Modelle aus und verstehen Sie ihre Stärken

- Experimentieren Sie mit Batch-Generierung

Monat 2: Erkunden Sie Fortgeschrittene Funktionen

- Lernen Sie über verschiedene VAE-Modelle

- Verstehen Sie Seed-Kontrolle für konsistente Ergebnisse

- Erkunden Sie erweiterte Sampling-Methoden

Workflow-Bibliotheken Erstellen

Organisationstipps:

- Speichern Sie erfolgreiche Workflows mit beschreibenden Namen

- Erstellen Sie Vorlagen für verschiedene Bildtypen

- Dokumentieren Sie Einstellungen, die für bestimmte Modelle gut funktionieren

Workflow-Namenskonvention:

- "Basis_Portrait_SD15.json"

- "Landschaft_SDXL_HoheQualitaet.json"

- "Konzeptkunst_FLUX_Schnell.json"

Wählen Sie Ihren Lernpfad

Während die Beherrschung des Node-Systems von ComfyUI unglaubliche kreative Kontrolle und tiefes Verständnis der KI-Bildgenerierung bietet, lohnt es sich, Ihre Ziele und Zeitinvestition zu berücksichtigen.

Vorteile des ComfyUI-Pfads:

- Vollständige Kontrolle über jeden Generierungsparameter

- Verständnis, wie KI-Bildgenerierung tatsächlich funktioniert

- Fähigkeit, benutzerdefinierte Workflows für spezifische Bedürfnisse zu erstellen

- Zugang zu modernsten Modellen und Techniken

Alternative Überlegungen: Für Kreative, die sich auf Ergebnisse statt auf technische Meisterschaft konzentrieren, bieten Plattformen wie Apatero.com professionelle KI-Bildgenerierung mit den neuesten Modellen und Optimierungen, ohne dass Node-basierte Workflow-Erstellung erforderlich ist.

Die Wahl hängt davon ab, ob Sie ein ComfyUI-Experte werden oder einfach effizient erstaunliche Bilder erstellen möchten.

Fazit und Ihre ComfyUI-Reise

Die Beherrschung dieser fünf essentiellen Nodes - Load Checkpoint, CLIP Text Encode, Empty Latent Image, KSampler und VAE Decode - gibt Ihnen die Grundlage, jedes KI-Bild zu erstellen, das Sie sich vorstellen können. Jeder fortgeschrittene ComfyUI-Workflow baut auf denselben grundlegenden Bausteinen auf.

Ihr Lern-Fahrplan:

- Diese Woche: Meistern Sie die Verbindung der 5 essentiellen Nodes

- Nächste Woche: Experimentieren Sie mit verschiedenen Modellen und Prompts

- Monat 1: Bauen Sie Vertrauen mit verschiedenen Bildtypen und -größen auf

- Monat 2: Erkunden Sie fortgeschrittene Nodes und Workflow-Optimierung

- Monat 3+: Erstellen Sie benutzerdefinierte Workflows für Ihre spezifischen kreativen Bedürfnisse

Wichtige Erkenntnisse:

- Beginnen Sie einfach mit den 5 essentiellen Nodes

- Konzentrieren Sie sich auf das Verständnis von Verbindungen, bevor Sie Komplexität hinzufügen

- Üben Sie mit verschiedenen Prompts und Einstellungen

- Speichern Sie Workflows, die gut funktionieren, für zukünftige Verwendung

- Seien Sie geduldig - ComfyUI-Meisterschaft kommt durch praktische Erfahrung

Sofortige Aktionsschritte:

- Laden Sie ComfyUI herunter und installieren Sie ein Stable Diffusion Modell

- Erstellen Sie Ihren ersten Workflow mit den 5 essentiellen Nodes

- Generieren Sie 10 verschiedene Bilder, indem Sie nur die Prompts ändern

- Experimentieren Sie mit verschiedenen Bildgrößen und KSampler-Einstellungen

- Speichern Sie Ihren ersten erfolgreichen Workflow als Vorlage

Denken Sie daran, jeder ComfyUI-Experte hat mit denselben grundlegenden Nodes angefangen. Die Komplexität, die heute überwältigend erscheint, wird zur zweiten Natur, während Sie üben. Ob Sie weiterhin fortgeschrittene ComfyUI-Expertise aufbauen oder sich für optimierte Alternativen wie Apatero.com entscheiden, das Verständnis dieser Grundlagen gibt Ihnen das Wissen, fundierte Entscheidungen über Ihren KI-Bildgenerierungs-Workflow zu treffen.

Ihre kreative Reise mit KI-Bildgenerierung beginnt mit diesen fünf Nodes - beherrschen Sie sie, und Sie haben die Grundlage grenzenloser visueller Kreativität gemeistert.

Bereit, Ihren KI-Influencer zu Erstellen?

Treten Sie 115 Studenten bei, die ComfyUI und KI-Influencer-Marketing in unserem kompletten 51-Lektionen-Kurs meistern.

Verwandte Artikel

Die 10 häufigsten ComfyUI-Anfängerfehler und wie man sie 2025 behebt

Vermeide die 10 häufigsten ComfyUI-Fehler, die neue Nutzer frustrieren. Vollständiger Troubleshooting-Leitfaden mit Lösungen für VRAM-Fehler, Probleme beim Laden von Modellen...

25 ComfyUI-Tipps und -Tricks, die Profis 2025 nicht verraten wollen

Entdecken Sie 25 fortgeschrittene ComfyUI-Tipps, Workflow-Optimierungstechniken und professionelle Tricks, die Experten nutzen. Vollständiger Leitfaden zur CFG-Optimierung, Batch-Verarbeitung und Qualitätsverbesserung.

360 Anime-Drehung mit Anisora v3.2: Kompletter Charakter-Rotationsguide ComfyUI 2025

Meistern Sie 360-Grad-Anime-Charakter-Rotation mit Anisora v3.2 in ComfyUI. Lernen Sie Kamera-Orbit-Workflows, Multi-View-Konsistenz und professionelle Turnaround-Animationstechniken.