すべての初心者が知っておくべきComfyUI基本必須ノード

2025年にComfyUIの基本ノードを習得しましょう。Load Checkpoint、CLIP Text Encode、KSampler、VAE Decode、基本的なワークフロー作成に関する完全な初心者向けガイド。

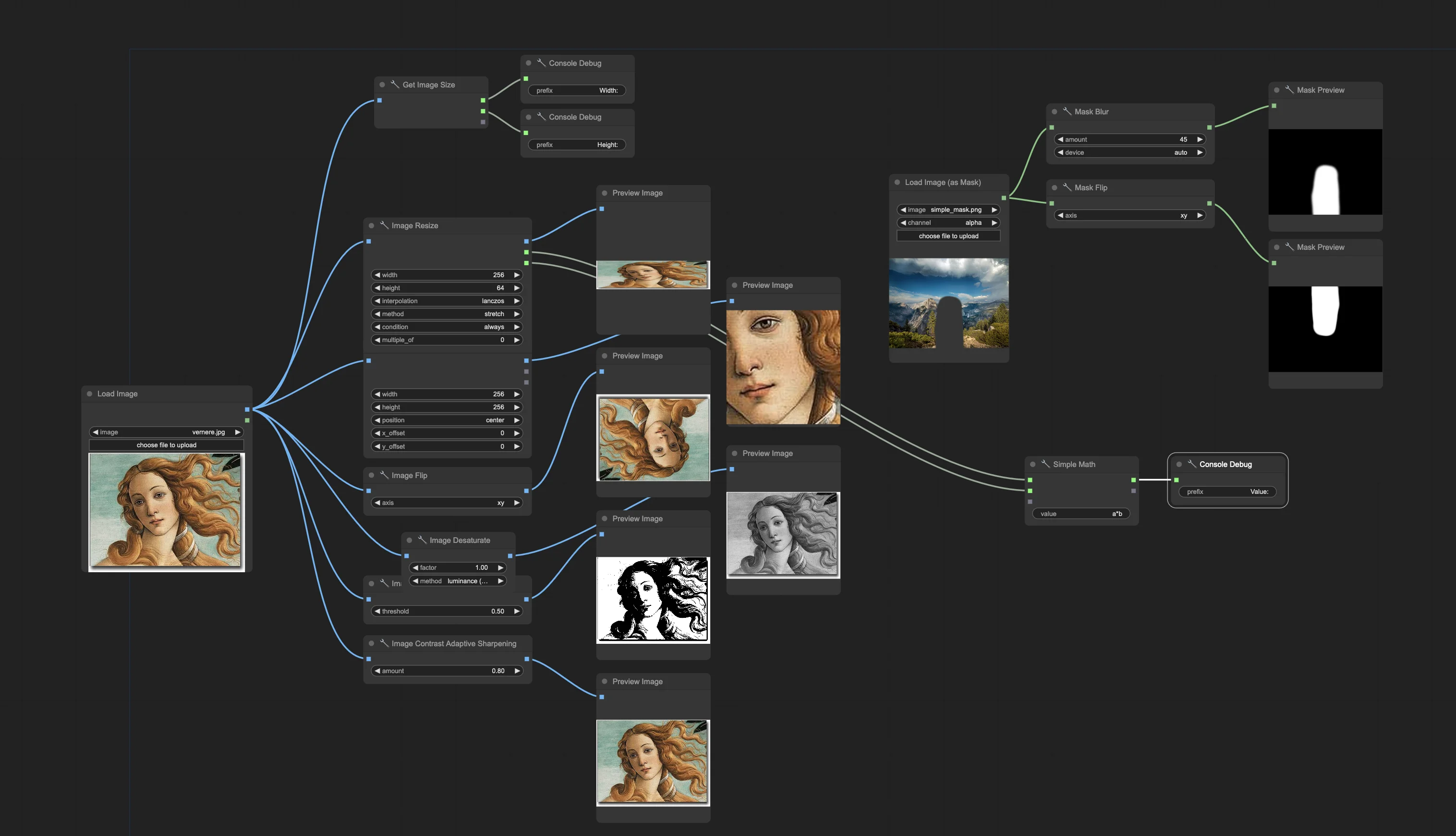

ComfyUIのAI画像生成における驚異的な力について聞いたことがあるでしょうが、初めて開いたときは回路基板を見ているように感じます。ノードがいたるところにあり、意味をなさない接続、そしてクリエイティブツールというよりも工学図のように見えるワークフロー。

すべてのエキスパートは、まさに今のあなたがいる場所から始まりました - インターフェースに混乱しているが、可能性に興奮しています。諦めることとComfyUIを習得することの違いは、すべてのワークフローのバックボーンを形成する5つの必須ノードを理解することに帰着します。

これらの基礎を把握すると、ComfyUIは威圧的な迷路から、クリエイティブなアイデアが見事なAI生成画像になる直感的なキャンバスに変わります。

ComfyUIノードの理解 - 構成要素

ComfyUIノードをAI画像生成のLEGOブロックのように考えてください。各ノードは1つの特定のタスクを実行し、それらを接続して完全なワークフローを作成します。プロセスをシンプルなボタンの背後に隠す他のAIツールとは異なり、ComfyUIは画像生成がどのように機能するかを正確に示します。

ノードを強力にするもの: 各ノードには3つの部分があります - 入力(左側)、出力(右側)、パラメータ(中央のコントロール)。あるノードの出力を別のノードの入力に接続することで、テキストプロンプトを最終画像に変換するデータフローを作成します。

これが重要な理由: ノードを理解することで、生成プロセスを完全に制御できます。事前設定されたオプションに制限される代わりに、画像の作成方法のあらゆる側面をカスタマイズできます。

Apatero.comのようなプラットフォームがセットアップの複雑さなしに即座のAI画像生成を提供する一方で、ComfyUIのノードシステムを学ぶことは、前例のないクリエイティブコントロールとカスタマイズの可能性を提供します。

知っておくべき5つの必須ノード

1. Load Checkpoint - AIモデルの基盤

機能: Load Checkpointノードは、AIモデル(Stable Diffusion 1.5、SDXL、FLUXなど)をロードし、画像生成のための3つの必須コンポーネントを提供します。

3つの出力の説明:

- MODEL: ノイズから画像を作成する実際の画像ジェネレーター

- CLIP: プロンプトを理解するテキストプロセッサー

- VAE: 人間が見える画像とAIが読み取れるデータの間の変換器

使用方法:

- Load Checkpointノードをキャンバスに追加

- モデル名のドロップダウンをクリックして、希望のモデルを選択

- 3つの出力を必要とする他のノードに接続

初心者向けの一般的なモデル:

- Stable Diffusion 1.5: 高速、信頼性が高い、学習に最適

- SDXL: より高品質、やや遅い

- FLUX: 最新技術、優れた結果

2. CLIP Text Encode - 言葉をAI言語に変換

機能: CLIP Text Encodeノードは、テキストプロンプトをAIモデルが理解し、画像生成に使用できる数学的表現に変換します。

必要な2つのタイプ:

- ポジティブプロンプト: 画像に欲しいものを記述

- ネガティブプロンプト: 欲しくないものを記述

基本設定:

- 2つのCLIP Text Encodeノードをワークフローに追加

- Load CheckpointからのCLIP出力を両方のノードに接続

- 最初のノードにポジティブプロンプトを入力

- 2番目のノードにネガティブプロンプトを入力(「ぼやけた、低品質」など)

プロンプト作成のヒント:

- プロンプトはシンプルで説明的に保つ

- カンマを使って異なる要素を分ける

- スタイル要素を追加する前に基本的な説明から始める

3. Empty Latent Image - キャンバスサイズの設定

機能: 画像が生成されるAIの数学的空間(潜在空間と呼ばれる)に空白の「キャンバス」を作成します。画像の寸法を設定すると考えてください。

主要設定:

- 幅と高さ: ピクセル単位の最終画像サイズ

- バッチサイズ: 一度に生成する画像の数

初心者向けの推奨サイズ:

- 512x512: 高速生成、テストに適している

- 768x768: より良い品質、やや遅い

- 1024x1024: 高品質、より多くのVRAMが必要

接続: 潜在出力は画像生成の開始点としてKSamplerノードに接続します。

4. KSampler - 画像生成の心臓部

機能: KSamplerは魔法が起こる場所です。テキストプロンプト、空白のキャンバス、AIモデルを取り、ノイズ除去プロセスを通じてランダムノイズを段階的に希望の画像に変換します。

必須設定:

| 設定 | 推奨値 | 機能 |

|---|---|---|

| Steps | 20-30 | 実行する改良パスの数 |

| CFG Scale | 7-12 | プロンプトにどれだけ忠実に従うか |

| Sampler Name | euler_aまたはdpmpp_2m | 生成アルゴリズム |

| Scheduler | normal | ステップの間隔 |

| Seed | -1(ランダム) | 生成の開始点 |

シードと再現可能な結果を取得する方法について詳しく学ぶには、包括的なシード管理ガイドをお読みください。

無料のComfyUIワークフロー

この記事のテクニックに関する無料のオープンソースComfyUIワークフローを見つけてください。 オープンソースは強力です。

必要な接続:

- MODEL入力: Load Checkpointから

- Positive入力: ポジティブCLIP Text Encodeから

- Negative入力: ネガティブCLIP Text Encodeから

- Latent image: Empty Latent Imageから

5. VAE Decode - 画像を可視化

機能: AIの数学的表現(潜在空間)を、見て保存できる通常の画像に戻します。このステップがないと、AIが理解するデータしかありません。

シンプルな設定:

- VAE Decodeノードを追加

- VAE入力をLoad CheckpointからのVAE出力に接続

- samples入力をKSamplerからのLATENT出力に接続

- IMAGE出力が最終的に生成された画像を表示

最初の基本ワークフローの構築

ステップバイステップのワークフロー作成

ステップ1: ノードを追加 空白のキャンバスを右クリックして、これら5つのノードを追加:

- Load Checkpoint

- CLIP Text Encode(これを2つ追加)

- Empty Latent Image

- KSampler

- VAE Decode

ステップ2: モデルを設定 Load Checkpointノードをクリックし、ドロップダウンメニューからStable Diffusionモデルを選択。

ステップ3: キャンバスサイズを設定 Empty Latent Imageノードで、幅と高さを512に設定(初心者に適した開始サイズ)。

ステップ4: プロンプトを書く

- 最初のCLIP Text Encode: "山々の美しい夕日、フォトリアリスティック"

- 2番目のCLIP Text Encode: "ぼやけた、低品質、歪んだ"

ステップ5: すべてを接続 出力ドットから入力ドットにドラッグして、これらの接続を行います:

| ノードから | 出力 | ノードへ | 入力 |

|---|---|---|---|

| Load Checkpoint | MODEL | KSampler | model |

| Load Checkpoint | CLIP | CLIP Text Encode #1 | clip |

| Load Checkpoint | CLIP | CLIP Text Encode #2 | clip |

| Load Checkpoint | VAE | VAE Decode | vae |

| CLIP Text Encode #1 | CONDITIONING | KSampler | positive |

| CLIP Text Encode #2 | CONDITIONING | KSampler | negative |

| Empty Latent Image | LATENT | KSampler | latent_image |

| KSampler | LATENT | VAE Decode | samples |

ステップ6: 画像を生成 「Queue Prompt」をクリックして、最初のComfyUI画像が生成されるのを見てください!

必須ノードパラメータの説明

KSampler設定の詳細

Steps(20-30推奨): ステップが多いほど品質は高くなりますが、生成は遅くなります。テストには20から始め、最終画像には30に増やします。

複雑さをスキップしたいですか? Apatero は、技術的なセットアップなしでプロフェッショナルなAI結果を即座に提供します。

CFG Scale(7-12推奨): プロンプトの遵守を制御します。低い値(7-8)= より多くの創造的自由。高い値(10-12)= より厳格なプロンプト追従。

サンプラー方法:

- euler_a: 高速、良品質、初心者に最適

- dpmpp_2m: やや良好な品質、速度差は最小限

- ddim: 古い方法、依然として信頼性がある

スケジューラーオプション:

- normal: 標準間隔、ほとんどの場合に機能

- karras: わずかに異なるステップ間隔、時々より良い結果 スケジューラーが画像にどのように影響するかの詳細については、Karrasスケジューラー説明ガイドをご確認ください。

一般的なパラメータの組み合わせ

| 画像タイプ | Steps | CFG | Sampler | 最適用途 |

|---|---|---|---|---|

| クイックテスト | 15 | 7 | euler_a | 迅速な反復 |

| バランスの取れた品質 | 25 | 8 | dpmpp_2m | 一般的な使用 |

| 高品質 | 30 | 10 | dpmpp_2m | 最終出力 |

| 創造的自由 | 20 | 6 | euler_a | 芸術的探求 |

さまざまな画像サイズでの作業

解像度ガイドライン

さまざまなモデルの標準サイズ:

| モデルタイプ | 推奨サイズ | VRAM使用量 | 生成時間 |

|---|---|---|---|

| SD 1.5 | 512x512, 512x768 | 低 | 高速 |

| SDXL | 1024x1024, 768x1344 | 中 | 中程度 |

| FLUX | 1024x1024, 896x1152 | 高 | より遅い |

アスペクト比のヒント:

- 正方形(1:1): 512x512, 1024x1024

- ポートレート(3:4): 512x768, 768x1024

- ランドスケープ(4:3): 768x512, 1024x768

- ワイドスクリーン(16:9): 512x896, 1024x576

ノード接続の理解

接続タイプと色

ビジュアル接続ガイド:

| 接続色 | データタイプ | 一般的な使用 |

|---|---|---|

| 紫 | MODEL | AI生成エンジン |

| 黄 | CLIP | テキスト処理 |

| 赤 | VAE | 画像エンコーディング/デコーディング |

| オレンジ | CONDITIONING | 処理されたプロンプト |

| 白 | LATENT | AIの作業スペース |

| 緑 | IMAGE | 最終的な可視画像 |

接続ルール

接続できるもの:

- 同じ色の出力と入力を接続できる

- 1つの出力は複数の入力に接続できる

- 各入力は1つの接続のみを受け入れる

一般的な接続ミス:

- 異なる色の接続を接続しようとする

- すべての必要な入力を接続し忘れる

- 出力を出力に接続する(不可能)

エラーで問題がある場合は、完全なトラブルシューティングソリューションについてComfyUI初心者の10の一般的なミスガイドをご確認ください。

初心者の一般的な問題のトラブルシューティング

「入力不足」エラー

問題: 不足している接続を示す赤いテキスト 解決策: すべての必要な入力(左側のドット)に適切な出力からの接続があることを確認

コンテンツ制作で月$1,250以上稼ぐ

独占クリエイターアフィリエイトプログラムに参加。バイラル動画のパフォーマンスに応じて報酬。自分のスタイルで完全な創造的自由を持ってコンテンツを作成。

必要な接続のチェックリスト:

- KSamplerには必要: model, positive, negative, latent_image

- VAE Decodeには必要: vae, samples

- CLIP Text Encodeには必要: clip

黒いまたは破損した画像

問題: 生成された画像が黒く表示されるか歪んでいる 解決策:

- VAE Decodeが正しく接続されていることを確認

- 互換性のあるモデル/VAEの組み合わせを使用していることを確認

- 画像サイズがモデル要件と一致していることを確認

メモリ不足エラー

問題: CUDA/メモリエラーで生成が失敗 解決策:

- 画像の寸法を減らす(512x512を試す)

- バッチサイズを1に減らす

- ComfyUIを再起動してメモリをクリア

- 他のGPU集約型アプリケーションを閉じる

生成速度が遅い

パフォーマンス最適化のヒント:

- テストには小さい画像サイズを使用

- 迅速な反復のためにステップ数を減らす

- 効率的なサンプラーを選択(euler_a、dpmpp_2m)

- 最初は一度に1つの画像を生成

実用的なワークフローの例

基本的なポートレート生成

ワークフロー設定:

- Load Checkpoint: リアリスティックモデル

- ポジティブプロンプト: "人物のプロフェッショナルヘッドショット写真、スタジオライティング、シャープフォーカス"

- ネガティブプロンプト: "ぼやけた、歪んだ、低品質、漫画"

- サイズ: 512x768(ポートレート向き)

- Steps: 25, CFG: 8

シンプルな風景作成

ワークフロー設定:

- Load Checkpoint: 風景重視のモデル

- ポジティブプロンプト: "風光明媚な山の風景、ゴールデンアワー、詳細、フォトリアリスティック"

- ネガティブプロンプト: "人々、建物、テキスト、ぼやけた"

- サイズ: 768x512(ランドスケープ向き)

- Steps: 30, CFG: 9

クイックコンセプトアート

ワークフロー設定:

- Load Checkpoint: アーティスティックモデル

- ポジティブプロンプト: "コンセプトアート、ファンタジー城、ドラマチックライティング、詳細"

- ネガティブプロンプト: "フォトリアリスティック、ぼやけた、低ディテール"

- サイズ: 512x512(正方形)

- Steps: 20, CFG: 7

基礎をマスターした後の次のステップ

段階的なスキル構築

週1-2: 必須事項をマスター

- 5つの基本ノードを接続する練習

- さまざまなプロンプトで実験

- さまざまな画像サイズと設定を試す

週3-4: ツールキットを拡張

- Preview Imageノードを追加して中間結果を確認

- さまざまなモデルを試して長所を理解

- バッチ生成で実験

月2: 中級機能を探索

- さまざまなVAEモデルについて学ぶ

- 一貫した結果のためのシード制御を理解

- 高度なサンプリング方法を探索

ワークフローライブラリの構築

整理のヒント:

- 成功したワークフローを説明的な名前で保存

- さまざまな画像タイプのテンプレートを作成

- 特定のモデルでうまく機能する設定を文書化

ワークフロー命名規則:

- "基本_ポートレート_SD15.json"

- "風景_SDXL_高品質.json"

- "コンセプトアート_FLUX_高速.json"

学習パスの選択

ComfyUIのノードシステムをマスターすることは、信じられないほどのクリエイティブコントロールとAI画像生成の深い理解を提供しますが、目標と時間投資を検討する価値があります。

ComfyUIパスの利点:

- すべての生成パラメータに対する完全な制御

- AI画像生成が実際にどのように機能するかの理解

- 特定のニーズに対するカスタムワークフローを作成する能力

- 最先端のモデルと技術へのアクセス

代替の考慮事項: 技術的な習熟度よりも結果に焦点を当てたクリエイターにとって、Apatero.comのようなプラットフォームは、ノードベースのワークフロー作成を必要とせず、最新のモデルと最適化でプロフェッショナル品質のAI画像生成を提供します。

選択は、ComfyUIエキスパートになりたいか、単に効率的に素晴らしい画像を作成したいかによって異なります。

結論とComfyUIの旅

これら5つの必須ノード - Load Checkpoint、CLIP Text Encode、Empty Latent Image、KSampler、VAE Decode - をマスターすることで、想像できるあらゆるAI画像を作成するための基礎が得られます。すべての高度なComfyUIワークフローは、これらの同じ基本的な構成要素に基づいています。

学習ロードマップ:

- 今週: 5つの必須ノードを接続することをマスター

- 来週: さまざまなモデルとプロンプトで実験

- 月1: さまざまな画像タイプとサイズで自信を築く

- 月2: 中級ノードとワークフロー最適化を探索

- 月3+: 特定のクリエイティブニーズのためのカスタムワークフローを作成

重要なポイント:

- 5つの必須ノードでシンプルに始める

- 複雑さを追加する前に接続を理解することに集中

- さまざまなプロンプトと設定で練習

- 将来の使用のためにうまく機能するワークフローを保存

- 忍耐強く - ComfyUIの習熟は実践的な経験を通じて得られる

即座の行動ステップ:

- ComfyUIをダウンロードしてStable Diffusionモデルをインストール

- 5つの必須ノードを使用して最初のワークフローを作成

- プロンプトのみを変更して10の異なる画像を生成

- さまざまな画像サイズとKSampler設定で実験

- 最初の成功したワークフローをテンプレートとして保存

覚えておいてください、すべてのComfyUIエキスパートはこれらの同じ基本ノードから始まりました。今日圧倒的に見える複雑さは、練習するにつれて第二の性質になります。高度なComfyUI専門知識を構築し続けるか、Apatero.comのような合理化された代替手段を選択するかにかかわらず、これらの基礎を理解することで、AI画像生成ワークフローについて情報に基づいた決定を下す知識が得られます。

AI画像生成とのクリエイティブな旅は、これら5つのノードから始まります - それらをマスターすれば、無限のビジュアルクリエイティビティの基礎をマスターしたことになります。

AIインフルエンサーを作成する準備はできましたか?

115人の学生とともに、51レッスンの完全なコースでComfyUIとAIインフルエンサーマーケティングをマスター。

関連記事

ComfyUI初心者が陥る最も一般的な10の間違いと2025年版の修正方法

新規ユーザーを悩ませるComfyUI初心者の落とし穴トップ10を回避しましょう。VRAMエラー、モデル読み込みなどの完全なトラブルシューティングガイド...

2025年版:プロユーザーが教えたがらないComfyUIの25のテクニックとコツ

エキスパートユーザーが活用している25の高度なComfyUIテクニック、ワークフロー最適化手法、プロレベルのコツを解説します。CFGチューニング、バッチ処理、品質改善の完全ガイド。

Anisora v3.2で360度アニメ回転:ComfyUI完全キャラクター回転ガイド2025

ComfyUIでAnisora v3.2を使用して360度アニメキャラクター回転をマスターしましょう。カメラ軌道ワークフロー、マルチビュー一貫性、プロフェッショナルなターンアラウンドアニメーション技術を学びます。