olmOCR 2 7B - OCR Open Source Revolucionário para Conversão de Documentos 2025

Guia completo do olmOCR 2 7B, o modelo revolucionário de OCR de código aberto do Allen AI. Descubra como este modelo de linguagem visual de 7B atinge 82,4% de precisão e processa 10.000 páginas por menos de $2.

Você está tentando extrair texto de milhares de PDFs digitalizados, documentos históricos ou artigos acadêmicos complexos com tabelas intrincadas e fórmulas matemáticas. Ferramentas OCR tradicionais como o Tesseract destroem a formatação, APIs comerciais caras drenam seu orçamento a $0,05 por página, e o GPT-4o Vision te dá 80% de precisão mas custa uma fortuna em grande escala.

E se você pudesse processar 10.000 páginas de documentos com precisão quase perfeita por menos de $2, preservar estruturas de tabelas complexas automaticamente e converter equações manuscritas em LaTeX limpo sem heurísticas de pós-processamento? O Allen Institute for AI acabou de lançar exatamente isso.

Resposta Rápida: olmOCR 2 7B é um modelo de linguagem visual de código aberto que converte documentos impressos digitalizados em texto limpo e estruturado com 82,4% de precisão em benchmarks. Construído sobre o Qwen2.5-VL-7B e treinado usando recompensas revolucionárias de testes unitários, ele alcança desempenho de ponta em fórmulas matemáticas, tabelas e layouts multi-coluna, processando 3.400 tokens por segundo em uma única GPU H100.

- olmOCR 2 7B atinge 82,4% no olmOCR-Bench, superando GPT-4o e ferramentas OCR comerciais

- Processa 10.000 páginas por menos de $2 usando o modelo quantizado FP8 a 3.400 tokens/segundo

- Treinado usando recompensas de testes unitários em 270.000 páginas diversificadas de PDF incluindo artigos acadêmicos, documentos legais e digitalizações históricas

- Gera texto estruturado diretamente com títulos Markdown, tabelas HTML e equações LaTeX

- Disponível em código aberto no Hugging Face com licenciamento permissivo para uso comercial

O Que É o olmOCR 2 7B e Por Que Ele Importa?

A tecnologia OCR tradicional tem limitações fundamentais. Ferramentas como o Tesseract funcionam bem para documentos limpos e bem estruturados, mas desmoronam completamente quando confrontadas com layouts complexos, notação matemática ou artigos acadêmicos multi-coluna. Soluções comerciais como o Google Cloud Vision atingem 98% de precisão em texto simples, mas têm dificuldade em preservar a estrutura de documentos e custam valores proibitivos para processamento em grande escala.

O olmOCR 2 representa uma mudança de paradigma na forma como abordamos a digitalização de documentos. Em vez de tratar OCR como um problema puro de imagem para texto, o Allen Institute for AI desenvolveu o olmOCR 2 como um modelo de linguagem visual de ponta a ponta que lê documentos da forma como humanos fazem, compreendendo contexto, estrutura e significado simultaneamente.

A inovação está na sua metodologia de treinamento. Em vez de otimizar para métricas genéricas de precisão, o olmOCR 2 usa testes unitários determinísticos como sinais de recompensa durante o aprendizado por reforço. Isso significa que o modelo aprende a passar em testes específicos e verificáveis como "preservar estrutura de tabela corretamente" e "manter consistência da ordem de leitura" em vez de apenas maximizar uma pontuação de precisão vaga.

Números de Impacto no Mundo Real:

- Digitalizações históricas de matemática melhoraram de 79,9% para 82,3% de precisão

- Extração de tabelas saltou de 72,9% para 84,9% de precisão

- Tratamento de layout multi-coluna aumentou de 77,3% para 83,7% de precisão

O modelo agora interpreta corretamente detalhes sutis como datas manuscritas nas cartas de Abraham Lincoln de 1864, algo que deixaria virtualmente todos os outros sistemas OCR disponíveis hoje perplexos.

Enquanto plataformas como Apatero.com oferecem processamento instantâneo de documentos sem nenhuma configuração técnica, entender modelos OCR avançados como o olmOCR 2 ajuda equipes técnicas a tomar decisões informadas sobre a implantação de pipelines personalizados de processamento de documentos em escala.

Como o olmOCR 2 7B Realmente Funciona?

A arquitetura técnica do olmOCR 2 7B revela por que ele supera tudo mais no mercado. Em seu núcleo, o modelo é construído sobre o Qwen2.5-VL-7B-Instruct, um modelo de fundação de linguagem visual de 7 bilhões de parâmetros que já se destaca em entender informação visual e gerar respostas de texto coerentes.

O Processo de Treinamento:

A Allen AI fez o ajuste fino deste modelo base no olmOCR-mix-1025, um conjunto de dados meticulosamente curado contendo 270.000 páginas de PDF com extrema diversidade. Não são apenas artigos acadêmicos ou documentos comerciais. O conjunto de dados inclui digitalizações históricas com qualidade de imagem degradada, documentos legais com layouts densos multi-coluna, folhetos técnicos com gráficos complexos e artigos matemáticos repletos de equações e notações.

Mas a verdadeira inovação vem na próxima fase usando aprendizado por reforço com recompensas verificáveis. Abordagens tradicionais treinariam modelos para maximizar pontuações de similaridade contra texto de verdade absoluta. O olmOCR 2 adota uma abordagem radicalmente diferente gerando dados de treinamento sintéticos através da análise do Claude Sonnet 4.

Metodologia de Recompensas de Testes Unitários:

O sistema cria verificadores determinísticos que checam propriedades específicas como se estruturas de tabelas são preservadas corretamente, a ordem de leitura mantém fluxo lógico, fórmulas matemáticas convertem com precisão para LaTeX, e títulos renderizam com hierarquia Markdown apropriada. Esses testes binários de aprovação/reprovação se tornam sinais de recompensa durante o treinamento de Group Relative Policy Optimization.

De acordo com o artigo de pesquisa, essa abordagem gerou 2.186 páginas PDF sintéticas com 30.381 casos de teste verificáveis a apenas $0,12 por página. O modelo aprende com critérios de desempenho concretos e mensuráveis em vez de métricas difusas de similaridade.

Arquitetura de Inferência:

Ao processar um documento, o olmOCR 2 7B segue este pipeline:

- Imagens de documentos são redimensionadas com a dimensão mais longa definida para 1288 pixels

- Páginas são codificadas em base64 como imagens PNG

- O modelo processa imagens com prompts de metadados de documentos

- A saída gera texto estruturado com tags de formatação incorporadas

- Markdown aparece para títulos, HTML renderiza para tabelas, LaTeX formata equações

Essa abordagem de ponta a ponta elimina o fluxo típico de OCR que requer estágios separados de detecção, reconhecimento e pós-processamento. O modelo gera texto limpo e naturalmente ordenado em uma única passagem.

- Velocidade: Modelo quantizado FP8 atinge 3.400 tokens de saída por segundo em uma única GPU H100

- Custo: Processe 10.000 páginas por menos de $2 com inferência quantizada

- Precisão: 82,4 pontos no olmOCR-Bench, superando GPT-4o e ferramentas comerciais especializadas

- Preservação de Estrutura: 95,7% de precisão na detecção de cabeçalhos/rodapés, 99,7% de precisão em texto base

Por Que Você Deveria Usar o olmOCR 2 7B em Vez de Outras Soluções OCR?

O cenário de OCR em 2025 oferece dezenas de opções, desde ferramentas clássicas como o Tesseract até LLMs multimodais de ponta como o GPT-4o Vision. Entender onde o olmOCR 2 7B se encaixa neste ambiente competitivo ajuda você a fazer a escolha certa para seu caso de uso específico.

Comparação com Ferramentas OCR Tradicionais:

O Tesseract permanece o mecanismo OCR de código aberto mais amplamente implantado, testado em batalha em milhões de implantações de produção. Ele lida adequadamente com documentos limpos e bem estruturados e roda eficientemente em hardware modesto. No entanto, o Tesseract luta catastroficamente com layouts complexos, produz saída distorcida para documentos multi-coluna, falha completamente em notação matemática e requer extenso pós-processamento para produzir resultados utilizáveis.

O olmOCR 2 7B trata esses casos "difíceis" como sua competência central. Onde o Tesseract gera texto confuso de um artigo acadêmico de duas colunas, o olmOCR 2 preserva a ordem de leitura perfeitamente. Onde o Tesseract ignora fórmulas matemáticas inteiramente, o olmOCR 2 gera LaTeX limpo. A diferença de desempenho se torna insuperável conforme a complexidade do documento aumenta.

Comparação com APIs de Visão Comerciais:

O Google Cloud Platform Vision OCR atinge impressionantes 98% de precisão de texto quando testado em conjuntos de dados de documentos limpos. AWS Textract e Azure Computer Vision oferecem capacidades similares com confiabilidade de nível empresarial e escala global. Essas soluções comerciais dominam o mercado para necessidades diretas de digitalização de documentos.

Mas o custo se torna proibitivo em escala. Processar 10.000 páginas através do Google Cloud Vision custa centenas de dólares. O GPT-4o Vision entrega excelentes resultados, mas varia de $0,03 a $0,05 por página dependendo da resolução da imagem. Para grandes projetos de arquivo ou pipelines contínuos de processamento de documentos, esses custos se acumulam rapidamente.

O olmOCR 2 7B processa as mesmas 10.000 páginas por menos de $2 usando o modelo quantizado FP8. Isso não é uma melhoria de 10x. É uma redução de custo de 150-200x comparado a APIs comerciais enquanto mantém precisão comparável ou superior em documentos complexos.

Comparação com GPT-4o e LLMs Multimodais:

Um detalhe interessante emerge da pesquisa. O olmOCR-mix-1025, o conjunto de dados de treinamento, foi criado usando saída OCR pelo próprio GPT-4o. O modelo estudante aprendeu da saída do professor, depois o superou.

Nas avaliações do olmOCR-Bench, o olmOCR 2 7B atinge 82,4 pontos comparado aos aproximadamente 78-80% de precisão do GPT-4o em tarefas similares de conversão de documentos. O modelo especializado vence o modelo de linguagem visual de propósito geral em seu próprio jogo.

O GPT-4o Vision se destaca em entender amplamente o conteúdo de imagens, responder perguntas sobre cenas visuais e realizar diversas tarefas de raciocínio multimodal. Mas para a tarefa específica de converter documentos impressos digitalizados em texto limpo, o especialista focado de 7B parâmetros supera o modelo massivo de propósito geral.

Quando o olmOCR 2 7B Faz Sentido:

Fluxos de Trabalho ComfyUI Gratuitos

Encontre fluxos de trabalho ComfyUI gratuitos e de código aberto para as técnicas deste artigo. Open source é poderoso.

Escolha o olmOCR 2 7B quando você precisar processar grandes volumes de documentos complexos a custo mínimo, converter artigos acadêmicos com notação matemática com precisão, preservar estruturas de tabelas e layouts multi-coluna perfeitamente, ou executar inferência em seu próprio hardware sem dependências de API.

Considere alternativas quando lidar com documentos manuscritos, processar imagens de cenas do mundo real em vez de impressos digitalizados, ou precisar de soluções plug-and-play imediatas sem configuração técnica.

Para equipes que desejam resultados profissionais de processamento de documentos sem gerenciar infraestrutura, plataformas como Apatero.com entregam capacidades OCR prontas para produção com zero configuração necessária.

Como Você Configura e Usa o olmOCR 2 7B?

Começar com o olmOCR 2 7B requer alguma familiaridade técnica, mas o toolkit oficial olmocr simplifica o processo significativamente comparado a construir tudo do zero.

Requisitos de Instalação:

O toolkit requer Python 3.8 ou mais recente e acesso a uma GPU para velocidades de inferência razoáveis. Embora você possa executar o modelo em CPU, o desempenho se torna impraticavelmente lento para qualquer volume significativo de processamento de documentos.

Instale o toolkit oficial executando pip install olmocr com versão 0.4.0 ou mais recente. Este único comando puxa todas as dependências necessárias incluindo VLLM para inferência eficiente, a arquitetura do modelo Qwen2.5-VL e utilitários de pré-processamento para lidar com renderização de PDF e codificação de imagens.

Considerações de Hardware:

O modelo quantizado FP8 requer aproximadamente 8GB de memória GPU e atinge desempenho ótimo em GPUs NVIDIA H100 a 3.400 tokens por segundo. Hardware mais acessível como A100s ou até placas RTX 4090 de consumidor funcionam perfeitamente bem com throughput proporcionalmente reduzido.

A variante BF16 de precisão completa precisa de aproximadamente 16GB de memória GPU, mas entrega precisão marginalmente melhor em alguns casos extremos. Para a maioria das aplicações de produção, a versão quantizada FP8 fornece o melhor trade-off entre desempenho e eficiência.

Padrão de Uso Básico:

O toolkit lida com renderização de PDF, extração de texto e rotação automática de páginas internamente. Seu código se concentra em apontar para arquivos de documentos e processar a saída estruturada.

Para prompting manual fora do toolkit, o fluxo de trabalho envolve renderizar páginas PDF como imagens PNG codificadas em base64 na dimensão mais longa de 1288 pixels, construir prompts combinando dados de imagem com metadados de documentos, usar o processador do modelo para lidar com texto e imagens, e gerar saída com configurações de temperatura apropriadas para extração de texto determinística.

Opções de Acesso à API:

Quer pular a complexidade? Apatero oferece resultados profissionais de IA instantaneamente sem configuração técnica.

Se gerenciar sua própria infraestrutura parece assustador, o olmOCR 2 7B está disponível através de APIs hospedadas no DeepInfra e Parasail. Esses serviços lidam com toda a complexidade de infraestrutura enquanto cobram apenas pelo uso real.

O DeepInfra oferece preços pay-per-token que tornam o processamento de documentos individuais ou pequenos lotes econômico. O Parasail fornece confiabilidade de nível empresarial com garantias de SLA para cargas de trabalho de produção.

Dicas de Otimização de Desempenho:

O processamento em lote de múltiplas páginas juntas amortiza a sobrecarga de carregamento do modelo e melhora a utilização da GPU. O batching integrado do toolkit lida com isso automaticamente ao processar PDFs multi-página.

Usar o modelo quantizado FP8 fornece inferência 2x mais rápida com degradação de precisão negligenciável para a maioria dos documentos. Reserve o modelo BF16 completo para casos onde você precisa de precisão máxima absoluta em conteúdo particularmente desafiador.

Para projetos de arquivo muito grandes processando milhões de páginas, considere fazer ajuste fino do olmOCR 2 7B em seus tipos específicos de documentos. O toolkit inclui scripts de ajuste fino que permitem adaptar o modelo a layouts específicos de domínio, terminologia ou convenções de formatação.

Embora configurar pipelines OCR personalizados ofereça máxima flexibilidade e eficiência de custo, soluções como Apatero.com fornecem acesso instantâneo ao processamento avançado de documentos sem nenhuma dessa sobrecarga técnica, tornando-as ideais para equipes focadas em resultados de negócios em vez de gerenciamento de infraestrutura.

Quais São as Aplicações do Mundo Real do olmOCR 2 7B?

As aplicações práticas de OCR altamente preciso e eficiente em custos abrangem virtualmente todas as indústrias que lidam com arquivos de documentos, mas certos casos de uso se beneficiam desproporcionalmente das forças específicas do olmOCR 2.

Pesquisa Acadêmica e Bibliotecas Digitais:

Universidades e instituições de pesquisa mantêm vastos arquivos de artigos históricos, dissertações e manuscritos raros. Digitalizar essas coleções torna o conhecimento acessível globalmente, mas requer OCR capaz de lidar com digitalizações degradadas, notação matemática complexa e layouts acadêmicos multi-coluna.

O olmOCR 2 7B se destaca precisamente nesses casos desafiadores. Sua precisão de 82,3% em digitalizações matemáticas históricas significa que pesquisadores podem buscar em artigos de física de décadas atrás por equações específicas. A precisão de 84,9% em extração de tabelas preserva tabelas de dados de publicações de química sem correção manual.

Uma biblioteca de pesquisa processando 100.000 artigos arquivados gastaria $3.000-$5.000 usando APIs OCR comerciais a $0,03-$0,05 por página. O olmOCR 2 7B realiza a mesma tarefa por menos de $20 em custos de computação ao executar o modelo FP8 em GPUs de nuvem alugadas.

Processamento de Documentos Legais:

Escritórios de advocacia e departamentos jurídicos corporativos se afogam em documentos que requerem revisão, análise e buscabilidade. Contratos, arquivos de casos, documentações regulatórias e registros judiciais frequentemente abrangem centenas ou milhares de páginas com texto denso em formatos multi-coluna.

Ganhe Até $1.250+/Mês Criando Conteúdo

Junte-se ao nosso programa exclusivo de afiliados criadores. Seja pago por vídeo viral com base no desempenho. Crie conteúdo no seu estilo com total liberdade criativa.

Ferramentas OCR tradicionais distorcem esses layouts, exigindo revisão humana cara para capturar erros. A precisão de 83,7% do olmOCR 2 7B em layouts multi-coluna significa que documentos legais digitalizam corretamente na primeira vez, permitindo busca de texto completo em arquivos de casos e fluxos de trabalho automatizados de análise de contratos.

Digitalização de Registros Médicos:

Provedores de saúde fazem a transição de registros em papel para registros eletrônicos de saúde, mas décadas de arquivos históricos de pacientes existem apenas em forma física. Esses documentos contêm históricos médicos críticos, resultados de testes em formato tabular e notas manuscritas de médicos nas margens.

Embora o olmOCR 2 7B não lide com texto puramente manuscrito, ele se destaca nas partes digitadas, preservando estruturas de tabelas em resultados de laboratório e mantendo ordem de leitura apropriada através de relatórios complexos multi-seção. Combinado com reconhecimento especializado de manuscritos para as porções anotadas, ele permite digitalização abrangente de registros médicos.

Arquivos de Publicação e Mídia:

Jornais, revistas e editoras de livros mantêm extensos arquivos de publicações passadas. Tornar esse conteúdo pesquisável e acessível requer OCR que lide com layouts variados, desde páginas simples de livros até spreads complexos de revistas com barras laterais, citações destacadas e artigos multi-coluna.

A compreensão de arquitetura do olmOCR 2 7B permite que ele navegue esses layouts visualmente complexos, mantendo ordem de leitura lógica mesmo quando o fluxo visual não corresponde à ordem linear do texto. Uma empresa de mídia digitalizando 50 anos de edições antigas de revistas pode processar milhões de páginas a custos medidos em centenas em vez de centenas de milhares de dólares.

Arquivos de Documentos Governamentais:

Governos federais, estaduais e locais operam arquivos massivos de documentos abrangendo registros legislativos, documentações regulatórias, correspondência histórica e solicitações de registros públicos. Tornar esses acessíveis aos cidadãos requer digitalização acessível e precisa em escala sem precedentes.

A economia de custo do olmOCR 2 7B torna projetos anteriormente impraticáveis subitamente viáveis. Processar 10 milhões de páginas de arquivos governamentais custaria $300.000-$500.000 através de APIs comerciais. Com o olmOCR 2 7B, os custos de computação caem para menos de $2.000 mais despesas de infraestrutura.

Criação de Conjuntos de Dados para Treinamento de IA:

A comunidade de aprendizado de máquina precisa de quantidades massivas de dados de texto de alta qualidade para treinar modelos de linguagem. PDFs representam trilhões de tokens trancados em formatos não legíveis por máquina em artigos acadêmicos, livros, documentação técnica e conteúdo publicado na web.

O olmOCR 2 7B existe parcialmente para resolver exatamente esse problema para o trabalho do próprio Allen Institute. Como eles observam, desbloquear trilhões de tokens em PDFs requer OCR preciso o suficiente para produzir texto de qualidade de treinamento sem introduzir erros sistemáticos que corrompem o aprendizado do modelo.

Organizações construindo modelos de linguagem específicos de domínio agora podem extrair dados de treinamento limpos de documentos da indústria, literatura acadêmica ou arquivos proprietários a custos que não requerem orçamentos de milhões de dólares.

Para empresas que precisam de capacidades de processamento de documentos sem construir infraestrutura personalizada, plataformas como Apatero.com integram OCR avançado em fluxos de trabalho amigáveis, entregando resultados profissionais sem a complexidade de implantar e gerenciar modelos especializados.

Perguntas Frequentes

O que torna o olmOCR 2 7B melhor que o Tesseract ou outras ferramentas OCR de código aberto?

O olmOCR 2 7B usa uma arquitetura de modelo de linguagem visual que entende estrutura e contexto de documentos, diferente da abordagem de correspondência de padrões do Tesseract. Isso permite tratamento preciso de layouts complexos como documentos multi-coluna, fórmulas matemáticas em LaTeX e estruturas de tabelas. Embora o Tesseract funcione bem em documentos simples, o olmOCR 2 atinge 82,4% de precisão em documentos desafiadores do mundo real onde o Tesseract tipicamente falha ou produz saída fortemente corrompida que requer extensa correção manual.

Quanto custa processar documentos com o olmOCR 2 7B comparado a APIs comerciais?

O modelo olmOCR 2 7B quantizado FP8 processa 10.000 páginas por menos de $2 em custos de computação em uma única GPU H100. Alternativas comerciais como Google Cloud Vision ou GPT-4o Vision cobram $0,03-$0,05 por página, significando que 10.000 páginas custam $300-$500. Isso representa uma redução de custo de 150-250x. Para processar milhões de páginas em projetos de arquivo, o olmOCR 2 7B torna projetos anteriormente proibitivos em custos economicamente viáveis.

O olmOCR 2 7B pode lidar com documentos manuscritos ou apenas texto impresso?

O olmOCR 2 7B é especializado em documentos impressos digitalizados como PDFs, livros digitalizados e documentos digitados. Ele não lida efetivamente com texto puramente manuscrito. No entanto, ele pode processar documentos que misturam texto impresso com anotações manuscritas, extraindo com precisão as porções impressas. Para o exemplo de data manuscrita na carta de Lincoln de 1864 mencionada na pesquisa, isso se refere a interpretar datas impressas em documentos históricos, não reconhecer caligrafia.

Que hardware eu preciso para executar o olmOCR 2 7B localmente?

O modelo quantizado FP8 requer aproximadamente 8GB de memória GPU e roda otimamente em GPUs NVIDIA como H100, A100 ou até placas RTX 4090 de consumidor. O modelo de precisão completa BF16 precisa de aproximadamente 16GB de memória GPU. Você pode executar inferência em CPU, mas a velocidade se torna impraticavelmente lenta para processar mais de um punhado de páginas. Para cargas de trabalho de produção processando milhares de páginas, aceleração GPU é essencial.

Quão preciso é o olmOCR 2 7B em tabelas e fórmulas matemáticas?

O olmOCR 2 7B atinge 84,9% de precisão na extração de tabelas, acima dos 72,9% na versão anterior. Para fórmulas matemáticas, particularmente em digitalizações históricas, a precisão atinge 82,3% comparado aos 79,9% anteriormente. O modelo gera tabelas em formato HTML e equações em LaTeX, preservando estrutura sem requerer heurísticas de pós-processamento. Isso o torna particularmente valioso para digitalizar artigos acadêmicos, documentação técnica e arquivos científicos.

O olmOCR 2 7B é verdadeiramente código aberto e livre para uso comercial?

Sim, o olmOCR 2 7B é lançado sob a licença Apache 2.0, que permite uso tanto em pesquisa quanto comercial. Os pesos do modelo estão disponíveis no Hugging Face, o conjunto de dados de treinamento é publicamente acessível e o código é de código aberto no GitHub. Você pode implantá-lo em aplicações comerciais, modificá-lo para suas necessidades e usá-lo em sistemas de produção sem taxas de licenciamento, embora você deva revisar os termos completos da licença Apache 2.0 para requisitos específicos de conformidade.

Como o olmOCR 2 7B se compara ao GPT-4o Vision para tarefas OCR?

O olmOCR 2 7B atinge 82,4% no olmOCR-Bench comparado aos aproximadamente 78-80% de precisão do GPT-4o em benchmarks similares de conversão de documentos. Interessantemente, o conjunto de dados de treinamento do olmOCR foi criado usando saída do GPT-4o, tornando este um caso onde o modelo estudante especializado supera seu professor. O GPT-4o se destaca em tarefas de visão gerais, enquanto o olmOCR 2 7B foca especificamente em digitalização de documentos, resultando em melhor desempenho a uma fração do custo para este caso de uso particular.

Posso fazer ajuste fino do olmOCR 2 7B para meus tipos específicos de documentos?

Sim, o toolkit olmocr inclui scripts de ajuste fino que permitem adaptar o modelo a documentos específicos de domínio. Se você está processando grandes volumes de documentos com formatação consistente, terminologia ou convenções de layout diferentes dos dados gerais de treinamento, o ajuste fino pode melhorar ainda mais a precisão. Isso é particularmente valioso para indústrias especializadas como documentação legal, médica ou técnica onde vocabulário específico de domínio e padrões de formatação aparecem consistentemente.

Qual é a diferença entre as versões FP8 e BF16 do olmOCR 2 7B?

A versão FP8 usa quantização de ponto flutuante de 8 bits, reduzindo o tamanho do modelo pela metade aproximadamente e aumentando a velocidade de inferência para 3.400 tokens por segundo enquanto mantém precisão quase idêntica para a maioria dos documentos. A versão de precisão completa BF16 oferece precisão marginalmente melhor em alguns casos extremos, mas requer o dobro de memória GPU e roda aproximadamente na metade da velocidade. Para a maioria das aplicações de produção, o modelo quantizado FP8 fornece o trade-off superior de desempenho-eficiência.

Onde posso acessar o olmOCR 2 7B se não quiser gerenciar infraestrutura?

O olmOCR 2 7B está disponível através de serviços de API hospedados incluindo DeepInfra e Parasail, que lidam com todo o gerenciamento de infraestrutura e cobram apenas pelo uso. Esses serviços tornam o modelo acessível sem requerer servidores GPU ou expertise técnica de implantação. Alternativamente, para fluxos de trabalho completos de processamento de documentos sem complexidade técnica, plataformas como Apatero.com integram capacidades OCR avançadas em interfaces amigáveis projetadas para usuários de negócios em vez de cientistas de dados.

Conclusão

O olmOCR 2 7B representa um avanço genuíno na tecnologia de digitalização de documentos de código aberto. Ao atingir 82,4% de precisão em documentos desafiadores do mundo real enquanto processa 10.000 páginas por menos de $2, ele torna projetos OCR anteriormente proibitivos em custos subitamente viáveis para instituições de pesquisa, empresas e arquivos governamentais.

A revolucionária metodologia de treinamento com recompensas de testes unitários demonstra como o aprendizado por reforço com objetivos verificáveis pode empurrar modelos especializados além do que LLMs multimodais de propósito geral alcançam. O olmOCR 2 7B vencendo o GPT-4o em tarefas de conversão de documentos apesar de ser 50x menor mostra o poder da otimização focada.

Próximos Passos:

Se você está pronto para começar a digitalizar arquivos de documentos, baixe o olmOCR 2 7B do Hugging Face e instale o toolkit com pip install olmocr. Para implantações de produção, explore opções de API hospedadas através do DeepInfra ou Parasail para evitar sobrecarga de gerenciamento de infraestrutura.

Equipes de pesquisa devem revisar o artigo do arxiv sobre recompensas de testes unitários para entender a metodologia de treinamento e considerar como abordagens similares podem se aplicar a outras tarefas especializadas de IA além de OCR.

Para empresas que precisam de capacidades imediatas de processamento de documentos sem configuração técnica, plataformas como Apatero.com entregam OCR pronto para produção integrado em soluções completas de fluxo de trabalho, permitindo que você se concentre em resultados de negócios em vez de implantação de modelos.

O lançamento do olmOCR 2 7B como tecnologia totalmente de código aberto com licenciamento permissivo garante que digitalização de documentos precisa e acessível se torne acessível a todos, desde pesquisadores individuais até empresas globais, fundamentalmente democratizando o acesso ao conhecimento trancado em bilhões de páginas de documentos impressos.

Pronto para Criar Seu Influenciador IA?

Junte-se a 115 alunos dominando ComfyUI e marketing de influenciadores IA em nosso curso completo de 51 lições.

Artigos Relacionados

Geração de Livros de Aventura com IA e Imagens em Tempo Real

Gere livros de aventura interativos com criação de imagens IA em tempo real. Fluxo de trabalho completo para narrativa dinâmica com geração visual consistente.

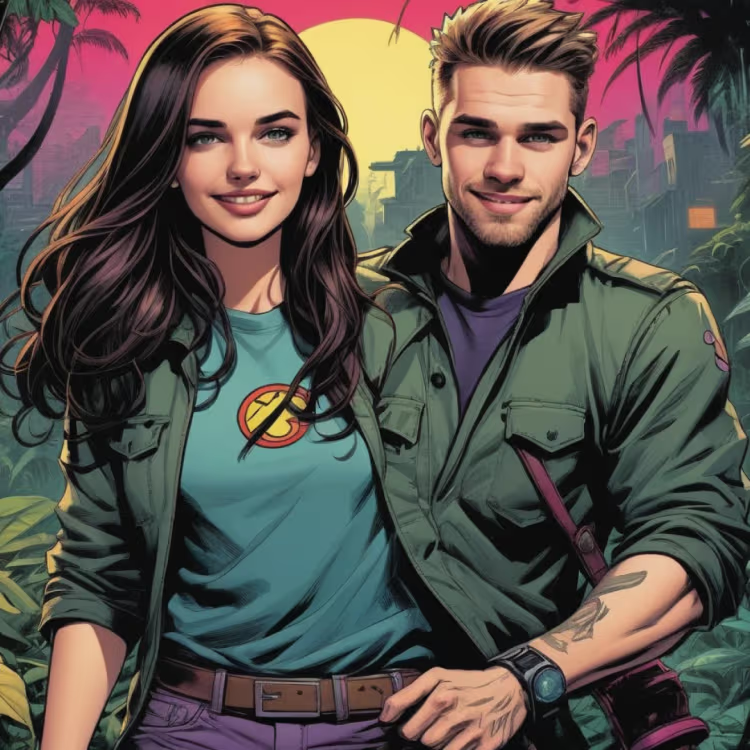

Criação de Histórias em Quadrinhos com IA usando Geração de Imagens IA

Crie quadrinhos profissionais com ferramentas de geração de imagens IA. Aprenda fluxos de trabalho completos para consistência de personagens, layouts de painéis e visualização de histórias que competem com a produção tradicional de quadrinhos.

Melhores Upscalers de Imagem IA 2025: Comparação ESRGAN vs Real-ESRGAN vs SwinIR

A comparação definitiva das tecnologias de upscaling IA. De ESRGAN a Real-ESRGAN, SwinIR e além - descubra qual upscaler IA oferece os melhores resultados...